最新刊期

2026 年 第 31 卷 第 2 期

- “介绍了其在增强现实领域的研究进展,相关专家构建了输入—输出双维度的AR交互技术全景框架,为解决多模态融合复杂度高、隐私安全隐患等核心挑战提供解决方案。”

摘要:增强现实(augmented reality,AR)技术通过三维空间感知与多模态交互机制,突破了传统二维交互的局限,其应用已渗透至医疗、教育、工业设计等领域。然而,现有研究多聚焦单一输入模态或特定应用场景,缺乏对多模态输入与跨感官反馈的系统性整合。本文构建了输入—输出双维度的AR交互技术全景框架:输入模态涵盖语音与姿态识别(包括眼动、头部及肢体动作),输出模态依据人类五感分类解析。该框架不仅为研究者提供技术链路图谱,还可通过系统性的技术缺口分析引导创新方向。研究发现,当前AR交互面临多模态融合复杂度高、隐私安全隐患、输入输出失衡及跨学科协同不足等核心挑战,需通过材料科学、认知神经科学、计算机伦理及计算机科学等领域的深度交叉,推动AR从界面增强向认知协同的范式跃迁。关键词:增强现实(AR);人机交互;多模态;输入模态;反馈111|184|0更新时间:2026-02-11

摘要:增强现实(augmented reality,AR)技术通过三维空间感知与多模态交互机制,突破了传统二维交互的局限,其应用已渗透至医疗、教育、工业设计等领域。然而,现有研究多聚焦单一输入模态或特定应用场景,缺乏对多模态输入与跨感官反馈的系统性整合。本文构建了输入—输出双维度的AR交互技术全景框架:输入模态涵盖语音与姿态识别(包括眼动、头部及肢体动作),输出模态依据人类五感分类解析。该框架不仅为研究者提供技术链路图谱,还可通过系统性的技术缺口分析引导创新方向。研究发现,当前AR交互面临多模态融合复杂度高、隐私安全隐患、输入输出失衡及跨学科协同不足等核心挑战,需通过材料科学、认知神经科学、计算机伦理及计算机科学等领域的深度交叉,推动AR从界面增强向认知协同的范式跃迁。关键词:增强现实(AR);人机交互;多模态;输入模态;反馈111|184|0更新时间:2026-02-11 -

三维缺陷检测技术研究进展 AI导读

“本文介绍了现代制造业中缺陷检测的重要性,指出传统二维检测方法的局限性,强调了三维缺陷检测技术的优势和必要性,同时指出现有综述的不足,阐述了本文对三维缺陷检测技术进行全面回顾和探讨研究方向的意义。” 摘要:随着工业制造技术的不断进步,产品质量控制对缺陷检测技术提出更高的要求。传统二维缺陷检测算法在处理复杂表面结构和形状时存在局限性,难以满足高精度、高鲁棒性的检测需求。相比之下,三维缺陷检测算法因具有更全面的信息、更高的准确率和更强的抗干扰性等优点,近年来受到广泛关注和深入研究。及时追踪该领域的最新动态并紧跟学术前沿,是推动三维缺陷检测技术不断突破、应对新挑战的必然要求。基于此,本文系统总结了三维缺陷检测领域的研究进展与发展趋势。从工业需求和技术挑战的角度阐述了缺陷检测的研究背景与意义。从传统机器学习方法出发,详细梳理了基于点云局部特征、点云配准和点云分割的三维缺陷检测方法,分析其技术原理与经典方法。针对深度学习技术在三维缺陷检测中的创新应用,从基于点云和基于多模态两个维度,深入探讨了当前的研究现状与技术突破。本文还对常用的三维缺陷检测基准数据集进行了全面分析,为研究者开展相关方法验证与性能评估提供参考。讨论了三维缺陷检测的主要挑战和未来发展趋势,为推动三维缺陷检测技术的进一步发展提供了指导。关键词:缺陷检测;计算机视觉;三维视觉;深度学习;多模态;综述276|425|0更新时间:2026-02-11

摘要:随着工业制造技术的不断进步,产品质量控制对缺陷检测技术提出更高的要求。传统二维缺陷检测算法在处理复杂表面结构和形状时存在局限性,难以满足高精度、高鲁棒性的检测需求。相比之下,三维缺陷检测算法因具有更全面的信息、更高的准确率和更强的抗干扰性等优点,近年来受到广泛关注和深入研究。及时追踪该领域的最新动态并紧跟学术前沿,是推动三维缺陷检测技术不断突破、应对新挑战的必然要求。基于此,本文系统总结了三维缺陷检测领域的研究进展与发展趋势。从工业需求和技术挑战的角度阐述了缺陷检测的研究背景与意义。从传统机器学习方法出发,详细梳理了基于点云局部特征、点云配准和点云分割的三维缺陷检测方法,分析其技术原理与经典方法。针对深度学习技术在三维缺陷检测中的创新应用,从基于点云和基于多模态两个维度,深入探讨了当前的研究现状与技术突破。本文还对常用的三维缺陷检测基准数据集进行了全面分析,为研究者开展相关方法验证与性能评估提供参考。讨论了三维缺陷检测的主要挑战和未来发展趋势,为推动三维缺陷检测技术的进一步发展提供了指导。关键词:缺陷检测;计算机视觉;三维视觉;深度学习;多模态;综述276|425|0更新时间:2026-02-11 -

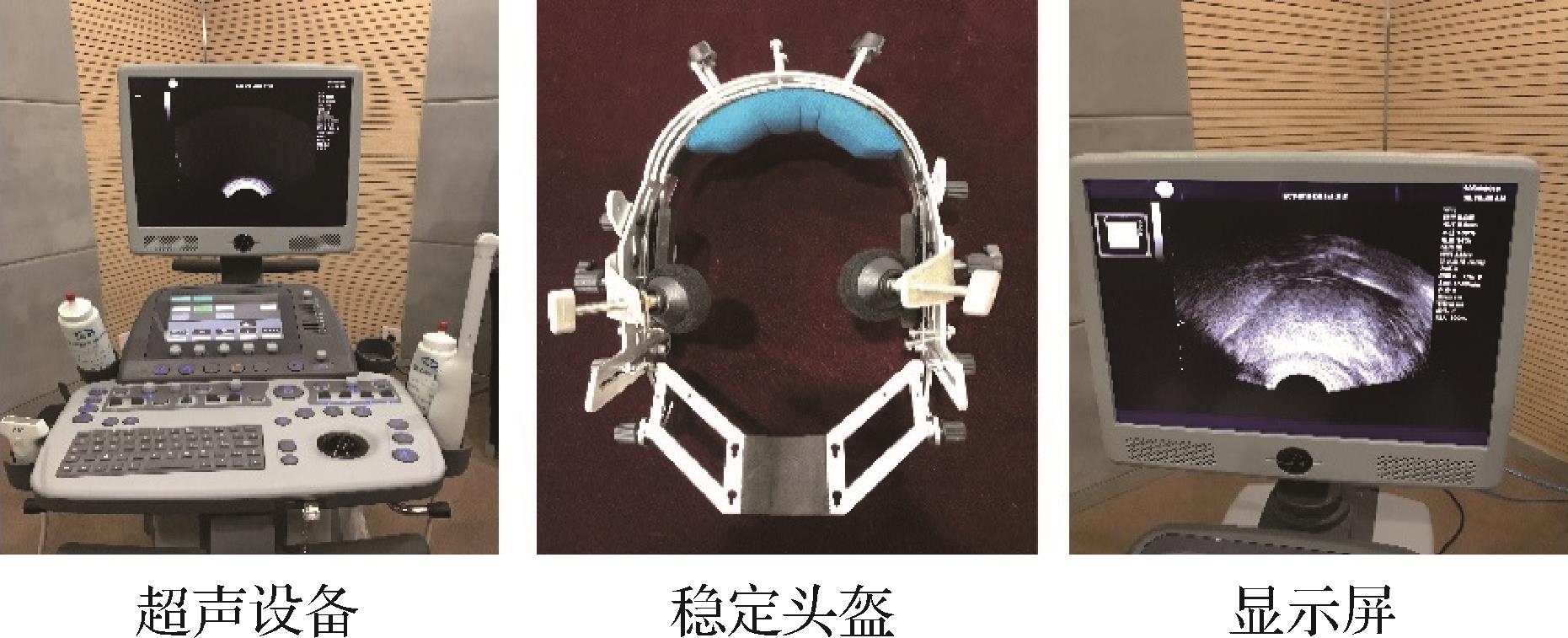

深度学习在超声舌成像处理中的研究进展 AI导读

“介绍了超声舌成像在语言学等领域的研究进展,专家借助深度学习攻克了超声舌成像处理难题,为语音工程应用等开辟了新方向。” 摘要:借助超声成像设备可以对发音生理舌体进行动态记录,超声舌成像的处理分析对于实践语言学、实验语音学研究以及语音工程应用具有重要意义,其中,舌体运动轨迹动态分析和舌体轮廓线的舌位姿态量化分析是实际应用中的关键技术。由于超声舌成像模糊、舌轮廓不清晰等噪声特性,其处理分析面临着舌位特征提取困难、舌体动态轮廓线跟踪困难等挑战。深度学习技术借助其强大的特征学习能力在超声舌成像处理分析中的舌体轮廓线的提取、舌体运动模型的构建以及深层次的语音工程应用等方面取得了较大成果。概述了超声成像与超声舌成像,分析了超声舌成像处理遇到的挑战,简述了深度学习的技术方法,归纳了深度学习技术在超声舌成像处理分析等任务中的建模机理和具体应用,包括超声音视频同步对齐、生物特征识别、多模态学习、无声语音接口、声学反演模型、语言学习与语音康复、创新交互与艺术娱乐等,并梳理了相关理论方法、技术手段及性能评价。最后给出了深度学习技术在超声舌成像处理分析中的研究展望与未来趋势。以期更多的计算机技术和超声成像技术能够引入并助推实验语音学和语言学的科学研究和学科发展。关键词:深度学习(DL);超声舌成像(UTI);发音生理舌体;语音工程;语音识别;语音合成82|99|0更新时间:2026-02-11

摘要:借助超声成像设备可以对发音生理舌体进行动态记录,超声舌成像的处理分析对于实践语言学、实验语音学研究以及语音工程应用具有重要意义,其中,舌体运动轨迹动态分析和舌体轮廓线的舌位姿态量化分析是实际应用中的关键技术。由于超声舌成像模糊、舌轮廓不清晰等噪声特性,其处理分析面临着舌位特征提取困难、舌体动态轮廓线跟踪困难等挑战。深度学习技术借助其强大的特征学习能力在超声舌成像处理分析中的舌体轮廓线的提取、舌体运动模型的构建以及深层次的语音工程应用等方面取得了较大成果。概述了超声成像与超声舌成像,分析了超声舌成像处理遇到的挑战,简述了深度学习的技术方法,归纳了深度学习技术在超声舌成像处理分析等任务中的建模机理和具体应用,包括超声音视频同步对齐、生物特征识别、多模态学习、无声语音接口、声学反演模型、语言学习与语音康复、创新交互与艺术娱乐等,并梳理了相关理论方法、技术手段及性能评价。最后给出了深度学习技术在超声舌成像处理分析中的研究展望与未来趋势。以期更多的计算机技术和超声成像技术能够引入并助推实验语音学和语言学的科学研究和学科发展。关键词:深度学习(DL);超声舌成像(UTI);发音生理舌体;语音工程;语音识别;语音合成82|99|0更新时间:2026-02-11

综述

- “介绍了其在军事目标检测领域的研究进展,相关专家构建了无人机视角坦克目标检测仿真数据集,验证了仿真数据在缓解实战图像数据稀缺问题上的有效性,为武器平台的实战运用提供了支持。”

摘要:目的随着计算机仿真技术的迭代演进,仿真图像数据正逐步成为许多数据稀缺领域的有效替代资源。但在实战图像样本更为匮乏的军事目标检测任务中,基于仿真数据及其融合策略训练的检测模型能否在真实战场中实现有效泛化,仍缺乏实证支撑。为此,制作了包含不同仿真域数据、作战场景和坦克型号的无人机视角坦克目标检测仿真数据集(synthetic tank, ST)1.0版本,包括ST1、ST2和ST3三个子数据集。方法通过构建仿真数据与实战场景检验框架,基于不同仿真数据分别训练 Cascade R-CNN(cascade region-based convolutional neural network)、YOLOv10(you only look once version 10)和 RT-DETR(real-time detection Transformer) 3类异构检测器后,在公开数据集与俄乌实战图像中展开跨域测试。系统探究了仿真域差异性(实验1)、混合仿真域组合效应(实验2)及数据增广策略(实验3)对模型泛化性能的影响。结果实验中所有模型的平均精度(average precision, AP)均值均随测试数据趋近真实作战场景呈下降趋势,其中 RT-DETR 模型在跨域检测中具有更强鲁棒性,在两个测试集上的AP最高达到 54.50% 与 42.30%;具备视觉真实性、目标域属性适配且可视化特征分布相近的仿真数据表现更佳;混合或增广优质仿真数据可显著提升模型性能。结论仿真图像数据能在一定程度上缓解实战图像数据稀缺问题,为武器平台的实战运用提供支持。但仍存在跨域泛化局限性,需结合其他源域及域泛化技术等进一步提升。关键词:坦克目标检测;无人机(UAV);仿真数据;单源域泛化;实战运用355|219|0更新时间:2026-02-11

摘要:目的随着计算机仿真技术的迭代演进,仿真图像数据正逐步成为许多数据稀缺领域的有效替代资源。但在实战图像样本更为匮乏的军事目标检测任务中,基于仿真数据及其融合策略训练的检测模型能否在真实战场中实现有效泛化,仍缺乏实证支撑。为此,制作了包含不同仿真域数据、作战场景和坦克型号的无人机视角坦克目标检测仿真数据集(synthetic tank, ST)1.0版本,包括ST1、ST2和ST3三个子数据集。方法通过构建仿真数据与实战场景检验框架,基于不同仿真数据分别训练 Cascade R-CNN(cascade region-based convolutional neural network)、YOLOv10(you only look once version 10)和 RT-DETR(real-time detection Transformer) 3类异构检测器后,在公开数据集与俄乌实战图像中展开跨域测试。系统探究了仿真域差异性(实验1)、混合仿真域组合效应(实验2)及数据增广策略(实验3)对模型泛化性能的影响。结果实验中所有模型的平均精度(average precision, AP)均值均随测试数据趋近真实作战场景呈下降趋势,其中 RT-DETR 模型在跨域检测中具有更强鲁棒性,在两个测试集上的AP最高达到 54.50% 与 42.30%;具备视觉真实性、目标域属性适配且可视化特征分布相近的仿真数据表现更佳;混合或增广优质仿真数据可显著提升模型性能。结论仿真图像数据能在一定程度上缓解实战图像数据稀缺问题,为武器平台的实战运用提供支持。但仍存在跨域泛化局限性,需结合其他源域及域泛化技术等进一步提升。关键词:坦克目标检测;无人机(UAV);仿真数据;单源域泛化;实战运用355|219|0更新时间:2026-02-11

数据集

- “相关研究在低光图像增强领域取得新进展,研究人员提出了一种融合多重空洞卷积与坐标分组的暗光图像增强网络(MCCNet),为解决低光环境下拍摄图像存在的亮度不均、细节丢失和色彩失真等问题提供了有效方案。”

摘要:目的在低光环境下拍摄的图像通常存在亮度不均、细节丢失和色彩失真等问题,导致视觉质量大幅下降。大多数低光图像增强方法更多关注亮度提升,忽略了色彩恢复,容易产生色偏和伪影。此外,现有深度学习方法大多结构复杂、训练成本较高,且难以同时兼顾亮度和色彩恢复。方法提出一种融合多重空洞卷积与坐标分组的暗光图像增强网络(low-light image enhancement network via fused multi-scale dilated convolutions and coordinate grouping,MCCNet)。MCCNet由色彩转换和增强网络两个独立分支组成。其中,基于权重感知的HVI(hue, value, intensity)色彩空间中引入色彩自适应因子,将亮度和颜色信息解耦,从而提高色彩增强的精确性。提出全局分组坐标注意力模块(global grouped coordinate attention module,GGCA),促进颜色空间与色彩恢复分支之间的信息交互,并有效抑制低光图像中的噪声。结合多种空洞率卷积层,提出多重空洞融合注意力模块(multi-scale dilated fusion attention module,MDFA),实现更精细化地亮度恢复。最后通过色彩转换和亮度增强两个分支的共同协作,在提升亮度的同时保留了更多图像细节,解决了复杂场景和极端低光场景中色彩失真的难题。结果将本文方法与RetinexNet等15种方法进行比较,在3个公开数据集、2个极端低光数据集和5个无配对数据集上进行评估,相较于次优值,本文算法的峰值信噪比(peak signal-to-noise ratio,PSNR)提高1.57 dB,在LOLv1数据集上的峰值信噪比(PSNR)和结构相似度(structural similarity index measure,SSIM)均优于其他算法。结论本文提出的MCCNet能够有效恢复亮度和色彩,在解决色偏和伪影问题时表现优异,且能够更好地调整光照、抑制噪声,实现高质量视觉增强效果。此外,本文方法充分考虑了计算复杂度与模型规模在实际应用中的需求,模型参数量仅为1.98 M,FLOPs为8.06 G,在实现领先性能的同时,显著降低了模型规模与计算开销,与经典图像增强方法以及近年来性能突出的先进算法进行对比,模型参数和计算量平均减少约96%和46%,实现了高效轻量的设计。关键词:低照度图像增强;HVI颜色空间;注意力机制;坐标分组;空洞卷积140|112|0更新时间:2026-02-11

摘要:目的在低光环境下拍摄的图像通常存在亮度不均、细节丢失和色彩失真等问题,导致视觉质量大幅下降。大多数低光图像增强方法更多关注亮度提升,忽略了色彩恢复,容易产生色偏和伪影。此外,现有深度学习方法大多结构复杂、训练成本较高,且难以同时兼顾亮度和色彩恢复。方法提出一种融合多重空洞卷积与坐标分组的暗光图像增强网络(low-light image enhancement network via fused multi-scale dilated convolutions and coordinate grouping,MCCNet)。MCCNet由色彩转换和增强网络两个独立分支组成。其中,基于权重感知的HVI(hue, value, intensity)色彩空间中引入色彩自适应因子,将亮度和颜色信息解耦,从而提高色彩增强的精确性。提出全局分组坐标注意力模块(global grouped coordinate attention module,GGCA),促进颜色空间与色彩恢复分支之间的信息交互,并有效抑制低光图像中的噪声。结合多种空洞率卷积层,提出多重空洞融合注意力模块(multi-scale dilated fusion attention module,MDFA),实现更精细化地亮度恢复。最后通过色彩转换和亮度增强两个分支的共同协作,在提升亮度的同时保留了更多图像细节,解决了复杂场景和极端低光场景中色彩失真的难题。结果将本文方法与RetinexNet等15种方法进行比较,在3个公开数据集、2个极端低光数据集和5个无配对数据集上进行评估,相较于次优值,本文算法的峰值信噪比(peak signal-to-noise ratio,PSNR)提高1.57 dB,在LOLv1数据集上的峰值信噪比(PSNR)和结构相似度(structural similarity index measure,SSIM)均优于其他算法。结论本文提出的MCCNet能够有效恢复亮度和色彩,在解决色偏和伪影问题时表现优异,且能够更好地调整光照、抑制噪声,实现高质量视觉增强效果。此外,本文方法充分考虑了计算复杂度与模型规模在实际应用中的需求,模型参数量仅为1.98 M,FLOPs为8.06 G,在实现领先性能的同时,显著降低了模型规模与计算开销,与经典图像增强方法以及近年来性能突出的先进算法进行对比,模型参数和计算量平均减少约96%和46%,实现了高效轻量的设计。关键词:低照度图像增强;HVI颜色空间;注意力机制;坐标分组;空洞卷积140|112|0更新时间:2026-02-11 - “本文介绍了盲源分离(BSS)及其在图像处理领域中的应用盲图像分离(BIS)的背景和重要性,指出在复杂图像分离任务中,基于统计约束的算法存在局限性。”

摘要:目的盲图像分离(blind image separation, BIS)指在未知混合方式及源图像先验的条件下,从单幅观测图像中同时估计并恢复多个独立源图像的逆问题,典型应用包括恶劣天气(雨、雪)去除和反射/阴影层分离等。然而,现有的BIS方法普遍依赖人工先验或基于卷积神经网络(convolutional neural network,CNN)或对抗生成网络(generative adversarial network,GAN)的变体,难以刻画真实场景中源图像复杂且多变的特征分布,导致在强噪声、非线性混合及纹理细节高度耦合的情况下出现源图像分离估计偏差、纹理失真和伪影残留等缺陷。对此,本文创新性地将扩散模型引入双通道盲图像分离,提出一种高效的双通道扩散分离模型(dual channel diffusion separation model, DCDSM)。方法DCDSM利用扩散模型学习源图像的特征分布,实现对源图像特征结构的有效重建,并根据两个源图像互为耦合噪声的特性,在双分支扩散的反向去噪过程设计了小波抑制模块(wavelet suppression module, WSM),形成交互式的双分支分离网络,提高混合图像细节信息的分离效果。结果在含雨/雪及复杂混合场景的合成数据集上进行了充分实验,结果表明:1)DCDSM在去雨、去雪的图像复原任务中分别取得PSNR/SSIM指标值为35.002 3 dB/0.954 9和29.810 8 dB/0.924 3,较Histoformer和LDRCNet分别提升1.257 0 dB/0.927 2 dB(PSNR)和0.026 2/0.028 9(SSIM)。2)针对复杂混合图像的双盲分离任务,所恢复的双源图像在纹理保真度与细节完整性上均显著优于其他方法,其PSNR与SSIM指标在两个通道上的平均值分别达到25.004 9 dB和0.799 7,较对比方法提升4.124 9 dB和0.092 6。结论本文模型在主观视觉和客观指标上相较于对比方法均取得最优的结果,解决了存在雨纹和雪纹残留、混合图像中细节模糊等问题。关键词:盲图像分离(BIS);扩散模型(DM);小波变换;傅里叶变换;图像复原54|89|0更新时间:2026-02-11

摘要:目的盲图像分离(blind image separation, BIS)指在未知混合方式及源图像先验的条件下,从单幅观测图像中同时估计并恢复多个独立源图像的逆问题,典型应用包括恶劣天气(雨、雪)去除和反射/阴影层分离等。然而,现有的BIS方法普遍依赖人工先验或基于卷积神经网络(convolutional neural network,CNN)或对抗生成网络(generative adversarial network,GAN)的变体,难以刻画真实场景中源图像复杂且多变的特征分布,导致在强噪声、非线性混合及纹理细节高度耦合的情况下出现源图像分离估计偏差、纹理失真和伪影残留等缺陷。对此,本文创新性地将扩散模型引入双通道盲图像分离,提出一种高效的双通道扩散分离模型(dual channel diffusion separation model, DCDSM)。方法DCDSM利用扩散模型学习源图像的特征分布,实现对源图像特征结构的有效重建,并根据两个源图像互为耦合噪声的特性,在双分支扩散的反向去噪过程设计了小波抑制模块(wavelet suppression module, WSM),形成交互式的双分支分离网络,提高混合图像细节信息的分离效果。结果在含雨/雪及复杂混合场景的合成数据集上进行了充分实验,结果表明:1)DCDSM在去雨、去雪的图像复原任务中分别取得PSNR/SSIM指标值为35.002 3 dB/0.954 9和29.810 8 dB/0.924 3,较Histoformer和LDRCNet分别提升1.257 0 dB/0.927 2 dB(PSNR)和0.026 2/0.028 9(SSIM)。2)针对复杂混合图像的双盲分离任务,所恢复的双源图像在纹理保真度与细节完整性上均显著优于其他方法,其PSNR与SSIM指标在两个通道上的平均值分别达到25.004 9 dB和0.799 7,较对比方法提升4.124 9 dB和0.092 6。结论本文模型在主观视觉和客观指标上相较于对比方法均取得最优的结果,解决了存在雨纹和雪纹残留、混合图像中细节模糊等问题。关键词:盲图像分离(BIS);扩散模型(DM);小波变换;傅里叶变换;图像复原54|89|0更新时间:2026-02-11

图像处理和编码

- “专家提出频域引导的RGB-D轻量级语义分割网络,融合Transformer与CNN结构,通过频域引导机制提升跨模态特征融合效果与模型轻量化水平,在RGB-D语义分割任务中显著提高语义对齐能力与信息融合效率,为轻量化多模态感知网络设计提供新思路。”

摘要:目的RGB-D语义分割通过融合RGB图像与深度图像的互补信息,能够有效提升复杂场景下的语义理解精度。然而,由于RGB与深度模态在特征表达上的本质差异,现有方法常依赖双编码器架构,导致特征对齐效率低、计算开销大,难以在模型性能与轻量化之间取得良好平衡。为此,提出一种融合频域引导的RGB-D轻量级语义分割网络,旨在提升跨模态特征融合效果并降低模型复杂度。方法构建融合Transformer与卷积神经网络(convolutional neural network,CNN)结构的RGB-D Block,通过全局注意力分支与局部卷积分支并行设计,兼顾长距离依赖建模与细节提取;设计频域引导提示适配器,通过傅里叶变换提取频谱能量以动态生成提示向量,并与查询特征融合以加强跨层语义对齐能力;设计频谱引导动态卷积模块,将特征划分为低、中、高频3个频段,通过门控机制融合多频特征与空间域提取特征,提升多尺度建模能力;构建多尺度频域代理注意力模块,利用上阶段的频谱特征生成动态代理向量,在低成本下实现高效的跨层全局建模。结果在RGB-D语义分割任务下的NYU Depth V2(New York University depth dataset V2)和SUN-RGBD(RGB-D scene understanding benchmark suite)数据集上,以不足主流方法一半的参数量分别实现了57.6%和52.8%的平均交并比;在RGB-L语义分割任务下的KITTI-360数据集上的实验进一步验证了对其他跨模态场景的鲁棒性。泛化测试中,模型在5个RGB-D显著目标检测数据集上于F-measure、E-measure、S-measure和平均绝对误差(mean absolute error,MAE)4项指标全面优于对比方法。此外,在NYU Depth V2上进行的消融实验也验证了各模块的独立价值与协同效益。结论提出一种频域引导的轻量级RGB-D感知框架,在多个关键模块中引入频域引导机制,统一构建频谱感知的提示学习、动态卷积与代理注意力路径,显著提升了RGB-D语义分割任务中的语义对齐能力、信息融合效率与模型部署适应性,为轻量化多模态感知网络的设计提供了新思路。关键词:RGB-D图像;RGB-D语义分割;频域建模;提示调优;动态卷积;代理注意力201|107|0更新时间:2026-02-11

摘要:目的RGB-D语义分割通过融合RGB图像与深度图像的互补信息,能够有效提升复杂场景下的语义理解精度。然而,由于RGB与深度模态在特征表达上的本质差异,现有方法常依赖双编码器架构,导致特征对齐效率低、计算开销大,难以在模型性能与轻量化之间取得良好平衡。为此,提出一种融合频域引导的RGB-D轻量级语义分割网络,旨在提升跨模态特征融合效果并降低模型复杂度。方法构建融合Transformer与卷积神经网络(convolutional neural network,CNN)结构的RGB-D Block,通过全局注意力分支与局部卷积分支并行设计,兼顾长距离依赖建模与细节提取;设计频域引导提示适配器,通过傅里叶变换提取频谱能量以动态生成提示向量,并与查询特征融合以加强跨层语义对齐能力;设计频谱引导动态卷积模块,将特征划分为低、中、高频3个频段,通过门控机制融合多频特征与空间域提取特征,提升多尺度建模能力;构建多尺度频域代理注意力模块,利用上阶段的频谱特征生成动态代理向量,在低成本下实现高效的跨层全局建模。结果在RGB-D语义分割任务下的NYU Depth V2(New York University depth dataset V2)和SUN-RGBD(RGB-D scene understanding benchmark suite)数据集上,以不足主流方法一半的参数量分别实现了57.6%和52.8%的平均交并比;在RGB-L语义分割任务下的KITTI-360数据集上的实验进一步验证了对其他跨模态场景的鲁棒性。泛化测试中,模型在5个RGB-D显著目标检测数据集上于F-measure、E-measure、S-measure和平均绝对误差(mean absolute error,MAE)4项指标全面优于对比方法。此外,在NYU Depth V2上进行的消融实验也验证了各模块的独立价值与协同效益。结论提出一种频域引导的轻量级RGB-D感知框架,在多个关键模块中引入频域引导机制,统一构建频谱感知的提示学习、动态卷积与代理注意力路径,显著提升了RGB-D语义分割任务中的语义对齐能力、信息融合效率与模型部署适应性,为轻量化多模态感知网络的设计提供了新思路。关键词:RGB-D图像;RGB-D语义分割;频域建模;提示调优;动态卷积;代理注意力201|107|0更新时间:2026-02-11 - “专家提出基于改进RT-DETR的机车圆弹簧缺陷检测方法,通过结构重参数化、可变形注意力机制及跨尺度特征信息融合等改进,有效提升检测精度与效率,为机车安全运行提供有力保障。”

摘要:目的机车圆弹簧缺陷检测对机车的安全运行至关重要,受限于检测车间复杂环境的影响,机车圆弹簧缺陷检测存在漏检、误检及检测效率低下的问题,为此,提出一种基于改进RT-DETR(real-time detection Transformer)的机车圆弹簧缺陷检测方法。方法首先,应用结构重参数化(structural re-parameterization,Rep)方法来改进部分卷积(partial convolution, Pconv),构建重参数化的部分卷积(Rep-Pconv)替换原始主干中的Basic block;其次,在基于注意力的尺度内特征交互(attention-based intra-scale feature interaction,AIFI)模块中引入可变形注意力(deformable attention,DA)机制修正原有结构中的多头自注意力机制(multi-head self-attention),提高模型对局部区域的关注度;最后,在颈部网络添加P2检测层,结合尺度序列特征融合(scale-sequence feature fusion,SSFF)思想与三重特征编码器(triple feature encoder,TFE)结构,构建轻量的跨尺度特征信息融合模块。结果利用自建机车圆弹簧缺陷数据集对所提方法进行验证,相较于原始的RT-DETR算法,改进后RT-DETR算法在参数量减少54%的同时,将mAP50提升至97.2%,提高2.8%,精度以及召回率分别提升0.8%和1.2%;与YOLOv5s、YOLOv8s、YOLO11s和YOLO12s相比,所提算法在多项指标上表现出显著优势。结论本文所改进的RT-DETR机车圆弹簧缺陷检测算法,能够有效应对机车圆弹簧在车间复杂环境检测的要求,通过实验验证并与当前主流目标检测算法进行对比分析,结果表明所提算法在实验数据集上表现优异。关键词:机车圆弹簧;缺陷检测;RT-DETR;部分卷积(Pconv);结构重参数化(Rep);可变形注意力机制;特征融合131|89|0更新时间:2026-02-11

摘要:目的机车圆弹簧缺陷检测对机车的安全运行至关重要,受限于检测车间复杂环境的影响,机车圆弹簧缺陷检测存在漏检、误检及检测效率低下的问题,为此,提出一种基于改进RT-DETR(real-time detection Transformer)的机车圆弹簧缺陷检测方法。方法首先,应用结构重参数化(structural re-parameterization,Rep)方法来改进部分卷积(partial convolution, Pconv),构建重参数化的部分卷积(Rep-Pconv)替换原始主干中的Basic block;其次,在基于注意力的尺度内特征交互(attention-based intra-scale feature interaction,AIFI)模块中引入可变形注意力(deformable attention,DA)机制修正原有结构中的多头自注意力机制(multi-head self-attention),提高模型对局部区域的关注度;最后,在颈部网络添加P2检测层,结合尺度序列特征融合(scale-sequence feature fusion,SSFF)思想与三重特征编码器(triple feature encoder,TFE)结构,构建轻量的跨尺度特征信息融合模块。结果利用自建机车圆弹簧缺陷数据集对所提方法进行验证,相较于原始的RT-DETR算法,改进后RT-DETR算法在参数量减少54%的同时,将mAP50提升至97.2%,提高2.8%,精度以及召回率分别提升0.8%和1.2%;与YOLOv5s、YOLOv8s、YOLO11s和YOLO12s相比,所提算法在多项指标上表现出显著优势。结论本文所改进的RT-DETR机车圆弹簧缺陷检测算法,能够有效应对机车圆弹簧在车间复杂环境检测的要求,通过实验验证并与当前主流目标检测算法进行对比分析,结果表明所提算法在实验数据集上表现优异。关键词:机车圆弹簧;缺陷检测;RT-DETR;部分卷积(Pconv);结构重参数化(Rep);可变形注意力机制;特征融合131|89|0更新时间:2026-02-11 -

以运动为中心的孪生网络三维目标跟踪 AI导读

“相关研究在三维单目标跟踪领域取得新进展,专家提出一种基于孪生网络以运动为中心的跟踪方法,有效解决了无纹理且不完整的激光雷达点云处理难题,显著提高跟踪精度,为该领域研究开辟了新方向。” 摘要:目的现有的三维单目标跟踪方法主要遵循基于孪生匹配的范式,长期以来,该范式在处理无纹理且不完整的激光雷达点云时存在诸多问题。一种新的以运动为中心的范式无需进行外观匹配,在很大程度上克服了这些挑战。然而,该方法为多阶段操作,需额外进行预分割与边界框优化。为了解决上述问题,提出一种创新且简洁的基于孪生网络以运动为中心的跟踪方法。方法本文方法的核心在于,先借助共享编码器从连续两帧数据中提取特征,随后直接在特征层面建模目标相对运动。具体而言,设计了时空特征聚合模块,该模块能在多尺度下整合编码特征,高效捕捉运动信息;同时引入边界框感知特征编码模块,将精确的尺寸先验信息融入运动特征,以提升预测精度。结果实验环节,在 Kitti、NuScenes和WOD(Waymo open dataset) 3个数据集上,与当前先进方法对比,结果显示:在Kitti数据集中,相较于排名第2的方法,平均成功率指标提升4.7%,平均精度指标提升4.9%;在NuScenes数据集中,平均成功率指标提升14.2%,平均精度指标提升11.5%;在WOD数据集中,平均成功率指标提升2.9%,平均精度指标提升5.4%。在Kitti和NuScenes数据集的高难度测试子集上,本文方法也展现出极强的鲁棒性。此外,在Kitti和NuScenes数据集上开展的消融实验,进一步验证了孪生架构、时空特征聚合模块及边界框感知特征编码模块的有效性。结论本文提出的基于孪生网络以运动为中心的跟踪方法,规避了易受干扰的外观匹配流程,且无需额外预分割和边界框优化,显著提高跟踪精度,为三维单目标跟踪领域提供了新思路。关键词:三维目标跟踪;激光点云;孪生网络;运动估计;深度学习78|166|0更新时间:2026-02-11

摘要:目的现有的三维单目标跟踪方法主要遵循基于孪生匹配的范式,长期以来,该范式在处理无纹理且不完整的激光雷达点云时存在诸多问题。一种新的以运动为中心的范式无需进行外观匹配,在很大程度上克服了这些挑战。然而,该方法为多阶段操作,需额外进行预分割与边界框优化。为了解决上述问题,提出一种创新且简洁的基于孪生网络以运动为中心的跟踪方法。方法本文方法的核心在于,先借助共享编码器从连续两帧数据中提取特征,随后直接在特征层面建模目标相对运动。具体而言,设计了时空特征聚合模块,该模块能在多尺度下整合编码特征,高效捕捉运动信息;同时引入边界框感知特征编码模块,将精确的尺寸先验信息融入运动特征,以提升预测精度。结果实验环节,在 Kitti、NuScenes和WOD(Waymo open dataset) 3个数据集上,与当前先进方法对比,结果显示:在Kitti数据集中,相较于排名第2的方法,平均成功率指标提升4.7%,平均精度指标提升4.9%;在NuScenes数据集中,平均成功率指标提升14.2%,平均精度指标提升11.5%;在WOD数据集中,平均成功率指标提升2.9%,平均精度指标提升5.4%。在Kitti和NuScenes数据集的高难度测试子集上,本文方法也展现出极强的鲁棒性。此外,在Kitti和NuScenes数据集上开展的消融实验,进一步验证了孪生架构、时空特征聚合模块及边界框感知特征编码模块的有效性。结论本文提出的基于孪生网络以运动为中心的跟踪方法,规避了易受干扰的外观匹配流程,且无需额外预分割和边界框优化,显著提高跟踪精度,为三维单目标跟踪领域提供了新思路。关键词:三维目标跟踪;激光点云;孪生网络;运动估计;深度学习78|166|0更新时间:2026-02-11 -

解耦情绪依赖关系的跨模态感知对话情绪识别 AI导读

“对话情绪识别领域迎来新突破,研究者提出DECANet模型,通过解耦情绪依赖关系与跨模态感知机制,有效攻克情绪动态演变及多模态融合难题,显著提升情绪识别准确率与泛化性能,为复杂交互场景下的情绪识别提供有力支持。” 摘要:目的对话情绪识别旨在准确捕捉对话中各话语的情绪状态,但面临两大挑战。其一,情绪状态随对话语境动态演变,且个体内部与说话者间存在结构异质的情绪依赖关系,增加了建模难度。其二,多模态信息融合时常出现语义错位和模态冗余,影响跨模态语义对齐与情绪线索的准确捕捉。方法提出一种解耦情绪依赖关系的跨模态感知对话情绪识别模型(decoupled emotion dependencies and cross-modal awareness network,DECANet)。该模型通过结构解耦策略,将个体内部和说话者间的情绪依赖分别建模为两个独立子图,并设计启发式动态交互机制实现差异化建模与协同融合,精准捕捉多层次情绪演化特征。在多模态建模方面,设计跨模态上下文感知自注意力机制强化模态间深层语义关联,辅以语义一致性驱动的特征选择模块,有效筛选语义偏离和冗余信息,提升情绪表征的判别力。结果在IEMOCAP(interactive emotional dyadic motion capture database)和MELD(multimodal emotion lines dataset)数据集上的实验结果表明,DECANet在准确率与加权F1值两个关键指标上均优于多种主流方法。在IEMOCAP上分别提升1.74%和1.77%;在MELD上亦取得了具有竞争力的性能增幅。消融实验进一步验证了情绪依赖解耦建模和跨模态交互机制的有效性。结论DECANet能够更清晰地区分并建模对话中异构的情绪依赖结构,增强多模态语义对齐,减少信息冗余,在复杂交互场景中展现出较强的情绪识别能力和良好的泛化性能。关键词:对话情绪识别(ERC);图注意力网络(GAT);情绪依赖图解耦与融合;多模态融合;跨模态交互机制66|126|0更新时间:2026-02-11

摘要:目的对话情绪识别旨在准确捕捉对话中各话语的情绪状态,但面临两大挑战。其一,情绪状态随对话语境动态演变,且个体内部与说话者间存在结构异质的情绪依赖关系,增加了建模难度。其二,多模态信息融合时常出现语义错位和模态冗余,影响跨模态语义对齐与情绪线索的准确捕捉。方法提出一种解耦情绪依赖关系的跨模态感知对话情绪识别模型(decoupled emotion dependencies and cross-modal awareness network,DECANet)。该模型通过结构解耦策略,将个体内部和说话者间的情绪依赖分别建模为两个独立子图,并设计启发式动态交互机制实现差异化建模与协同融合,精准捕捉多层次情绪演化特征。在多模态建模方面,设计跨模态上下文感知自注意力机制强化模态间深层语义关联,辅以语义一致性驱动的特征选择模块,有效筛选语义偏离和冗余信息,提升情绪表征的判别力。结果在IEMOCAP(interactive emotional dyadic motion capture database)和MELD(multimodal emotion lines dataset)数据集上的实验结果表明,DECANet在准确率与加权F1值两个关键指标上均优于多种主流方法。在IEMOCAP上分别提升1.74%和1.77%;在MELD上亦取得了具有竞争力的性能增幅。消融实验进一步验证了情绪依赖解耦建模和跨模态交互机制的有效性。结论DECANet能够更清晰地区分并建模对话中异构的情绪依赖结构,增强多模态语义对齐,减少信息冗余,在复杂交互场景中展现出较强的情绪识别能力和良好的泛化性能。关键词:对话情绪识别(ERC);图注意力网络(GAT);情绪依赖图解耦与融合;多模态融合;跨模态交互机制66|126|0更新时间:2026-02-11 -

非空间配准的多模态目标检测决策融合策略 AI导读

“多模态目标检测领域迎来新突破,相关专家提出非空间配准多模态目标检测决策融合方法,有效解决实际应用中不同模态相机非空间配准图像检测难题,显著提升检测精度与鲁棒性。” 摘要:目的多模态目标检测通过融合红外与可见光等多源传感器数据,有效提升了模型在复杂环境下的检测精度与鲁棒性。然而,现有方法普遍基于严格配准的多模态数据开展研究,不能直接适配实际应用中不同模态相机得到的非空间配准图像,在图像输入算法前仍需完成配准,这损失了实时性和灵活性。为此,提出一种非空间配准条件下的多模态目标检测任务,并设计了一种非空间配准的多模态目标检测决策融合方法。在数据层面,利用3种公共数据集模拟双光载荷拍摄得到的非空间配准图像对,在不引入额外标注成本的前提下,为新的任务提供了基准数据。在算法层面,设计了一种基于图结构的非空间配准决策融合方法。方法首先,根据不同模态检测器的检测结果构建带权有向图,实现不同模态目标的图结构化表示;接着,利用图结构中目标间的相对位置关系,实现跨模态目标的自适应匹配;最终,对匹配成功的目标进行决策融合,并设计了模态迁移策略以实现多模态信息的高效互补。结果在3个数据集上的实验结果表明,本文方法在非空间配准场景下较单模态检测器实现了最大10.03%的漏检率降幅。同时,该方法在配准数据集上同样适用,相较于多光谱行人检测Transformer(multi spectral pedestrian detection Transformer,MS-DETR)、动态自适应多光谱检测Transformer(dynamic adaptive multispectral detection Transformer,DAMSDet)等先进多模态目标检测方法,检测准确率提升了6.8%。结论本文所提出的非空间配准多模态目标检测决策融合方法,能够很好地适应存在空间差异的实际场景,并且相比其他先进的多模态目标检测模型,有更高的准确率和鲁棒性。相关的代码与数据集将在此仓库公开:https://github.com/1e12Leon/ProbDet。关键词:目标检测;多模态目标检测;有向图;决策融合;非空间配准101|139|0更新时间:2026-02-11

摘要:目的多模态目标检测通过融合红外与可见光等多源传感器数据,有效提升了模型在复杂环境下的检测精度与鲁棒性。然而,现有方法普遍基于严格配准的多模态数据开展研究,不能直接适配实际应用中不同模态相机得到的非空间配准图像,在图像输入算法前仍需完成配准,这损失了实时性和灵活性。为此,提出一种非空间配准条件下的多模态目标检测任务,并设计了一种非空间配准的多模态目标检测决策融合方法。在数据层面,利用3种公共数据集模拟双光载荷拍摄得到的非空间配准图像对,在不引入额外标注成本的前提下,为新的任务提供了基准数据。在算法层面,设计了一种基于图结构的非空间配准决策融合方法。方法首先,根据不同模态检测器的检测结果构建带权有向图,实现不同模态目标的图结构化表示;接着,利用图结构中目标间的相对位置关系,实现跨模态目标的自适应匹配;最终,对匹配成功的目标进行决策融合,并设计了模态迁移策略以实现多模态信息的高效互补。结果在3个数据集上的实验结果表明,本文方法在非空间配准场景下较单模态检测器实现了最大10.03%的漏检率降幅。同时,该方法在配准数据集上同样适用,相较于多光谱行人检测Transformer(multi spectral pedestrian detection Transformer,MS-DETR)、动态自适应多光谱检测Transformer(dynamic adaptive multispectral detection Transformer,DAMSDet)等先进多模态目标检测方法,检测准确率提升了6.8%。结论本文所提出的非空间配准多模态目标检测决策融合方法,能够很好地适应存在空间差异的实际场景,并且相比其他先进的多模态目标检测模型,有更高的准确率和鲁棒性。相关的代码与数据集将在此仓库公开:https://github.com/1e12Leon/ProbDet。关键词:目标检测;多模态目标检测;有向图;决策融合;非空间配准101|139|0更新时间:2026-02-11

图像分析和识别

- “相关研究在视频内容描述领域取得新进展,专家提出融合轨迹时空感知与自适应语义聚焦的方法,显著提升了视频描述的准确性和语义丰富性,为视频内容理解与表达提供了新思路。”

摘要:目的视频内容描述任务旨在自动生成自然语言句子,精准表达视频视觉语义信息。尽管编码器—解码器方法在视觉表达与语言生成上已有进展,但视频编码器难以建模目标级运动与事件,解码器也难以实现跨模态语义对齐,限制了生成文本质量。为此,提出融合轨迹时空感知与自适应语义聚焦的方法,以增强目标运动建模能力并改善多模态语义对齐。方法首先,提出基于点轨迹的视觉特征聚合方法,通过时空建模生成兼具空间外观与时间连续性的轨迹特征,并与局部运动特征融合,以增强模型在运动和形变场景下的目标追踪能力和语义连贯性;同时,设计无监督自适应关键轨迹聚焦学习方法,利用密集点轨迹动态信息,通过注意力权重自适应筛选关键轨迹并引入聚焦损失,引导模型优先关注关键语义区域、抑制背景干扰,从而提升跨模态语义关联能力。结果在MSR-VTT(Microsoft research video to text)和MSVD(Microsoft research video description corpus)两个公开数据集上进行实验,所提方法在CIDEr(consensus-based image description evaluation)指标上分别取得61.2和130.1的得分,显著优于现有主流方法,验证了所提方法在描述准确性与语义丰富性方面的有效性。定性分析表明,该方法在提升描述的时序连贯性和语义表达能力方面表现优异。结论本文方法有效提升了视频描述模型在复杂动态环境下的目标语义连续性建模能力,并通过无监督的自适应关键轨迹聚焦学习方法改善了注意力机制对视频与文本语义关联的能力。关键词:视频内容描述;多模态语义关联;时空点轨迹;特征聚合;自适应语义聚焦73|174|0更新时间:2026-02-11

摘要:目的视频内容描述任务旨在自动生成自然语言句子,精准表达视频视觉语义信息。尽管编码器—解码器方法在视觉表达与语言生成上已有进展,但视频编码器难以建模目标级运动与事件,解码器也难以实现跨模态语义对齐,限制了生成文本质量。为此,提出融合轨迹时空感知与自适应语义聚焦的方法,以增强目标运动建模能力并改善多模态语义对齐。方法首先,提出基于点轨迹的视觉特征聚合方法,通过时空建模生成兼具空间外观与时间连续性的轨迹特征,并与局部运动特征融合,以增强模型在运动和形变场景下的目标追踪能力和语义连贯性;同时,设计无监督自适应关键轨迹聚焦学习方法,利用密集点轨迹动态信息,通过注意力权重自适应筛选关键轨迹并引入聚焦损失,引导模型优先关注关键语义区域、抑制背景干扰,从而提升跨模态语义关联能力。结果在MSR-VTT(Microsoft research video to text)和MSVD(Microsoft research video description corpus)两个公开数据集上进行实验,所提方法在CIDEr(consensus-based image description evaluation)指标上分别取得61.2和130.1的得分,显著优于现有主流方法,验证了所提方法在描述准确性与语义丰富性方面的有效性。定性分析表明,该方法在提升描述的时序连贯性和语义表达能力方面表现优异。结论本文方法有效提升了视频描述模型在复杂动态环境下的目标语义连续性建模能力,并通过无监督的自适应关键轨迹聚焦学习方法改善了注意力机制对视频与文本语义关联的能力。关键词:视频内容描述;多模态语义关联;时空点轨迹;特征聚合;自适应语义聚焦73|174|0更新时间:2026-02-11 - “相关研究在红外与可见光图像融合领域取得新进展,研究人员提出创新IVIF框架,结合大气散射模型与频域特征组件,有效提升融合图像质量,为复杂场景图像融合提供新思路。”

摘要:目的红外与可见光图像融合(infrared and visible image fusion,IVIF)旨在融合多源图像中的互补信息,生成包含丰富纹理细节和明显热辐射特征的融合图像。然而,现有的融合方法未能充分考虑大气传输过程中的光能损失和散射效应,这对图像质量产生了不利影响,尤其是在光照变化显著的复杂场景中。方法为克服这一问题,提出一种创新的IVIF框架,将大气散射物理模型与频域特征组件相结合,精确预测并估计大气散射模型中的关键物理参数——传输图和大气光。通过这一框架,增强可见光图像,减轻散射和能量衰减的影响。此外,结合傅里叶变换与空间通道注意力机制,选择性地增强频域中的幅度和相位特征,有效提升融合图像的纹理保真度和细节表现。结果在RoadScene、TNO(TNO multiband image data collection)、M3FD(multi-modal fusion face detection)和VT5000(RGB-T salient object detection dataset VT5000) 4个公开数据集以及1个极端场景有雾数据集AWMM-100K(all-weather multi-modality image fusion 100K benchmark)上的实验评估显示,本文方法在复杂场景中的融合效果优于现有方法,融合图像具有清晰的目标轮廓和高视觉质量。在定量评估中,与其他深度学习方法相比,本文方法在信息熵、标准差、空间频率、平均梯度、峰值信噪比和相关系数6项指标上均值分别提升7.44%、44.22%、97.89%、91.01%、59.15%和83.68%,表明该方法在目标检测等高层次视觉任务中具有显著优势。结论本研究将传统大气散射模型引入IVIF领域,并结合傅里叶变换与空间通道注意力机制,提升了图像融合的精度和细节保真度,具有重要的实际应用价值。该方法能够有效减轻大气散射带来的负面影响,提升图像质量,适用于复杂动态环境中的实际应用,如目标识别、自动驾驶、遥感监测和安防监控等任务,在实际应用中展现出强大的潜力。关键词:图像融合;红外与可见光图像;大气散射增强;融合算法;深度学习94|140|0更新时间:2026-02-11

摘要:目的红外与可见光图像融合(infrared and visible image fusion,IVIF)旨在融合多源图像中的互补信息,生成包含丰富纹理细节和明显热辐射特征的融合图像。然而,现有的融合方法未能充分考虑大气传输过程中的光能损失和散射效应,这对图像质量产生了不利影响,尤其是在光照变化显著的复杂场景中。方法为克服这一问题,提出一种创新的IVIF框架,将大气散射物理模型与频域特征组件相结合,精确预测并估计大气散射模型中的关键物理参数——传输图和大气光。通过这一框架,增强可见光图像,减轻散射和能量衰减的影响。此外,结合傅里叶变换与空间通道注意力机制,选择性地增强频域中的幅度和相位特征,有效提升融合图像的纹理保真度和细节表现。结果在RoadScene、TNO(TNO multiband image data collection)、M3FD(multi-modal fusion face detection)和VT5000(RGB-T salient object detection dataset VT5000) 4个公开数据集以及1个极端场景有雾数据集AWMM-100K(all-weather multi-modality image fusion 100K benchmark)上的实验评估显示,本文方法在复杂场景中的融合效果优于现有方法,融合图像具有清晰的目标轮廓和高视觉质量。在定量评估中,与其他深度学习方法相比,本文方法在信息熵、标准差、空间频率、平均梯度、峰值信噪比和相关系数6项指标上均值分别提升7.44%、44.22%、97.89%、91.01%、59.15%和83.68%,表明该方法在目标检测等高层次视觉任务中具有显著优势。结论本研究将传统大气散射模型引入IVIF领域,并结合傅里叶变换与空间通道注意力机制,提升了图像融合的精度和细节保真度,具有重要的实际应用价值。该方法能够有效减轻大气散射带来的负面影响,提升图像质量,适用于复杂动态环境中的实际应用,如目标识别、自动驾驶、遥感监测和安防监控等任务,在实际应用中展现出强大的潜力。关键词:图像融合;红外与可见光图像;大气散射增强;融合算法;深度学习94|140|0更新时间:2026-02-11 -

面向边缘计算设备的轻量级双目立体匹配网络 AI导读

“专家提出轻量级实时立体匹配网络框架LBSM,摒弃高计算开销方案,采用2D卷积与轻量化通道注意力机制等,降低计算开销,提升准确性,为边缘计算设备部署双目立体视觉系统提供新方案。” 摘要:目的现有的高精度双目立体匹配网络因计算开销较高,难以部署到算力受限的边缘计算设备上,极大地限制了双目立体视觉系统的适用场景。针对此问题,提出一种轻量级实时立体匹配网络框架(light-weight binocular stereo matching framework, LBSM)。方法首先,摒弃了高计算开销的“4D代价体 + 3D卷积”的主流方案,仅采用2D卷积与轻量化通道注意力机制构建了高效的融合注意力(merged attention, MA)代价聚合模块,在降低计算开销的同时减少了信息丢失,使得代价聚合过程更加高效;其次,提出空间自适应视差传播(adaptive disparity propagation, ADP)策略以替代双线性插值,以极低的代价(仅增加约0.03 M参数、0.36 G“乘法—累加”操作数和1.1 ms推理时间)将端点误差和1像素误差分别降低了21.54%和20.73%,揭示了视差上采样策略在轻量级模型中的重要性。在上述方法的基础上,构建了仅依赖2D卷积、无需任何3D卷积层的轻量级模型框架LBSM,通过简单配置即可生成系列模型。结果实验结果表明,所提模型在大型数据集Scene Flow上以更低的计算开销取得了更高的准确性(LBSM-L以68.5%的“乘法—累加”操作数取得了明显高于BGNet(bilateral grid learning network)的准确性),而且在真实道路场景数据集KITTI 2012(Karlsruhe Institute of Technology and Toyota Technological Institute at Chicago)和KITTI 2015上分别取得了低至2.41%和2.52%的错误率,显著优于ADCPNet(adaptive disparity candidates prediction network)、P3SNet(parallel pyramid pooling stereo network)等主流轻量级立体匹配模型。此外,在嵌入式AI(artificial intelligence)硬件平台上的部署实测显示,模型处理速度达4.59~20.29帧/s。结论LBSM在计算开销与准确性之间实现了更好的权衡,能够在低算力边缘计算设备上实时完成双目立体匹配任务,在算力受限的实际场景中具有较大的应用潜力。关键词:双目立体视觉;全卷积网络;空间自适应性;轻量级模型;嵌入式智能设备160|121|0更新时间:2026-02-11

摘要:目的现有的高精度双目立体匹配网络因计算开销较高,难以部署到算力受限的边缘计算设备上,极大地限制了双目立体视觉系统的适用场景。针对此问题,提出一种轻量级实时立体匹配网络框架(light-weight binocular stereo matching framework, LBSM)。方法首先,摒弃了高计算开销的“4D代价体 + 3D卷积”的主流方案,仅采用2D卷积与轻量化通道注意力机制构建了高效的融合注意力(merged attention, MA)代价聚合模块,在降低计算开销的同时减少了信息丢失,使得代价聚合过程更加高效;其次,提出空间自适应视差传播(adaptive disparity propagation, ADP)策略以替代双线性插值,以极低的代价(仅增加约0.03 M参数、0.36 G“乘法—累加”操作数和1.1 ms推理时间)将端点误差和1像素误差分别降低了21.54%和20.73%,揭示了视差上采样策略在轻量级模型中的重要性。在上述方法的基础上,构建了仅依赖2D卷积、无需任何3D卷积层的轻量级模型框架LBSM,通过简单配置即可生成系列模型。结果实验结果表明,所提模型在大型数据集Scene Flow上以更低的计算开销取得了更高的准确性(LBSM-L以68.5%的“乘法—累加”操作数取得了明显高于BGNet(bilateral grid learning network)的准确性),而且在真实道路场景数据集KITTI 2012(Karlsruhe Institute of Technology and Toyota Technological Institute at Chicago)和KITTI 2015上分别取得了低至2.41%和2.52%的错误率,显著优于ADCPNet(adaptive disparity candidates prediction network)、P3SNet(parallel pyramid pooling stereo network)等主流轻量级立体匹配模型。此外,在嵌入式AI(artificial intelligence)硬件平台上的部署实测显示,模型处理速度达4.59~20.29帧/s。结论LBSM在计算开销与准确性之间实现了更好的权衡,能够在低算力边缘计算设备上实时完成双目立体匹配任务,在算力受限的实际场景中具有较大的应用潜力。关键词:双目立体视觉;全卷积网络;空间自适应性;轻量级模型;嵌入式智能设备160|121|0更新时间:2026-02-11 - “#论文摘要#介绍了其在高精度结构光三维成像领域的研究进展,相关专家提出了一种基于条件扩散模型的多频相位解包裹方法(DiffPhase),为解决相位图噪声污染与大范围跳跃问题提供了有效解决方案。”

摘要:目的相位解包裹是从受限于周期范围且受噪声干扰的相位信息中恢复连续相位的技术,是高精度结构光三维成像的关键步骤。受设备误差和环境干扰影响,相位图易受噪声污染甚至出现大范围跳跃,给三维成像带来困难。去噪扩散模型在图像生成方面表现突出,但其主要面向自然图像生成,难以保证几何模型精度,无法直接应用于相位解包裹与三维重建。此外,现有方法多依赖单频包裹相位,难以兼顾全局结构与局部细节。方法提出一种基于条件扩散模型的多频相位解包裹方法(DiffPhase),结合三维成像实现精确的绝对相位重建。该方法将相位解包裹建模为条件引导生成任务,通过构建与扩散网络对齐的多尺度特征提取模块,并引入跨尺度交叉注意力结构,将包裹相位特征逐步融合到扩散过程,提升局部精度与全局一致性。训练采用两阶段策略,先预训练特征提取模块学习结构先验,再进行端到端优化以增强预测性能。同时设计自适应多频输入机制,有效结合低频全局轮廓与高频局部细节,抑制误差传播并提升鲁棒性。结果在RME-multi(random matrix enlargement-multifrequency)和MoGR-multi(mixture of Gaussians with ramp-multifrequency)仿真数据集上,本文方法的归一化均方根误差分别为0.23%、0.24%;在NYU-phase(New York University-phase)和MS-phase(middlebury stereo-phase)真实数据集上分别为4.69%、7.50%,优于对比的8种深度学习及传统方法。在复杂场景中,该方法能在强噪声与遮挡下保持较高精度,尤其在细节边缘与复杂结构区域表现更优。结论DiffPhase方法充分利用扩散模型的条件生成与全局建模能力,能够在高噪声、高复杂度场景下获得准确稳健的解包裹结果,有效提升三维重建精度与鲁棒性。关键词:相位解包裹;扩散模型;三维建模;深度学习;计算机视觉151|157|0更新时间:2026-02-11

摘要:目的相位解包裹是从受限于周期范围且受噪声干扰的相位信息中恢复连续相位的技术,是高精度结构光三维成像的关键步骤。受设备误差和环境干扰影响,相位图易受噪声污染甚至出现大范围跳跃,给三维成像带来困难。去噪扩散模型在图像生成方面表现突出,但其主要面向自然图像生成,难以保证几何模型精度,无法直接应用于相位解包裹与三维重建。此外,现有方法多依赖单频包裹相位,难以兼顾全局结构与局部细节。方法提出一种基于条件扩散模型的多频相位解包裹方法(DiffPhase),结合三维成像实现精确的绝对相位重建。该方法将相位解包裹建模为条件引导生成任务,通过构建与扩散网络对齐的多尺度特征提取模块,并引入跨尺度交叉注意力结构,将包裹相位特征逐步融合到扩散过程,提升局部精度与全局一致性。训练采用两阶段策略,先预训练特征提取模块学习结构先验,再进行端到端优化以增强预测性能。同时设计自适应多频输入机制,有效结合低频全局轮廓与高频局部细节,抑制误差传播并提升鲁棒性。结果在RME-multi(random matrix enlargement-multifrequency)和MoGR-multi(mixture of Gaussians with ramp-multifrequency)仿真数据集上,本文方法的归一化均方根误差分别为0.23%、0.24%;在NYU-phase(New York University-phase)和MS-phase(middlebury stereo-phase)真实数据集上分别为4.69%、7.50%,优于对比的8种深度学习及传统方法。在复杂场景中,该方法能在强噪声与遮挡下保持较高精度,尤其在细节边缘与复杂结构区域表现更优。结论DiffPhase方法充分利用扩散模型的条件生成与全局建模能力,能够在高噪声、高复杂度场景下获得准确稳健的解包裹结果,有效提升三维重建精度与鲁棒性。关键词:相位解包裹;扩散模型;三维建模;深度学习;计算机视觉151|157|0更新时间:2026-02-11 -

融合手物特征的三维手部姿态估计网络 AI导读

“专家提出融合手物特征的三维手部姿态估计网络,通过多层次跨模态交互优化,有效提升遮挡场景下的手部姿态估计性能,为复杂交互场景下的人机交互研究开辟了新方向。” 摘要:目的手部姿态估计作为人机交互的核心感知技术,在复杂交互场景下,面临多尺度特征融合过程中信道丢失以及手物交互过程中遮挡干扰等挑战,现有方法多依赖单一特征提取策略或静态注意力机制,无法同时兼顾精度与鲁棒性。为此,提出一种融合手物特征的三维手部姿态估计网络(hand object collaborative enhancement network,HOCEN),旨在通过多层次跨模态交互优化,提升遮挡场景下的手部姿态估计性能。方法设计双流特征金字塔,通过双向跨尺度信息聚合捕获局部细节与全局语义依赖,缓解传统特征金字塔的通道信息丢失问题;给出一种基于外部注意力的动态调整模块,对提取后的手部特征进行动态注意力权重分配,抑制噪声干扰;构建双流协同注意力机制,结合手—物几何约束与语义互补特性,增强跨模态特征对齐能力;通过层级特征解码器重构精准的手部姿态参数。结果在Dex-YCB(dexterous-YCB)与HO3D(hand-object 3D)数据集上的实验结果表明,本文方法在遮挡场景下的手部关节定位精度高于当前的主流模型,在Dex-YCB数据集上,手部姿态估计指标MPJPE(mean per joint position error)和PA-MPJPE(procrustes-aligned mean per joint position error)分别达到12.4 mm和5.4 mm,均优于SemGCN(semantic graph convolutional network)、HFL(harmonious feature learning)等先进模型,在HO3D数据集上,手部姿态估计指标Join和Mesh上分别达到9.2 mm和9.1 mm,实现了极低的误差。此外,在Dex-YCB与HO3D数据集上分别进行消融实验,进一步证明各模块在手—物协同估计指标上的独立贡献与协同增益。结论本文提出一种基于动态手物交互特征融合的三维手部姿态估计网络架构,通过跨模态特征协同建模机制有效提升姿态估计精度。实验结果表明,本文方法在复杂交互场景下具有较高的鲁棒性与泛化能力,提出的动态特征校准与手物协同策略为提升遮挡场景下的手部姿态估计提供了全新的解决方案。关键词:手势姿态估计;双流金字塔特征融合;动态注意力机制;动态特征调整;手物协同增强173|150|0更新时间:2026-02-11

摘要:目的手部姿态估计作为人机交互的核心感知技术,在复杂交互场景下,面临多尺度特征融合过程中信道丢失以及手物交互过程中遮挡干扰等挑战,现有方法多依赖单一特征提取策略或静态注意力机制,无法同时兼顾精度与鲁棒性。为此,提出一种融合手物特征的三维手部姿态估计网络(hand object collaborative enhancement network,HOCEN),旨在通过多层次跨模态交互优化,提升遮挡场景下的手部姿态估计性能。方法设计双流特征金字塔,通过双向跨尺度信息聚合捕获局部细节与全局语义依赖,缓解传统特征金字塔的通道信息丢失问题;给出一种基于外部注意力的动态调整模块,对提取后的手部特征进行动态注意力权重分配,抑制噪声干扰;构建双流协同注意力机制,结合手—物几何约束与语义互补特性,增强跨模态特征对齐能力;通过层级特征解码器重构精准的手部姿态参数。结果在Dex-YCB(dexterous-YCB)与HO3D(hand-object 3D)数据集上的实验结果表明,本文方法在遮挡场景下的手部关节定位精度高于当前的主流模型,在Dex-YCB数据集上,手部姿态估计指标MPJPE(mean per joint position error)和PA-MPJPE(procrustes-aligned mean per joint position error)分别达到12.4 mm和5.4 mm,均优于SemGCN(semantic graph convolutional network)、HFL(harmonious feature learning)等先进模型,在HO3D数据集上,手部姿态估计指标Join和Mesh上分别达到9.2 mm和9.1 mm,实现了极低的误差。此外,在Dex-YCB与HO3D数据集上分别进行消融实验,进一步证明各模块在手—物协同估计指标上的独立贡献与协同增益。结论本文提出一种基于动态手物交互特征融合的三维手部姿态估计网络架构,通过跨模态特征协同建模机制有效提升姿态估计精度。实验结果表明,本文方法在复杂交互场景下具有较高的鲁棒性与泛化能力,提出的动态特征校准与手物协同策略为提升遮挡场景下的手部姿态估计提供了全新的解决方案。关键词:手势姿态估计;双流金字塔特征融合;动态注意力机制;动态特征调整;手物协同增强173|150|0更新时间:2026-02-11

图像理解和计算机视觉

- “相关研究在遥感影像建筑物提取领域取得新进展,专家们提出了一种无提示—判别联合模型(SAM-Classifier),实现了通用视觉模型向遥感场景的迁移,完成了建筑物的自动化高效提取,为解决传统方法精度瓶颈问题提供了新方案。”

摘要:目的针对传统高分辨率影像建筑物提取方法的精度瓶颈,SAM(segment anything model)模型虽然具有分割优势,却因训练域差异和人工提示依赖,无法直接应用于大规模遥感影像的自动化提取。为此,提出一种无提示—判别联合模型(SAM-Classifier),实现了通用视觉模型向遥感场景的迁移,完成了建筑物的自动化高效提取。方法本研究采用了一系列实验来系统探究不同提示方式(包括点提示、框提示和掩码提示)在SAM模型指导下的建筑物提取效果,并引入一个无需提示的联合模型——SAM-Classifier,以克服传统SAM模型在语义理解和提示依赖方面的限制。实验基于3个公开可用的数据集进行,以全面评估各种提示策略下SAM模型的表现。此外,为了比较不同解决方案在建筑物提取任务中的性能差异,还特别设计了对比实验,将SAM模型及SAM-Classifier的结果与商汤科技开发的遥感大模型(Sense Earth 3.0)进行了详细的对比分析。结果实验表明,框提示引导下的 SAM分割表现最优(WHU数据集F1分数0.945);所提出的SAM-Classifier 无需人工提示,Ma数据集F1分数0.717,与对比的先进方法性能相近。结论本文提出 SAM-Classifier,通过融合轻量级分类器实现无需提示的端到端建筑物提取,有效缓解了SAM的语义理解不足与提示依赖问题,为遥感影像的自动化解译提供了新方案。关键词:图像分割;高分辨率影像;建筑物提取;SAM(segment anything model);提示分割;优化策略155|115|0更新时间:2026-02-11

摘要:目的针对传统高分辨率影像建筑物提取方法的精度瓶颈,SAM(segment anything model)模型虽然具有分割优势,却因训练域差异和人工提示依赖,无法直接应用于大规模遥感影像的自动化提取。为此,提出一种无提示—判别联合模型(SAM-Classifier),实现了通用视觉模型向遥感场景的迁移,完成了建筑物的自动化高效提取。方法本研究采用了一系列实验来系统探究不同提示方式(包括点提示、框提示和掩码提示)在SAM模型指导下的建筑物提取效果,并引入一个无需提示的联合模型——SAM-Classifier,以克服传统SAM模型在语义理解和提示依赖方面的限制。实验基于3个公开可用的数据集进行,以全面评估各种提示策略下SAM模型的表现。此外,为了比较不同解决方案在建筑物提取任务中的性能差异,还特别设计了对比实验,将SAM模型及SAM-Classifier的结果与商汤科技开发的遥感大模型(Sense Earth 3.0)进行了详细的对比分析。结果实验表明,框提示引导下的 SAM分割表现最优(WHU数据集F1分数0.945);所提出的SAM-Classifier 无需人工提示,Ma数据集F1分数0.717,与对比的先进方法性能相近。结论本文提出 SAM-Classifier,通过融合轻量级分类器实现无需提示的端到端建筑物提取,有效缓解了SAM的语义理解不足与提示依赖问题,为遥感影像的自动化解译提供了新方案。关键词:图像分割;高分辨率影像;建筑物提取;SAM(segment anything model);提示分割;优化策略155|115|0更新时间:2026-02-11

遥感图像处理

0