最新刊期

2022 年 第 27 卷 第 10 期

-

-

摘要:随着多媒体技术的发展,可获取的媒体数据在种类和量级上大幅提升。受人类感知方式的启发,多种媒体数据互相融合处理,促进了人工智能在计算机视觉领域的研究发展,在遥感图像解译、生物医学和深度估计等方面有广泛的应用。尽管多模态数据在描述事物特征时具有明显优势,但仍面临着较大的挑战。1)受到不同成像设备和传感器的限制,难以收集到大规模、高质量的多模态数据集;2)多模态数据需要匹配成对用于研究,任一模态的缺失都会造成可用数据的减少;3)图像、视频数据在处理和标注上需要耗费较多的时间和人力成本,这些问题使得目前本领域的技术尚待攻关。本文立足于数据受限条件下的多模态学习方法,根据样本数量、标注信息和样本质量等不同的维度,将计算机视觉领域中的多模态数据受限方法分为小样本学习、缺乏强监督标注信息、主动学习、数据去噪和数据增强5个方向,详细阐述了各类方法的样本特点和模型方法的最新进展。并介绍了数据受限前提下的多模态学习方法使用的数据集及其应用方向(包括人体姿态估计、行人重识别等),对比分析了现有算法的优缺点以及未来的发展方向,对该领域的发展具有积极的意义。关键词:多模态数据;数据受限;深度学习;融合算法;计算机视觉156|328|5更新时间:2024-05-07

摘要:随着多媒体技术的发展,可获取的媒体数据在种类和量级上大幅提升。受人类感知方式的启发,多种媒体数据互相融合处理,促进了人工智能在计算机视觉领域的研究发展,在遥感图像解译、生物医学和深度估计等方面有广泛的应用。尽管多模态数据在描述事物特征时具有明显优势,但仍面临着较大的挑战。1)受到不同成像设备和传感器的限制,难以收集到大规模、高质量的多模态数据集;2)多模态数据需要匹配成对用于研究,任一模态的缺失都会造成可用数据的减少;3)图像、视频数据在处理和标注上需要耗费较多的时间和人力成本,这些问题使得目前本领域的技术尚待攻关。本文立足于数据受限条件下的多模态学习方法,根据样本数量、标注信息和样本质量等不同的维度,将计算机视觉领域中的多模态数据受限方法分为小样本学习、缺乏强监督标注信息、主动学习、数据去噪和数据增强5个方向,详细阐述了各类方法的样本特点和模型方法的最新进展。并介绍了数据受限前提下的多模态学习方法使用的数据集及其应用方向(包括人体姿态估计、行人重识别等),对比分析了现有算法的优缺点以及未来的发展方向,对该领域的发展具有积极的意义。关键词:多模态数据;数据受限;深度学习;融合算法;计算机视觉156|328|5更新时间:2024-05-07 -

摘要:恶劣复杂及对抗环境下产生的图像数据通常受限,常具有非完整、不确定、小样本、小目标的全部或部分特性,与通常的图像大数据相比,对受限图像数据处理和分析的方法有明显区别:大数据的统计特性显著依赖于中心极限定理下的3σ原则,而受限下的图像数据统计一致性弱,难以体现可信且鲁棒的集中优势特点;遮挡、伪装等情况导致样本信息乃至维度都具有不完整性或非确定性,以模糊数学为基础的系列处理方法导致计算量剧增;以深度学习为代表的系列大数据处理方法得到巨大发展,但由于受限图像数据的处理和分析基本属于不可逆的逆问题,其解空间一般为高维子空间,如何可信鲁棒地确定空间中的解,目前尚无有效可行的通用理论和方法;采用隶属度为测度的系列方法需紧密依赖融入先验知识构造的代价函数。为促进受限图像数据的研究,梳理了对其处理和分析的机理、方法、手段以及遇到的困难,提出了可能的突破方法,以及催生的研究范式改变,以求抛砖引玉,吸引更多学者从事该研究。关键词:图像数据受限;中心极限定理;不可逆的逆问题;模糊数学;研究范式95|127|0更新时间:2024-05-07

摘要:恶劣复杂及对抗环境下产生的图像数据通常受限,常具有非完整、不确定、小样本、小目标的全部或部分特性,与通常的图像大数据相比,对受限图像数据处理和分析的方法有明显区别:大数据的统计特性显著依赖于中心极限定理下的3σ原则,而受限下的图像数据统计一致性弱,难以体现可信且鲁棒的集中优势特点;遮挡、伪装等情况导致样本信息乃至维度都具有不完整性或非确定性,以模糊数学为基础的系列处理方法导致计算量剧增;以深度学习为代表的系列大数据处理方法得到巨大发展,但由于受限图像数据的处理和分析基本属于不可逆的逆问题,其解空间一般为高维子空间,如何可信鲁棒地确定空间中的解,目前尚无有效可行的通用理论和方法;采用隶属度为测度的系列方法需紧密依赖融入先验知识构造的代价函数。为促进受限图像数据的研究,梳理了对其处理和分析的机理、方法、手段以及遇到的困难,提出了可能的突破方法,以及催生的研究范式改变,以求抛砖引玉,吸引更多学者从事该研究。关键词:图像数据受限;中心极限定理;不可逆的逆问题;模糊数学;研究范式95|127|0更新时间:2024-05-07 -

摘要:目的在智能监控视频分析领域中,行人重识别是跨无交叠视域的摄像头匹配行人的基础问题。在可见光图像的单模态匹配问题上,现有方法在公开标准数据集上已取得优良的性能。然而,在跨正常光照与低照度场景进行行人重识别的时候,使用可见光图像和红外图像进行跨模态匹配的效果仍不理想。研究的难点主要有两方面:1)在不同光谱范围成像的可见光图像与红外图像之间显著的视觉差异导致模态鸿沟难以消除;2)人工难以分辨跨模态图像的行人身份导致标注数据缺乏。针对以上两个问题,本文研究如何利用易于获得的有标注可见光图像辅助数据进行单模态自监督信息的挖掘,从而提供先验知识引导跨模态匹配模型的学习。方法提出一种随机单通道掩膜的数据增强方法,对输入可见光图像的3个通道使用掩膜随机保留单通道的信息,使模型关注提取对光谱范围不敏感的特征。提出一种基于三通道与单通道双模型互学习的预训练与微调方法,利用三通道数据与单通道数据之间的关系挖掘与迁移鲁棒的跨光谱自监督信息,提高跨模态匹配模型的匹配能力。结果跨模态行人重识别的实验在“可见光—红外”多模态行人数据集SYSU-MM01(Sun Yat-Sen University Multiple Modality 01)、RGBNT201(RGB, near infrared, thermal infrared, 201)和RegDB上进行。实验结果表明,本文方法在这3个数据集上都达到领先水平。与对比方法中的最优结果相比,在RGBNT201数据集上的平均精度均值mAP(mean average precision)有最高接近5%的提升。结论提出的单模态跨光谱自监督信息挖掘方法,利用单模态可见光图像辅助数据挖掘对光谱范围变化不敏感的自监督信息,引导单模态预训练与多模态有监督微调,提高跨模态行人重识别的性能。关键词:行人重识别;跨模态检索;红外图像;自监督学习;互学习123|199|5更新时间:2024-05-07

摘要:目的在智能监控视频分析领域中,行人重识别是跨无交叠视域的摄像头匹配行人的基础问题。在可见光图像的单模态匹配问题上,现有方法在公开标准数据集上已取得优良的性能。然而,在跨正常光照与低照度场景进行行人重识别的时候,使用可见光图像和红外图像进行跨模态匹配的效果仍不理想。研究的难点主要有两方面:1)在不同光谱范围成像的可见光图像与红外图像之间显著的视觉差异导致模态鸿沟难以消除;2)人工难以分辨跨模态图像的行人身份导致标注数据缺乏。针对以上两个问题,本文研究如何利用易于获得的有标注可见光图像辅助数据进行单模态自监督信息的挖掘,从而提供先验知识引导跨模态匹配模型的学习。方法提出一种随机单通道掩膜的数据增强方法,对输入可见光图像的3个通道使用掩膜随机保留单通道的信息,使模型关注提取对光谱范围不敏感的特征。提出一种基于三通道与单通道双模型互学习的预训练与微调方法,利用三通道数据与单通道数据之间的关系挖掘与迁移鲁棒的跨光谱自监督信息,提高跨模态匹配模型的匹配能力。结果跨模态行人重识别的实验在“可见光—红外”多模态行人数据集SYSU-MM01(Sun Yat-Sen University Multiple Modality 01)、RGBNT201(RGB, near infrared, thermal infrared, 201)和RegDB上进行。实验结果表明,本文方法在这3个数据集上都达到领先水平。与对比方法中的最优结果相比,在RGBNT201数据集上的平均精度均值mAP(mean average precision)有最高接近5%的提升。结论提出的单模态跨光谱自监督信息挖掘方法,利用单模态可见光图像辅助数据挖掘对光谱范围变化不敏感的自监督信息,引导单模态预训练与多模态有监督微调,提高跨模态行人重识别的性能。关键词:行人重识别;跨模态检索;红外图像;自监督学习;互学习123|199|5更新时间:2024-05-07 -

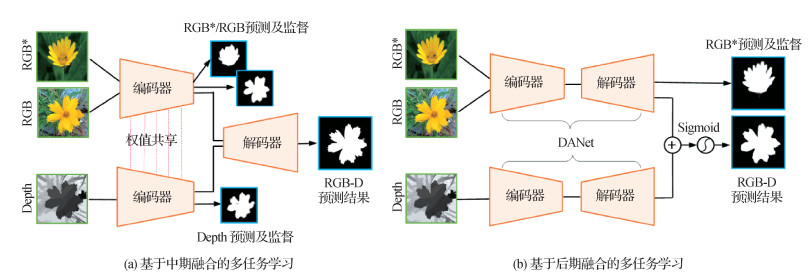

摘要:目的现有基于RGB-D(RGB-depth)的显著性物体检测方法往往通过全监督方式在一个较小的RGB-D训练集上进行训练,因此其泛化性能受到较大的局限。受小样本学习方法的启发,本文将RGB-D显著性物体检测视为小样本问题,利用模型解空间优化和训练样本扩充两类小样本学习方法,探究并解决小样本条件下的RGB-D显著性物体检测。方法模型解空间优化通过对RGB和RGB-D显著性物体检测这两种任务进行多任务学习,并采用模型参数共享的方式约束模型的解空间,从而将额外的RGB显著性物体检测任务学习到的知识迁移至RGB-D显著性物体检测任务中。另外,训练样本扩充通过深度估计算法从额外的RGB数据生成相应的深度图,并将RGB图像和所生成的深度图用于RGB-D显著性物体检测任务的训练。结果在9个数据集上的对比实验表明,引入小样本学习方法能有效提升RGB-D显著性物体检测的性能。此外,对不同小样本学习方法在不同的RGB-D显著性物体检测模型下(包括典型的中期融合模型和后期融合模型)进行了对比研究,并进行相关分析与讨论。结论本文尝试将小样本学习方法用于RGB-D显著性物体检测,探究并利用两种不同小样本学习方法迁移额外的RGB图像知识,通过大量实验验证了引入小样本学习来提升RGB-D显著性物体检测性能的可行性和有效性,对后续将小样本学习引入其他多模态检测任务也提供了一定的启示。关键词:多模态检测;RGB-D显著性检测;小样本学习;多任务学习;深度估计236|283|1更新时间:2024-05-07

摘要:目的现有基于RGB-D(RGB-depth)的显著性物体检测方法往往通过全监督方式在一个较小的RGB-D训练集上进行训练,因此其泛化性能受到较大的局限。受小样本学习方法的启发,本文将RGB-D显著性物体检测视为小样本问题,利用模型解空间优化和训练样本扩充两类小样本学习方法,探究并解决小样本条件下的RGB-D显著性物体检测。方法模型解空间优化通过对RGB和RGB-D显著性物体检测这两种任务进行多任务学习,并采用模型参数共享的方式约束模型的解空间,从而将额外的RGB显著性物体检测任务学习到的知识迁移至RGB-D显著性物体检测任务中。另外,训练样本扩充通过深度估计算法从额外的RGB数据生成相应的深度图,并将RGB图像和所生成的深度图用于RGB-D显著性物体检测任务的训练。结果在9个数据集上的对比实验表明,引入小样本学习方法能有效提升RGB-D显著性物体检测的性能。此外,对不同小样本学习方法在不同的RGB-D显著性物体检测模型下(包括典型的中期融合模型和后期融合模型)进行了对比研究,并进行相关分析与讨论。结论本文尝试将小样本学习方法用于RGB-D显著性物体检测,探究并利用两种不同小样本学习方法迁移额外的RGB图像知识,通过大量实验验证了引入小样本学习来提升RGB-D显著性物体检测性能的可行性和有效性,对后续将小样本学习引入其他多模态检测任务也提供了一定的启示。关键词:多模态检测;RGB-D显著性检测;小样本学习;多任务学习;深度估计236|283|1更新时间:2024-05-07

图像数据受限

-

摘要:目标检测是一种广泛应用于工业控制和航空航天等安全攸关场景的重要技术。随着深度学习在目标检测领域的应用,检测精度得到较大提升,但由于深度学习固有的脆弱性,使得基于深度学习的目标检测技术的可靠性和安全性面临新的挑战。本文对面向目标检测的对抗样本生成及防御的研究分析和总结,致力于为增强目标检测模型的鲁棒性和提出更好的防御策略提供思路。首先,介绍对抗样本的概念、产生原因以及目标检测领域对抗样本生成常用的评价指标和数据集。然后,根据对抗样本生成的扰动范围将攻击分为全局扰动攻击和局部扰动攻击,并在此分类基础上,分别从攻击的目标检测器类型、损失函数设计等方面对目标检测的对抗样本生成方法进行分析和总结,通过实验对比了几种典型目标检测对抗攻击方法的性能,同时比较了这几种方法的跨模型迁移攻击能力。此外,本文对目前目标检测领域常用的对抗防御策略进行了分析和归纳。最后,总结了目标检测领域对抗样本的生成及防御面临的挑战,并对未来发展方向做出展望。关键词:目标检测;对抗样本;深度学习;对抗防御;全局扰动;局部扰动561|542|8更新时间:2024-05-07

摘要:目标检测是一种广泛应用于工业控制和航空航天等安全攸关场景的重要技术。随着深度学习在目标检测领域的应用,检测精度得到较大提升,但由于深度学习固有的脆弱性,使得基于深度学习的目标检测技术的可靠性和安全性面临新的挑战。本文对面向目标检测的对抗样本生成及防御的研究分析和总结,致力于为增强目标检测模型的鲁棒性和提出更好的防御策略提供思路。首先,介绍对抗样本的概念、产生原因以及目标检测领域对抗样本生成常用的评价指标和数据集。然后,根据对抗样本生成的扰动范围将攻击分为全局扰动攻击和局部扰动攻击,并在此分类基础上,分别从攻击的目标检测器类型、损失函数设计等方面对目标检测的对抗样本生成方法进行分析和总结,通过实验对比了几种典型目标检测对抗攻击方法的性能,同时比较了这几种方法的跨模型迁移攻击能力。此外,本文对目前目标检测领域常用的对抗防御策略进行了分析和归纳。最后,总结了目标检测领域对抗样本的生成及防御面临的挑战,并对未来发展方向做出展望。关键词:目标检测;对抗样本;深度学习;对抗防御;全局扰动;局部扰动561|542|8更新时间:2024-05-07 -

摘要:超像素/体素分割算法把具有相同结构信息的点划分至同一子区域,获得可准确描述图像局部特征且符合功能子结构的平滑边缘信息,在医学磁共振成像(magnetic resonance imaging, MRI)分割领域广泛应用。本文比较了不同超像素算法分割脑肿瘤医学图像的性能。归纳并总结了多种最新超像素/体素算法的研究成果及应用,为进一步比较算法性能,选取了多模态脑肿瘤分割挑战赛(Multimodal Brain Tumor Segmentation Challenge, BraTS) 2018数据集中的部分脑肿瘤图像进行超像素分割。同时,通过边缘召回率、欠分割错误率、紧密度评测和可达分割准确率4项指标分析算法性能,并阐述算法的未来发展趋势和可行性空间。通过上述算法分析可得:基于图论的(graph-based)、标准化分割(normalized cut)、随机游走算法(lazy random walk)可获得精准的核心肿瘤信息,但对增强肿瘤的准确率稍显不足,不利于后续特征区域提取。基于密度的聚类算法(density-based spatial clustering of applications with noise, DBSCAN)和线性谱聚类(linear spectral clustering, LSC)算法可较好保留肿瘤边界信息,具有较好的局部局灶信息特征,但不能实现邻域信息表达,且没有解决质量跨度较大的问题。拓扑保持正则、Turbopixels和简单线性迭代聚类分割算法(simple linear iterative clustering algorithm, SLIC)的超像素形状结构上更加完整紧凑,对病灶边界的特征描述较为平滑柔和,以此弥补算法对边界描述的不足之处。通过评价指标、国内外最新发展动态和实验对比分析,可看出超像素/体素分割算法具有较高的分割性能,研究领域具有良好的发展前景。关键词:图像处理;磁共振成像(MRI);超像素/体素;脑肿瘤分割;评价指标142|345|0更新时间:2024-05-07

摘要:超像素/体素分割算法把具有相同结构信息的点划分至同一子区域,获得可准确描述图像局部特征且符合功能子结构的平滑边缘信息,在医学磁共振成像(magnetic resonance imaging, MRI)分割领域广泛应用。本文比较了不同超像素算法分割脑肿瘤医学图像的性能。归纳并总结了多种最新超像素/体素算法的研究成果及应用,为进一步比较算法性能,选取了多模态脑肿瘤分割挑战赛(Multimodal Brain Tumor Segmentation Challenge, BraTS) 2018数据集中的部分脑肿瘤图像进行超像素分割。同时,通过边缘召回率、欠分割错误率、紧密度评测和可达分割准确率4项指标分析算法性能,并阐述算法的未来发展趋势和可行性空间。通过上述算法分析可得:基于图论的(graph-based)、标准化分割(normalized cut)、随机游走算法(lazy random walk)可获得精准的核心肿瘤信息,但对增强肿瘤的准确率稍显不足,不利于后续特征区域提取。基于密度的聚类算法(density-based spatial clustering of applications with noise, DBSCAN)和线性谱聚类(linear spectral clustering, LSC)算法可较好保留肿瘤边界信息,具有较好的局部局灶信息特征,但不能实现邻域信息表达,且没有解决质量跨度较大的问题。拓扑保持正则、Turbopixels和简单线性迭代聚类分割算法(simple linear iterative clustering algorithm, SLIC)的超像素形状结构上更加完整紧凑,对病灶边界的特征描述较为平滑柔和,以此弥补算法对边界描述的不足之处。通过评价指标、国内外最新发展动态和实验对比分析,可看出超像素/体素分割算法具有较高的分割性能,研究领域具有良好的发展前景。关键词:图像处理;磁共振成像(MRI);超像素/体素;脑肿瘤分割;评价指标142|345|0更新时间:2024-05-07 -

摘要:深度学习作为人工智能的一个研究分支发展迅速,而研究数据主要是语音、图像和视频等,这些具有规则结构的数据通常在欧氏空间中表示。然而许多学习任务需要处理的数据是从非欧氏空间中生成,这些数据特征和其关系结构可以用图来定义。图卷积神经网络通过将卷积定理应用于图,完成节点之间的信息传播与聚合,成为建模图数据一种有效的方法。尽管图卷积神经网络取得了巨大成功,但针对图任务中的节点分类问题,由于深层图结构优化的特有难点——过平滑现象,现有的多数模型都只有两三层的浅层模型架构。在理论上,图卷积神经网络的深层结构可以获得更多节点表征信息,因此针对其层级信息进行研究,将层级结构算法迁移到图数据分析的核心在于图层级卷积算子构建和图层级间信息融合。本文对图网络层级信息挖掘算法进行综述,介绍图神经网络的发展背景、存在问题以及图卷积神经网络层级结构算法的发展,根据不同图卷积层级信息处理将现有算法分为正则化方法和架构调整方法。正则化方法通过重新构建图卷积算子更好地聚合邻域信息,而架构调整方法则融合层级信息丰富节点表征。图卷积神经网络层级特性实验表明,图结构中存在层级特性节点,现有图层级信息挖掘算法仍未对层级特性节点的图信息进行完全探索。最后,总结了图卷积神经网络层级信息挖掘模型的主要应用领域,并从计算效率、大规模数据、动态图和应用场景等方面提出进一步研究的方向。关键词:层级结构;图卷积神经网络(GCN);注意力机制;人工智能;深度学习143|974|1更新时间:2024-05-07

摘要:深度学习作为人工智能的一个研究分支发展迅速,而研究数据主要是语音、图像和视频等,这些具有规则结构的数据通常在欧氏空间中表示。然而许多学习任务需要处理的数据是从非欧氏空间中生成,这些数据特征和其关系结构可以用图来定义。图卷积神经网络通过将卷积定理应用于图,完成节点之间的信息传播与聚合,成为建模图数据一种有效的方法。尽管图卷积神经网络取得了巨大成功,但针对图任务中的节点分类问题,由于深层图结构优化的特有难点——过平滑现象,现有的多数模型都只有两三层的浅层模型架构。在理论上,图卷积神经网络的深层结构可以获得更多节点表征信息,因此针对其层级信息进行研究,将层级结构算法迁移到图数据分析的核心在于图层级卷积算子构建和图层级间信息融合。本文对图网络层级信息挖掘算法进行综述,介绍图神经网络的发展背景、存在问题以及图卷积神经网络层级结构算法的发展,根据不同图卷积层级信息处理将现有算法分为正则化方法和架构调整方法。正则化方法通过重新构建图卷积算子更好地聚合邻域信息,而架构调整方法则融合层级信息丰富节点表征。图卷积神经网络层级特性实验表明,图结构中存在层级特性节点,现有图层级信息挖掘算法仍未对层级特性节点的图信息进行完全探索。最后,总结了图卷积神经网络层级信息挖掘模型的主要应用领域,并从计算效率、大规模数据、动态图和应用场景等方面提出进一步研究的方向。关键词:层级结构;图卷积神经网络(GCN);注意力机制;人工智能;深度学习143|974|1更新时间:2024-05-07 -

摘要:图像美学评价方法是当前研究的热点问题。图像美学评价分为大众化和个性化两种。大众化图像美学评价主要研究大多数人对图像共同的审美感知评估,而个性化图像美学评价可以针对用户的个性化审美感知进行评估。现有的研究工作主要集中在大众化图像美学评价上,但是由于人们对图像的审美体验具有高度主观性,研究针对特定用户的个性化图像美学评价方法更加符合现实意义。目前研究人员针对个性化图像美学评价展开了相关研究,并取得了一定的研究进展。但是现有的文献中缺少对个性化图像美学评价方法的综述,本文针对个性化图像美学评价的研究进展与趋势进行概述。首先分析图像美学评价的研究现状与发展趋势; 然后针对现阶段的个性化图像美学评价模型进行概述,将现有的个性化图像美学评价模型总结为基于协同过滤的模型、基于用户交互的模型和基于审美差异的模型,并分析这3类模型主要的设计思路以及优缺点; 最后介绍个性化图像美学评价在精准营销、个性化推荐系统、个性化视觉增强和个性化艺术设计上的应用前景,并指出未来研究工作在主观特性分析和知识驱动建模等方面的发展方向。关键词:个性化图像美学;评价方法;审美体验;主观特性;知识驱动212|928|0更新时间:2024-05-07

摘要:图像美学评价方法是当前研究的热点问题。图像美学评价分为大众化和个性化两种。大众化图像美学评价主要研究大多数人对图像共同的审美感知评估,而个性化图像美学评价可以针对用户的个性化审美感知进行评估。现有的研究工作主要集中在大众化图像美学评价上,但是由于人们对图像的审美体验具有高度主观性,研究针对特定用户的个性化图像美学评价方法更加符合现实意义。目前研究人员针对个性化图像美学评价展开了相关研究,并取得了一定的研究进展。但是现有的文献中缺少对个性化图像美学评价方法的综述,本文针对个性化图像美学评价的研究进展与趋势进行概述。首先分析图像美学评价的研究现状与发展趋势; 然后针对现阶段的个性化图像美学评价模型进行概述,将现有的个性化图像美学评价模型总结为基于协同过滤的模型、基于用户交互的模型和基于审美差异的模型,并分析这3类模型主要的设计思路以及优缺点; 最后介绍个性化图像美学评价在精准营销、个性化推荐系统、个性化视觉增强和个性化艺术设计上的应用前景,并指出未来研究工作在主观特性分析和知识驱动建模等方面的发展方向。关键词:个性化图像美学;评价方法;审美体验;主观特性;知识驱动212|928|0更新时间:2024-05-07 -

摘要:青光眼是以视神经损伤、特征性视野损伤为特点的一类眼病,在早期很难诊断,尽早发现可更好地遏制青光眼病症的恶化,降低致盲率。视盘和视杯的比值是评价青光眼诊断中的重要指标之一,视盘和视杯的分割是青光眼诊断的关键步骤。但眼底彩照中的渗出物、不均匀照明区域等特征使其可能出现相似的亮度区域,导致视盘和视杯的分割非常困难。因此本文对现有眼底彩照中视盘和视杯的分割方法进行了总结,并将其分为5大类:水平集法、模态法、能量泛函法、划分法以及基于机器学习的混合法。系统地梳理了各类算法的代表性方法,以及基本思想、理论基础、关键技术、框架流程和优缺点等。同时,概括了适用于青光眼诊断的各种数据集,包括数据集的名称、来源以及详细内容,并总结了在各种数据集中不同视盘和视杯分割结果和诊断青光眼的量化指标及其相关结果。在现有的视盘和视杯分割方法中,许多图像处理和机器学习技术得到广泛应用。通过对该领域研究算法进行综述,清晰直观地总结了各类算法之间的特点及联系,有助于推动视盘和视杯分割在青光眼疾病临床诊断中的应用。可以在很大程度上提高临床医生的工作效率,为临床诊断青光眼提供了重要的理论研究意义和价值。关键词:眼底彩照;视盘分割;视杯分割;青光眼;诊断217|1177|0更新时间:2024-05-07

摘要:青光眼是以视神经损伤、特征性视野损伤为特点的一类眼病,在早期很难诊断,尽早发现可更好地遏制青光眼病症的恶化,降低致盲率。视盘和视杯的比值是评价青光眼诊断中的重要指标之一,视盘和视杯的分割是青光眼诊断的关键步骤。但眼底彩照中的渗出物、不均匀照明区域等特征使其可能出现相似的亮度区域,导致视盘和视杯的分割非常困难。因此本文对现有眼底彩照中视盘和视杯的分割方法进行了总结,并将其分为5大类:水平集法、模态法、能量泛函法、划分法以及基于机器学习的混合法。系统地梳理了各类算法的代表性方法,以及基本思想、理论基础、关键技术、框架流程和优缺点等。同时,概括了适用于青光眼诊断的各种数据集,包括数据集的名称、来源以及详细内容,并总结了在各种数据集中不同视盘和视杯分割结果和诊断青光眼的量化指标及其相关结果。在现有的视盘和视杯分割方法中,许多图像处理和机器学习技术得到广泛应用。通过对该领域研究算法进行综述,清晰直观地总结了各类算法之间的特点及联系,有助于推动视盘和视杯分割在青光眼疾病临床诊断中的应用。可以在很大程度上提高临床医生的工作效率,为临床诊断青光眼提供了重要的理论研究意义和价值。关键词:眼底彩照;视盘分割;视杯分割;青光眼;诊断217|1177|0更新时间:2024-05-07

综述

-

摘要:目的将低分辨率(low-resolution,LR)图像映射到高分辨率(high-resolution,HR)图像是典型的不适定恢复问题,即输出的HR图像和输入的LR图像之间的映射是多对一的,这意味着仅通过增加网络深度来确定HR图像与LR图像之间的特定映射关系是非常困难的。针对该问题,本文提出一种基于多监督光滑化损失函数的图像超分辨率方法。方法该方法主体由LR图像上采样通道和HR图像下采样通道两部分组成。各通道分为两个阶段,每个阶段均包括浅层特征提取模块、基于迭代采样错误反馈机制的采样模块、全局特征融合模块和图像重建模块。将LR图像上采样通道第1阶段结果与HR图像下采样通道第1阶段结果对比,然后将HR原图像和HR图像下采样通道第2阶段结果作为约束构成多监督,使映射函数空间尽可能精确,并将多监督损失函数光滑化保证梯度在全局范围内传递。结果在基准测试集Set5、Set14、BSD100(Berkeley segmentation dataset)、Urban100(urban scenes dataset)、Manga109(109 manga volumes dataset)数据集上进行测试,并与Bicubic、SRCNN(super-resolution convolutional neural network)、FSRCNN(fast super-resolution convolutional neural network)、LapSRN(Laplacian pyramid super-resolution network)、VDSR(very deep super-resolution convolutional networks)、DBPN(deep back-projection networks for super-resolution)和DRN(dual regression networks)等方法的实验结果进行对比。当放大因子为4时,本文算法的峰值信噪比分别为32.29 dB、28.85 dB、27.61 dB、26.16 dB和30.87 dB;在重建图像的可视化分析方面,本文算法相较于对比算法具有更加丰富的纹理和清晰的轮廓。结论实验结果表明,基于多监督光滑化损失函数方法的图像重建结果与其他超分辨率主流算法相比,在重建图像质量和高频细节处理方面均有所提高。关键词:超分辨率重建;迭代采样;多监督;映射空间;光滑化损失函数121|150|0更新时间:2024-05-07

摘要:目的将低分辨率(low-resolution,LR)图像映射到高分辨率(high-resolution,HR)图像是典型的不适定恢复问题,即输出的HR图像和输入的LR图像之间的映射是多对一的,这意味着仅通过增加网络深度来确定HR图像与LR图像之间的特定映射关系是非常困难的。针对该问题,本文提出一种基于多监督光滑化损失函数的图像超分辨率方法。方法该方法主体由LR图像上采样通道和HR图像下采样通道两部分组成。各通道分为两个阶段,每个阶段均包括浅层特征提取模块、基于迭代采样错误反馈机制的采样模块、全局特征融合模块和图像重建模块。将LR图像上采样通道第1阶段结果与HR图像下采样通道第1阶段结果对比,然后将HR原图像和HR图像下采样通道第2阶段结果作为约束构成多监督,使映射函数空间尽可能精确,并将多监督损失函数光滑化保证梯度在全局范围内传递。结果在基准测试集Set5、Set14、BSD100(Berkeley segmentation dataset)、Urban100(urban scenes dataset)、Manga109(109 manga volumes dataset)数据集上进行测试,并与Bicubic、SRCNN(super-resolution convolutional neural network)、FSRCNN(fast super-resolution convolutional neural network)、LapSRN(Laplacian pyramid super-resolution network)、VDSR(very deep super-resolution convolutional networks)、DBPN(deep back-projection networks for super-resolution)和DRN(dual regression networks)等方法的实验结果进行对比。当放大因子为4时,本文算法的峰值信噪比分别为32.29 dB、28.85 dB、27.61 dB、26.16 dB和30.87 dB;在重建图像的可视化分析方面,本文算法相较于对比算法具有更加丰富的纹理和清晰的轮廓。结论实验结果表明,基于多监督光滑化损失函数方法的图像重建结果与其他超分辨率主流算法相比,在重建图像质量和高频细节处理方面均有所提高。关键词:超分辨率重建;迭代采样;多监督;映射空间;光滑化损失函数121|150|0更新时间:2024-05-07 -

摘要:目的深度学习在视频超分辨率重建领域表现出优异的性能,本文提出了一种轻量级注意力约束的可变形对齐网络,旨在用一个模型参数少的网络重建出逼真的高分辨率视频帧。方法本文网络由特征提取模块、注意力约束对齐子网络和动态融合分支3部分组成。1)共享权重的特征提取模块在不增加参数量的前提下充分提取输入帧的多尺度语义信息。2)将提取到的特征送入注意力约束对齐子网络中生成具有精准匹配关系的对齐特征。3)将拼接好的对齐特征作为共享条件输入动态融合分支,融合前向神经网络中参考帧的时域对齐特征和原始低分辨率(low-resolution,LR)帧在不同阶段的空间特征。4)通过上采样重建高分辨率(high-resolution,HR)帧。结果实验在两个基准测试数据集(Vid4(Vimeo-90k)和REDS4(realistic and diverse scenes dataset))上进行了定量评估,与较先进的视频超分辨率网络相比,本文方法在图像质量指标峰值信噪比(peak signal to noise ratio,PSNR)和结构相似性(structural similarity,SSIM)方面获得了更好的结果,进一步提高了超分辨率的细节特征。本文网络在获得相同的PSNR指标的情况下,模型参数减少了近50%。结论通过极轴约束使得注意力对齐网络模型参数量大大减少,并能够充分捕获远距离信息来进行特征对齐,产生高效的时空特征,还通过设计动态融合机制,实现了高质量的重建结果。关键词:视频超分辨率(VSR);轻量网络;可变形卷积;注意力约束;动态融合机制;残差空洞空间金字塔池化101|202|0更新时间:2024-05-07

摘要:目的深度学习在视频超分辨率重建领域表现出优异的性能,本文提出了一种轻量级注意力约束的可变形对齐网络,旨在用一个模型参数少的网络重建出逼真的高分辨率视频帧。方法本文网络由特征提取模块、注意力约束对齐子网络和动态融合分支3部分组成。1)共享权重的特征提取模块在不增加参数量的前提下充分提取输入帧的多尺度语义信息。2)将提取到的特征送入注意力约束对齐子网络中生成具有精准匹配关系的对齐特征。3)将拼接好的对齐特征作为共享条件输入动态融合分支,融合前向神经网络中参考帧的时域对齐特征和原始低分辨率(low-resolution,LR)帧在不同阶段的空间特征。4)通过上采样重建高分辨率(high-resolution,HR)帧。结果实验在两个基准测试数据集(Vid4(Vimeo-90k)和REDS4(realistic and diverse scenes dataset))上进行了定量评估,与较先进的视频超分辨率网络相比,本文方法在图像质量指标峰值信噪比(peak signal to noise ratio,PSNR)和结构相似性(structural similarity,SSIM)方面获得了更好的结果,进一步提高了超分辨率的细节特征。本文网络在获得相同的PSNR指标的情况下,模型参数减少了近50%。结论通过极轴约束使得注意力对齐网络模型参数量大大减少,并能够充分捕获远距离信息来进行特征对齐,产生高效的时空特征,还通过设计动态融合机制,实现了高质量的重建结果。关键词:视频超分辨率(VSR);轻量网络;可变形卷积;注意力约束;动态融合机制;残差空洞空间金字塔池化101|202|0更新时间:2024-05-07 -

摘要:目的图像修复技术虽然取得了长足进步,但是当图像中缺失区域较大时,非缺失区域提供的信息量非常有限,从而导致难以产生语义信息一致的内容来增强修复图像和真实图像的视觉一致性;同时图像修复常使用两阶段网络结构,基于该结构的模型不仅需要较长的训练时间,还会导致图像修复效果对第1阶段输出结果依赖性较强。针对上述问题,提出了一种基于双解码器的增强语义一致的图像修复方法。方法使用双解码器网络结构消除两阶段修复方法中存在的依赖性问题,同时有效缩短模型的训练时间;利用一致性损失、感知损失和风格损失,更好地捕获图像的上下文语义信息,解决图像修复任务中出现的视觉不一致的问题。此外,本文使用了跳跃连接,并引入多尺度注意力模块和扩张卷积,进一步提高了网络的特征提取能力。结果为了公正地评价,在CelebA、Stanford Cars和UCF Google Street View共3个数据集上对具有规则和不规则缺失区域的图像分别进行实验,采用客观评价指标:均方误差(L2)、峰值信噪比(peak signal-to-noise ratio,PSNR)、结构相似性(structural similarity,SSIM)、FID(Fréchet inception distance)和IS (inception score)进行评价。实验结果表明本文方法修复的图像不仅在视觉上有明显的提升,而且取得了较优的数值。如规则缺失区域下,在CelebA数据集中,本文方法的FID(越小越好)比性能第2的模型在数值上减少了39.2%;在UCF Google Street View数据集中,本文方法的PSNR比其他模型在数值上分别提高了12.64%、6.77%、4.41%。结论本文方法有效减少了模型的训练时间,同时消除了两阶段网络模型中的依赖性问题,修复的图像也呈现出更好的视觉一致性。关键词:图像修复;语义一致;双解码器;跳跃连接;多尺度注意力模块111|251|3更新时间:2024-05-07

摘要:目的图像修复技术虽然取得了长足进步,但是当图像中缺失区域较大时,非缺失区域提供的信息量非常有限,从而导致难以产生语义信息一致的内容来增强修复图像和真实图像的视觉一致性;同时图像修复常使用两阶段网络结构,基于该结构的模型不仅需要较长的训练时间,还会导致图像修复效果对第1阶段输出结果依赖性较强。针对上述问题,提出了一种基于双解码器的增强语义一致的图像修复方法。方法使用双解码器网络结构消除两阶段修复方法中存在的依赖性问题,同时有效缩短模型的训练时间;利用一致性损失、感知损失和风格损失,更好地捕获图像的上下文语义信息,解决图像修复任务中出现的视觉不一致的问题。此外,本文使用了跳跃连接,并引入多尺度注意力模块和扩张卷积,进一步提高了网络的特征提取能力。结果为了公正地评价,在CelebA、Stanford Cars和UCF Google Street View共3个数据集上对具有规则和不规则缺失区域的图像分别进行实验,采用客观评价指标:均方误差(L2)、峰值信噪比(peak signal-to-noise ratio,PSNR)、结构相似性(structural similarity,SSIM)、FID(Fréchet inception distance)和IS (inception score)进行评价。实验结果表明本文方法修复的图像不仅在视觉上有明显的提升,而且取得了较优的数值。如规则缺失区域下,在CelebA数据集中,本文方法的FID(越小越好)比性能第2的模型在数值上减少了39.2%;在UCF Google Street View数据集中,本文方法的PSNR比其他模型在数值上分别提高了12.64%、6.77%、4.41%。结论本文方法有效减少了模型的训练时间,同时消除了两阶段网络模型中的依赖性问题,修复的图像也呈现出更好的视觉一致性。关键词:图像修复;语义一致;双解码器;跳跃连接;多尺度注意力模块111|251|3更新时间:2024-05-07

图像处理和编码

-

摘要:目的可见光和热红外模态数据具有很强的互补性,RGBT(RGB-thermal)跟踪受到越来越多的关注。传统RGBT目标跟踪方法只是将两个模态的特征进行简单融合,跟踪的性能受到一定程度的限制。本文提出了一种基于动态交互和融合的方法,协作学习面向RGBT跟踪的模态特定和互补表示。方法首先,不同模态的特征进行交互生成多模态特征,在每个模态的特定特征学习中使用注意力机制来提升判别性。其次,通过融合不同层次的多模态特征来获得丰富的空间和语义信息,并通过设计一个互补特征学习模块来进行不同模态互补特征的学习。最后,提出一个动态权重损失函数,根据对两个模态特定分支预测结果的一致性和不确定性进行约束以自适应优化整个网络中的参数。结果在两个基准RGBT目标跟踪数据集上进行实验,数据表明,在RGBT234数据集上,本文方法的精确率(precision rate,PR)为79.2%,成功率(success rate,SR)为55.8%;在GTOT(grayscale-thermal object tracking)数据集上,本文方法的精确率为86.1%,成功率为70.9%。同时也在RGBT234和GTOT数据集上进行了对比实验以验证算法的有效性,实验结果表明本文方法改善了RGBT目标跟踪的结果。结论本文提出的RGBT目标跟踪算法,有效挖掘了两个模态之间的互补性,取得了较好的跟踪精度。关键词:模态交互;模态融合;互补特征学习;模态特定信息;RGBT目标跟踪269|180|4更新时间:2024-05-07

摘要:目的可见光和热红外模态数据具有很强的互补性,RGBT(RGB-thermal)跟踪受到越来越多的关注。传统RGBT目标跟踪方法只是将两个模态的特征进行简单融合,跟踪的性能受到一定程度的限制。本文提出了一种基于动态交互和融合的方法,协作学习面向RGBT跟踪的模态特定和互补表示。方法首先,不同模态的特征进行交互生成多模态特征,在每个模态的特定特征学习中使用注意力机制来提升判别性。其次,通过融合不同层次的多模态特征来获得丰富的空间和语义信息,并通过设计一个互补特征学习模块来进行不同模态互补特征的学习。最后,提出一个动态权重损失函数,根据对两个模态特定分支预测结果的一致性和不确定性进行约束以自适应优化整个网络中的参数。结果在两个基准RGBT目标跟踪数据集上进行实验,数据表明,在RGBT234数据集上,本文方法的精确率(precision rate,PR)为79.2%,成功率(success rate,SR)为55.8%;在GTOT(grayscale-thermal object tracking)数据集上,本文方法的精确率为86.1%,成功率为70.9%。同时也在RGBT234和GTOT数据集上进行了对比实验以验证算法的有效性,实验结果表明本文方法改善了RGBT目标跟踪的结果。结论本文提出的RGBT目标跟踪算法,有效挖掘了两个模态之间的互补性,取得了较好的跟踪精度。关键词:模态交互;模态融合;互补特征学习;模态特定信息;RGBT目标跟踪269|180|4更新时间:2024-05-07 -

摘要:目的相比于静态人脸表情图像识别,视频序列中的各帧人脸表情强度差异较大,并且含有中性表情的帧数较多,然而现有模型无法为视频序列中每帧图像分配合适的权重。为了充分利用视频序列中的时空维度信息和不同帧图像对视频表情识别的作用力差异特点,本文提出一种基于Transformer的视频序列表情识别方法。方法首先,将一个视频序列分成含有固定帧数的短视频片段,并采用深度残差网络对视频片段中的每帧图像学习出高层次的人脸表情特征,从而生成一个固定维度的视频片段空间特征。然后,通过设计合适的长短时记忆网络(long short-term memory network,LSTM)和Transformer模型分别从该视频片段空间特征序列中进一步学习出高层次的时间维度特征和注意力特征,并进行级联输入到全连接层,从而输出该视频片段的表情分类分数值。最后,将一个视频所有片段的表情分类分数值进行最大池化,实现该视频的最终表情分类任务。结果在公开的BAUM-1s(Bahcesehir University multimodal)和RML(Ryerson Multimedia Lab)视频情感数据集上的试验结果表明,该方法分别取得了60.72%和75.44%的正确识别率,优于其他对比方法的性能。结论该方法采用端到端的学习方式,能够有效提升视频序列表情识别性能。关键词:视频序列;人脸表情识别;时空维度;深度残差网络;长短时记忆网络(LSTM);端到端;Transformer57|154|3更新时间:2024-05-07

摘要:目的相比于静态人脸表情图像识别,视频序列中的各帧人脸表情强度差异较大,并且含有中性表情的帧数较多,然而现有模型无法为视频序列中每帧图像分配合适的权重。为了充分利用视频序列中的时空维度信息和不同帧图像对视频表情识别的作用力差异特点,本文提出一种基于Transformer的视频序列表情识别方法。方法首先,将一个视频序列分成含有固定帧数的短视频片段,并采用深度残差网络对视频片段中的每帧图像学习出高层次的人脸表情特征,从而生成一个固定维度的视频片段空间特征。然后,通过设计合适的长短时记忆网络(long short-term memory network,LSTM)和Transformer模型分别从该视频片段空间特征序列中进一步学习出高层次的时间维度特征和注意力特征,并进行级联输入到全连接层,从而输出该视频片段的表情分类分数值。最后,将一个视频所有片段的表情分类分数值进行最大池化,实现该视频的最终表情分类任务。结果在公开的BAUM-1s(Bahcesehir University multimodal)和RML(Ryerson Multimedia Lab)视频情感数据集上的试验结果表明,该方法分别取得了60.72%和75.44%的正确识别率,优于其他对比方法的性能。结论该方法采用端到端的学习方式,能够有效提升视频序列表情识别性能。关键词:视频序列;人脸表情识别;时空维度;深度残差网络;长短时记忆网络(LSTM);端到端;Transformer57|154|3更新时间:2024-05-07 -

摘要:目的传统的光伏面板故障检测主要依靠人工巡检,效率低下且误检率很高,而流行的基于机器视觉的智能检测方法又面临缺少大量负样例造成故障检测模型准确性偏低的问题。针对上述问题,本文提出一种基于对抗训练的半监督异常检测模型, 通过应用梯度中心化(gradient centralization,

摘要:目的传统的光伏面板故障检测主要依靠人工巡检,效率低下且误检率很高,而流行的基于机器视觉的智能检测方法又面临缺少大量负样例造成故障检测模型准确性偏低的问题。针对上述问题,本文提出一种基于对抗训练的半监督异常检测模型, 通过应用梯度中心化(gradient centralization,$ {\rm{GC}}$ $ {\rm{Smooth}}\ {\rm{L1}}$ 关键词:异常检测;生成对抗网络(GAN);光伏发电;深度卷积;梯度中心化(GC)117|57|0更新时间:2024-05-07 -

摘要:目的X光图像违禁物品检测一直是安检领域的一个基础问题,安检违禁物品形式各异,尺度变化大,以及透视性导致大量物体堆放时出现重叠遮挡现象,传统图像处理模型很容易出现漏检误检,召回率低。针对以上问题,提出一种融合多尺度特征与全局上下文信息的特征增强融合网络(feature enhancement fusion network, FEFNet)用于X光违禁物品检测。方法首先针对特征主干网络darknet53,加入空间坐标的注意力机制,将位置信息嵌入到通道注意力中,分别沿两个空间方向聚合特征,增强特征提取器对违禁目标的特征提取能力,抑制背景噪声干扰。然后,将特征提取主干网络输出的特征编码为1维向量,利用自监督二阶融合获取特征空间像素相关性矩阵,进而获取完整的全局上下文信息,为视觉遮挡区域提供全局信息指导。针对违禁物品尺度不一的问题,提出多尺度特征金字塔融合模块,增加一层小感受野预测特征用于提高对小尺度违禁目标的检测能力。最后,通过融合全局上下文特征信息和局部多尺度细节特征解决违禁物品之间的视觉遮挡问题。结果在SIXRay-Lite(security inspection X-ray)数据集上进行训练和验证,并与SSD(single shot detection)、Faster R-CNN、RetinaNet、YOLOv5(you only look once)和ACMNet(asymmetrical convolution multi-view neural network)模型进行了对比实验。结果表明,本文模型在SIXray-Lite数据集上的mAP(mean average precision)达到85.64%,特征增强融合模块和多尺度特征金字塔融合模块较原有模型分别提升了6.73%和5.93%,总体检测精度较原有检测网络提升了11.24%。结论提出的特征增强融合检测模型能够更好地提取显著差异特征,降低背景噪声干扰,提高对多尺度以及小型违禁物品的检测能力。同时利用全局上下文特征信息和多尺度局部特征相结合,有效地缓解了违禁物品之间的视觉遮挡现象,在保证实时性的同时有效地提高了模型的整体检测精度。关键词:违禁品检测;X光图像;特征增强融合;注意力机制;多尺度融合;全局上下文信息98|311|5更新时间:2024-05-07

摘要:目的X光图像违禁物品检测一直是安检领域的一个基础问题,安检违禁物品形式各异,尺度变化大,以及透视性导致大量物体堆放时出现重叠遮挡现象,传统图像处理模型很容易出现漏检误检,召回率低。针对以上问题,提出一种融合多尺度特征与全局上下文信息的特征增强融合网络(feature enhancement fusion network, FEFNet)用于X光违禁物品检测。方法首先针对特征主干网络darknet53,加入空间坐标的注意力机制,将位置信息嵌入到通道注意力中,分别沿两个空间方向聚合特征,增强特征提取器对违禁目标的特征提取能力,抑制背景噪声干扰。然后,将特征提取主干网络输出的特征编码为1维向量,利用自监督二阶融合获取特征空间像素相关性矩阵,进而获取完整的全局上下文信息,为视觉遮挡区域提供全局信息指导。针对违禁物品尺度不一的问题,提出多尺度特征金字塔融合模块,增加一层小感受野预测特征用于提高对小尺度违禁目标的检测能力。最后,通过融合全局上下文特征信息和局部多尺度细节特征解决违禁物品之间的视觉遮挡问题。结果在SIXRay-Lite(security inspection X-ray)数据集上进行训练和验证,并与SSD(single shot detection)、Faster R-CNN、RetinaNet、YOLOv5(you only look once)和ACMNet(asymmetrical convolution multi-view neural network)模型进行了对比实验。结果表明,本文模型在SIXray-Lite数据集上的mAP(mean average precision)达到85.64%,特征增强融合模块和多尺度特征金字塔融合模块较原有模型分别提升了6.73%和5.93%,总体检测精度较原有检测网络提升了11.24%。结论提出的特征增强融合检测模型能够更好地提取显著差异特征,降低背景噪声干扰,提高对多尺度以及小型违禁物品的检测能力。同时利用全局上下文特征信息和多尺度局部特征相结合,有效地缓解了违禁物品之间的视觉遮挡现象,在保证实时性的同时有效地提高了模型的整体检测精度。关键词:违禁品检测;X光图像;特征增强融合;注意力机制;多尺度融合;全局上下文信息98|311|5更新时间:2024-05-07 -

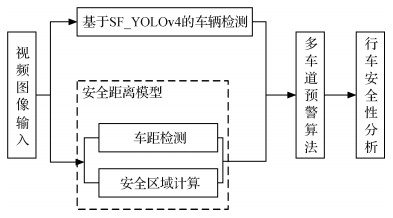

摘要:目的基于视觉的车辆行驶安全性预警分析技术是目前车辆辅助驾驶的一个重要研究方向,对前方多车道快速行驶的车辆进行精准的跟踪定位并建立稳定可靠的安全距离预警模型是当前研究难点。为此,提出面向高速公路场景的车路视觉协同行车安全预警算法。方法首先提出一种深度卷积神经网络SF_YOLOv4(single feature you look only once v4)对前方车辆进行精准的检测跟踪;然后提出一种安全距离模型对车辆刹车距离进行计算,并根据单目视觉原理计算车辆间距离;最后提出多车道预警模型对自车行驶过程的安全性进行分析,并对司机给予相应安全提示。结果实验结果表明,提出的SF_YOLOv4算法对车辆检测的准确率为93.55%,检测速度(25帧/s)领先对比算法,有效降低了算法的时间和空间复杂度;提出的安全距离模型计算的不同类型车辆的刹车距离误差小于0.1 m,与交通法建议的距离相比,本文方法计算的安全距离精确度明显提升;提出的多车道安全预警模型与马自达6(ATENZA)自带的前方碰撞系统相比,能对相邻车道车辆进行预警,并提前0.7 s对前方变道车辆发出预警。结论提出的多车道预警模型充分考虑高速公路上相邻车道中的车辆位置变化发生的碰撞事故;本文方法与传统方法相比,具有较高实用性,其预警效果更加客观,预警范围更广,可以有效提高高速公路上的行车安全。关键词:安全性分析;防碰撞预警;车辆目标检测;安全距离模型;YOLOv4;车距计算96|217|1更新时间:2024-05-07

摘要:目的基于视觉的车辆行驶安全性预警分析技术是目前车辆辅助驾驶的一个重要研究方向,对前方多车道快速行驶的车辆进行精准的跟踪定位并建立稳定可靠的安全距离预警模型是当前研究难点。为此,提出面向高速公路场景的车路视觉协同行车安全预警算法。方法首先提出一种深度卷积神经网络SF_YOLOv4(single feature you look only once v4)对前方车辆进行精准的检测跟踪;然后提出一种安全距离模型对车辆刹车距离进行计算,并根据单目视觉原理计算车辆间距离;最后提出多车道预警模型对自车行驶过程的安全性进行分析,并对司机给予相应安全提示。结果实验结果表明,提出的SF_YOLOv4算法对车辆检测的准确率为93.55%,检测速度(25帧/s)领先对比算法,有效降低了算法的时间和空间复杂度;提出的安全距离模型计算的不同类型车辆的刹车距离误差小于0.1 m,与交通法建议的距离相比,本文方法计算的安全距离精确度明显提升;提出的多车道安全预警模型与马自达6(ATENZA)自带的前方碰撞系统相比,能对相邻车道车辆进行预警,并提前0.7 s对前方变道车辆发出预警。结论提出的多车道预警模型充分考虑高速公路上相邻车道中的车辆位置变化发生的碰撞事故;本文方法与传统方法相比,具有较高实用性,其预警效果更加客观,预警范围更广,可以有效提高高速公路上的行车安全。关键词:安全性分析;防碰撞预警;车辆目标检测;安全距离模型;YOLOv4;车距计算96|217|1更新时间:2024-05-07 -

摘要:目的人体尺寸测量是服装制作中的一个重要环节。非接触式人体测量具有效率高、方便快捷的优点,但存在测量精准度较低、对设备和外界环境要求高等问题。为进一步改进这些问题,本文基于卷积神经网络建立模型,相继提出人体分割和关键点检测的方法、基于Bezier曲线的人体肩宽测量方法和基于双椭圆拟合的人体围度测量方法。方法通过摄像头获取人体的正面、侧面及背面图像;利用Deeplabv3+算法对人体图像进行分割获得人体轮廓,利用OpenPose算法对人体关键点进行检测及定位,利用肩部端点处的角度特征并结合人体肩部关节点信息确定肩部端点,利用肩部曲线与Bezier曲线的相似性通过计算肩部Bezier曲线的长度得到肩宽,通过关键点信息确定胸围、腰围及臀围的宽度和厚度,并建立围度曲线的双椭圆拟合模型,采用线性回归法训练得到拟合模型中的参数,最后利用双椭圆拟合曲线的周长得到人体围度。结果根据本文方法对100位被测者进行肩宽计算,对132位被测者进行人体围度计算,平均绝对误差均在3 cm以内,符合国家测量标准,且整套方法操作方便,结果稳定。结论实验验证了本文方法在人体尺寸测量中的精度,降低了非接触式人体测量法对外界环境和设备的依赖程度,提高了系统的鲁棒性,为非接触式人体测量走向实用化打下了坚实基础。关键词:OpenPose;Deeplabv3+;Bezier曲线;曲线拟合;人体测量64|48|2更新时间:2024-05-07

摘要:目的人体尺寸测量是服装制作中的一个重要环节。非接触式人体测量具有效率高、方便快捷的优点,但存在测量精准度较低、对设备和外界环境要求高等问题。为进一步改进这些问题,本文基于卷积神经网络建立模型,相继提出人体分割和关键点检测的方法、基于Bezier曲线的人体肩宽测量方法和基于双椭圆拟合的人体围度测量方法。方法通过摄像头获取人体的正面、侧面及背面图像;利用Deeplabv3+算法对人体图像进行分割获得人体轮廓,利用OpenPose算法对人体关键点进行检测及定位,利用肩部端点处的角度特征并结合人体肩部关节点信息确定肩部端点,利用肩部曲线与Bezier曲线的相似性通过计算肩部Bezier曲线的长度得到肩宽,通过关键点信息确定胸围、腰围及臀围的宽度和厚度,并建立围度曲线的双椭圆拟合模型,采用线性回归法训练得到拟合模型中的参数,最后利用双椭圆拟合曲线的周长得到人体围度。结果根据本文方法对100位被测者进行肩宽计算,对132位被测者进行人体围度计算,平均绝对误差均在3 cm以内,符合国家测量标准,且整套方法操作方便,结果稳定。结论实验验证了本文方法在人体尺寸测量中的精度,降低了非接触式人体测量法对外界环境和设备的依赖程度,提高了系统的鲁棒性,为非接触式人体测量走向实用化打下了坚实基础。关键词:OpenPose;Deeplabv3+;Bezier曲线;曲线拟合;人体测量64|48|2更新时间:2024-05-07

图像分析和识别

-

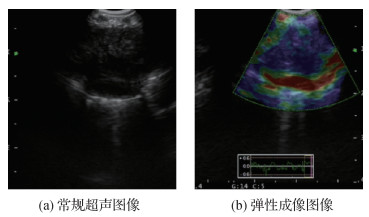

摘要:目的超声弹性成像技术已逐步应用于支气管淋巴结良恶性的诊断,帮助确定肺癌分期。在支气管超声弹性图像中,淋巴结区域的精确定位对诊断准确度具有重要影响,但通常依赖专业医师的手动分割,费时费力。为此,本文设计了一种注意力上下文编码器网络(attention context encoder network,ACE-Net)。方法本文网络模型包括编码器、上下文提取器和解码器3部分。使用在ImageNet数据集上预训练且去掉平均池化层和全连接层的34层残差网络ResNet-34作为编码器提取特征,上下文提取器从编码器的输出中进一步提取高级语义信息,同时保留尽可能多的空间信息,基于AG(attention gate)的解码器可以抑制输入图像中的不相关区域,同时突出对当前任务更关键的特征。结果实验在本文收集的包含支气管超声弹性图像及对应分割标签的数据集上进行,与6种典型的U-Net结构深度网络模型的分割性能进行对比,数据集中的每幅图像中的淋巴结都由专业医师手动分割标注。基础U-Net网络得到淋巴结分割结果的Dice系数、敏感度和特异度分别为0.820 7、85.08%和96.82%,其他改进网络的分割性能在此基础上均有一定提高,本文方法的Dice系数、敏感度和特异度分别为0.845 1、87.92%和97.04%,Dice系数和敏感度在所有方法中取得了最优值,特异度取得了次优值。结论以U-Net为代表的深度学习模型在支气管超声弹性图像淋巴结分割问题中具有很大潜力,将上下文提取器和注意力机制融入U-Net网络可以一定程度提升分割精度。本文收集的数据集将有助于推动支气管超声弹性图像淋巴结分割问题的研究。关键词:超声弹性成像;淋巴结分割;深度学习;U-Net;上下文提取器;注意力机制103|462|5更新时间:2024-05-07

摘要:目的超声弹性成像技术已逐步应用于支气管淋巴结良恶性的诊断,帮助确定肺癌分期。在支气管超声弹性图像中,淋巴结区域的精确定位对诊断准确度具有重要影响,但通常依赖专业医师的手动分割,费时费力。为此,本文设计了一种注意力上下文编码器网络(attention context encoder network,ACE-Net)。方法本文网络模型包括编码器、上下文提取器和解码器3部分。使用在ImageNet数据集上预训练且去掉平均池化层和全连接层的34层残差网络ResNet-34作为编码器提取特征,上下文提取器从编码器的输出中进一步提取高级语义信息,同时保留尽可能多的空间信息,基于AG(attention gate)的解码器可以抑制输入图像中的不相关区域,同时突出对当前任务更关键的特征。结果实验在本文收集的包含支气管超声弹性图像及对应分割标签的数据集上进行,与6种典型的U-Net结构深度网络模型的分割性能进行对比,数据集中的每幅图像中的淋巴结都由专业医师手动分割标注。基础U-Net网络得到淋巴结分割结果的Dice系数、敏感度和特异度分别为0.820 7、85.08%和96.82%,其他改进网络的分割性能在此基础上均有一定提高,本文方法的Dice系数、敏感度和特异度分别为0.845 1、87.92%和97.04%,Dice系数和敏感度在所有方法中取得了最优值,特异度取得了次优值。结论以U-Net为代表的深度学习模型在支气管超声弹性图像淋巴结分割问题中具有很大潜力,将上下文提取器和注意力机制融入U-Net网络可以一定程度提升分割精度。本文收集的数据集将有助于推动支气管超声弹性图像淋巴结分割问题的研究。关键词:超声弹性成像;淋巴结分割;深度学习;U-Net;上下文提取器;注意力机制103|462|5更新时间:2024-05-07

医学图像处理

-

摘要:目的海洋中尺度涡自动检测是了解其演变规律,研究其在海洋物质运输和能量传递中的作用的基础。针对海洋中尺度涡形态不规则、结构复杂多变、长宽比不确定,以及涡群海域中尺度涡分布密集导致的检测精度低的问题,提出一种基于深度学习多尺度旋转锚机制的海洋中尺度涡自动旋转检测方法。方法首先对卫星遥感海平面高度异常数据进行可视化预处理,并采用图像处理策略对数据集进行扩充构建训练集;其次构建了一种基于深度学习多尺度旋转锚机制的中尺度涡自动检测模型,考虑到中尺度涡尺度变化大和其所处海洋环境复杂多变的特点,主干网络采用RetinaNet提取中尺度涡特征,同时采用特征金字塔结构融合中尺度涡的低层与高层特征,设计多尺度、多长宽比以及多旋转角度锚点机制实现多尺度旋转检测锚的生成;最后集成分类与回归两个子网络,实现海洋中尺度涡的自动旋转检测。结果实验结果表明,提出的中尺度涡自动检测方法极大改进了水平检测框存在显著的大纵横比导致检测精度低和检测框嵌套和重叠现象。本文方法最优检测精度为90.22%,与水平检测方法相比,精度提升了8%。在印度洋、太平洋、大西洋和赤道海域进行了海洋中尺度涡的旋转检测实证分析,验证了模型具有很好的泛化能力。结论本文通过设计多尺度、多长宽比和多旋转角度实现多尺度旋转锚的生成机制,达到中尺度涡目标旋转检测,有效克服了水平检测框区域冗余和检测框重叠、嵌套现象,显著提升了中尺度涡检测精度。关键词:目标旋转检测;海洋中尺度涡;海平面异常;深度学习;多尺度旋转锚78|339|2更新时间:2024-05-07

摘要:目的海洋中尺度涡自动检测是了解其演变规律,研究其在海洋物质运输和能量传递中的作用的基础。针对海洋中尺度涡形态不规则、结构复杂多变、长宽比不确定,以及涡群海域中尺度涡分布密集导致的检测精度低的问题,提出一种基于深度学习多尺度旋转锚机制的海洋中尺度涡自动旋转检测方法。方法首先对卫星遥感海平面高度异常数据进行可视化预处理,并采用图像处理策略对数据集进行扩充构建训练集;其次构建了一种基于深度学习多尺度旋转锚机制的中尺度涡自动检测模型,考虑到中尺度涡尺度变化大和其所处海洋环境复杂多变的特点,主干网络采用RetinaNet提取中尺度涡特征,同时采用特征金字塔结构融合中尺度涡的低层与高层特征,设计多尺度、多长宽比以及多旋转角度锚点机制实现多尺度旋转检测锚的生成;最后集成分类与回归两个子网络,实现海洋中尺度涡的自动旋转检测。结果实验结果表明,提出的中尺度涡自动检测方法极大改进了水平检测框存在显著的大纵横比导致检测精度低和检测框嵌套和重叠现象。本文方法最优检测精度为90.22%,与水平检测方法相比,精度提升了8%。在印度洋、太平洋、大西洋和赤道海域进行了海洋中尺度涡的旋转检测实证分析,验证了模型具有很好的泛化能力。结论本文通过设计多尺度、多长宽比和多旋转角度实现多尺度旋转锚的生成机制,达到中尺度涡目标旋转检测,有效克服了水平检测框区域冗余和检测框重叠、嵌套现象,显著提升了中尺度涡检测精度。关键词:目标旋转检测;海洋中尺度涡;海平面异常;深度学习;多尺度旋转锚78|339|2更新时间:2024-05-07 -

摘要:目的为解决当前遥感影像道路提取方法普遍存在的自动化程度低、提取精度不高和由于样本数量不平衡导致的模型训练不稳定等问题,本文提出一种集成注意力机制和扩张卷积的道路提取模型(attention and dilated convolutional U-Net,A & D-UNet)。方法A & D-UNet聚合网络模型以经典U-Net网络结构为基础,在编码部分引入残差学习单元(residual learning unit,RLU),降低深度卷积神经网络在训练时的复杂度;应用卷积注意力模块(convolutional block attention module,CBAM)从通道和空间维度两个方面优化分配权重,突出道路特征信息;并使用扩张卷积单元(dilated convolutional unit,DCU)感受更大范围的特征区域,整合道路的上下文信息。采用二进制交叉熵(binary cross entropy,BCE)和Dice相结合的复合损失函数训练模型,减轻遥感影像中样本数量不平衡导致的模型不稳定。结果在公开的美国马萨诸塞州和Deep Globe道路数据集上进行模型验证实验,并与传统的U-Net、LinkNet和D-LinkNet图像分割模型对比分析。在美国马萨诸塞州道路测试集上,本文构建的A & D-UNet模型的总体精度、F1分数和交并比等评价指标分别为95.27%、77.96%和79.89%,均优于对比算法,在测试集中对线性特征明显、标签遗漏标记以及存在树木遮挡的道路区域具有更好的识别效果;在Deep Globe道路测试集上,A & D-UNet模型的总体精度、F1分数和交并比分别为94.01%、77.06%和78.44%,且对线性特征明显的主干道路、标签未标记的狭窄道路以及阴影遮挡的城市道路都具有较好的提取效果。结论本文提出的A & D-UNet道路提取模型,综合了残差学习、注意力机制和扩张卷积的优点,有效提升了目标分割的性能,是一种提取效果较好、值得推广的聚合网络模型。关键词:道路信息;残差学习单元(RLU);卷积注意力模块(CBAM);扩张卷积单元(DCU);损失函数139|742|6更新时间:2024-05-07

摘要:目的为解决当前遥感影像道路提取方法普遍存在的自动化程度低、提取精度不高和由于样本数量不平衡导致的模型训练不稳定等问题,本文提出一种集成注意力机制和扩张卷积的道路提取模型(attention and dilated convolutional U-Net,A & D-UNet)。方法A & D-UNet聚合网络模型以经典U-Net网络结构为基础,在编码部分引入残差学习单元(residual learning unit,RLU),降低深度卷积神经网络在训练时的复杂度;应用卷积注意力模块(convolutional block attention module,CBAM)从通道和空间维度两个方面优化分配权重,突出道路特征信息;并使用扩张卷积单元(dilated convolutional unit,DCU)感受更大范围的特征区域,整合道路的上下文信息。采用二进制交叉熵(binary cross entropy,BCE)和Dice相结合的复合损失函数训练模型,减轻遥感影像中样本数量不平衡导致的模型不稳定。结果在公开的美国马萨诸塞州和Deep Globe道路数据集上进行模型验证实验,并与传统的U-Net、LinkNet和D-LinkNet图像分割模型对比分析。在美国马萨诸塞州道路测试集上,本文构建的A & D-UNet模型的总体精度、F1分数和交并比等评价指标分别为95.27%、77.96%和79.89%,均优于对比算法,在测试集中对线性特征明显、标签遗漏标记以及存在树木遮挡的道路区域具有更好的识别效果;在Deep Globe道路测试集上,A & D-UNet模型的总体精度、F1分数和交并比分别为94.01%、77.06%和78.44%,且对线性特征明显的主干道路、标签未标记的狭窄道路以及阴影遮挡的城市道路都具有较好的提取效果。结论本文提出的A & D-UNet道路提取模型,综合了残差学习、注意力机制和扩张卷积的优点,有效提升了目标分割的性能,是一种提取效果较好、值得推广的聚合网络模型。关键词:道路信息;残差学习单元(RLU);卷积注意力模块(CBAM);扩张卷积单元(DCU);损失函数139|742|6更新时间:2024-05-07 -

摘要:目的自编码器作为一种无监督的特征提取算法,可以在无标签的条件下学习到样本的高阶、稠密特征。然而当训练集含噪声或异常时,会迫使自编码器学习这些异常样本的特征,导致性能下降。同时,自编码器应用于高光谱图像处理时,往往会忽略掉空域信息,进一步限制了自编码器的探测性能。针对上述问题,本文提出一种基于空域协同自编码器的高光谱异常检测算法。方法利用块图模型优良的背景抑制能力从空域角度筛选用于自编码器训练的背景样本集。自编码器采用经预筛选的训练样本集进行网络参数更新,在提升对背景样本表达能力的同时避免异常样本对探测性能的影响。为进一步将空域信息融入探测结果,利用块图模型得到的异常响应构建权重,起到突出目标并抑制背景的作用。结果实验在3组不同尺寸的高光谱数据集上与5种代表性的高光谱异常检测算法进行比较。本文方法在3组数据集上的AUC(area under the curve)值分别为0.990 4、0.988 8和0.997 0,均高于其他算法。同时,对比了不同的训练集选择策略,与随机选取和使用全部样本进行对比。结果表明,本文基于空域响应的样本筛选方法相较对比方法具有较明显的优势。结论提出的基于空域协同自编码器的高光谱异常检测算法从空域角度筛选样本以提升自编码器区分异常与背景的能力,同时融合了光谱域和空域信息,进一步提升了异常检测性能。关键词:高光谱图像(HSI);异常检测;块图模型;自编码器(AE);空谱特征融合206|183|0更新时间:2024-05-07

摘要:目的自编码器作为一种无监督的特征提取算法,可以在无标签的条件下学习到样本的高阶、稠密特征。然而当训练集含噪声或异常时,会迫使自编码器学习这些异常样本的特征,导致性能下降。同时,自编码器应用于高光谱图像处理时,往往会忽略掉空域信息,进一步限制了自编码器的探测性能。针对上述问题,本文提出一种基于空域协同自编码器的高光谱异常检测算法。方法利用块图模型优良的背景抑制能力从空域角度筛选用于自编码器训练的背景样本集。自编码器采用经预筛选的训练样本集进行网络参数更新,在提升对背景样本表达能力的同时避免异常样本对探测性能的影响。为进一步将空域信息融入探测结果,利用块图模型得到的异常响应构建权重,起到突出目标并抑制背景的作用。结果实验在3组不同尺寸的高光谱数据集上与5种代表性的高光谱异常检测算法进行比较。本文方法在3组数据集上的AUC(area under the curve)值分别为0.990 4、0.988 8和0.997 0,均高于其他算法。同时,对比了不同的训练集选择策略,与随机选取和使用全部样本进行对比。结果表明,本文基于空域响应的样本筛选方法相较对比方法具有较明显的优势。结论提出的基于空域协同自编码器的高光谱异常检测算法从空域角度筛选样本以提升自编码器区分异常与背景的能力,同时融合了光谱域和空域信息,进一步提升了异常检测性能。关键词:高光谱图像(HSI);异常检测;块图模型;自编码器(AE);空谱特征融合206|183|0更新时间:2024-05-07 -

摘要:目的合成孔径雷达(synthetic aperture radar, SAR)图像舰船目标检测在军事、民生领域发挥重要作用。由于SAR图像背景复杂且多为小尺度舰船目标,同时图像中的相干斑噪声导致舰船目标边缘模糊,现阶段目标检测模型无法快速高效地实现目标检测任务。为了提高模型检测精度,使模型具有更好的鲁棒性,提出了自适应权重金字塔和分支强相关的SAR图像检测模型。方法对特征提取网络提取的特征图经过采样、融合处理获得特征自适应权重,然后利用权重指导每层特征图充分融合空间位置信息和语义信息,更好地检测小尺度目标;分支强相关模块融合分类分支和回归分支的特征,对融合后的待检测特征分别采用1×1、3×3对称卷积核和1×3、3×1非对称卷积核捕获不同的舰船特征;构建IoU(intersection over union)分支,利用IoU分支作用于分类分支,避免高IoU低分类置信度的候选框被抑制,通过设置平衡因子平衡IoU分支和分类分支,使其能更好地指导回归分支优化候选框。结果在公开的遥感数据集SSDD(SAR ship detection dataset)上实验结果表明,本文模型的检测精度达到90.53%,F1值提升至94.35%,检测速度达到20.14帧/s。与其他SAR图像舰船目标检测算法相比有较好的检测效果。结论实验结果表明该模型相比原始模型具有更好的检测效果,满足实时性检测需求,在SAR图像实时检测中具有实际意义。关键词:目标检测;合成孔径雷达(SAR);自适应权重;分支相关;平衡因子95|358|2更新时间:2024-05-07

摘要:目的合成孔径雷达(synthetic aperture radar, SAR)图像舰船目标检测在军事、民生领域发挥重要作用。由于SAR图像背景复杂且多为小尺度舰船目标,同时图像中的相干斑噪声导致舰船目标边缘模糊,现阶段目标检测模型无法快速高效地实现目标检测任务。为了提高模型检测精度,使模型具有更好的鲁棒性,提出了自适应权重金字塔和分支强相关的SAR图像检测模型。方法对特征提取网络提取的特征图经过采样、融合处理获得特征自适应权重,然后利用权重指导每层特征图充分融合空间位置信息和语义信息,更好地检测小尺度目标;分支强相关模块融合分类分支和回归分支的特征,对融合后的待检测特征分别采用1×1、3×3对称卷积核和1×3、3×1非对称卷积核捕获不同的舰船特征;构建IoU(intersection over union)分支,利用IoU分支作用于分类分支,避免高IoU低分类置信度的候选框被抑制,通过设置平衡因子平衡IoU分支和分类分支,使其能更好地指导回归分支优化候选框。结果在公开的遥感数据集SSDD(SAR ship detection dataset)上实验结果表明,本文模型的检测精度达到90.53%,F1值提升至94.35%,检测速度达到20.14帧/s。与其他SAR图像舰船目标检测算法相比有较好的检测效果。结论实验结果表明该模型相比原始模型具有更好的检测效果,满足实时性检测需求,在SAR图像实时检测中具有实际意义。关键词:目标检测;合成孔径雷达(SAR);自适应权重;分支相关;平衡因子95|358|2更新时间:2024-05-07

遥感图像处理

0