最新刊期

2021 年 第 26 卷 第 4 期

-

摘要:图像标题生成与描述的任务是通过计算机将图像自动翻译成自然语言的形式重新表达出来,该研究在人类视觉辅助、智能人机环境开发等领域具有广阔的应用前景,同时也为图像检索、高层视觉语义推理和个性化描述等任务的研究提供支撑。图像数据具有高度非线性和繁杂性,而人类自然语言较为抽象且逻辑严谨,因此让计算机自动地对图像内容进行抽象和总结,具有很大的挑战性。本文对图像简单标题生成与描述任务进行了阐述,分析了基于手工特征的图像简单描述生成方法,并对包括基于全局视觉特征、视觉特征选择与优化以及面向优化策略等基于深度特征的图像简单描述生成方法进行了梳理与总结。针对图像的精细化描述任务,分析了当前主要的图像“密集描述”与结构化描述模型与方法。此外,本文还分析了融合情感信息与个性化表达的图像描述方法。在分析与总结的过程中,指出了当前各类图像标题生成与描述方法存在的不足,提出了下一步可能的研究趋势与解决思路。对该领域常用的MS COCO 2014(Microsoft common objects in context)、Flickr30K等数据集进行了详细介绍,对图像简单描述、图像密集描述与段落描述和图像情感描述等代表性模型在数据集上的性能进行了对比分析。由于视觉数据的复杂性与自然语言的抽象性,尤其是融合情感与个性化表达的图像描述任务,在相关特征提取与表征、语义词汇的选择与嵌入、数据集构建及描述评价等方面尚存在大量问题亟待解决。关键词:图像标题生成;深度特征;视觉描述;语段生成;图像情感;逻辑语义125|296|2更新时间:2024-05-07

摘要:图像标题生成与描述的任务是通过计算机将图像自动翻译成自然语言的形式重新表达出来,该研究在人类视觉辅助、智能人机环境开发等领域具有广阔的应用前景,同时也为图像检索、高层视觉语义推理和个性化描述等任务的研究提供支撑。图像数据具有高度非线性和繁杂性,而人类自然语言较为抽象且逻辑严谨,因此让计算机自动地对图像内容进行抽象和总结,具有很大的挑战性。本文对图像简单标题生成与描述任务进行了阐述,分析了基于手工特征的图像简单描述生成方法,并对包括基于全局视觉特征、视觉特征选择与优化以及面向优化策略等基于深度特征的图像简单描述生成方法进行了梳理与总结。针对图像的精细化描述任务,分析了当前主要的图像“密集描述”与结构化描述模型与方法。此外,本文还分析了融合情感信息与个性化表达的图像描述方法。在分析与总结的过程中,指出了当前各类图像标题生成与描述方法存在的不足,提出了下一步可能的研究趋势与解决思路。对该领域常用的MS COCO 2014(Microsoft common objects in context)、Flickr30K等数据集进行了详细介绍,对图像简单描述、图像密集描述与段落描述和图像情感描述等代表性模型在数据集上的性能进行了对比分析。由于视觉数据的复杂性与自然语言的抽象性,尤其是融合情感与个性化表达的图像描述任务,在相关特征提取与表征、语义词汇的选择与嵌入、数据集构建及描述评价等方面尚存在大量问题亟待解决。关键词:图像标题生成;深度特征;视觉描述;语段生成;图像情感;逻辑语义125|296|2更新时间:2024-05-07 -

摘要:准确分割肺结节在临床上具有重要意义。计算机断层扫描(computer tomography,CT)技术以其成像速度快、图像分辨率高等优点广泛应用于肺结节分割及功能评价中。为了进一步对肺部CT影像中的肺结节分割方法进行探索,本文对基于CT影像的肺结节分割方法研究进行综述。1)对传统的肺结节分割方法及其优缺点进行了归纳比较;2)重点介绍了包括深度学习、深度学习与传统方法相结合在内的肺结节分割方法;3)简单介绍了肺结节分割方法的常用评价指标,并结合部分方法的指标表现展望了肺结节分割方法研究领域的未来发展趋势。传统的肺结节分割方法各有优缺点和其适用的结节类型,深度学习分割方法因普适性好等优点成为该领域的研究热点。研究者们致力于如何提高分割结果的准确度、模型的鲁棒性及方法的普适性,为了实现此目的本文总结了各类方法的优缺点。基于CT影像的肺结节分割方法研究已经取得了不小的成就,但肺结节形状各异、密度不均匀,且部分结节与血管、胸膜等解剖结构粘连,给结节分割增加了困难,结节分割效果仍有很大提升空间。精度高、速度快的深度学习分割方法将会是研究者密切关注的方法,但该类方法仍需解决数据需求量大和网络模型超参数的确定等问题。关键词:肺结节;CT影像;肺结节分割方法;深度学习;综述422|124|4更新时间:2024-05-07

摘要:准确分割肺结节在临床上具有重要意义。计算机断层扫描(computer tomography,CT)技术以其成像速度快、图像分辨率高等优点广泛应用于肺结节分割及功能评价中。为了进一步对肺部CT影像中的肺结节分割方法进行探索,本文对基于CT影像的肺结节分割方法研究进行综述。1)对传统的肺结节分割方法及其优缺点进行了归纳比较;2)重点介绍了包括深度学习、深度学习与传统方法相结合在内的肺结节分割方法;3)简单介绍了肺结节分割方法的常用评价指标,并结合部分方法的指标表现展望了肺结节分割方法研究领域的未来发展趋势。传统的肺结节分割方法各有优缺点和其适用的结节类型,深度学习分割方法因普适性好等优点成为该领域的研究热点。研究者们致力于如何提高分割结果的准确度、模型的鲁棒性及方法的普适性,为了实现此目的本文总结了各类方法的优缺点。基于CT影像的肺结节分割方法研究已经取得了不小的成就,但肺结节形状各异、密度不均匀,且部分结节与血管、胸膜等解剖结构粘连,给结节分割增加了困难,结节分割效果仍有很大提升空间。精度高、速度快的深度学习分割方法将会是研究者密切关注的方法,但该类方法仍需解决数据需求量大和网络模型超参数的确定等问题。关键词:肺结节;CT影像;肺结节分割方法;深度学习;综述422|124|4更新时间:2024-05-07

综述

-

摘要:目的随着深度卷积神经网络的兴起,图像超分重建算法在精度与速度方面均取得长足进展。然而,目前多数超分重建方法需要较深的网络才能取得良好性能,不仅训练难度大,而且到网络末端浅层特征信息容易丢失,难以充分捕获对超分重建起关键作用的高频细节信息。为此,本文融合多尺度特征充分挖掘超分重建所需的高频细节信息,提出了一种全局注意力门控残差记忆网络。方法在网络前端特征提取部分,利用单层卷积提取浅层特征信息。在网络主体非线性映射部分,级联一组递归的残差记忆模块,每个模块融合多个递归的多尺度残差单元和一个全局注意力门控模块来输出具备多层级信息的特征表征。在网络末端,并联多尺度特征并通过像素重组机制实现高质量的图像放大。结果本文分别在图像超分重建的5个基准测试数据集(Set5、Set14、B100、Urban100和Manga109)上进行评估,在评估指标峰值信噪比(peak signal to noise ratio,PSNR)和结构相似性(structural similarity,SSIM)上相比当前先进的网络模型均获得更优性能,尤其在Manga109测试数据集上本文算法取得的PSNR结果达到39.19 dB,相比当前先进的轻量型算法AWSRN(adaptive weighted super-resolution network)提高0.32 dB。结论本文网络模型在对低分图像进行超分重建时,能够联合学习网络多层级、多尺度特征,充分挖掘图像高频信息,获得高质量的重建结果。关键词:单幅图像超分辨率(SISR);深度卷积神经网络(DCNN);注意力门控机制;多尺度残差单元(MRUs);递归学习26|42|2更新时间:2024-05-07

摘要:目的随着深度卷积神经网络的兴起,图像超分重建算法在精度与速度方面均取得长足进展。然而,目前多数超分重建方法需要较深的网络才能取得良好性能,不仅训练难度大,而且到网络末端浅层特征信息容易丢失,难以充分捕获对超分重建起关键作用的高频细节信息。为此,本文融合多尺度特征充分挖掘超分重建所需的高频细节信息,提出了一种全局注意力门控残差记忆网络。方法在网络前端特征提取部分,利用单层卷积提取浅层特征信息。在网络主体非线性映射部分,级联一组递归的残差记忆模块,每个模块融合多个递归的多尺度残差单元和一个全局注意力门控模块来输出具备多层级信息的特征表征。在网络末端,并联多尺度特征并通过像素重组机制实现高质量的图像放大。结果本文分别在图像超分重建的5个基准测试数据集(Set5、Set14、B100、Urban100和Manga109)上进行评估,在评估指标峰值信噪比(peak signal to noise ratio,PSNR)和结构相似性(structural similarity,SSIM)上相比当前先进的网络模型均获得更优性能,尤其在Manga109测试数据集上本文算法取得的PSNR结果达到39.19 dB,相比当前先进的轻量型算法AWSRN(adaptive weighted super-resolution network)提高0.32 dB。结论本文网络模型在对低分图像进行超分重建时,能够联合学习网络多层级、多尺度特征,充分挖掘图像高频信息,获得高质量的重建结果。关键词:单幅图像超分辨率(SISR);深度卷积神经网络(DCNN);注意力门控机制;多尺度残差单元(MRUs);递归学习26|42|2更新时间:2024-05-07 -

摘要:目的单幅图像超分辨率重建的深度学习算法中,大多数网络都采用了单一尺度的卷积核来提取特征(如3×3的卷积核),往往忽略了不同卷积核尺寸带来的不同大小感受域的问题,而不同大小的感受域会使网络注意到不同程度的特征,因此只采用单一尺度的卷积核会使网络忽略了不同特征图之间的宏观联系。针对上述问题,本文提出了多层次感知残差卷积网络(multi-level perception residual convolutional network,MLP-Net,用于单幅图像超分辨率重建)。方法通过特征提取模块提取图像低频特征作为输入。输入部分由密集连接的多个多层次感知模块组成,其中多层次感知模块分为浅层多层次特征提取和深层多层次特征提取,以确保网络既能注意到图像的低级特征,又能注意到高级特征,同时也能保证特征之间的宏观联系。结果实验结果采用客观评价的峰值信噪比(peak signal to noise ratio,PSNR)和结构相似性(structural similarity,SSIM)两个指标,将本文算法其他超分辨率算法进行了对比。最终结果表明本文算法在4个基准测试集上(Set5、Set14、Urban100和BSD100(Berkeley Segmentation Dataset))放大2倍的平均峰值信噪比分别为37.851 1 dB,33.933 8 dB,32.219 1 dB,32.148 9 dB,均高于其他几种算法的结果。结论本文提出的卷积网络采用多尺度卷积充分提取分层特征中的不同层次特征,同时利用低分辨率图像本身的结构信息完成重建,并取得不错的重建效果。关键词:深度学习;卷积神经网络(CNN);单幅图像超分辨率(SISR);多层次感知;残差网络;密集连接;DIV2K67|27|1更新时间:2024-05-07

摘要:目的单幅图像超分辨率重建的深度学习算法中,大多数网络都采用了单一尺度的卷积核来提取特征(如3×3的卷积核),往往忽略了不同卷积核尺寸带来的不同大小感受域的问题,而不同大小的感受域会使网络注意到不同程度的特征,因此只采用单一尺度的卷积核会使网络忽略了不同特征图之间的宏观联系。针对上述问题,本文提出了多层次感知残差卷积网络(multi-level perception residual convolutional network,MLP-Net,用于单幅图像超分辨率重建)。方法通过特征提取模块提取图像低频特征作为输入。输入部分由密集连接的多个多层次感知模块组成,其中多层次感知模块分为浅层多层次特征提取和深层多层次特征提取,以确保网络既能注意到图像的低级特征,又能注意到高级特征,同时也能保证特征之间的宏观联系。结果实验结果采用客观评价的峰值信噪比(peak signal to noise ratio,PSNR)和结构相似性(structural similarity,SSIM)两个指标,将本文算法其他超分辨率算法进行了对比。最终结果表明本文算法在4个基准测试集上(Set5、Set14、Urban100和BSD100(Berkeley Segmentation Dataset))放大2倍的平均峰值信噪比分别为37.851 1 dB,33.933 8 dB,32.219 1 dB,32.148 9 dB,均高于其他几种算法的结果。结论本文提出的卷积网络采用多尺度卷积充分提取分层特征中的不同层次特征,同时利用低分辨率图像本身的结构信息完成重建,并取得不错的重建效果。关键词:深度学习;卷积神经网络(CNN);单幅图像超分辨率(SISR);多层次感知;残差网络;密集连接;DIV2K67|27|1更新时间:2024-05-07 -

摘要:目的为解决水下图像的色偏和低对比度等问题,提出一种基于双尺度图像分解的水下彩色图像增强算法。方法通过基于均值和方差的对比度拉伸方法改善图像的色偏问题,并利用中值滤波降低红通道对比度拉伸后引入的噪声;采用双尺度图像分解绿通道图像补偿红通道图像细节;在处理后的红通道图像中引入原始图像红通道的真实细节与颜色。结果选取不同水下图像作为实验数据集,将本文方法与暗通道先验的方法、基于融合的方法、自动红通道恢复方法以及一种基于卷积神经网络深度学习的方法相比较,首先从主观视觉效果进行定性分析,然后通过不同评测指标进行定量分析。主观定性分析结果表明,提出的方法相比较其他方法能够更好地解决图像色偏和红色阴影问题;定量分析中,自然图像质量评价(natural image quality evaluation,NIQE)指标和信息熵(information entropy,IE)值较基于融合的方法和深度学习的方法分别提高了1.8%和13.6%,且水下图像质量评价指标(underwater image quality measurement method,UIQM)较其他方法更优。结论提出的双尺度图像分解方法利用水下图像成像特点解决图像色偏以及低对比度问题,具有良好的适应能力,同时算法复杂度低且鲁棒性较高,普遍适用于复杂的水下彩色图像增强。关键词:水下图像;双尺度分解;均值滤波;细节补偿;色偏;红色阴影101|158|2更新时间:2024-05-07

摘要:目的为解决水下图像的色偏和低对比度等问题,提出一种基于双尺度图像分解的水下彩色图像增强算法。方法通过基于均值和方差的对比度拉伸方法改善图像的色偏问题,并利用中值滤波降低红通道对比度拉伸后引入的噪声;采用双尺度图像分解绿通道图像补偿红通道图像细节;在处理后的红通道图像中引入原始图像红通道的真实细节与颜色。结果选取不同水下图像作为实验数据集,将本文方法与暗通道先验的方法、基于融合的方法、自动红通道恢复方法以及一种基于卷积神经网络深度学习的方法相比较,首先从主观视觉效果进行定性分析,然后通过不同评测指标进行定量分析。主观定性分析结果表明,提出的方法相比较其他方法能够更好地解决图像色偏和红色阴影问题;定量分析中,自然图像质量评价(natural image quality evaluation,NIQE)指标和信息熵(information entropy,IE)值较基于融合的方法和深度学习的方法分别提高了1.8%和13.6%,且水下图像质量评价指标(underwater image quality measurement method,UIQM)较其他方法更优。结论提出的双尺度图像分解方法利用水下图像成像特点解决图像色偏以及低对比度问题,具有良好的适应能力,同时算法复杂度低且鲁棒性较高,普遍适用于复杂的水下彩色图像增强。关键词:水下图像;双尺度分解;均值滤波;细节补偿;色偏;红色阴影101|158|2更新时间:2024-05-07

图像处理和编码

-

摘要:目的针对现有步态识别方法易受携带物品、衣服变化等影响的问题,提出了将无肩姿态能量图、步态参数等姿态特征与步态参数的2维傅里叶变换相结合的步态识别算法。方法基于姿态关节点序列提出忽略肩膀宽度信息的无肩姿态能量图,用以减弱衣服变化的影响;由于下肢受衣物及背包影响较小,提取3个或3个以上的下肢关节点局部结构参数,即提取中臀点与左右膝关节点、中臀点与左右踝关节点构成的两个三角形面积以及所有下肢关节点构成的多边形面积作为步态参数,增强下肢参数在步态识别中的作用;人在行走时,单肢体的运动具有一定的周期性,且肢体之间运动具有一定的协调性,用步态参数的2维幅度谱来表示单肢体运动的周期性与肢体之间运动的协调性,以提高步态参数的可区别性;在现有典型步态特征的基础上,融合本文提出的无肩姿态能量图、步态参数及其2维傅里叶变换幅度谱,采用多特征表示步态的方法,充分利用各特征的优点,提出加权平均与最大池化相结合的两层分数融合策略进行步态识别,提高了步态识别算法在携带物品、衣服变化和跨视角等条件下的正确率。结果实验结果表明,在中国科学院自动化研究所发布的步态数据集CASIA-B上,本文方法在相同视角条件下,正常状态、背包状态和穿大衣状态的平均识别率分别为99.56%、99.23%和94.25%;在跨视角条件下,正常状态、背包状态和穿大衣状态的平均识别率分别为91.32%、85.34%和69.51%。与典型算法相比,穿大衣状态的识别率有显著提升。结论本文方法采用加权平均与最大池化相结合的两层分数融合策略,综合利用各特征的优点及其适用场景,有效提高了步态识别的准确率,特别是减弱了衣服厚度、样式等变化对步态识别的影响。关键词:步态识别;姿态特征;无肩姿态能量图;运动的协调性与周期性;局部结构步态参数;步态参数的2维傅里叶变换;两层分数融合策略84|33|3更新时间:2024-05-07

摘要:目的针对现有步态识别方法易受携带物品、衣服变化等影响的问题,提出了将无肩姿态能量图、步态参数等姿态特征与步态参数的2维傅里叶变换相结合的步态识别算法。方法基于姿态关节点序列提出忽略肩膀宽度信息的无肩姿态能量图,用以减弱衣服变化的影响;由于下肢受衣物及背包影响较小,提取3个或3个以上的下肢关节点局部结构参数,即提取中臀点与左右膝关节点、中臀点与左右踝关节点构成的两个三角形面积以及所有下肢关节点构成的多边形面积作为步态参数,增强下肢参数在步态识别中的作用;人在行走时,单肢体的运动具有一定的周期性,且肢体之间运动具有一定的协调性,用步态参数的2维幅度谱来表示单肢体运动的周期性与肢体之间运动的协调性,以提高步态参数的可区别性;在现有典型步态特征的基础上,融合本文提出的无肩姿态能量图、步态参数及其2维傅里叶变换幅度谱,采用多特征表示步态的方法,充分利用各特征的优点,提出加权平均与最大池化相结合的两层分数融合策略进行步态识别,提高了步态识别算法在携带物品、衣服变化和跨视角等条件下的正确率。结果实验结果表明,在中国科学院自动化研究所发布的步态数据集CASIA-B上,本文方法在相同视角条件下,正常状态、背包状态和穿大衣状态的平均识别率分别为99.56%、99.23%和94.25%;在跨视角条件下,正常状态、背包状态和穿大衣状态的平均识别率分别为91.32%、85.34%和69.51%。与典型算法相比,穿大衣状态的识别率有显著提升。结论本文方法采用加权平均与最大池化相结合的两层分数融合策略,综合利用各特征的优点及其适用场景,有效提高了步态识别的准确率,特别是减弱了衣服厚度、样式等变化对步态识别的影响。关键词:步态识别;姿态特征;无肩姿态能量图;运动的协调性与周期性;局部结构步态参数;步态参数的2维傅里叶变换;两层分数融合策略84|33|3更新时间:2024-05-07 -

摘要:目的手势识别是人机交互领域的热点问题。针对传统手势识别方法在复杂背景下识别率低,以及现有基于深度学习的手势识别方法检测时间长等问题,提出了一种基于改进TinyYOLOv3算法的手势识别方法。方法对TinyYOLOv3主干网络重新进行设计,增加网络层数,从而确保网络提取到更丰富的语义信息。使用深度可分离卷积代替传统卷积,并对不同网络层的特征进行融合,在保证识别准确率的同时,减小网络模型的大小。采用CIoU(complete intersection over union)损失对原始的边界框坐标预测损失进行改进,将通道注意力模块融合到特征提取网络中,提高了定位精度和识别准确率。使用数据增强方法避免训练过拟合,并通过超参数优化和先验框聚类等方法加快网络收敛速度。结果改进后的网络识别准确率达到99.1%,网络模型大小为27.6 MB,相比原网络(TinyYOLOv3)准确率提升了8.5%,网络模型降低了5.6 MB,相比于YOLO(you only look once)v3和SSD(single shot multibox detector)300算法,准确率略有降低,但网络模型分别减小到原来的1/8和1/3左右,相比于YOLO-lite和MobileNet-SSD等轻量级网络,准确率分别提升61.12%和3.11%。同时在自制的复杂背景下的手势数据集对改进后的网络模型进行验证,准确率达到97.3%,充分证明了本文算法的可行性。结论本文提出的改进Tiny-YOLOv3手势识别方法,对于复杂背景下的手势具有较高的识别准确率,同时在检测速度和模型大小方面都优于其他算法,可以较好地满足在嵌入式设备中的使用要求。关键词:手势识别;TinyYOLOv3;深度可分离卷积;CIoU损失76|75|3更新时间:2024-05-07

摘要:目的手势识别是人机交互领域的热点问题。针对传统手势识别方法在复杂背景下识别率低,以及现有基于深度学习的手势识别方法检测时间长等问题,提出了一种基于改进TinyYOLOv3算法的手势识别方法。方法对TinyYOLOv3主干网络重新进行设计,增加网络层数,从而确保网络提取到更丰富的语义信息。使用深度可分离卷积代替传统卷积,并对不同网络层的特征进行融合,在保证识别准确率的同时,减小网络模型的大小。采用CIoU(complete intersection over union)损失对原始的边界框坐标预测损失进行改进,将通道注意力模块融合到特征提取网络中,提高了定位精度和识别准确率。使用数据增强方法避免训练过拟合,并通过超参数优化和先验框聚类等方法加快网络收敛速度。结果改进后的网络识别准确率达到99.1%,网络模型大小为27.6 MB,相比原网络(TinyYOLOv3)准确率提升了8.5%,网络模型降低了5.6 MB,相比于YOLO(you only look once)v3和SSD(single shot multibox detector)300算法,准确率略有降低,但网络模型分别减小到原来的1/8和1/3左右,相比于YOLO-lite和MobileNet-SSD等轻量级网络,准确率分别提升61.12%和3.11%。同时在自制的复杂背景下的手势数据集对改进后的网络模型进行验证,准确率达到97.3%,充分证明了本文算法的可行性。结论本文提出的改进Tiny-YOLOv3手势识别方法,对于复杂背景下的手势具有较高的识别准确率,同时在检测速度和模型大小方面都优于其他算法,可以较好地满足在嵌入式设备中的使用要求。关键词:手势识别;TinyYOLOv3;深度可分离卷积;CIoU损失76|75|3更新时间:2024-05-07 -

摘要:目的人脸姿态偏转是影响人脸识别准确率的一个重要因素,本文利用3维人脸重建中常用的3维形变模型以及深度卷积神经网络,提出一种用于多姿态人脸识别的人脸姿态矫正算法,在一定程度上提高了大姿态下人脸识别的准确率。方法对传统的3维形变模型拟合方法进行改进,利用人脸形状参数和表情参数对3维形变模型进行建模,针对面部不同区域的关键点赋予不同的权值,加权拟合3维形变模型,使得具有不同姿态和面部表情的人脸图像拟合效果更好。然后,对3维人脸模型进行姿态矫正并利用深度学习对人脸图像进行修复,修复不规则的人脸空洞区域,并使用最新的局部卷积技术同时在新的数据集上重新训练卷积神经网络,使得网络参数达到最优。结果在LFW(labeled faces in the wild)人脸数据库和StirlingESRC(Economic Social Research Council)3维人脸数据库上,将本文算法与其他方法进行比较,实验结果表明,本文算法的人脸识别精度有一定程度的提高。在LFW数据库上,通过对具有任意姿态的人脸图像进行姿态矫正和修复后,本文方法达到了96.57%的人脸识别精确度。在StirlingESRC数据库上,本文方法在人脸姿态为±22°的情况下,人脸识别准确率分别提高5.195%和2.265%;在人脸姿态为±45°情况下,人脸识别准确率分别提高5.875%和11.095%;平均人脸识别率分别提高5.53%和7.13%。对比实验结果表明,本文提出的人脸姿态矫正算法有效提高了人脸识别的准确率。结论本文提出的人脸姿态矫正算法,综合了3维形变模型和深度学习模型的优点,在各个人脸姿态角度下,均能使人脸识别准确率在一定程度上有所提高。关键词:多姿态人脸识别;3维形变模型(3DMM);卷积神经网络(CNN);图像修复;深度学习89|104|1更新时间:2024-05-07

摘要:目的人脸姿态偏转是影响人脸识别准确率的一个重要因素,本文利用3维人脸重建中常用的3维形变模型以及深度卷积神经网络,提出一种用于多姿态人脸识别的人脸姿态矫正算法,在一定程度上提高了大姿态下人脸识别的准确率。方法对传统的3维形变模型拟合方法进行改进,利用人脸形状参数和表情参数对3维形变模型进行建模,针对面部不同区域的关键点赋予不同的权值,加权拟合3维形变模型,使得具有不同姿态和面部表情的人脸图像拟合效果更好。然后,对3维人脸模型进行姿态矫正并利用深度学习对人脸图像进行修复,修复不规则的人脸空洞区域,并使用最新的局部卷积技术同时在新的数据集上重新训练卷积神经网络,使得网络参数达到最优。结果在LFW(labeled faces in the wild)人脸数据库和StirlingESRC(Economic Social Research Council)3维人脸数据库上,将本文算法与其他方法进行比较,实验结果表明,本文算法的人脸识别精度有一定程度的提高。在LFW数据库上,通过对具有任意姿态的人脸图像进行姿态矫正和修复后,本文方法达到了96.57%的人脸识别精确度。在StirlingESRC数据库上,本文方法在人脸姿态为±22°的情况下,人脸识别准确率分别提高5.195%和2.265%;在人脸姿态为±45°情况下,人脸识别准确率分别提高5.875%和11.095%;平均人脸识别率分别提高5.53%和7.13%。对比实验结果表明,本文提出的人脸姿态矫正算法有效提高了人脸识别的准确率。结论本文提出的人脸姿态矫正算法,综合了3维形变模型和深度学习模型的优点,在各个人脸姿态角度下,均能使人脸识别准确率在一定程度上有所提高。关键词:多姿态人脸识别;3维形变模型(3DMM);卷积神经网络(CNN);图像修复;深度学习89|104|1更新时间:2024-05-07 -

摘要:目的为了解决复杂环境中多人姿态估计存在的定位和识别等问题,提高多人姿态估计的准确率,减少算法存在的大量冗余参数,提高姿态估计的运行速率,提出了基于批量归一化层(batch normalization,BN)通道剪枝的多人姿态估计算法(YOLOv3 prune pose estimator,YLPPE)。方法以目标检测算法YOLOv3(you only look once v3)和堆叠沙漏网络(stacked hourglass network,SHN)算法为基础,通过重叠度K-means算法修改YOLOv3网络锚框以更适应行人目标检测,并训练得到Trimming-YOLOv3网络;利用批量归一化层的缩放因子对Trimming-YOLOv3网络进行循环迭代式通道剪枝,设置剪枝阈值与缩放因子,实现较为有效的模型剪枝效果,训练得到Trim-Prune-YOLOv3网络;为了结合单人姿态估计网络,重定义图像尺寸为256×256像素(非正方形图像通过补零实现);再级联4个Hourglass子网络得到堆叠沙漏网络,从而提升整体姿态估计精度。结果利用斯坦福大学的MPⅡ数据集(MPⅡ human pose dataset)进行实验验证,本文算法对姿态估计的准确率达到了83.9%;同时,时间复杂度为O(n2),模型参数量与未剪枝原始YOLOv3相比下降42.9%。结论结合YOLOv3剪枝算法的多人姿态估计方法可以有效减少复杂环境对人体姿态估计的负面影响,实现复杂环境下的多人姿态估计并提高估计精度,有效减少模型冗余参数,提高算法的整体运行速率,能够实现较为准确的多人姿态估计,并具有较好的鲁棒性和泛化能力。关键词:目标检测;多人姿态估计;模型剪枝;YOLOv3;堆叠沙漏网络;MPII数据集86|122|7更新时间:2024-05-07

摘要:目的为了解决复杂环境中多人姿态估计存在的定位和识别等问题,提高多人姿态估计的准确率,减少算法存在的大量冗余参数,提高姿态估计的运行速率,提出了基于批量归一化层(batch normalization,BN)通道剪枝的多人姿态估计算法(YOLOv3 prune pose estimator,YLPPE)。方法以目标检测算法YOLOv3(you only look once v3)和堆叠沙漏网络(stacked hourglass network,SHN)算法为基础,通过重叠度K-means算法修改YOLOv3网络锚框以更适应行人目标检测,并训练得到Trimming-YOLOv3网络;利用批量归一化层的缩放因子对Trimming-YOLOv3网络进行循环迭代式通道剪枝,设置剪枝阈值与缩放因子,实现较为有效的模型剪枝效果,训练得到Trim-Prune-YOLOv3网络;为了结合单人姿态估计网络,重定义图像尺寸为256×256像素(非正方形图像通过补零实现);再级联4个Hourglass子网络得到堆叠沙漏网络,从而提升整体姿态估计精度。结果利用斯坦福大学的MPⅡ数据集(MPⅡ human pose dataset)进行实验验证,本文算法对姿态估计的准确率达到了83.9%;同时,时间复杂度为O(n2),模型参数量与未剪枝原始YOLOv3相比下降42.9%。结论结合YOLOv3剪枝算法的多人姿态估计方法可以有效减少复杂环境对人体姿态估计的负面影响,实现复杂环境下的多人姿态估计并提高估计精度,有效减少模型冗余参数,提高算法的整体运行速率,能够实现较为准确的多人姿态估计,并具有较好的鲁棒性和泛化能力。关键词:目标检测;多人姿态估计;模型剪枝;YOLOv3;堆叠沙漏网络;MPII数据集86|122|7更新时间:2024-05-07 -

摘要:目的细粒度图像分类是计算机视觉领域具有挑战性的课题,目的是将一个大的类别分为更详细的子类别,在工业和学术方面都有着十分广泛的研究需求。为了改善细粒度图像分类过程中不相关背景干扰和类别差异特征难以提取的问题,提出了一种将目标检测方法YOLOv3(you only look once)和双线性融合网络相结合的细粒度分类优化算法,以此提高细粒度图像分类的性能。方法利用重新训练过的目标检测算法YOLOv3粗略确定目标在图像中的位置;使用背景抑制方法消除目标以外的信息干扰;利用融合不同通道、不同层级卷积层特征的方法对经典的细粒度分类算法双线性卷积神经网络(bilinear convolutional neural network,B-CNN)进行改进,优化分类性能,通过融合双线性网络中不同卷积层的特征向量,得到更加丰富的互补信息,从而提高细粒度分类精度。结果实验结果表明,在CUB-200-2011(Caltech-UCSD Birds-200- 2011)、Cars196和Aircrafts100数据集中,本文算法的分类准确率分别为86.3%、92.8%和89.0%,比经典的B-CNN细粒度分类算法分别提高了2.2%、1.5%和4.9%,验证了本文算法的有效性。同时,与已有细粒度图像分类算法相比也表现出一定的优势。结论改进算法使用YOLOv3有效滤除了大量无关背景,通过特征融合方法来改进双线性卷积神经分类网络,丰富特征信息,使分类的结果更加精准。关键词:细粒度图像分类;目标检测;背景抑制;特征融合;双线性卷积神经网络(B-CNN)223|177|6更新时间:2024-05-07

摘要:目的细粒度图像分类是计算机视觉领域具有挑战性的课题,目的是将一个大的类别分为更详细的子类别,在工业和学术方面都有着十分广泛的研究需求。为了改善细粒度图像分类过程中不相关背景干扰和类别差异特征难以提取的问题,提出了一种将目标检测方法YOLOv3(you only look once)和双线性融合网络相结合的细粒度分类优化算法,以此提高细粒度图像分类的性能。方法利用重新训练过的目标检测算法YOLOv3粗略确定目标在图像中的位置;使用背景抑制方法消除目标以外的信息干扰;利用融合不同通道、不同层级卷积层特征的方法对经典的细粒度分类算法双线性卷积神经网络(bilinear convolutional neural network,B-CNN)进行改进,优化分类性能,通过融合双线性网络中不同卷积层的特征向量,得到更加丰富的互补信息,从而提高细粒度分类精度。结果实验结果表明,在CUB-200-2011(Caltech-UCSD Birds-200- 2011)、Cars196和Aircrafts100数据集中,本文算法的分类准确率分别为86.3%、92.8%和89.0%,比经典的B-CNN细粒度分类算法分别提高了2.2%、1.5%和4.9%,验证了本文算法的有效性。同时,与已有细粒度图像分类算法相比也表现出一定的优势。结论改进算法使用YOLOv3有效滤除了大量无关背景,通过特征融合方法来改进双线性卷积神经分类网络,丰富特征信息,使分类的结果更加精准。关键词:细粒度图像分类;目标检测;背景抑制;特征融合;双线性卷积神经网络(B-CNN)223|177|6更新时间:2024-05-07 -

摘要:目的服装检索方法是计算机视觉与自然语言处理领域的研究热点,其包含基于内容与基于文本的两种查询模态。然而传统检索方法通常存在检索效率低的问题,且很少研究关注服装在风格上的相似性。为解决这些问题,本文提出深度多模态融合的服装风格检索方法。方法提出分层深度哈希检索模型,基于预训练的残差网络ResNet(residual network)进行迁移学习,并把分类层改造成哈希编码层,利用哈希特征进行粗检索,再用图像深层特征进行细检索。设计文本分类语义检索模型,基于LSTM(long short-term memory)设计文本分类网络以提前分类缩小检索范围,再以基于doc2vec提取的文本嵌入语义特征进行检索。同时提出相似风格上下文检索模型,其参考单词相似性来衡量服装风格相似性。最后采用概率驱动的方法量化风格相似性,并以最大化该相似性的结果融合方法作为本文检索方法的最终反馈。结果在Polyvore数据集上,与原始ResNet模型相比,分层深度哈希检索模型的top5平均检索精度提高11.6%,检索速度提高2.57 s/次。与传统文本分类嵌入模型相比,本文分类语义检索模型的top5查准率提高29.96%,检索速度提高16.53 s/次。结论提出的深度多模态融合的服装风格检索方法获得检索精度与检索速度的提升,同时进行了相似风格服装的检索使结果更具有多样性。关键词:多模态服装检索;哈希特征;文本嵌入;风格相似性;深度哈希63|52|1更新时间:2024-05-07

摘要:目的服装检索方法是计算机视觉与自然语言处理领域的研究热点,其包含基于内容与基于文本的两种查询模态。然而传统检索方法通常存在检索效率低的问题,且很少研究关注服装在风格上的相似性。为解决这些问题,本文提出深度多模态融合的服装风格检索方法。方法提出分层深度哈希检索模型,基于预训练的残差网络ResNet(residual network)进行迁移学习,并把分类层改造成哈希编码层,利用哈希特征进行粗检索,再用图像深层特征进行细检索。设计文本分类语义检索模型,基于LSTM(long short-term memory)设计文本分类网络以提前分类缩小检索范围,再以基于doc2vec提取的文本嵌入语义特征进行检索。同时提出相似风格上下文检索模型,其参考单词相似性来衡量服装风格相似性。最后采用概率驱动的方法量化风格相似性,并以最大化该相似性的结果融合方法作为本文检索方法的最终反馈。结果在Polyvore数据集上,与原始ResNet模型相比,分层深度哈希检索模型的top5平均检索精度提高11.6%,检索速度提高2.57 s/次。与传统文本分类嵌入模型相比,本文分类语义检索模型的top5查准率提高29.96%,检索速度提高16.53 s/次。结论提出的深度多模态融合的服装风格检索方法获得检索精度与检索速度的提升,同时进行了相似风格服装的检索使结果更具有多样性。关键词:多模态服装检索;哈希特征;文本嵌入;风格相似性;深度哈希63|52|1更新时间:2024-05-07 -

摘要:目的视觉显著性在众多视觉驱动的应用中具有重要作用,这些应用领域出现了从2维视觉到3维视觉的转换,从而基于RGB-D数据的显著性模型引起了广泛关注。与2维图像的显著性不同,RGB-D显著性包含了许多不同模态的线索。多模态线索之间存在互补和竞争关系,如何有效地利用和融合这些线索仍是一个挑战。传统的融合模型很难充分利用多模态线索之间的优势,因此研究了RGB-D显著性形成过程中多模态线索融合的问题。方法提出了一种基于超像素下条件随机场的RGB-D显著性检测模型。提取不同模态的显著性线索,包括平面线索、深度线索和运动线索等。以超像素为单位建立条件随机场模型,联合多模态线索的影响和图像邻域显著值平滑约束,设计了一个全局能量函数作为模型的优化目标,刻画了多模态线索之间的相互作用机制。其中,多模态线索在能量函数中的权重因子由卷积神经网络学习得到。结果实验在两个公开的RGB-D视频显著性数据集上与6种显著性检测方法进行了比较,所提模型在所有相关数据集和评价指标上都优于当前最先进的模型。相比于第2高的指标,所提模型的AUC(area under curve),sAUC(shuffled AUC),SIM(similarity),PCC(Pearson correlation coefficient)和NSS(normalized scanpath saliency)指标在IRCCyN数据集上分别提升了2.3%,2.3%,18.9%,21.6%和56.2%;在DML-iTrack-3D数据集上分别提升了2.0%,1.4%,29.1%,10.6%,23.3%。此外还进行了模型内部的比较,验证了所提融合方法优于其他传统融合方法。结论本文提出的RGB-D显著性检测模型中的条件随机场和卷积神经网络充分利用了不同模态线索的优势,将它们有效融合,提升了显著性检测模型的性能,能在视觉驱动的应用领域发挥一定作用。关键词:RGB-D显著性;显著性融合;条件随机场(CRF);全局能量函数;卷积神经网络(CNN)136|209|2更新时间:2024-05-07

摘要:目的视觉显著性在众多视觉驱动的应用中具有重要作用,这些应用领域出现了从2维视觉到3维视觉的转换,从而基于RGB-D数据的显著性模型引起了广泛关注。与2维图像的显著性不同,RGB-D显著性包含了许多不同模态的线索。多模态线索之间存在互补和竞争关系,如何有效地利用和融合这些线索仍是一个挑战。传统的融合模型很难充分利用多模态线索之间的优势,因此研究了RGB-D显著性形成过程中多模态线索融合的问题。方法提出了一种基于超像素下条件随机场的RGB-D显著性检测模型。提取不同模态的显著性线索,包括平面线索、深度线索和运动线索等。以超像素为单位建立条件随机场模型,联合多模态线索的影响和图像邻域显著值平滑约束,设计了一个全局能量函数作为模型的优化目标,刻画了多模态线索之间的相互作用机制。其中,多模态线索在能量函数中的权重因子由卷积神经网络学习得到。结果实验在两个公开的RGB-D视频显著性数据集上与6种显著性检测方法进行了比较,所提模型在所有相关数据集和评价指标上都优于当前最先进的模型。相比于第2高的指标,所提模型的AUC(area under curve),sAUC(shuffled AUC),SIM(similarity),PCC(Pearson correlation coefficient)和NSS(normalized scanpath saliency)指标在IRCCyN数据集上分别提升了2.3%,2.3%,18.9%,21.6%和56.2%;在DML-iTrack-3D数据集上分别提升了2.0%,1.4%,29.1%,10.6%,23.3%。此外还进行了模型内部的比较,验证了所提融合方法优于其他传统融合方法。结论本文提出的RGB-D显著性检测模型中的条件随机场和卷积神经网络充分利用了不同模态线索的优势,将它们有效融合,提升了显著性检测模型的性能,能在视觉驱动的应用领域发挥一定作用。关键词:RGB-D显著性;显著性融合;条件随机场(CRF);全局能量函数;卷积神经网络(CNN)136|209|2更新时间:2024-05-07 -

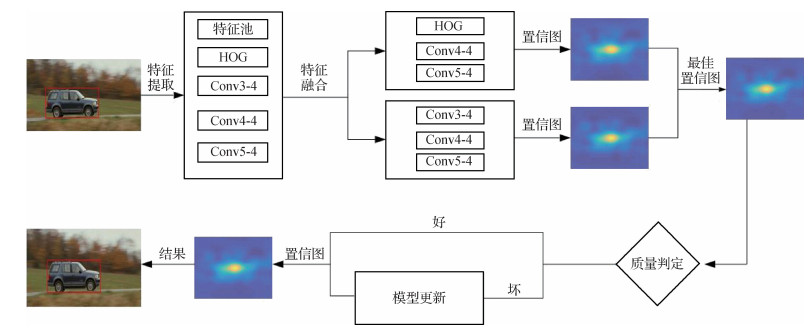

摘要:目的针对目标跟踪算法在现实场景的遮挡、光照变化和尺度变化等问题,提出一种融入时序信息和速度信息的多特征融合自适应模型更新目标跟踪算法。方法通过提取目标的分级深度特征和手工设计方向梯度直方图(histogram of oriented gradients,HOG)特征,以全深度特征组合和深层深度特征与手工设计特征组合的方式构造两个融合特征器,提高在复杂场景下跟踪的稳健性;对融合特征进行可信度计算,选择最可靠融合特征对当前帧目标进行跟踪;在跟踪质量不可靠时,对目标表征模型进行更新,加入时间上下文信息和当前鲁棒表征信息,通过多峰值判定和运动速度判定选择最优目标预测位置作为最终结果。结果在OTB(object tracking benchmark)2013和OTB2015数据库上进行大量测试,与其他7个算法相比,本文算法总体效果取得最优,且在不同复杂环境下也取得了优秀的跟踪效果,在OTB13和OTB15数据库中,跟踪精度分别为89.3%和83.3%,成功率分别为87%和78.3%。结论本文算法利用深度特征与手工设计特征进行融合,对跟踪结果进行多峰值分析和运动速度判定,跟踪结果不佳时自适应更新特征进行重跟踪。实验结果表明,本文算法可以有效处理光照变化、背景杂波和遮挡等复杂因素的干扰,有效提升了跟踪质量。关键词:目标跟踪;分级深度特征;时间上下文信息;多峰值判定;模型更新92|96|1更新时间:2024-05-07

摘要:目的针对目标跟踪算法在现实场景的遮挡、光照变化和尺度变化等问题,提出一种融入时序信息和速度信息的多特征融合自适应模型更新目标跟踪算法。方法通过提取目标的分级深度特征和手工设计方向梯度直方图(histogram of oriented gradients,HOG)特征,以全深度特征组合和深层深度特征与手工设计特征组合的方式构造两个融合特征器,提高在复杂场景下跟踪的稳健性;对融合特征进行可信度计算,选择最可靠融合特征对当前帧目标进行跟踪;在跟踪质量不可靠时,对目标表征模型进行更新,加入时间上下文信息和当前鲁棒表征信息,通过多峰值判定和运动速度判定选择最优目标预测位置作为最终结果。结果在OTB(object tracking benchmark)2013和OTB2015数据库上进行大量测试,与其他7个算法相比,本文算法总体效果取得最优,且在不同复杂环境下也取得了优秀的跟踪效果,在OTB13和OTB15数据库中,跟踪精度分别为89.3%和83.3%,成功率分别为87%和78.3%。结论本文算法利用深度特征与手工设计特征进行融合,对跟踪结果进行多峰值分析和运动速度判定,跟踪结果不佳时自适应更新特征进行重跟踪。实验结果表明,本文算法可以有效处理光照变化、背景杂波和遮挡等复杂因素的干扰,有效提升了跟踪质量。关键词:目标跟踪;分级深度特征;时间上下文信息;多峰值判定;模型更新92|96|1更新时间:2024-05-07 -

摘要:目的3D点云与以规则的密集网格表示的图像不同,不仅不规则且无序,而且由于输入输出大小和顺序差异,具有密度不均匀以及形状和缩放比例存在差异的特性。为此,提出一种对3D点云进行卷积的方法,将关系形状卷积神经网络(relation-shape convolution neural network,RSCNN)与逆密度函数相结合,并在卷积网络中增添反卷积层,实现了点云更精确的分类分割效果。方法在关系形状卷积神经网络中,将卷积核视为由权重函数和逆密度函数组成的3D点局部坐标的非线性函数。对给定的点,权重函数通过多层感知器网络学习,逆密度函数通过核密度估计(kernel density estimation,KDE)学习,逆密度函数的引入对点云采样率不均匀的情况进行弥补。在点云分割任务中,引入由插值和关系形状卷积层两部分组成的反卷积层,将特征从子采样点云传播回原始分辨率。结果在ModelNet40、ShapeNet、ScanNet数据集上进行分类、部分分割和语义场景分割实验,验证模型的分类分割性能。在分类实验中,与PointNet++相比,整体精度提升3.1%,在PointNet++将法线也作为输入的情况下,精度依然提升了1.9%;在部分分割实验中,类平均交并比(mean intersection over union,mIoU)比PointNet++在法线作为输入情况下高6.0%,实例mIoU比PointNet++高1.4%;在语义场景分割实验中,mIoU比PointNet++高13.7%。在ScanNet数据集上进行不同步长有无逆密度函数的对比实验,实验证明逆密度函数将分割精度提升0.8%左右,有效提升了模型性能。结论融合逆密度函数的关系形状卷积神经网络可以有效获取点云数据中的局部和全局特征,并对点云采样不均匀的情况实现一定程度的补偿,实现更优的分类和分割效果。关键词:关系形状卷积神经网络(RSCNN);逆密度函数;非均匀采样;反卷积层;点云的分类与分割51|57|1更新时间:2024-05-07

摘要:目的3D点云与以规则的密集网格表示的图像不同,不仅不规则且无序,而且由于输入输出大小和顺序差异,具有密度不均匀以及形状和缩放比例存在差异的特性。为此,提出一种对3D点云进行卷积的方法,将关系形状卷积神经网络(relation-shape convolution neural network,RSCNN)与逆密度函数相结合,并在卷积网络中增添反卷积层,实现了点云更精确的分类分割效果。方法在关系形状卷积神经网络中,将卷积核视为由权重函数和逆密度函数组成的3D点局部坐标的非线性函数。对给定的点,权重函数通过多层感知器网络学习,逆密度函数通过核密度估计(kernel density estimation,KDE)学习,逆密度函数的引入对点云采样率不均匀的情况进行弥补。在点云分割任务中,引入由插值和关系形状卷积层两部分组成的反卷积层,将特征从子采样点云传播回原始分辨率。结果在ModelNet40、ShapeNet、ScanNet数据集上进行分类、部分分割和语义场景分割实验,验证模型的分类分割性能。在分类实验中,与PointNet++相比,整体精度提升3.1%,在PointNet++将法线也作为输入的情况下,精度依然提升了1.9%;在部分分割实验中,类平均交并比(mean intersection over union,mIoU)比PointNet++在法线作为输入情况下高6.0%,实例mIoU比PointNet++高1.4%;在语义场景分割实验中,mIoU比PointNet++高13.7%。在ScanNet数据集上进行不同步长有无逆密度函数的对比实验,实验证明逆密度函数将分割精度提升0.8%左右,有效提升了模型性能。结论融合逆密度函数的关系形状卷积神经网络可以有效获取点云数据中的局部和全局特征,并对点云采样不均匀的情况实现一定程度的补偿,实现更优的分类和分割效果。关键词:关系形状卷积神经网络(RSCNN);逆密度函数;非均匀采样;反卷积层;点云的分类与分割51|57|1更新时间:2024-05-07

图像分析和识别

-

摘要:目的机载激光雷达(light detection and ranging,LiDAR)能够快速获取建筑物表面的3维点云,为提取建筑物轮廓提供重要的数据支撑,但由于激光脚点的随机性和点云自身的离散性,常规固定半径Alpha Shapes(A-Shapes)算法难以兼顾轮廓提取的精细度和完整度,且在点数量较大情况下计算效率较低。因此,提出一种基于网格的可变半径Alpha Shapes方法用于提取机载LiDAR点云建筑物轮廓。方法对3维点云进行投影降维,对投影后2维离散点的范围构建规则格网,接着根据网格内点云填充情况筛选出边界网格,计算边界网格的平滑度并加权不同的滚动圆半径,再以边界网格为中心生成3×3邻域网格检测窗口,利用滚动圆原理提取窗口内点集的边界点,迭代检测直到所有边界网格遍历完成,最后获取点云的完整轮廓。结果在精度评价实验中,与固定半径A-Shapes方法和可变半径Alpha Shapes(variable radius Alpha Shapes,VA-Shapes)方法相比,若建筑物以直线特征为主且边缘点云参差不齐,则本文方法的提取效果不理想;若建筑物含有较多拐角特征,则本文方法的提取效果较好。在效率评价实验中,与A-Shapes方法、VA-Shapse方法以及包裹圆方法相比,若点云数据量较小,则4种方法的耗时差距不大;若数据量较大,则本文方法和包裹圆方法的耗时远小于固定半径A-Shapes方法。实验结果表明,本文提出的轮廓提取方法适用于多种形状的建筑物点云。从轮廓完整性、几何精度以及计算效率等几方面综合考虑,本文方法提取建筑物点云轮廓效果较好。结论本文提出的基于网格的可变半径Alpha Shapes建筑物点云轮廓提取方法结合了网格划分和滚动圆检测的优点,能够有效提取机载LiDAR建筑物点云顶部轮廓,具有较高的提取效率和良好的鲁棒性,提取的轮廓精度较高。关键词:机载激光雷达(LiDAR);点云;建筑物轮廓;Alpha Shapes算法;网格150|133|5更新时间:2024-05-07

摘要:目的机载激光雷达(light detection and ranging,LiDAR)能够快速获取建筑物表面的3维点云,为提取建筑物轮廓提供重要的数据支撑,但由于激光脚点的随机性和点云自身的离散性,常规固定半径Alpha Shapes(A-Shapes)算法难以兼顾轮廓提取的精细度和完整度,且在点数量较大情况下计算效率较低。因此,提出一种基于网格的可变半径Alpha Shapes方法用于提取机载LiDAR点云建筑物轮廓。方法对3维点云进行投影降维,对投影后2维离散点的范围构建规则格网,接着根据网格内点云填充情况筛选出边界网格,计算边界网格的平滑度并加权不同的滚动圆半径,再以边界网格为中心生成3×3邻域网格检测窗口,利用滚动圆原理提取窗口内点集的边界点,迭代检测直到所有边界网格遍历完成,最后获取点云的完整轮廓。结果在精度评价实验中,与固定半径A-Shapes方法和可变半径Alpha Shapes(variable radius Alpha Shapes,VA-Shapes)方法相比,若建筑物以直线特征为主且边缘点云参差不齐,则本文方法的提取效果不理想;若建筑物含有较多拐角特征,则本文方法的提取效果较好。在效率评价实验中,与A-Shapes方法、VA-Shapse方法以及包裹圆方法相比,若点云数据量较小,则4种方法的耗时差距不大;若数据量较大,则本文方法和包裹圆方法的耗时远小于固定半径A-Shapes方法。实验结果表明,本文提出的轮廓提取方法适用于多种形状的建筑物点云。从轮廓完整性、几何精度以及计算效率等几方面综合考虑,本文方法提取建筑物点云轮廓效果较好。结论本文提出的基于网格的可变半径Alpha Shapes建筑物点云轮廓提取方法结合了网格划分和滚动圆检测的优点,能够有效提取机载LiDAR建筑物点云顶部轮廓,具有较高的提取效率和良好的鲁棒性,提取的轮廓精度较高。关键词:机载激光雷达(LiDAR);点云;建筑物轮廓;Alpha Shapes算法;网格150|133|5更新时间:2024-05-07 -

摘要:目的光场相机可以通过单次曝光同时从多个视角采样单个场景,在深度估计领域具有独特优势。消除遮挡的影响是光场深度估计的难点之一。现有方法基于2D场景模型检测各视角遮挡状态,但是遮挡取决于所采样场景的3D立体模型,仅利用2D模型无法精确检测,不精确的遮挡检测结果将降低后续深度估计精度。针对这一问题,提出了3D遮挡模型引导的光场图像深度获取方法。方法向2D模型中的不同物体之间添加前后景关系和深度差信息,得到场景的立体模型,之后在立体模型中根据光线的传输路径推断所有视角的遮挡情况并记录在遮挡图(occlusion map)中。在遮挡图引导下,在遮挡和非遮挡区域分别使用不同成本量进行深度估计。在遮挡区域,通过遮挡图屏蔽被遮挡视角,基于剩余视角的成像一致性计算深度;在非遮挡区域,根据该区域深度连续特性设计了新型离焦网格匹配成本量,相比传统成本量,该成本量能够感知更广范围的色彩纹理,以此估计更平滑的深度图。为了进一步提升深度估计的精度,根据遮挡检测和深度估计的依赖关系设计了基于最大期望(exception maximization,EM)算法的联合优化框架,在该框架下,遮挡图和深度图通过互相引导的方式相继提升彼此精度。结果实验结果表明,本文方法在大部分实验场景中,对于单遮挡、多遮挡和低对比度遮挡在遮挡检测和深度估计方面均能达到最优结果。均方误差(mean square error,MSE)对比次优结果平均降低约19.75%。结论针对遮挡场景的深度估计,通过理论分析和实验验证,表明3D遮挡模型相比传统2D遮挡模型在遮挡检测方面具有一定优越性,本文方法更适用于复杂遮挡场景的深度估计。关键词:光场;深度估计;3D遮挡模型;抗遮挡;最大期望(EM)147|215|0更新时间:2024-05-07

摘要:目的光场相机可以通过单次曝光同时从多个视角采样单个场景,在深度估计领域具有独特优势。消除遮挡的影响是光场深度估计的难点之一。现有方法基于2D场景模型检测各视角遮挡状态,但是遮挡取决于所采样场景的3D立体模型,仅利用2D模型无法精确检测,不精确的遮挡检测结果将降低后续深度估计精度。针对这一问题,提出了3D遮挡模型引导的光场图像深度获取方法。方法向2D模型中的不同物体之间添加前后景关系和深度差信息,得到场景的立体模型,之后在立体模型中根据光线的传输路径推断所有视角的遮挡情况并记录在遮挡图(occlusion map)中。在遮挡图引导下,在遮挡和非遮挡区域分别使用不同成本量进行深度估计。在遮挡区域,通过遮挡图屏蔽被遮挡视角,基于剩余视角的成像一致性计算深度;在非遮挡区域,根据该区域深度连续特性设计了新型离焦网格匹配成本量,相比传统成本量,该成本量能够感知更广范围的色彩纹理,以此估计更平滑的深度图。为了进一步提升深度估计的精度,根据遮挡检测和深度估计的依赖关系设计了基于最大期望(exception maximization,EM)算法的联合优化框架,在该框架下,遮挡图和深度图通过互相引导的方式相继提升彼此精度。结果实验结果表明,本文方法在大部分实验场景中,对于单遮挡、多遮挡和低对比度遮挡在遮挡检测和深度估计方面均能达到最优结果。均方误差(mean square error,MSE)对比次优结果平均降低约19.75%。结论针对遮挡场景的深度估计,通过理论分析和实验验证,表明3D遮挡模型相比传统2D遮挡模型在遮挡检测方面具有一定优越性,本文方法更适用于复杂遮挡场景的深度估计。关键词:光场;深度估计;3D遮挡模型;抗遮挡;最大期望(EM)147|215|0更新时间:2024-05-07

图像理解和计算机视觉

-

摘要:目的对B样条的改进方法大多从增加局部参数和在三角函数空间定义基两个角度出发,但仍存在缺陷,原因是通过模型的控制顶点对曲线进行编辑和处理,存在控制顶点给定时曲线较为固定的不足。为此,本文构造了一类基于全正基的非均匀三次加权λαβ-B样条基。方法结合加权思想,首先证明三次有理基在相应空间上的全正性;其次对三次三角基和三次有理基同时进行扩展,得到新的λαβ-B样条基,新扩展基具有和经典B样条基相似的性质;最后对新扩展基进行线性组合,用得到的多项式构造非均匀三次加权λαβ-B样条基,并研究了曲线的定义及性质。结果实验结果表明,新曲线保留传统B样条曲线基本性质的同时,还具有局部调整性,可以改善只通过调整控制顶点改变曲线形状的不足。结论构造的新λαβ-B样条曲线可以有效克服传统方法在改进时的不足,适合曲线设计。关键词:λαβ-Bernstein基;加权λαβ-B样条;非均匀;全正性;局部调整性质57|30|1更新时间:2024-05-07

摘要:目的对B样条的改进方法大多从增加局部参数和在三角函数空间定义基两个角度出发,但仍存在缺陷,原因是通过模型的控制顶点对曲线进行编辑和处理,存在控制顶点给定时曲线较为固定的不足。为此,本文构造了一类基于全正基的非均匀三次加权λαβ-B样条基。方法结合加权思想,首先证明三次有理基在相应空间上的全正性;其次对三次三角基和三次有理基同时进行扩展,得到新的λαβ-B样条基,新扩展基具有和经典B样条基相似的性质;最后对新扩展基进行线性组合,用得到的多项式构造非均匀三次加权λαβ-B样条基,并研究了曲线的定义及性质。结果实验结果表明,新曲线保留传统B样条曲线基本性质的同时,还具有局部调整性,可以改善只通过调整控制顶点改变曲线形状的不足。结论构造的新λαβ-B样条曲线可以有效克服传统方法在改进时的不足,适合曲线设计。关键词:λαβ-Bernstein基;加权λαβ-B样条;非均匀;全正性;局部调整性质57|30|1更新时间:2024-05-07

计算机图形学

-

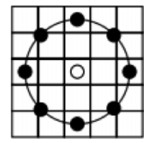

摘要:目的在极化合成孔径雷达(synthetic aperture radar,SAR)图像中常用直线检测进行机场跑道的识别,但是河流、道路等与机场跑道具有相似直线的地物容易对检测结果造成干扰,出现检测目标难定位、目标模糊、多虚警等问题。为此,本文设计了一种利用目标散射特性结合局部二值模式(local binary patterns,LBP)特征分类的极化SAR图像机场跑道区域检测方法,采用LBP特征对极化SAR图像进行有监督的分类来提取真实的机场区域。方法首先利用异化散射功率对极化SAR图像进行阈值分割,然后通过形态学处理得到疑似机场跑道区域,同时构建机场跑道和非机场跑道两类训练样本,并提取、统计样本的LBP特征,形成直方图,得到特征向量训练支持向量机(support vector machine,SVM)二分类器,其中SVM二分类器采用了径向基函数(radial basis function,RBF)核函数;接着对疑似机场跑道区域构建LBP特征,送入SVM二分类器中分类,对机场跑道进行检测识别,最终得到真实的机场跑道区域。结果利用UAVSAR(uninhabited aerial vehicle synthetic aperture radar)系统采集的7幅极化SAR图像数据进行实验检测,并选取基于几何特征辨识跑道的两种算法进行对比,3种方法均有效检测出了7幅场景中的真实跑道,但是本文方法在7幅数据中总的虚警和漏警个数均为1,而两种对比算法中的虚警个数分别为2和11、漏警个数分别为8和1。结论本文方法不仅能有效检测出机场跑道区域,且检测效果更好,计算量较小,虚警和漏警率低,效率更高。关键词:极化合成孔径雷达(PolSAR)图像;机场跑道检测;局部二值模式(LBP)特征;支持向量机(SVM)分类;阈值分割92|760|0更新时间:2024-05-07

摘要:目的在极化合成孔径雷达(synthetic aperture radar,SAR)图像中常用直线检测进行机场跑道的识别,但是河流、道路等与机场跑道具有相似直线的地物容易对检测结果造成干扰,出现检测目标难定位、目标模糊、多虚警等问题。为此,本文设计了一种利用目标散射特性结合局部二值模式(local binary patterns,LBP)特征分类的极化SAR图像机场跑道区域检测方法,采用LBP特征对极化SAR图像进行有监督的分类来提取真实的机场区域。方法首先利用异化散射功率对极化SAR图像进行阈值分割,然后通过形态学处理得到疑似机场跑道区域,同时构建机场跑道和非机场跑道两类训练样本,并提取、统计样本的LBP特征,形成直方图,得到特征向量训练支持向量机(support vector machine,SVM)二分类器,其中SVM二分类器采用了径向基函数(radial basis function,RBF)核函数;接着对疑似机场跑道区域构建LBP特征,送入SVM二分类器中分类,对机场跑道进行检测识别,最终得到真实的机场跑道区域。结果利用UAVSAR(uninhabited aerial vehicle synthetic aperture radar)系统采集的7幅极化SAR图像数据进行实验检测,并选取基于几何特征辨识跑道的两种算法进行对比,3种方法均有效检测出了7幅场景中的真实跑道,但是本文方法在7幅数据中总的虚警和漏警个数均为1,而两种对比算法中的虚警个数分别为2和11、漏警个数分别为8和1。结论本文方法不仅能有效检测出机场跑道区域,且检测效果更好,计算量较小,虚警和漏警率低,效率更高。关键词:极化合成孔径雷达(PolSAR)图像;机场跑道检测;局部二值模式(LBP)特征;支持向量机(SVM)分类;阈值分割92|760|0更新时间:2024-05-07

遥感图像处理

0