最新刊期

2021 年 第 26 卷 第 2 期

- 摘要:神经信息处理系统大会(Conference on Neural Information Processing Systems,NeurIPS)是机器学习领域的顶级会议,在中国计算机学会(China Computer Federation,CCF)推荐国际学术会议中被评为人工智能领域的A类会议,一直广受关注。NeurIPS 2020收到了创纪录的9 467篇投稿,最终录用1 898篇论文。收录的论文涵盖了人工智能的各种主题,包括深度学习及其应用、强化学习与规划、纯理论研究、概率方法、优化及机器学习与社会等。本文回顾了NeurIPS 2020的亮点及论文录用情况,详细解读了特邀报告、最佳论文、口头报告及部分海报论文,希望能帮助读者快速了解NeurIPS 2020的盛况。关键词:人工智能;机器学习;深度学习;强化学习;理论;优化;学术会议;NeurIPS 202068|57|0更新时间:2024-05-07

前沿进展

-

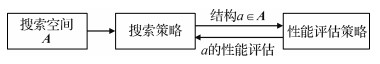

摘要:深度神经网络在图像识别、语言识别和机器翻译等人工智能任务中取得了巨大进展,很大程度上归功于优秀的神经网络结构设计。神经网络大都由手工设计,需要专业的机器学习知识以及大量的试错。为此,自动化的神经网络结构搜索成为研究热点。神经网络结构搜索(neural architecture search,NAS)主要由搜索空间、搜索策略与性能评估方法3部分组成。在搜索空间设计上,出于计算量的考虑,通常不会搜索整个网络结构,而是先将网络分成几块,然后搜索块中的结构。根据实际情况的不同,可以共享不同块中的结构,也可以对每个块单独搜索不同的结构。在搜索策略上,主流的优化方法包含强化学习、进化算法、贝叶斯优化和基于梯度的优化等。在性能评估上,为了节省计算时间,通常不会将每一个网络都充分训练到收敛,而是通过权值共享、早停等方法尽可能减小单个网络的训练时间。与手工设计的网络相比,神经网络结构搜索得到的深度神经网络具有更好的性能。在ImageNet分类任务上,与手工设计的MobileNetV2相比,通过神经网络结构搜索得到的MobileNetV3减少了近30%的计算量,并且top-1分类精度提升了3.2%;在Cityscapes语义分割任务上,与手工设计的DeepLabv3+相比,通过神经网络结构搜索得到的Auto-DeepLab-L可以在没有ImageNet预训练的情况下,达到比DeepLabv3+更高的平均交并比(mean intersection over union,mIOU),同时减小一半以上的计算量。神经网络结构搜索得到的深度神经网络通常比手工设计的神经网络有着更好的表现,是未来神经网络设计的发展趋势。关键词:人工智能;计算机视觉;深度神经网络;强化学习;进化算法;神经网络结构搜索(NAS)39|73|3更新时间:2024-05-07

摘要:深度神经网络在图像识别、语言识别和机器翻译等人工智能任务中取得了巨大进展,很大程度上归功于优秀的神经网络结构设计。神经网络大都由手工设计,需要专业的机器学习知识以及大量的试错。为此,自动化的神经网络结构搜索成为研究热点。神经网络结构搜索(neural architecture search,NAS)主要由搜索空间、搜索策略与性能评估方法3部分组成。在搜索空间设计上,出于计算量的考虑,通常不会搜索整个网络结构,而是先将网络分成几块,然后搜索块中的结构。根据实际情况的不同,可以共享不同块中的结构,也可以对每个块单独搜索不同的结构。在搜索策略上,主流的优化方法包含强化学习、进化算法、贝叶斯优化和基于梯度的优化等。在性能评估上,为了节省计算时间,通常不会将每一个网络都充分训练到收敛,而是通过权值共享、早停等方法尽可能减小单个网络的训练时间。与手工设计的网络相比,神经网络结构搜索得到的深度神经网络具有更好的性能。在ImageNet分类任务上,与手工设计的MobileNetV2相比,通过神经网络结构搜索得到的MobileNetV3减少了近30%的计算量,并且top-1分类精度提升了3.2%;在Cityscapes语义分割任务上,与手工设计的DeepLabv3+相比,通过神经网络结构搜索得到的Auto-DeepLab-L可以在没有ImageNet预训练的情况下,达到比DeepLabv3+更高的平均交并比(mean intersection over union,mIOU),同时减小一半以上的计算量。神经网络结构搜索得到的深度神经网络通常比手工设计的神经网络有着更好的表现,是未来神经网络设计的发展趋势。关键词:人工智能;计算机视觉;深度神经网络;强化学习;进化算法;神经网络结构搜索(NAS)39|73|3更新时间:2024-05-07 -

摘要:图像质量评价一直是图像处理和计算机视觉领域的一个基础问题,图像质量评价模型也广泛应用于图像/视频编码、超分辨率重建和图像/视频视觉质量增强等相关领域。图像质量评价主要包括全参考图像质量评价、半参考图像质量评价和无参考图像质量评价。全参考图像质量评价和半参考图像质量评价分别指预测图像质量时参考信息完全可用和部分可用,而无参考图像质量评价是指预测图像质量时参考信息不可用。虽然全参考和半参考图像质量评价模型较为可靠,但在计算过程中必须依赖参考信息,使得应用场景极为受限。无参考图像质量评价模型因不需要依赖参考信息而有较强的适用性,一直都是图像质量评价领域研究的热点。本文主要概述2012—2020年国内外公开发表的无参考图像质量评价模型,根据模型训练过程中是否需要用到主观分数,将无参考图像质量评价模型分为有监督学习和无监督学习的无参考图像质量评价模型。同时,每类模型分成基于传统机器学习算法的模型和基于深度学习算法的模型。对基于传统机器学习算法的模型,重点介绍相应的特征提取策略及思想;对基于深度学习算法的模型,重点介绍设计思路。此外,本文介绍了图像质量评价在新媒体数据中的研究工作及图像质量评价的应用。最后对介绍的无参考图像质量评价模型进行总结,并指出未来可能的发展方向。关键词:图像质量评价;人类视觉系统;视觉感知;自然统计特征;机器学习;深度学习257|1276|19更新时间:2024-05-07

摘要:图像质量评价一直是图像处理和计算机视觉领域的一个基础问题,图像质量评价模型也广泛应用于图像/视频编码、超分辨率重建和图像/视频视觉质量增强等相关领域。图像质量评价主要包括全参考图像质量评价、半参考图像质量评价和无参考图像质量评价。全参考图像质量评价和半参考图像质量评价分别指预测图像质量时参考信息完全可用和部分可用,而无参考图像质量评价是指预测图像质量时参考信息不可用。虽然全参考和半参考图像质量评价模型较为可靠,但在计算过程中必须依赖参考信息,使得应用场景极为受限。无参考图像质量评价模型因不需要依赖参考信息而有较强的适用性,一直都是图像质量评价领域研究的热点。本文主要概述2012—2020年国内外公开发表的无参考图像质量评价模型,根据模型训练过程中是否需要用到主观分数,将无参考图像质量评价模型分为有监督学习和无监督学习的无参考图像质量评价模型。同时,每类模型分成基于传统机器学习算法的模型和基于深度学习算法的模型。对基于传统机器学习算法的模型,重点介绍相应的特征提取策略及思想;对基于深度学习算法的模型,重点介绍设计思路。此外,本文介绍了图像质量评价在新媒体数据中的研究工作及图像质量评价的应用。最后对介绍的无参考图像质量评价模型进行总结,并指出未来可能的发展方向。关键词:图像质量评价;人类视觉系统;视觉感知;自然统计特征;机器学习;深度学习257|1276|19更新时间:2024-05-07 -

摘要:铁路作为国家重要基础设施、国民经济大动脉和大众化运输方式,对社会经济发展起着不可替代的支撑作用。轨道是铁路系统的重要组件,轨道病害检测是铁路工务部门的核心业务。传统的人工巡检不仅费时费力,而且检测结果容易受到各种主观因素的影响。因此,自动化轨道病害检测对维护铁路运输安全具有重要的现实意义。考虑到视觉检测在速度、成本和可视化等方面的优势,本文聚焦于轨道病害视觉检测技术。首先以广泛应用的无砟轨道为例介绍轨道的基本结构,对常见的轨道表观病害进行样例展示、成因分析和影响评价;简要梳理常见的自动化轨道检测技术的基本原理和应用场景,对轨道病害视觉检测面临的图像质量不均、可用特征较少和模型更新困难等主要挑战进行归纳;然后,依照前景模型、背景模型、盲源分离模型及深度学习模型的分类逻辑对轨道病害视觉检测领域的研究现状进行综述,简要介绍了各类方法的代表性工作,总结了各类方法的技术特点与应用局限性;最后,针对智能化铁路的发展需求,展望了未来轨道病害视觉检测技术的研究趋势,即利用小样本/零样本学习、多任务学习与多源异构数据融合等技术手段来解决当前视觉检测系统中的鲁棒性弱、虚警率高等问题。关键词:轨道病害;视觉检测;前景;背景;盲源分离;深度学习443|787|2更新时间:2024-05-07

摘要:铁路作为国家重要基础设施、国民经济大动脉和大众化运输方式,对社会经济发展起着不可替代的支撑作用。轨道是铁路系统的重要组件,轨道病害检测是铁路工务部门的核心业务。传统的人工巡检不仅费时费力,而且检测结果容易受到各种主观因素的影响。因此,自动化轨道病害检测对维护铁路运输安全具有重要的现实意义。考虑到视觉检测在速度、成本和可视化等方面的优势,本文聚焦于轨道病害视觉检测技术。首先以广泛应用的无砟轨道为例介绍轨道的基本结构,对常见的轨道表观病害进行样例展示、成因分析和影响评价;简要梳理常见的自动化轨道检测技术的基本原理和应用场景,对轨道病害视觉检测面临的图像质量不均、可用特征较少和模型更新困难等主要挑战进行归纳;然后,依照前景模型、背景模型、盲源分离模型及深度学习模型的分类逻辑对轨道病害视觉检测领域的研究现状进行综述,简要介绍了各类方法的代表性工作,总结了各类方法的技术特点与应用局限性;最后,针对智能化铁路的发展需求,展望了未来轨道病害视觉检测技术的研究趋势,即利用小样本/零样本学习、多任务学习与多源异构数据融合等技术手段来解决当前视觉检测系统中的鲁棒性弱、虚警率高等问题。关键词:轨道病害;视觉检测;前景;背景;盲源分离;深度学习443|787|2更新时间:2024-05-07 - 摘要:现有卷积神经网络(convolutional neural network,CNN)利用卷积层和激活函数的叠加,构建复杂非线性函数拟合输入数据到输出标签的转换关系,这种端到端的学习方式严重影响了CNN特征图与先验知识的融合,导致其对训练样本数量和质量敏感,同时增加了CNN特征图可解释性难度。本文从深度学习建模方式角度出发,以遥感图像特征表达及其可解释性为切入点,搭建传统遥感图像先验知识与CNN的桥梁,分析阐述了黎曼流形特征空间(Riemannian manifold feature space,RMFS)对CNN可解释性、特征演化规律等方面的促进作用;提出融合CNN与RMFS构建RMFS-CNN遥感图像分类新框架,以RMFS为特征过渡平台,一方面利用其线性特征分布规律降低CNN对传统图像特征的学习难度,另一方面定义能够突显图像先验知识的表达范式,提高CNN对可解释性特征的学习能力,以达到利用RMFS对先验知识(特征)表达的优异性能提高CNN遥感图像分类特征利用效率的目的;以RMFS特征表达范式为基础定义控制CNN特征学习偏好的损失函数,进而发展具有良好特征解释性的CNN分类模型及可控的模型训练方法;最后指出构建RMFS-CNN分类框架的可行性及该框架对遥感图像分类和深度学习理论发展方面的理论贡献与应用价值。关键词:遥感图像分类;深度学习;卷积神经网络;黎曼流形特征空间;特征表达;特征定制;模型训练219|150|3更新时间:2024-05-07

学者观点

- 摘要:利用深度学习方法对医学影像数据进行处理分析,极大地促进了精准医疗和个性化医疗的快速发展。深度学习在医学图像领域的应用较为广泛,具有多病种、多模态、多组学和多功能的特点。为便于对深度学习在医学图像处理领域的应用进行更深入有效的探索,本文系统综述了相关研究进展。首先,从深度学习在影像基因组学中的应用出发,理清了深度学习在医学影像领域应用的一般思路和现状,将医学影像领域分为智能诊断、疗效评估和预测预后等3个模块,并对模块内的各病种进行总结,展示了深度学习各算法的优缺点及面临的问题和挑战。其次,对深度学习中出现的新思路、新方法以及对传统方法的改进进行了阐述。最后,总结了该领域现阶段面临的问题,并对未来的研究方向做出了展望。基于深度学习的医学图像智能处理与分析虽然取得了一些有价值的研究成果,但还需要根据临床的实际需求,将深度学习与经典的机器学习算法及无创并且高效的多组学数据结合起来,对深度学习的理论和方法进行深入研究。关键词:医学图像处理;人工智能;深度学习;影像基因组学;精准医疗383|175|7更新时间:2024-05-07

-

摘要:黑烟车辆逐渐成为城市的主要污染源之一,针对黑烟的视频车辆检测方法具有效果好、成本低、应用面广和不妨碍交通等优点,但是仍存在误检率高、新方法可解释性差的缺陷。为了总结归纳视频黑烟检测算法的研究进展,本文对2016—2019年公开发表的文献进行总结。视频黑烟检测框架按顺序可以分为监控视频预处理、疑似黑烟区域选取、黑烟特征选取、分类识别和算法性能分析几部分,而且此顺序可以根据实际情况微调。本文介绍了视频黑烟检测框架,从层次的角度分析了疑似黑烟区域提取和黑烟特征选取。疑似黑烟区域提取方法由低到高依次分为图像级提取、目标级提取、像素级提取和纯黑烟重构等4个层次,提取方法的精细度与稳定性逐步上升,而且高层次方法一般可以应用在低层次方法的结果上。黑烟特征按基于学习的非线性映射次数划分为底层特征、中层特征和高层特征等3个层次,分界点是1次和3次。随着层次的提高,特征表达力就会越强,但二者之间并不是严格的线性关系。然后从可解释性的角度重点介绍了高层特征。另外,本文从有、无深度学习的角度归纳了特征提取算法,之后从传统方法与深度方法两方面归纳了常见的分类识别方法。最后介绍了主流算法评价指标。针对视频黑烟检测算法的几个特点,对其未来发展方向进行了总结归纳。关键词:黑烟车辆检测;特征提取;烟雾识别;深度学习可解释性;综述84|233|0更新时间:2024-05-07

摘要:黑烟车辆逐渐成为城市的主要污染源之一,针对黑烟的视频车辆检测方法具有效果好、成本低、应用面广和不妨碍交通等优点,但是仍存在误检率高、新方法可解释性差的缺陷。为了总结归纳视频黑烟检测算法的研究进展,本文对2016—2019年公开发表的文献进行总结。视频黑烟检测框架按顺序可以分为监控视频预处理、疑似黑烟区域选取、黑烟特征选取、分类识别和算法性能分析几部分,而且此顺序可以根据实际情况微调。本文介绍了视频黑烟检测框架,从层次的角度分析了疑似黑烟区域提取和黑烟特征选取。疑似黑烟区域提取方法由低到高依次分为图像级提取、目标级提取、像素级提取和纯黑烟重构等4个层次,提取方法的精细度与稳定性逐步上升,而且高层次方法一般可以应用在低层次方法的结果上。黑烟特征按基于学习的非线性映射次数划分为底层特征、中层特征和高层特征等3个层次,分界点是1次和3次。随着层次的提高,特征表达力就会越强,但二者之间并不是严格的线性关系。然后从可解释性的角度重点介绍了高层特征。另外,本文从有、无深度学习的角度归纳了特征提取算法,之后从传统方法与深度方法两方面归纳了常见的分类识别方法。最后介绍了主流算法评价指标。针对视频黑烟检测算法的几个特点,对其未来发展方向进行了总结归纳。关键词:黑烟车辆检测;特征提取;烟雾识别;深度学习可解释性;综述84|233|0更新时间:2024-05-07 -

摘要:刚体目标姿态作为计算机视觉技术的重点研究方向之一,旨在确定场景中3维目标的位置平移和方位旋转等多个自由度,越来越多地应用在工业机械臂操控、空间在轨服务、自动驾驶和现实增强等领域。本文对基于单幅图像的刚体目标姿态过程、方法分类及其现存问题进行了整体综述。通过利用单幅刚体目标图像实现多自由度姿态估计的各类方法进行总结、分类及比较,重点论述了姿态估计的一般过程、估计方法的演进和划分、常用数据集及评估准则、研究现状与展望。目前,多自由度刚体目标姿态估计方法主要针对单一特定应用场景具有较好的效果,还没有通用于复合场景的方法,且现有方法在面对多种光照条件、杂乱遮挡场景、旋转对称和类间相似性目标时,估计精度和效率下降显著。结合现存问题及当前深度学习技术的助推影响,从场景级多目标推理、自监督学习方法、前端检测网络、轻量高效的网络设计、多信息融合姿态估计框架和图像数据表征空间等6个方面对该领域的发展趋势进行预测和展望。关键词:计算机视觉;单幅图像;刚体目标;姿态估计;深度学习127|787|4更新时间:2024-05-07

摘要:刚体目标姿态作为计算机视觉技术的重点研究方向之一,旨在确定场景中3维目标的位置平移和方位旋转等多个自由度,越来越多地应用在工业机械臂操控、空间在轨服务、自动驾驶和现实增强等领域。本文对基于单幅图像的刚体目标姿态过程、方法分类及其现存问题进行了整体综述。通过利用单幅刚体目标图像实现多自由度姿态估计的各类方法进行总结、分类及比较,重点论述了姿态估计的一般过程、估计方法的演进和划分、常用数据集及评估准则、研究现状与展望。目前,多自由度刚体目标姿态估计方法主要针对单一特定应用场景具有较好的效果,还没有通用于复合场景的方法,且现有方法在面对多种光照条件、杂乱遮挡场景、旋转对称和类间相似性目标时,估计精度和效率下降显著。结合现存问题及当前深度学习技术的助推影响,从场景级多目标推理、自监督学习方法、前端检测网络、轻量高效的网络设计、多信息融合姿态估计框架和图像数据表征空间等6个方面对该领域的发展趋势进行预测和展望。关键词:计算机视觉;单幅图像;刚体目标;姿态估计;深度学习127|787|4更新时间:2024-05-07 -

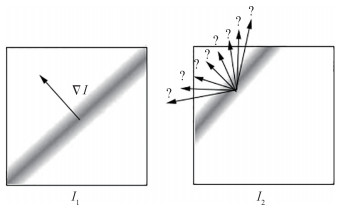

摘要:对流体图像序列进行运动分析一直是流体力学、医学和计算机视觉等领域的重要研究课题。从图像对中提取的密集精确的速度矢量场能够为许多领域提供有价值的信息,基于光流法的流体运动估计技术因其独特的优势成为一个有前途的方向。光流法可以获得具有较高分辨率的密集速度矢量场,在小尺度精细结构的测量上有所改进,弥补了基于相关分析法的粒子图像测速技术的不足。此外,光流方法还可以方便的引入各种物理约束,获得较为符合流体运动特性的运动估计结果。为了全面反映基于光流法的流体运动估计算法的研究进展,本文在广泛调研相关文献的基础上,对国内外具有代表性的论文进行了系统阐述。首先介绍了光流法的基本原理,然后将现有算法按照要解决的突出问题进行分类:结合流体力学知识的能量最小化函数,提高对光照变化的鲁棒性,大位移估计和消除异常值。对每类方法,从问题解决过程的角度予以介绍,分析了各类突出问题中现有算法的特点和局限性。最后,总结分析了流体运动估计技术当前面临的问题和挑战,并对未来基于光流法的运动估计算法的研究方向和研究重点进行了展望。关键词:流体运动估计;光流法;流体力学;光照变化;大位移估计;异常值检测101|163|8更新时间:2024-05-07

摘要:对流体图像序列进行运动分析一直是流体力学、医学和计算机视觉等领域的重要研究课题。从图像对中提取的密集精确的速度矢量场能够为许多领域提供有价值的信息,基于光流法的流体运动估计技术因其独特的优势成为一个有前途的方向。光流法可以获得具有较高分辨率的密集速度矢量场,在小尺度精细结构的测量上有所改进,弥补了基于相关分析法的粒子图像测速技术的不足。此外,光流方法还可以方便的引入各种物理约束,获得较为符合流体运动特性的运动估计结果。为了全面反映基于光流法的流体运动估计算法的研究进展,本文在广泛调研相关文献的基础上,对国内外具有代表性的论文进行了系统阐述。首先介绍了光流法的基本原理,然后将现有算法按照要解决的突出问题进行分类:结合流体力学知识的能量最小化函数,提高对光照变化的鲁棒性,大位移估计和消除异常值。对每类方法,从问题解决过程的角度予以介绍,分析了各类突出问题中现有算法的特点和局限性。最后,总结分析了流体运动估计技术当前面临的问题和挑战,并对未来基于光流法的运动估计算法的研究方向和研究重点进行了展望。关键词:流体运动估计;光流法;流体力学;光照变化;大位移估计;异常值检测101|163|8更新时间:2024-05-07

综述

-

摘要:目的随着云计算和移动互联网技术的飞速发展,屏幕图像编码已成为视频压缩领域新的研究热点。帧内块复制(intra block copy,IBC)算法是屏幕内容编码(screen content coding,SCC)中的核心算法,已经成为高效视频编码(high efficiency video coding,HEVC)等标准中屏幕内容编码的重要组成部分。为了进一步消除IBC算法中的位移矢量(displacement vector,DV)参数编码的冗余,根据DV参数具有的固有帧内块匹配特性和相关性,提出了一种DV参数编码算法。方法首先,对待编码DV采用邻近块与最近块相结合的DV预测编码方案,进一步提高DV的预测编码效率;然后,对预测编码效率不高的DV,提出了一种基于区域划分与调整的高效DV直接编码方案。对SCC标准测试数据集合中的17个测试数据集合的3种编码配置从编码效率和复杂度两方面进行了评测。结果实验结果表明,对于SCC标准测试数据集合中移动的文字和图形序列类别,在全帧内、随机接入和低延迟这3种有损编码配置下,提出的DV算法与HEVC SCC中的IBC算法相比,在编解码复杂度没有任何影响的前提下,Y分量的BD(Bjφntegaard Delta)-rate平均降低率分别为1.04%、0.87%和0.93%,全帧内配置下Y分量的BD-rate降低率可达2.99%。结论本文方法优于HEVC-SCC中的IBC算法中的DV编码算法,能有效提升编码效率。关键词:高效视频编码(HEVC);数字音视频编解码;屏幕内容编码;位移矢量;预测编码;直接编码105|183|0更新时间:2024-05-07

摘要:目的随着云计算和移动互联网技术的飞速发展,屏幕图像编码已成为视频压缩领域新的研究热点。帧内块复制(intra block copy,IBC)算法是屏幕内容编码(screen content coding,SCC)中的核心算法,已经成为高效视频编码(high efficiency video coding,HEVC)等标准中屏幕内容编码的重要组成部分。为了进一步消除IBC算法中的位移矢量(displacement vector,DV)参数编码的冗余,根据DV参数具有的固有帧内块匹配特性和相关性,提出了一种DV参数编码算法。方法首先,对待编码DV采用邻近块与最近块相结合的DV预测编码方案,进一步提高DV的预测编码效率;然后,对预测编码效率不高的DV,提出了一种基于区域划分与调整的高效DV直接编码方案。对SCC标准测试数据集合中的17个测试数据集合的3种编码配置从编码效率和复杂度两方面进行了评测。结果实验结果表明,对于SCC标准测试数据集合中移动的文字和图形序列类别,在全帧内、随机接入和低延迟这3种有损编码配置下,提出的DV算法与HEVC SCC中的IBC算法相比,在编解码复杂度没有任何影响的前提下,Y分量的BD(Bjφntegaard Delta)-rate平均降低率分别为1.04%、0.87%和0.93%,全帧内配置下Y分量的BD-rate降低率可达2.99%。结论本文方法优于HEVC-SCC中的IBC算法中的DV编码算法,能有效提升编码效率。关键词:高效视频编码(HEVC);数字音视频编解码;屏幕内容编码;位移矢量;预测编码;直接编码105|183|0更新时间:2024-05-07

图像处理和编码

-

摘要:目的 目标遮挡一直是限制跟踪算法精确度和稳定性的问题之一,针对该问题,提出一种抗遮挡的多层次重定位目标跟踪算法。 方法 通过平均峰值相关能量动态分配特征权重,将梯度特征与颜色直方图特征动态地结合起来进行目标跟踪。利用多峰值检测和峰值波动情况进行目标状态判定,若目标状态不理想,则停止模板更新,避免逐帧更新导致目标漂移,继续跟踪目标;若判定目标遮挡,则提取对应特征点,使用最邻近距离比进行特征匹配和筛选,丢弃负样本的最邻近样本作为二次筛选,利用广义霍夫变换进行第3次筛选并重定位目标,对目标继续跟踪。 结果 在标准数据集OTB(object tracking benchmark)100和LaSOT(large-scale single object tracking)上的实验结果显示,本文算法的精确率分别为0.885和0.301,相较于Staple算法分别提升了13.5%和30.3%。 结论 在目标发生遮挡的场景中,本文方法能够重定位目标并且继续跟踪,优化后的模板更新策略提高了算法速度。目标状态的判定有效估计了目标遮挡问题,可以及时采取应对策略,提高算法在复杂环境下的稳定性。关键词:目标跟踪;相关滤波;目标重定位;遮挡感知;特征提取47|105|0更新时间:2024-05-07

摘要:目的 目标遮挡一直是限制跟踪算法精确度和稳定性的问题之一,针对该问题,提出一种抗遮挡的多层次重定位目标跟踪算法。 方法 通过平均峰值相关能量动态分配特征权重,将梯度特征与颜色直方图特征动态地结合起来进行目标跟踪。利用多峰值检测和峰值波动情况进行目标状态判定,若目标状态不理想,则停止模板更新,避免逐帧更新导致目标漂移,继续跟踪目标;若判定目标遮挡,则提取对应特征点,使用最邻近距离比进行特征匹配和筛选,丢弃负样本的最邻近样本作为二次筛选,利用广义霍夫变换进行第3次筛选并重定位目标,对目标继续跟踪。 结果 在标准数据集OTB(object tracking benchmark)100和LaSOT(large-scale single object tracking)上的实验结果显示,本文算法的精确率分别为0.885和0.301,相较于Staple算法分别提升了13.5%和30.3%。 结论 在目标发生遮挡的场景中,本文方法能够重定位目标并且继续跟踪,优化后的模板更新策略提高了算法速度。目标状态的判定有效估计了目标遮挡问题,可以及时采取应对策略,提高算法在复杂环境下的稳定性。关键词:目标跟踪;相关滤波;目标重定位;遮挡感知;特征提取47|105|0更新时间:2024-05-07 -

摘要:目的 为了解决经典卷积神经网络无法满足图像中极小目标特征提取的准确性需求问题,本文基于DeepLabv3plus算法,在下采样过程中引入特征图切分模块,提出了DeepLabv3plus-IRCNet(IR为倒置残差(inverted residual,C为特征图切分(feature map cut))图像语义分割方法,支撑图像极小目标的特征提取。 方法 采用由普通卷积层和多个使用深度可分离卷积的倒置残差模块串联组成的深度卷积神经网络提取特征,当特征图分辨率降低到输入图像的1/16时,引入特征图切分模块,将各个切分特征图分别放大,通过参数共享的方式提取特征。然后,将每个输出的特征图进行对应位置拼接,与解码阶段放大到相同尺寸的特征图进行融合,提高模型对小目标物体特征的提取能力。 结果 本文方法引入特征图切分模块,提高了模型对小目标物体的关注,充分考虑了图像上下文信息,对多个尺度下的各个中间层特征进行融合,提高了图像分割精度。为验证方法的有效性,使用CamVid(Cambridge-driving labeled video database)数据集对提出的方法进行验证,平均交并比(mean intersection over union,mIoU)相对于DeepLabv3plus模型有所提升。验证结果表明了本文方法的有效性。 结论 本文方法充分考虑了图像分割中小目标物体的关注度,提出的DeepLabv3plus-IRCNet模型提升了图像分割精度。关键词:空洞卷积;深度可分离卷积;特征图切分;特征提取网络;特征融合83|181|6更新时间:2024-05-07

摘要:目的 为了解决经典卷积神经网络无法满足图像中极小目标特征提取的准确性需求问题,本文基于DeepLabv3plus算法,在下采样过程中引入特征图切分模块,提出了DeepLabv3plus-IRCNet(IR为倒置残差(inverted residual,C为特征图切分(feature map cut))图像语义分割方法,支撑图像极小目标的特征提取。 方法 采用由普通卷积层和多个使用深度可分离卷积的倒置残差模块串联组成的深度卷积神经网络提取特征,当特征图分辨率降低到输入图像的1/16时,引入特征图切分模块,将各个切分特征图分别放大,通过参数共享的方式提取特征。然后,将每个输出的特征图进行对应位置拼接,与解码阶段放大到相同尺寸的特征图进行融合,提高模型对小目标物体特征的提取能力。 结果 本文方法引入特征图切分模块,提高了模型对小目标物体的关注,充分考虑了图像上下文信息,对多个尺度下的各个中间层特征进行融合,提高了图像分割精度。为验证方法的有效性,使用CamVid(Cambridge-driving labeled video database)数据集对提出的方法进行验证,平均交并比(mean intersection over union,mIoU)相对于DeepLabv3plus模型有所提升。验证结果表明了本文方法的有效性。 结论 本文方法充分考虑了图像分割中小目标物体的关注度,提出的DeepLabv3plus-IRCNet模型提升了图像分割精度。关键词:空洞卷积;深度可分离卷积;特征图切分;特征提取网络;特征融合83|181|6更新时间:2024-05-07 -

摘要:目的少数民族服装款式结构复杂,视觉风格各异。由于缺少民族服装语义标签、局部特征繁杂以及语义标签之间存在相互干扰等因素导致少数民族服装图像解析准确率和精度较低。因此,本文提出了一种融合视觉风格和标签约束的少数民族服装图像解析方法。方法首先基于本文构建的包含55个少数民族的服装图像数据集,按照基本款式结构、着装区域、配饰和不同视觉风格自定义少数民族服装的通用语义标签和民族语义标签,同时设置4组标注对,共8个标注点;然后,结合自定义语义标签和带有标注对的训练图像,在深度完全卷积神经网络SegNet中加入视觉风格以融合局部特征和全局特征,并引入属性预测、风格预测和三元组损失函数对输入的待解析图像进行初步解析;最后,通过构建的标签约束网络进一步优化初步解析结果,避免标签相互干扰,得到优化后的最终解析结果。结果在构建的少数民族服装图像数据集上进行验证,实验结果表明,标注对有效提升了局部特征的检测准确率,构建的视觉风格网络能够有效融合少数民族服装的全局特征和局部特征,标签约束网络解决了标签之间相互干扰的问题,在结合视觉风格网络和标签约束网络后,能够明显提升少数民族服装解析的平均精度,像素准确度达到了90.54%。结论本文提出的融合视觉风格和标签约束的少数民族服装图像解析方法,能够提高少数民族服装图像解析的准确率和精度,对传承祖国文化、保护非物质文化遗产具有很好的意义。关键词:少数民族服装;图像解析;语义标签;视觉风格;标签约束72|311|0更新时间:2024-05-07

摘要:目的少数民族服装款式结构复杂,视觉风格各异。由于缺少民族服装语义标签、局部特征繁杂以及语义标签之间存在相互干扰等因素导致少数民族服装图像解析准确率和精度较低。因此,本文提出了一种融合视觉风格和标签约束的少数民族服装图像解析方法。方法首先基于本文构建的包含55个少数民族的服装图像数据集,按照基本款式结构、着装区域、配饰和不同视觉风格自定义少数民族服装的通用语义标签和民族语义标签,同时设置4组标注对,共8个标注点;然后,结合自定义语义标签和带有标注对的训练图像,在深度完全卷积神经网络SegNet中加入视觉风格以融合局部特征和全局特征,并引入属性预测、风格预测和三元组损失函数对输入的待解析图像进行初步解析;最后,通过构建的标签约束网络进一步优化初步解析结果,避免标签相互干扰,得到优化后的最终解析结果。结果在构建的少数民族服装图像数据集上进行验证,实验结果表明,标注对有效提升了局部特征的检测准确率,构建的视觉风格网络能够有效融合少数民族服装的全局特征和局部特征,标签约束网络解决了标签之间相互干扰的问题,在结合视觉风格网络和标签约束网络后,能够明显提升少数民族服装解析的平均精度,像素准确度达到了90.54%。结论本文提出的融合视觉风格和标签约束的少数民族服装图像解析方法,能够提高少数民族服装图像解析的准确率和精度,对传承祖国文化、保护非物质文化遗产具有很好的意义。关键词:少数民族服装;图像解析;语义标签;视觉风格;标签约束72|311|0更新时间:2024-05-07 -

摘要:目的区域推荐网络(region proposal network,RPN)与孪生网络(Siamese)相结合进行视频目标跟踪,显示了较高的准确性。然而,孪生RPN网络(Siamese region proposal network,SiamRPN)目标跟踪器依赖于密集的锚框策略,会产生大量冗余的锚框并影响跟踪的精度和速度。为了解决该问题,本文提出了孪生导向锚框RPN网络(Siamese-guided anchor RPN,Siamese GA-RPN)。方法Siamese GA-RPN的主要思想是利用语义特征来指导锚框生成。其中导向锚框网络包括位置预测模块和形状预测模块,这两个模块分别利用孪生网络中CNN(convolutional neural network)产生的语义特征预测锚框的位置和长宽尺寸,减少了冗余锚框的产生。然后,进一步设计了特征自适应模块,利用每个锚框的形状信息,通过可变卷积层来修正跟踪目标的原始特征图,降低目标特征与锚框信息的不一致性,提高了目标跟踪的准确性。结果在3个具有挑战性的视频跟踪基准数据集VOT(video object tracking)2015、VOT2016和VOT2017上进行了跟踪实验,测试了算法在目标快速移动、遮挡和光照等复杂场景下的跟踪性能,并与多种优秀算法在准确性和鲁棒性两个评价指标上进行定量比较。在VOT2015数据集上,本文算法与孪生RPN网络相比,准确性提高了1.72%,鲁棒性提高了5.17%;在VOT2016数据集上,本文算法与孪生RPN网络相比,准确性提高了3.6%,鲁棒性提高了6.6%;在VOT2017数据集上进行实时实验,本文算法表现出了较好的实时跟踪效果。结论通过孪生导向锚框RPN网络提高了锚框生成的有效性,确保了特征与锚框的一致性,实现了对目标的精确定位,较好地解决了锚框尺寸对目标跟踪精度的影响。在目标尺度发生变化、遮挡、光照条件变化和目标快速运动等复杂场景下仍然表现出了较强的鲁棒性和适应性。关键词:目标跟踪;孪生网络;RPN网络;导向锚框;特征适应26|24|4更新时间:2024-05-07

摘要:目的区域推荐网络(region proposal network,RPN)与孪生网络(Siamese)相结合进行视频目标跟踪,显示了较高的准确性。然而,孪生RPN网络(Siamese region proposal network,SiamRPN)目标跟踪器依赖于密集的锚框策略,会产生大量冗余的锚框并影响跟踪的精度和速度。为了解决该问题,本文提出了孪生导向锚框RPN网络(Siamese-guided anchor RPN,Siamese GA-RPN)。方法Siamese GA-RPN的主要思想是利用语义特征来指导锚框生成。其中导向锚框网络包括位置预测模块和形状预测模块,这两个模块分别利用孪生网络中CNN(convolutional neural network)产生的语义特征预测锚框的位置和长宽尺寸,减少了冗余锚框的产生。然后,进一步设计了特征自适应模块,利用每个锚框的形状信息,通过可变卷积层来修正跟踪目标的原始特征图,降低目标特征与锚框信息的不一致性,提高了目标跟踪的准确性。结果在3个具有挑战性的视频跟踪基准数据集VOT(video object tracking)2015、VOT2016和VOT2017上进行了跟踪实验,测试了算法在目标快速移动、遮挡和光照等复杂场景下的跟踪性能,并与多种优秀算法在准确性和鲁棒性两个评价指标上进行定量比较。在VOT2015数据集上,本文算法与孪生RPN网络相比,准确性提高了1.72%,鲁棒性提高了5.17%;在VOT2016数据集上,本文算法与孪生RPN网络相比,准确性提高了3.6%,鲁棒性提高了6.6%;在VOT2017数据集上进行实时实验,本文算法表现出了较好的实时跟踪效果。结论通过孪生导向锚框RPN网络提高了锚框生成的有效性,确保了特征与锚框的一致性,实现了对目标的精确定位,较好地解决了锚框尺寸对目标跟踪精度的影响。在目标尺度发生变化、遮挡、光照条件变化和目标快速运动等复杂场景下仍然表现出了较强的鲁棒性和适应性。关键词:目标跟踪;孪生网络;RPN网络;导向锚框;特征适应26|24|4更新时间:2024-05-07 -

摘要:目的行人检测是指使用矩形框和置信度找出图像或者视频中的所有行人。传统的图像行人检测方法对于姿态各异或者相互遮挡的行人无能为力。深度神经网络(deep neural networks,DNN)在目标检测领域表现出色,然而依然难以解决行人检测中一些问题。本文提出一种融合密度和精细分数的行人检测方法DC-CSP(density map and classifier modules with center and scale prediction)。方法首先,在CSP(center and scale prediction)网络的基础上添加密度图模块(density map module,DMM)和分类器模块(classifier module,CM),得到DC-CSP网络;然后,针对置信度不精确问题,利用不同模块对分数预测结果的互补性质,设计阶段分数融合(stage score fusion,SSF)规则对检测分数进行更新,使得行人置信度上升、背景置信度下降;最后,基于NMS(non-maximum suppression),利用估计的行人密度图,设计改进的自适应NMS(improved adaptive NMS,IAN)后处理方法,能够进一步改善检测结果,对相互遮挡行人提高交并比(intersection over union,IOU)阈值从而减少漏检,对单个行人降低IOU阈值从而减少错检。结果在公开数据集Citypersons和Caltech上进行定量和定性分析。定量分析中,与其他方法相比,本文方法在Citypersons数据集的Reasonable、Heavy、Partial以及Bare子集上,对数平均漏检率分别下降了0.8%、1.3%、1.0%和0.8%,在Caltech数据集的Reasonable和All子集上分别下降了0.3%和0.7%;在定性分析中,可视化结果表明,本文方法在一定程度上解决了各种不同场景下存在的相互遮挡行人漏检、单个行人错检以及置信度不精确等一系列问题。此外,消融实验证明了所设计模块及其对应规则的有效性。结论本文方法使用联合多个模块的卷积神经网络(convolutional neural network,CNN),针对密度特征、分类特征分别设计IAN方法和SSF规则,在一定程度上解决了相互遮挡行人漏检、单个行人错检以及置信度不精确的问题,在多个数据集上证明了方法的有效性和鲁棒性。关键词:城市场景;行人检测;卷积神经网络(CNN);密度图;分数融合;自适应后处理63|96|2更新时间:2024-05-07

摘要:目的行人检测是指使用矩形框和置信度找出图像或者视频中的所有行人。传统的图像行人检测方法对于姿态各异或者相互遮挡的行人无能为力。深度神经网络(deep neural networks,DNN)在目标检测领域表现出色,然而依然难以解决行人检测中一些问题。本文提出一种融合密度和精细分数的行人检测方法DC-CSP(density map and classifier modules with center and scale prediction)。方法首先,在CSP(center and scale prediction)网络的基础上添加密度图模块(density map module,DMM)和分类器模块(classifier module,CM),得到DC-CSP网络;然后,针对置信度不精确问题,利用不同模块对分数预测结果的互补性质,设计阶段分数融合(stage score fusion,SSF)规则对检测分数进行更新,使得行人置信度上升、背景置信度下降;最后,基于NMS(non-maximum suppression),利用估计的行人密度图,设计改进的自适应NMS(improved adaptive NMS,IAN)后处理方法,能够进一步改善检测结果,对相互遮挡行人提高交并比(intersection over union,IOU)阈值从而减少漏检,对单个行人降低IOU阈值从而减少错检。结果在公开数据集Citypersons和Caltech上进行定量和定性分析。定量分析中,与其他方法相比,本文方法在Citypersons数据集的Reasonable、Heavy、Partial以及Bare子集上,对数平均漏检率分别下降了0.8%、1.3%、1.0%和0.8%,在Caltech数据集的Reasonable和All子集上分别下降了0.3%和0.7%;在定性分析中,可视化结果表明,本文方法在一定程度上解决了各种不同场景下存在的相互遮挡行人漏检、单个行人错检以及置信度不精确等一系列问题。此外,消融实验证明了所设计模块及其对应规则的有效性。结论本文方法使用联合多个模块的卷积神经网络(convolutional neural network,CNN),针对密度特征、分类特征分别设计IAN方法和SSF规则,在一定程度上解决了相互遮挡行人漏检、单个行人错检以及置信度不精确的问题,在多个数据集上证明了方法的有效性和鲁棒性。关键词:城市场景;行人检测;卷积神经网络(CNN);密度图;分数融合;自适应后处理63|96|2更新时间:2024-05-07

图像分析和识别

-

摘要:目的立体匹配是计算机双目视觉的重要研究方向,主要分为全局匹配算法与局部匹配算法两类。传统的局部立体匹配算法计算复杂度低,可以满足实时性的需要,但是未能充分利用图像的边缘纹理信息,因此在非遮挡、视差不连续区域的匹配精度欠佳。为此,提出了融合边缘保持与改进代价聚合的立体匹配。方法首先利用图像的边缘空间信息构建权重矩阵,与灰度差绝对值和梯度代价进行加权融合,形成新的代价计算方式,同时将边缘区域像素点的权重信息与引导滤波的正则化项相结合,并在多分辨率尺度的框架下进行代价聚合。所得结果经过视差计算,得到初始视差图,再通过左右一致性检测、加权中值滤波等视差优化步骤获得最终的视差图。结果在Middlebury立体匹配平台上进行实验,结果表明,融合边缘权重信息对边缘处像素点的代价量进行了更加有效地区分,能够提升算法在各区域的匹配精度。其中,未加入视差优化步骤的21组扩展图像对的平均误匹配率较改进前减少3.48%,峰值信噪比提升3.57 dB,在标准4幅图中venus上经过视差优化后非遮挡区域的误匹配率仅为0.18%。结论融合边缘保持的多尺度立体匹配算法有效提升了图像在边缘纹理处的匹配精度,进一步降低了非遮挡区域与视差不连续区域的误匹配率。关键词:计算机视觉;局部立体匹配;代价计算;边缘保持;引导滤波130|1098|6更新时间:2024-05-07

摘要:目的立体匹配是计算机双目视觉的重要研究方向,主要分为全局匹配算法与局部匹配算法两类。传统的局部立体匹配算法计算复杂度低,可以满足实时性的需要,但是未能充分利用图像的边缘纹理信息,因此在非遮挡、视差不连续区域的匹配精度欠佳。为此,提出了融合边缘保持与改进代价聚合的立体匹配。方法首先利用图像的边缘空间信息构建权重矩阵,与灰度差绝对值和梯度代价进行加权融合,形成新的代价计算方式,同时将边缘区域像素点的权重信息与引导滤波的正则化项相结合,并在多分辨率尺度的框架下进行代价聚合。所得结果经过视差计算,得到初始视差图,再通过左右一致性检测、加权中值滤波等视差优化步骤获得最终的视差图。结果在Middlebury立体匹配平台上进行实验,结果表明,融合边缘权重信息对边缘处像素点的代价量进行了更加有效地区分,能够提升算法在各区域的匹配精度。其中,未加入视差优化步骤的21组扩展图像对的平均误匹配率较改进前减少3.48%,峰值信噪比提升3.57 dB,在标准4幅图中venus上经过视差优化后非遮挡区域的误匹配率仅为0.18%。结论融合边缘保持的多尺度立体匹配算法有效提升了图像在边缘纹理处的匹配精度,进一步降低了非遮挡区域与视差不连续区域的误匹配率。关键词:计算机视觉;局部立体匹配;代价计算;边缘保持;引导滤波130|1098|6更新时间:2024-05-07

图像理解和计算机视觉

-

摘要:目的针对现有神经网络模型需要对左心室心肌内膜和外膜单独建模的问题,本文提出了一种基于胶囊结构的心脏磁共振图像(magnetic resonance imaging,MRI)分割模型Seg-CapNet,旨在同时提取心肌内膜和外膜,并保证两者的空间位置关系。方法首先利用胶囊网络将待分割目标转换成包含目标相对位置、颜色以及大小等信息的向量,然后使用全连接将这些向量的空间关系进行重组,最后采用反卷积对特征图进行上采样,将分割图还原为输入图像尺寸。在上采样过程中将每层特征图与卷积层的特征图进行连接,有助于图像细节还原以及模型的反向传播,加快训练过程。Seg-CapNet的输出向量不仅有图像的灰度、纹理等底层图像特征,还包含目标的位置、大小等语义特征,有效提升了目标图像的分割精度。为了进一步提高分割质量,还提出了一种新的损失函数用于约束分割结果以保持多目标区域间的相对位置关系。结果在ACDC(automated cardiac diagnosis challenge)2017、MICCAI(medical image computing and computer-assisted intervention)2013和MICCAI2009等3个心脏MRI分割竞赛的公开数据集上对Seg-CapNet模型进行训练和验证,并与神经网络分割模型U-net和SegNet进行对比。实验结果表明,相对于U-Net和SegNet,Seg-CapNet同时分割目标重叠区域的平均Dice系数提升了3.5%,平均豪斯多夫距离(Hausdorff distance,HD)降低了18%。并且Seg-CapNet的参数量仅为U-Net的54%、SegNet的40%,在提升分割精度的同时,降低了训练时间和复杂度。结论本文提出的Seg-CapNet模型在保证同时分割重叠区域目标的同时,降低了参数量,提升了训练速度,并保持了较好的左心室心肌内膜和外膜分割精度。关键词:神经网络;胶囊网络;图像分割;重叠区域目标;心脏磁共振图像74|235|7更新时间:2024-05-07

摘要:目的针对现有神经网络模型需要对左心室心肌内膜和外膜单独建模的问题,本文提出了一种基于胶囊结构的心脏磁共振图像(magnetic resonance imaging,MRI)分割模型Seg-CapNet,旨在同时提取心肌内膜和外膜,并保证两者的空间位置关系。方法首先利用胶囊网络将待分割目标转换成包含目标相对位置、颜色以及大小等信息的向量,然后使用全连接将这些向量的空间关系进行重组,最后采用反卷积对特征图进行上采样,将分割图还原为输入图像尺寸。在上采样过程中将每层特征图与卷积层的特征图进行连接,有助于图像细节还原以及模型的反向传播,加快训练过程。Seg-CapNet的输出向量不仅有图像的灰度、纹理等底层图像特征,还包含目标的位置、大小等语义特征,有效提升了目标图像的分割精度。为了进一步提高分割质量,还提出了一种新的损失函数用于约束分割结果以保持多目标区域间的相对位置关系。结果在ACDC(automated cardiac diagnosis challenge)2017、MICCAI(medical image computing and computer-assisted intervention)2013和MICCAI2009等3个心脏MRI分割竞赛的公开数据集上对Seg-CapNet模型进行训练和验证,并与神经网络分割模型U-net和SegNet进行对比。实验结果表明,相对于U-Net和SegNet,Seg-CapNet同时分割目标重叠区域的平均Dice系数提升了3.5%,平均豪斯多夫距离(Hausdorff distance,HD)降低了18%。并且Seg-CapNet的参数量仅为U-Net的54%、SegNet的40%,在提升分割精度的同时,降低了训练时间和复杂度。结论本文提出的Seg-CapNet模型在保证同时分割重叠区域目标的同时,降低了参数量,提升了训练速度,并保持了较好的左心室心肌内膜和外膜分割精度。关键词:神经网络;胶囊网络;图像分割;重叠区域目标;心脏磁共振图像74|235|7更新时间:2024-05-07

医学图像处理

-

摘要:目的遥感图像中存在大小、形态不一的目标,增加了目标分割任务的困难性。感受野代表了特征图中每个像素对应输入图像的区域,若感受野与目标形状的契合度较高,则特征图中包含的目标特征更加完整,有利于分割。在现有的分割方法中,通常采用的是正方形的感受野,而遥感图像中目标形状多变,导致感受野无法较好地契合目标形状,在提取目标特征时会引入过多的无用特征,从而影响分割精度。为此,本文提出基于自适应感受野机制的遥感图像分割模型。方法在编码—解码网络结构的基础上,引入自适应感受野机制。首先在编码器上提取不同大小和宽高比的感受野特征,然后在特征融合时使用通道注意力模块自适应地获取通道权重,通过加权强化与目标形状契合度高的感受野的特征,弱化与目标形状契合度低的感受野的特征,在保留目标特征的同时减少背景特征的干扰,进而提升模型的分割精度。结果在Inria Aerial Image Labeling数据集与DeepGlobe Road Extraction数据集上进行实验并与相关方法比较,在两个数据集上的平均交并比分别为76.1%和61.9%,平均F1值分别为86.5%和76.5%。结论本文模型能够提取不同形状感受野的特征,并自适应地获取通道权重,使模型能提取更加完整的目标特征,从而提升目标分割效果。关键词:遥感图像;卷积神经网络(CNN);图像分割;自适应感受野机制(ARFM);通道注意力模块(CAM)56|54|4更新时间:2024-05-07

摘要:目的遥感图像中存在大小、形态不一的目标,增加了目标分割任务的困难性。感受野代表了特征图中每个像素对应输入图像的区域,若感受野与目标形状的契合度较高,则特征图中包含的目标特征更加完整,有利于分割。在现有的分割方法中,通常采用的是正方形的感受野,而遥感图像中目标形状多变,导致感受野无法较好地契合目标形状,在提取目标特征时会引入过多的无用特征,从而影响分割精度。为此,本文提出基于自适应感受野机制的遥感图像分割模型。方法在编码—解码网络结构的基础上,引入自适应感受野机制。首先在编码器上提取不同大小和宽高比的感受野特征,然后在特征融合时使用通道注意力模块自适应地获取通道权重,通过加权强化与目标形状契合度高的感受野的特征,弱化与目标形状契合度低的感受野的特征,在保留目标特征的同时减少背景特征的干扰,进而提升模型的分割精度。结果在Inria Aerial Image Labeling数据集与DeepGlobe Road Extraction数据集上进行实验并与相关方法比较,在两个数据集上的平均交并比分别为76.1%和61.9%,平均F1值分别为86.5%和76.5%。结论本文模型能够提取不同形状感受野的特征,并自适应地获取通道权重,使模型能提取更加完整的目标特征,从而提升目标分割效果。关键词:遥感图像;卷积神经网络(CNN);图像分割;自适应感受野机制(ARFM);通道注意力模块(CAM)56|54|4更新时间:2024-05-07

遥感图像处理

0