最新刊期

2021 年 第 26 卷 第 1 期

序言和编者按

-

摘要:随着汽车智能化程度的不断提高,智能汽车通过环境传感器与周边行驶环境的信息交互与互联更为密切,需应对的行驶环境状况也越来越复杂,包括行驶道路、周边交通和气象条件等诸多因素,具有较强的不确定性、难以重复、不可预测和不可穷尽。限于研发周期和成本、工况复杂多样性,特别是安全因素的考虑,传统的开放道路测试试验或基于封闭试验场的测试难以满足智能驾驶系统可靠性与鲁棒性的测试要求。因此,借助数字虚拟技术的仿真测试成为智能驾驶测试验证一种新的手段,仿真场景的构建作为模拟仿真的重要组成部分,是实现智能驾驶测试中大样本、极限边界小概率样本测试验证的关键技术,这对提升智能驾驶系统的压力和加速测评水平显得尤为重要。面向智能驾驶测试的仿真场景构建技术已成为当前汽车智能化新的研究课题和世界性的研究热点,作为一种新兴技术仍面临许多挑战。本文提出了面向智能驾驶测试的仿真场景构建方法,系统阐述了国内外研究工作的进展与现状,包括场景自动构建方法和交通仿真建模方法,重点分析一些值得深入研究的问题并围绕场景构建技术的发展趋势进行了讨论分析,最后介绍了团队相关研究在2020中国智能驾驶挑战赛仿真赛和世界智能驾驶挑战赛的仿真场景应用情况。关键词:汽车智能驾驶;模拟仿真;仿真测试;场景构建;交通建模;智能驾驶挑战赛128|216|9更新时间:2024-05-08

摘要:随着汽车智能化程度的不断提高,智能汽车通过环境传感器与周边行驶环境的信息交互与互联更为密切,需应对的行驶环境状况也越来越复杂,包括行驶道路、周边交通和气象条件等诸多因素,具有较强的不确定性、难以重复、不可预测和不可穷尽。限于研发周期和成本、工况复杂多样性,特别是安全因素的考虑,传统的开放道路测试试验或基于封闭试验场的测试难以满足智能驾驶系统可靠性与鲁棒性的测试要求。因此,借助数字虚拟技术的仿真测试成为智能驾驶测试验证一种新的手段,仿真场景的构建作为模拟仿真的重要组成部分,是实现智能驾驶测试中大样本、极限边界小概率样本测试验证的关键技术,这对提升智能驾驶系统的压力和加速测评水平显得尤为重要。面向智能驾驶测试的仿真场景构建技术已成为当前汽车智能化新的研究课题和世界性的研究热点,作为一种新兴技术仍面临许多挑战。本文提出了面向智能驾驶测试的仿真场景构建方法,系统阐述了国内外研究工作的进展与现状,包括场景自动构建方法和交通仿真建模方法,重点分析一些值得深入研究的问题并围绕场景构建技术的发展趋势进行了讨论分析,最后介绍了团队相关研究在2020中国智能驾驶挑战赛仿真赛和世界智能驾驶挑战赛的仿真场景应用情况。关键词:汽车智能驾驶;模拟仿真;仿真测试;场景构建;交通建模;智能驾驶挑战赛128|216|9更新时间:2024-05-08 -

摘要:自动驾驶系统(autonomous driving system,ADS)是一种集成高精度传感器、人工智能和地图导航系统等模块的信息—物理融合系统。该类系统中的自动驾驶软件完成了从高级辅助驾驶到无人驾驶任务中关键的感知、定位、预测、规划和控制任务。随着深度学习和强化学习等人工智能技术的发展和车载硬件设备的不断升级,高级别的自动驾驶软件已经逐渐应用于多种安全攸关的场景中,保障其运行稳定性与可靠性的测试技术逐渐成为学术界和产业界的研究重点。本文在广泛调研国内外文献基础上,对自动驾驶软件测试技术进行了深入分析与梳理。结合自动驾驶软件的架构特点及系统特征,讨论了面向自动驾驶系统的仿真测试和实景测试,以及面向组件的测试技术。其中,在仿真方法方面,分析了软件仿真、半实体仿真和在环仿真等技术;在仿真对象方面,讨论了静态环境仿真、动态场景仿真、传感器仿真和车辆动力学仿真等。同时,本文介绍了当前实景测试的进展与情况,重点分析了实景测试案例中的得失优劣。在面向自动驾驶软件组件的测试技术方面,重点讨论了当前数据驱动技术在感知组件、决策规划组件,以及控制组件测试方面的进展。最后,本文总结分析了自动驾驶软件测试当前面临的挑战,并对未来自动驾驶软件测试技术的研究方向和研究重点进行了展望。关键词:自动驾驶软件;综述;仿真测试;数据驱动的测试;软件测试165|712|7更新时间:2024-05-08

摘要:自动驾驶系统(autonomous driving system,ADS)是一种集成高精度传感器、人工智能和地图导航系统等模块的信息—物理融合系统。该类系统中的自动驾驶软件完成了从高级辅助驾驶到无人驾驶任务中关键的感知、定位、预测、规划和控制任务。随着深度学习和强化学习等人工智能技术的发展和车载硬件设备的不断升级,高级别的自动驾驶软件已经逐渐应用于多种安全攸关的场景中,保障其运行稳定性与可靠性的测试技术逐渐成为学术界和产业界的研究重点。本文在广泛调研国内外文献基础上,对自动驾驶软件测试技术进行了深入分析与梳理。结合自动驾驶软件的架构特点及系统特征,讨论了面向自动驾驶系统的仿真测试和实景测试,以及面向组件的测试技术。其中,在仿真方法方面,分析了软件仿真、半实体仿真和在环仿真等技术;在仿真对象方面,讨论了静态环境仿真、动态场景仿真、传感器仿真和车辆动力学仿真等。同时,本文介绍了当前实景测试的进展与情况,重点分析了实景测试案例中的得失优劣。在面向自动驾驶软件组件的测试技术方面,重点讨论了当前数据驱动技术在感知组件、决策规划组件,以及控制组件测试方面的进展。最后,本文总结分析了自动驾驶软件测试当前面临的挑战,并对未来自动驾驶软件测试技术的研究方向和研究重点进行了展望。关键词:自动驾驶软件;综述;仿真测试;数据驱动的测试;软件测试165|712|7更新时间:2024-05-08 -

摘要:自动驾驶车辆的本质是轮式移动机器人,是一个集模式识别、环境感知、规划决策和智能控制等功能于一体的综合系统。人工智能和机器学习领域的进步极大推动了自动驾驶技术的发展。当前主流的机器学习方法分为:监督学习、非监督学习和强化学习3种。强化学习方法更适用于复杂交通场景下自动驾驶系统决策和控制的智能处理,有利于提高自动驾驶的舒适性和安全性。深度学习和强化学习相结合产生的深度强化学习方法成为机器学习领域中的热门研究方向。首先对自动驾驶技术、强化学习方法以及自动驾驶控制架构进行简要介绍,并阐述了强化学习方法的基本原理和研究现状。随后重点阐述了强化学习方法在自动驾驶控制领域的研究历史和现状,并结合北京联合大学智能车研究团队的研究和测试工作介绍了典型的基于强化学习的自动驾驶控制技术应用,讨论了深度强化学习的潜力。最后提出了强化学习方法在自动驾驶控制领域研究和应用时遇到的困难和挑战,包括真实环境下自动驾驶安全性、多智能体强化学习和符合人类驾驶特性的奖励函数设计等。研究有助于深入了解强化学习方法在自动驾驶控制方面的优势和局限性,在应用中也可作为自动驾驶控制系统的设计参考。关键词:自动驾驶;决策控制;马尔可夫决策过程;强化学习;数据驱动;自主学习414|128|5更新时间:2024-05-08

摘要:自动驾驶车辆的本质是轮式移动机器人,是一个集模式识别、环境感知、规划决策和智能控制等功能于一体的综合系统。人工智能和机器学习领域的进步极大推动了自动驾驶技术的发展。当前主流的机器学习方法分为:监督学习、非监督学习和强化学习3种。强化学习方法更适用于复杂交通场景下自动驾驶系统决策和控制的智能处理,有利于提高自动驾驶的舒适性和安全性。深度学习和强化学习相结合产生的深度强化学习方法成为机器学习领域中的热门研究方向。首先对自动驾驶技术、强化学习方法以及自动驾驶控制架构进行简要介绍,并阐述了强化学习方法的基本原理和研究现状。随后重点阐述了强化学习方法在自动驾驶控制领域的研究历史和现状,并结合北京联合大学智能车研究团队的研究和测试工作介绍了典型的基于强化学习的自动驾驶控制技术应用,讨论了深度强化学习的潜力。最后提出了强化学习方法在自动驾驶控制领域研究和应用时遇到的困难和挑战,包括真实环境下自动驾驶安全性、多智能体强化学习和符合人类驾驶特性的奖励函数设计等。研究有助于深入了解强化学习方法在自动驾驶控制方面的优势和局限性,在应用中也可作为自动驾驶控制系统的设计参考。关键词:自动驾驶;决策控制;马尔可夫决策过程;强化学习;数据驱动;自主学习414|128|5更新时间:2024-05-08 -

摘要:作为实现汽车自动驾驶的关键基础设施,自动驾驶地图能够提供大量准确且语义丰富的数据来帮助用户以更精细的尺度了解周边环境状况,辅助感知、定位、驾驶规划与决策控制,满足智能时代多种高层次的应用需求,进而切实推动我国自动驾驶相关领域的发展与商业化应用。自动驾驶地图的数据标准作为自动驾驶地图生产应用的指导性规范之一,是自动驾驶地图数据标准化的基准。当前我国自动驾驶相关领域对自动驾驶地图标准化的需求迫切,地图数据标准化已成为业界共同关注的热点问题。为解决自动驾驶地图数据标准化问题,切实推动自动驾驶地图的高效发展,本文对自动驾驶地图的数据标准进行比较研究。首先介绍国内外主流的自动驾驶地图数据标准,然后针对其中4种:导航数据标准(navigation data standard,NDS)、OpenDrive、智能运输系统智能驾驶电子地图数据模型与交换格式和道路高精度电子导航地图数据规范进行分析比较研究,主要从数据结构、数据模型、地图渲染和协同应用4个维度展开,并在各个维度上给出数据标准编制时建议遵循的原则。基于分析比较研究的结果,总结出自动驾驶地图数据标准编制时建议遵循的原则。通过对自动驾驶地图的数据标准进行分析比较研究,归纳总结出数据标准编制时建议遵循的原则,这些建议遵循的编制原则对我国相应规格标准的制定具有借鉴意义。关键词:自动驾驶;自动驾驶地图;数据标准;自动驾驶地图数据标准;编制原则181|297|22更新时间:2024-05-08

摘要:作为实现汽车自动驾驶的关键基础设施,自动驾驶地图能够提供大量准确且语义丰富的数据来帮助用户以更精细的尺度了解周边环境状况,辅助感知、定位、驾驶规划与决策控制,满足智能时代多种高层次的应用需求,进而切实推动我国自动驾驶相关领域的发展与商业化应用。自动驾驶地图的数据标准作为自动驾驶地图生产应用的指导性规范之一,是自动驾驶地图数据标准化的基准。当前我国自动驾驶相关领域对自动驾驶地图标准化的需求迫切,地图数据标准化已成为业界共同关注的热点问题。为解决自动驾驶地图数据标准化问题,切实推动自动驾驶地图的高效发展,本文对自动驾驶地图的数据标准进行比较研究。首先介绍国内外主流的自动驾驶地图数据标准,然后针对其中4种:导航数据标准(navigation data standard,NDS)、OpenDrive、智能运输系统智能驾驶电子地图数据模型与交换格式和道路高精度电子导航地图数据规范进行分析比较研究,主要从数据结构、数据模型、地图渲染和协同应用4个维度展开,并在各个维度上给出数据标准编制时建议遵循的原则。基于分析比较研究的结果,总结出自动驾驶地图数据标准编制时建议遵循的原则。通过对自动驾驶地图的数据标准进行分析比较研究,归纳总结出数据标准编制时建议遵循的原则,这些建议遵循的编制原则对我国相应规格标准的制定具有借鉴意义。关键词:自动驾驶;自动驾驶地图;数据标准;自动驾驶地图数据标准;编制原则181|297|22更新时间:2024-05-08 -

摘要:视觉感知模块能够利用摄像机等视觉传感器获取丰富的图像和视频信息,进而检测自动驾驶汽车视野中的车辆、行人与交通标识等信息,是自动驾驶最有效、成本最低的感知方式之一。运动规划为自主车辆提供从车辆初始状态到目标状态的一系列运动参数和驾驶动作,而端到端的模型能够直接从感知的数据获取车辆的运动参数,因而受到广泛的关注。为了全面反映视觉感知的端到端自动驾驶运动规划方法的研究进展,本文对国内外公开发表的具有代表性和前沿的论文进行了概述。首先分析端到端方法的应用,以及视觉感知和运动规划在端到端自动驾驶中的作用,然后以自主车辆的学习方式作为分类依据,将视觉感知的端到端自动驾驶运动规划的实现方法分为模仿学习和强化学习两大类,并对各类方法的不同算法进行了归纳和分析;考虑到现阶段端到端模型的研究面临着虚拟到现实的任务,故对基于迁移学习的方法进行了梳理。最后列举与自动驾驶相关的数据集和仿真平台,总结存在的问题和挑战,对未来的发展趋势进行思考和展望。视觉感知的端到端自动驾驶运动规划模型的普适性强且结构简单,这类方法具有广阔的应用前景和研究价值,但是存在不可解释和难以保证绝对安全的问题,未来需要更多的研究改善端到端模型存在的局限性。关键词:视觉感知;运动规划;端到端;自动驾驶;模仿学习;强化学习198|617|6更新时间:2024-05-08

摘要:视觉感知模块能够利用摄像机等视觉传感器获取丰富的图像和视频信息,进而检测自动驾驶汽车视野中的车辆、行人与交通标识等信息,是自动驾驶最有效、成本最低的感知方式之一。运动规划为自主车辆提供从车辆初始状态到目标状态的一系列运动参数和驾驶动作,而端到端的模型能够直接从感知的数据获取车辆的运动参数,因而受到广泛的关注。为了全面反映视觉感知的端到端自动驾驶运动规划方法的研究进展,本文对国内外公开发表的具有代表性和前沿的论文进行了概述。首先分析端到端方法的应用,以及视觉感知和运动规划在端到端自动驾驶中的作用,然后以自主车辆的学习方式作为分类依据,将视觉感知的端到端自动驾驶运动规划的实现方法分为模仿学习和强化学习两大类,并对各类方法的不同算法进行了归纳和分析;考虑到现阶段端到端模型的研究面临着虚拟到现实的任务,故对基于迁移学习的方法进行了梳理。最后列举与自动驾驶相关的数据集和仿真平台,总结存在的问题和挑战,对未来的发展趋势进行思考和展望。视觉感知的端到端自动驾驶运动规划模型的普适性强且结构简单,这类方法具有广阔的应用前景和研究价值,但是存在不可解释和难以保证绝对安全的问题,未来需要更多的研究改善端到端模型存在的局限性。关键词:视觉感知;运动规划;端到端;自动驾驶;模仿学习;强化学习198|617|6更新时间:2024-05-08

综述

-

摘要:目的视觉感知技术是智能车系统中的一项关键技术,但是在复杂挑战下如何有效提高视觉性能已经成为智能驾驶领域的重要研究内容。本文将人工社会(artificial societies)、计算实验(computational experiments)和平行执行(parallel execution)构成的ACP方法引入智能驾驶的视觉感知领域,提出了面向智能驾驶的平行视觉感知,解决了视觉模型合理训练和评估问题,有助于智能驾驶进一步走向实际应用。方法平行视觉感知通过人工子系统组合来模拟实际驾驶场景,构建人工驾驶场景使之成为智能车视觉感知的“计算实验室”;借助计算实验两种操作模式完成视觉模型训练与评估;最后采用平行执行动态优化视觉模型,保障智能驾驶对复杂挑战的感知与理解长期有效。结果实验表明,目标检测的训练阶段虚实混合数据最高精度可达60.9%,比单纯用KPC(包括:KITTI(Karlsruhe Institute of Technology and Toyota Technological Institute),PASCAL VOC(pattern analysis,statistical modelling and computational learning visual object classes)和MS COCO(Microsoft common objects in context))数据和虚拟数据分别高出17.9%和5.3%;在评估阶段相较于基准数据,常规任务(-30°且垂直移动)平均精度下降11.3%,环境任务(雾天)平均精度下降21.0%,困难任务(所有挑战)平均精度下降33.7%。结论本文为智能驾驶设计和实施了在实际驾驶场景难以甚至无法进行的视觉计算实验,对复杂视觉挑战进行分析和评估,具备加强智能车在行驶过程中感知和理解周围场景的意义。关键词:智能驾驶;平行智能;虚拟图像;合成图像;目标检测96|231|4更新时间:2024-05-08

摘要:目的视觉感知技术是智能车系统中的一项关键技术,但是在复杂挑战下如何有效提高视觉性能已经成为智能驾驶领域的重要研究内容。本文将人工社会(artificial societies)、计算实验(computational experiments)和平行执行(parallel execution)构成的ACP方法引入智能驾驶的视觉感知领域,提出了面向智能驾驶的平行视觉感知,解决了视觉模型合理训练和评估问题,有助于智能驾驶进一步走向实际应用。方法平行视觉感知通过人工子系统组合来模拟实际驾驶场景,构建人工驾驶场景使之成为智能车视觉感知的“计算实验室”;借助计算实验两种操作模式完成视觉模型训练与评估;最后采用平行执行动态优化视觉模型,保障智能驾驶对复杂挑战的感知与理解长期有效。结果实验表明,目标检测的训练阶段虚实混合数据最高精度可达60.9%,比单纯用KPC(包括:KITTI(Karlsruhe Institute of Technology and Toyota Technological Institute),PASCAL VOC(pattern analysis,statistical modelling and computational learning visual object classes)和MS COCO(Microsoft common objects in context))数据和虚拟数据分别高出17.9%和5.3%;在评估阶段相较于基准数据,常规任务(-30°且垂直移动)平均精度下降11.3%,环境任务(雾天)平均精度下降21.0%,困难任务(所有挑战)平均精度下降33.7%。结论本文为智能驾驶设计和实施了在实际驾驶场景难以甚至无法进行的视觉计算实验,对复杂视觉挑战进行分析和评估,具备加强智能车在行驶过程中感知和理解周围场景的意义。关键词:智能驾驶;平行智能;虚拟图像;合成图像;目标检测96|231|4更新时间:2024-05-08 -

摘要:目的随着计算机与人工智能的快速发展,视觉感知技术突飞猛进。然而,以深度学习为主的视觉感知方法依赖于大规模多样性的数据集,因此,本文提出了基于平行学习的视觉分析框架——平行视觉,它通过大量精细标注的人工图像来给视觉算法补充足够的图像数据,从而将计算机变成计算智能的“实验室”。方法首先人工图像系统模拟实际图像中可能出现的成像条件,利用系统内部参数自动得到标注信息,获取符合要求的人工图像数据;然后使用预测学习设计视觉感知模型,利用计算实验方法在人工图像系统生成的大量图像数据上进行各种实验,方便地研究复杂环境条件等困难场景对视觉感知模型的影响,使一些实际中的不可控因素转变为可控因素,增加视觉模型的可解释性;最后通过指示学习反馈优化模型参数,利用视觉感知模型在实际场景下存在的困难来指导其在人工场景的训练,以实际与人工虚实互动的方式,在线学习和优化视觉感知模型。由于已经有大量研究人员致力于构建人工场景并生成大量虚拟图像,因此本文采用已构建的这些人工场景图像,并对实际场景图像进行翻转、裁剪、缩放等数据扩充,然后以计算实验和预测学习为重点,开展了相关的应用实例研究。结果在SYNTHIA(synthetic collection of imagery and annotations),Virtual KITTI(Karlsruhe Institute of Technology and Toyota Technological Institute)和VIPER(visual perception benchmark)数据集上进行的大量实验表明,本文方法能够有效地克服数据集分布差异对模型泛化能力的影响,性能优于同期最好的方法,比如在SYNTHIA数据集上检测和分割性能分别提升了3.8%和2.7%。结论平行视觉是视觉计算领域的一个重要研究方向,通过与深度学习的结合,将推动越来越多的智能视觉系统发展成熟并走向应用。关键词:计算机视觉;平行学习;平行视觉;视觉感知模型;实例分割;目标检测182|213|2更新时间:2024-05-08

摘要:目的随着计算机与人工智能的快速发展,视觉感知技术突飞猛进。然而,以深度学习为主的视觉感知方法依赖于大规模多样性的数据集,因此,本文提出了基于平行学习的视觉分析框架——平行视觉,它通过大量精细标注的人工图像来给视觉算法补充足够的图像数据,从而将计算机变成计算智能的“实验室”。方法首先人工图像系统模拟实际图像中可能出现的成像条件,利用系统内部参数自动得到标注信息,获取符合要求的人工图像数据;然后使用预测学习设计视觉感知模型,利用计算实验方法在人工图像系统生成的大量图像数据上进行各种实验,方便地研究复杂环境条件等困难场景对视觉感知模型的影响,使一些实际中的不可控因素转变为可控因素,增加视觉模型的可解释性;最后通过指示学习反馈优化模型参数,利用视觉感知模型在实际场景下存在的困难来指导其在人工场景的训练,以实际与人工虚实互动的方式,在线学习和优化视觉感知模型。由于已经有大量研究人员致力于构建人工场景并生成大量虚拟图像,因此本文采用已构建的这些人工场景图像,并对实际场景图像进行翻转、裁剪、缩放等数据扩充,然后以计算实验和预测学习为重点,开展了相关的应用实例研究。结果在SYNTHIA(synthetic collection of imagery and annotations),Virtual KITTI(Karlsruhe Institute of Technology and Toyota Technological Institute)和VIPER(visual perception benchmark)数据集上进行的大量实验表明,本文方法能够有效地克服数据集分布差异对模型泛化能力的影响,性能优于同期最好的方法,比如在SYNTHIA数据集上检测和分割性能分别提升了3.8%和2.7%。结论平行视觉是视觉计算领域的一个重要研究方向,通过与深度学习的结合,将推动越来越多的智能视觉系统发展成熟并走向应用。关键词:计算机视觉;平行学习;平行视觉;视觉感知模型;实例分割;目标检测182|213|2更新时间:2024-05-08

平行驾驶

-

摘要:目的行人检测是目标检测中的一个基准问题,在自动驾驶等场景有着较大的实用价值,在路径规划和智能避障方面发挥着重要作用。受限于现实的算法功耗和运行效率,在自动驾驶场景下行人检测存在检测速度不佳、遮挡行人检测精度不足和小尺度行人漏检率高等问题,在保证实时性的前提下设计一种适合行人检测的算法,是一项挑战性的工作。方法本文旨在解决自动驾驶场景中耗时长、行人遮挡和小尺度行人检测结果精度低的问题,提出了一种尺度注意力并行检测算法(scale-aware and efficient object detection,Scale-aware EfficientDet):在特征提取与检测中使用了EfficientDet的主干网络,保证算法效率和功耗的平衡;在行人遮挡方面,为了提高模型对遮挡现象的检测精度,引入了可以增强行人与其他物体之间特征差异的损失函数;在提高小目标行人检测精度方面,采用scale-aware双路网络算法来增加对小目标行人的检测精度。结果本文选择Caltech行人数据集作为对比数据集,选取YOLO(you only look once)、YOLOv3、SA-FastRCNN(scale-aware fast region-based convolutional neural network)等算法进行对比,在运行效率方面,本文算法在连续输入单帧图像的情况下达到了35帧/s,多图像输入时达到了70帧/s的工作效率;在模型精度测试中,本文算法也略胜一筹。本文算法应用于2020年中国智能汽车大赛中,在安全避障环节皆获得满分。结论本文设计的尺度感知的行人检测算法,在EfficientDet高性能检测器的基础上,通过结合损失函数、scale-aware双路子网络的改进,进一步提升了本文检测器的鲁棒性。关键词:自动驾驶;行人检测;目标检测;EfficientDet;卷积神经网络53|43|6更新时间:2024-05-08

摘要:目的行人检测是目标检测中的一个基准问题,在自动驾驶等场景有着较大的实用价值,在路径规划和智能避障方面发挥着重要作用。受限于现实的算法功耗和运行效率,在自动驾驶场景下行人检测存在检测速度不佳、遮挡行人检测精度不足和小尺度行人漏检率高等问题,在保证实时性的前提下设计一种适合行人检测的算法,是一项挑战性的工作。方法本文旨在解决自动驾驶场景中耗时长、行人遮挡和小尺度行人检测结果精度低的问题,提出了一种尺度注意力并行检测算法(scale-aware and efficient object detection,Scale-aware EfficientDet):在特征提取与检测中使用了EfficientDet的主干网络,保证算法效率和功耗的平衡;在行人遮挡方面,为了提高模型对遮挡现象的检测精度,引入了可以增强行人与其他物体之间特征差异的损失函数;在提高小目标行人检测精度方面,采用scale-aware双路网络算法来增加对小目标行人的检测精度。结果本文选择Caltech行人数据集作为对比数据集,选取YOLO(you only look once)、YOLOv3、SA-FastRCNN(scale-aware fast region-based convolutional neural network)等算法进行对比,在运行效率方面,本文算法在连续输入单帧图像的情况下达到了35帧/s,多图像输入时达到了70帧/s的工作效率;在模型精度测试中,本文算法也略胜一筹。本文算法应用于2020年中国智能汽车大赛中,在安全避障环节皆获得满分。结论本文设计的尺度感知的行人检测算法,在EfficientDet高性能检测器的基础上,通过结合损失函数、scale-aware双路子网络的改进,进一步提升了本文检测器的鲁棒性。关键词:自动驾驶;行人检测;目标检测;EfficientDet;卷积神经网络53|43|6更新时间:2024-05-08 -

摘要:目的针对视觉目标跟踪(video object tracking,VOT)和视频对象分割(video object segmentation,VOS)问题,研究人员提出了多个多任务处理框架,但是该类框架的精确度和鲁棒性较差。针对此问题,本文提出一个融合多尺度上下文信息和视频帧间信息的实时视觉目标跟踪与视频对象分割多任务的端到端框架。方法文中提出的架构使用了由空洞深度可分离卷积组成的更加多尺度的空洞空间金字塔池化模块,以及具备帧间信息的帧间掩模传播模块,使得网络对多尺度目标对象分割能力更强,同时具备更好的鲁棒性。结果本文方法在视觉目标跟踪VOT-2016和VOT-2018数据集上的期望平均重叠率(expected average overlap,EAO)分别达到了0.462和0.408,分别比SiamMask高了0.029和0.028,达到了最先进的结果,并且表现出更好的鲁棒性。在视频对象分割DAVIS(densely annotated video segmentation)-2016和DAVIS-2017数据集上也取得了有竞争力的结果。其中,在多目标对象分割DAVIS-2017数据集上,本文方法比SiamMask有更好的性能表现,区域相似度的杰卡德系数的平均值JM和轮廓精确度的F度量的平均值FM分别达到了56.0和59.0,并且区域和轮廓的衰变值JD和FD都比SiamMask中的低,分别为17.9和19.8。同时运行速度为45帧/s,达到了实时的运行速度。结论文中提出的融合多尺度上下文信息和视频帧间信息的实时视觉目标跟踪与视频对象分割多任务的端到端框架,充分捕捉了多尺度上下文信息并且利用了视频帧间的信息,使得网络对多尺度目标对象分割能力更强的同时具备更好的鲁棒性。关键词:视觉目标跟踪;视频对象分割;全卷积网络;空洞空间金字塔池化;帧间掩模传播44|46|4更新时间:2024-05-08

摘要:目的针对视觉目标跟踪(video object tracking,VOT)和视频对象分割(video object segmentation,VOS)问题,研究人员提出了多个多任务处理框架,但是该类框架的精确度和鲁棒性较差。针对此问题,本文提出一个融合多尺度上下文信息和视频帧间信息的实时视觉目标跟踪与视频对象分割多任务的端到端框架。方法文中提出的架构使用了由空洞深度可分离卷积组成的更加多尺度的空洞空间金字塔池化模块,以及具备帧间信息的帧间掩模传播模块,使得网络对多尺度目标对象分割能力更强,同时具备更好的鲁棒性。结果本文方法在视觉目标跟踪VOT-2016和VOT-2018数据集上的期望平均重叠率(expected average overlap,EAO)分别达到了0.462和0.408,分别比SiamMask高了0.029和0.028,达到了最先进的结果,并且表现出更好的鲁棒性。在视频对象分割DAVIS(densely annotated video segmentation)-2016和DAVIS-2017数据集上也取得了有竞争力的结果。其中,在多目标对象分割DAVIS-2017数据集上,本文方法比SiamMask有更好的性能表现,区域相似度的杰卡德系数的平均值JM和轮廓精确度的F度量的平均值FM分别达到了56.0和59.0,并且区域和轮廓的衰变值JD和FD都比SiamMask中的低,分别为17.9和19.8。同时运行速度为45帧/s,达到了实时的运行速度。结论文中提出的融合多尺度上下文信息和视频帧间信息的实时视觉目标跟踪与视频对象分割多任务的端到端框架,充分捕捉了多尺度上下文信息并且利用了视频帧间的信息,使得网络对多尺度目标对象分割能力更强的同时具备更好的鲁棒性。关键词:视觉目标跟踪;视频对象分割;全卷积网络;空洞空间金字塔池化;帧间掩模传播44|46|4更新时间:2024-05-08 -

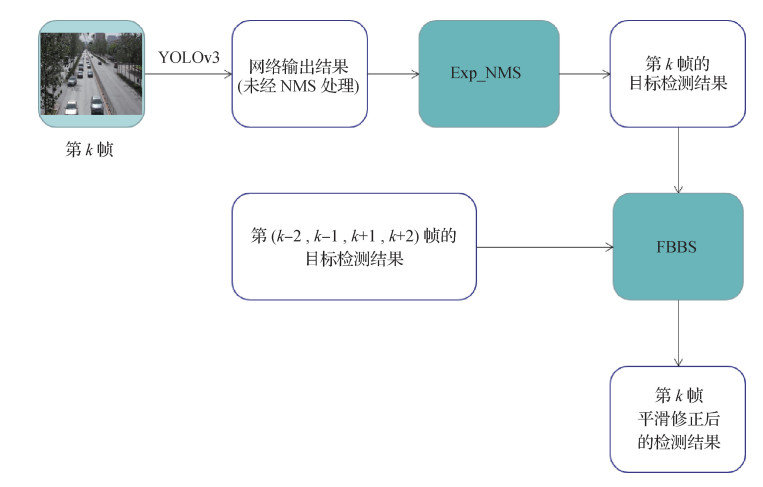

摘要:目的目前视频目标检测(object detection from video)领域大量研究集中在提升预测框定位准确性,对于定位稳定性提升的研究则较少。然而,预测框定位稳定性对多目标跟踪、车辆行驶控制等算法具有重要影响,为提高预测框定位稳定性,本文提出了一种扩张性非极大值抑制(expanded non-maximum suppression,Exp_NMS)方法和帧间平滑策略(frame bounding box smooth,FBBS)。方法目标检测阶段使用YOLO(you only look once)v3神经网络,非极大值抑制阶段通过融合多个预测框信息得出结果,增强预测框在连续视频流中的稳定性。后续利用视频相邻帧信息关联的特点,对预测框进行平滑处理,进一步提高预测框定位稳定性。结果选用UA-DETRAC(University at Albany detection and tracking benchmark dataset)数据集进行分析实验,使用卡尔曼滤波多目标跟踪算法进行辅助验证。本文在MOT(multiple object tracking)评价指标基础上,设计了平均轨迹曲折度(average track-tortuosity,AT)来直观、量化地衡量预测框定位稳定性及跟踪轨迹的平滑度。实验结果表明,本文方法几乎不影响预测框定位准确性,且对定位稳定性有大幅改善,相应跟踪质量得到显著提升。测试视频的MOTA(multiple object tracking accuracy)提升6.0%、IDs(identity switches)减少16.8%,跟踪FP(false positives)类型错误下降45.83%,AT下降36.57%,mAP(mean average precision)仅下降0.07%。结论从非极大值抑制和前后帧信息关联两个角度设计相关策略,经实验验证,本文方法在基本不影响预测框定位准确性的前提下,可有效提升预测框定位稳定性。关键词:卷积神经网络;视频目标检测;预测框定位稳定性;非极大值抑制策略;相邻帧信息关联114|390|3更新时间:2024-05-08

摘要:目的目前视频目标检测(object detection from video)领域大量研究集中在提升预测框定位准确性,对于定位稳定性提升的研究则较少。然而,预测框定位稳定性对多目标跟踪、车辆行驶控制等算法具有重要影响,为提高预测框定位稳定性,本文提出了一种扩张性非极大值抑制(expanded non-maximum suppression,Exp_NMS)方法和帧间平滑策略(frame bounding box smooth,FBBS)。方法目标检测阶段使用YOLO(you only look once)v3神经网络,非极大值抑制阶段通过融合多个预测框信息得出结果,增强预测框在连续视频流中的稳定性。后续利用视频相邻帧信息关联的特点,对预测框进行平滑处理,进一步提高预测框定位稳定性。结果选用UA-DETRAC(University at Albany detection and tracking benchmark dataset)数据集进行分析实验,使用卡尔曼滤波多目标跟踪算法进行辅助验证。本文在MOT(multiple object tracking)评价指标基础上,设计了平均轨迹曲折度(average track-tortuosity,AT)来直观、量化地衡量预测框定位稳定性及跟踪轨迹的平滑度。实验结果表明,本文方法几乎不影响预测框定位准确性,且对定位稳定性有大幅改善,相应跟踪质量得到显著提升。测试视频的MOTA(multiple object tracking accuracy)提升6.0%、IDs(identity switches)减少16.8%,跟踪FP(false positives)类型错误下降45.83%,AT下降36.57%,mAP(mean average precision)仅下降0.07%。结论从非极大值抑制和前后帧信息关联两个角度设计相关策略,经实验验证,本文方法在基本不影响预测框定位准确性的前提下,可有效提升预测框定位稳定性。关键词:卷积神经网络;视频目标检测;预测框定位稳定性;非极大值抑制策略;相邻帧信息关联114|390|3更新时间:2024-05-08 -

摘要:目的在智能网联汽车系统开发中,复杂环境下的车道线检测是关键环节之一。目前的车道线检测算法大都基于颜色、灰度和边缘等视觉特征信息,检测准确度受环境影响较大。而车道线的长度、宽度及方向等特征的规律性较强,具有序列化和结构关联的特点,不易受到环境影响。为此,采用视觉信息与空间分布关系相结合的方案,来提高复杂环境下的车道线检测能力。方法首先针对鸟瞰图中车道线在横向和纵向上分布密度不同的特点,将目标检测算法YOLO v3(you only look once v3)的网格密度由S×S改进为S×2S,得到的YOLO v3(S×2S)更适于小尺寸、大宽高比物体的检测;然后利用车道线序列化和结构相互关联的特点,在双向循环门限单元(bidirectional gated recurrent unit,BGRU)的基础上,提出基于车道线分布关系的车道线检测模型(BGRU-Lane,BGRU-L)。最后利用基于置信度的D-S(Dempster-Shafer)算法融合YOLO v3(S×2S)和BGRU-L的检测结果,提高复杂场景下的车道线检测能力。结果采用融合了视觉信息和空间分布关系的车道线检测模型,在KITTI(Karlsruhe Institute of Technology and Toyoko Technological Institute)交通数据集上的平均精度均值达到了90.28%,在欧洲卡车模拟2常规场景(Euro Truck Simulator 2 convention,ETS2_conv)和欧洲卡车模拟2复杂场景(Euro Truck Simulator 2 complex,ETS2_complex)下的平均精度均值分别为92.49%和91.73%。结论通过增大YOLO v3纵向的网格密度,可显著提高模型检测小尺寸、大宽高比物体的准确度;序列化和结构关联是车道线的重要属性,基于空间分布关系的BGRU-L模型的准确度受环境影响较小。两种模型的检测结果在经过D-S融合后,在复杂场景下具有较高的准确度。关键词:机器视觉;车道线检测;网格密度;空间分布;D-S融合118|65|4更新时间:2024-05-08

摘要:目的在智能网联汽车系统开发中,复杂环境下的车道线检测是关键环节之一。目前的车道线检测算法大都基于颜色、灰度和边缘等视觉特征信息,检测准确度受环境影响较大。而车道线的长度、宽度及方向等特征的规律性较强,具有序列化和结构关联的特点,不易受到环境影响。为此,采用视觉信息与空间分布关系相结合的方案,来提高复杂环境下的车道线检测能力。方法首先针对鸟瞰图中车道线在横向和纵向上分布密度不同的特点,将目标检测算法YOLO v3(you only look once v3)的网格密度由S×S改进为S×2S,得到的YOLO v3(S×2S)更适于小尺寸、大宽高比物体的检测;然后利用车道线序列化和结构相互关联的特点,在双向循环门限单元(bidirectional gated recurrent unit,BGRU)的基础上,提出基于车道线分布关系的车道线检测模型(BGRU-Lane,BGRU-L)。最后利用基于置信度的D-S(Dempster-Shafer)算法融合YOLO v3(S×2S)和BGRU-L的检测结果,提高复杂场景下的车道线检测能力。结果采用融合了视觉信息和空间分布关系的车道线检测模型,在KITTI(Karlsruhe Institute of Technology and Toyoko Technological Institute)交通数据集上的平均精度均值达到了90.28%,在欧洲卡车模拟2常规场景(Euro Truck Simulator 2 convention,ETS2_conv)和欧洲卡车模拟2复杂场景(Euro Truck Simulator 2 complex,ETS2_complex)下的平均精度均值分别为92.49%和91.73%。结论通过增大YOLO v3纵向的网格密度,可显著提高模型检测小尺寸、大宽高比物体的准确度;序列化和结构关联是车道线的重要属性,基于空间分布关系的BGRU-L模型的准确度受环境影响较小。两种模型的检测结果在经过D-S融合后,在复杂场景下具有较高的准确度。关键词:机器视觉;车道线检测;网格密度;空间分布;D-S融合118|65|4更新时间:2024-05-08 -

摘要:目的路径跟踪是自动驾驶汽车根据感知、决策和规划结果正确沿道路行驶的关键部分。目前路径跟踪算法难以在全速域、复杂路径场景和高自由度动力学模型下取得优异的性能,并且未考虑与纵向控制的耦合特性,限制了控制算法的跟踪性能。针对以上问题,提出了一种基于速度自适应预瞄的无模型转向控制算法。方法根据车辆与跟踪路径的横向偏差与角度偏差,建立车辆方向盘输出控制量方程,该方法实现了在动力学高度复杂情况和跟踪路径可导情况下的低速稳定跟踪。同时根据车辆纵向速度自适应设置跟踪预瞄距离,并将速度耦合参数加入方程,实现了车辆全速域、全路径的稳定跟踪。结果本文在PanoSim自动驾驶仿真系统和Simulink仿真软件进行仿真实验,在高自由度动力学模型下,本文算法实现在超高速(>220 km/h)直线及小曲率跟踪路径中横向偏差变化量Δ

摘要:目的路径跟踪是自动驾驶汽车根据感知、决策和规划结果正确沿道路行驶的关键部分。目前路径跟踪算法难以在全速域、复杂路径场景和高自由度动力学模型下取得优异的性能,并且未考虑与纵向控制的耦合特性,限制了控制算法的跟踪性能。针对以上问题,提出了一种基于速度自适应预瞄的无模型转向控制算法。方法根据车辆与跟踪路径的横向偏差与角度偏差,建立车辆方向盘输出控制量方程,该方法实现了在动力学高度复杂情况和跟踪路径可导情况下的低速稳定跟踪。同时根据车辆纵向速度自适应设置跟踪预瞄距离,并将速度耦合参数加入方程,实现了车辆全速域、全路径的稳定跟踪。结果本文在PanoSim自动驾驶仿真系统和Simulink仿真软件进行仿真实验,在高自由度动力学模型下,本文算法实现在超高速(>220 km/h)直线及小曲率跟踪路径中横向偏差变化量Δd 的模Δd < 0.1 m、在高速(>150 km/h)大曲率弯道跟踪路径中Δd < 0.3 m的性能。结论本文提出的基于速度自适应预瞄的无模型转向控制算法可以实现全速域、大曲率的路径稳定跟踪。关键词:自动驾驶;转向控制;路径跟踪;预瞄;速度耦合;PanoSim153|236|2更新时间:2024-05-08 -

摘要:目的复杂环境下的疲劳驾驶检测是一个具有挑战性的技术问题。为了充分利用驾驶员面部特征信息与时间特征,提出一种基于伪3D(Pseudo-3D,P3D)卷积神经网络(convolutional neural network,CNN)与注意力机制的驾驶疲劳检测方法。方法采用伪3D卷积模块进行时空特征学习;提出P3D-Attention模块,利用P3D的结构融合双通道注意力模块和适应的空间注意力模块,提高对重要通道特征的相关度,增加特征图的全局相关性,将多层深度卷积特征进行融合。利用双通道注意力模块分别在视频帧之间和每一帧的通道上施加关注,去除背景和噪声对识别的干扰,使用自适应空间注意模块使模型训练更快、收敛更好;使用2D全局平均池化层替代3D全局平均池化层获得更具表达能力的特征,进而提高网络收敛速度;运用softmax分类层进行分类。结果在公共数据集YawDD(a yawning detection dataset)上开展对比实验,本文方法在测试集上的F1-score检测准确率达到99.89%,在打哈欠类别上召回率达到100%;在数据集UTA-RLDD(University of Texas at Arlington real-life drowsiness dataset)上,本文方法在测试集上的F1-score检测准确率达到99.64%,在困倦类别上召回率达到100%;与Inception-V3融合LSTM(long short-term memory)的方法相比,本文方法模型大小为42.5 MB,是其模型大小的1/9,本文方法预测时间约660 ms,是其11%左右。结论提出一种基于伪3D卷积神经网络与注意力机制的驾驶疲劳检测方法,利用注意力机制进一步分析哈欠、眨眼和头部特征运动,将哈欠行为与说话行为动作很好地区分开来。关键词:3D卷积神经网络;伪3D卷积;全局平均池化;注意力机制;疲劳驾驶83|266|4更新时间:2024-05-08

摘要:目的复杂环境下的疲劳驾驶检测是一个具有挑战性的技术问题。为了充分利用驾驶员面部特征信息与时间特征,提出一种基于伪3D(Pseudo-3D,P3D)卷积神经网络(convolutional neural network,CNN)与注意力机制的驾驶疲劳检测方法。方法采用伪3D卷积模块进行时空特征学习;提出P3D-Attention模块,利用P3D的结构融合双通道注意力模块和适应的空间注意力模块,提高对重要通道特征的相关度,增加特征图的全局相关性,将多层深度卷积特征进行融合。利用双通道注意力模块分别在视频帧之间和每一帧的通道上施加关注,去除背景和噪声对识别的干扰,使用自适应空间注意模块使模型训练更快、收敛更好;使用2D全局平均池化层替代3D全局平均池化层获得更具表达能力的特征,进而提高网络收敛速度;运用softmax分类层进行分类。结果在公共数据集YawDD(a yawning detection dataset)上开展对比实验,本文方法在测试集上的F1-score检测准确率达到99.89%,在打哈欠类别上召回率达到100%;在数据集UTA-RLDD(University of Texas at Arlington real-life drowsiness dataset)上,本文方法在测试集上的F1-score检测准确率达到99.64%,在困倦类别上召回率达到100%;与Inception-V3融合LSTM(long short-term memory)的方法相比,本文方法模型大小为42.5 MB,是其模型大小的1/9,本文方法预测时间约660 ms,是其11%左右。结论提出一种基于伪3D卷积神经网络与注意力机制的驾驶疲劳检测方法,利用注意力机制进一步分析哈欠、眨眼和头部特征运动,将哈欠行为与说话行为动作很好地区分开来。关键词:3D卷积神经网络;伪3D卷积;全局平均池化;注意力机制;疲劳驾驶83|266|4更新时间:2024-05-08 -

摘要:目的疲劳驾驶是引发车辆交通事故的主要原因之一,针对现有方法在驾驶员面部遮挡情况下对眼睛状态识别效果不佳的问题,提出了一种基于自商图—梯度图共生矩阵的驾驶员眼部疲劳检测方法。方法利用以残差网络(residual network,ResNet)为前置网络的SSD(single shot multibox detector)人脸检测器来获取视频中的有效人脸区域,并通过人脸关键点检测算法分割出眼睛局部区域图像;建立驾驶员眼部的自商图与梯度图共生矩阵模型,分析共生矩阵的数字统计特征,选取效果较好的特征用以判定人眼的开闭状态;结合眼睛闭合时间百分比(percentage of eyelid closure,PERCLOS)与最长闭眼持续时间(maximum closing duration,MCD)两个疲劳指标来判别驾驶员的疲劳状态。结果在六自由度汽车性能虚拟仿真实验平台上模拟汽车驾驶,采集并分析驾驶员面部视频,本文方法能够有效识别驾驶员面部遮挡时眼睛的开闭状态,准确率高达99.12%,面部未遮挡时的识别精度为98.73%,算法处理视频的速度约为32帧/s。对比方法1采用方向梯度直方图特征与支持向量机分类器相结合的人脸检测算法,并以眼睛纵横比判定开闭眼状态,在面部遮挡时识别较弱;以卷积神经网络(convolutional neural network,CNN)判别眼睛状态的对比方法2虽然在面部遮挡情况下的准确率高达98.02%,但眨眼检测准确率效果不佳。结论基于自商图—梯度图共生矩阵的疲劳检测方法能够有效识别面部遮挡时眼睛的开闭情况和驾驶员的疲劳状态,具有较快的检测速度与较高的准确率。关键词:疲劳驾驶;人脸检测;人脸关键点检测;自商图;共生矩阵;眼睛闭合时间百分比(PERCLOS)85|173|2更新时间:2024-05-08

摘要:目的疲劳驾驶是引发车辆交通事故的主要原因之一,针对现有方法在驾驶员面部遮挡情况下对眼睛状态识别效果不佳的问题,提出了一种基于自商图—梯度图共生矩阵的驾驶员眼部疲劳检测方法。方法利用以残差网络(residual network,ResNet)为前置网络的SSD(single shot multibox detector)人脸检测器来获取视频中的有效人脸区域,并通过人脸关键点检测算法分割出眼睛局部区域图像;建立驾驶员眼部的自商图与梯度图共生矩阵模型,分析共生矩阵的数字统计特征,选取效果较好的特征用以判定人眼的开闭状态;结合眼睛闭合时间百分比(percentage of eyelid closure,PERCLOS)与最长闭眼持续时间(maximum closing duration,MCD)两个疲劳指标来判别驾驶员的疲劳状态。结果在六自由度汽车性能虚拟仿真实验平台上模拟汽车驾驶,采集并分析驾驶员面部视频,本文方法能够有效识别驾驶员面部遮挡时眼睛的开闭状态,准确率高达99.12%,面部未遮挡时的识别精度为98.73%,算法处理视频的速度约为32帧/s。对比方法1采用方向梯度直方图特征与支持向量机分类器相结合的人脸检测算法,并以眼睛纵横比判定开闭眼状态,在面部遮挡时识别较弱;以卷积神经网络(convolutional neural network,CNN)判别眼睛状态的对比方法2虽然在面部遮挡情况下的准确率高达98.02%,但眨眼检测准确率效果不佳。结论基于自商图—梯度图共生矩阵的疲劳检测方法能够有效识别面部遮挡时眼睛的开闭情况和驾驶员的疲劳状态,具有较快的检测速度与较高的准确率。关键词:疲劳驾驶;人脸检测;人脸关键点检测;自商图;共生矩阵;眼睛闭合时间百分比(PERCLOS)85|173|2更新时间:2024-05-08

目标检测与跟踪

-

摘要:目的无监督单目图像深度估计是3维重建领域的一个重要方向,在视觉导航和障碍物检测等领域具有广泛的应用价值。针对目前主流方法存在的局部可微性问题,提出了一种基于局部平面参数预测的方法。方法将深度估计问题转化为局部平面参数估计问题,使用局部平面参数预测模块代替多尺度估计中上采样及生成深度图的过程。在每个尺度的深度图预测中根据局部平面参数恢复至标准尺度,然后依据针孔相机模型得到标准尺度深度图,以避免使用双线性插值带来的局部可微性,从而有效规避陷入局部极小值,配合在网络跳层连接中引入的串联注意力机制,提升网络的特征提取能力。结果在KITTI(Karlsruhe Institute of Technology and Toyota Technological Institute at Chicago)自动驾驶数据集上进行了对比实验以及消融实验,与现存无监督方法和部分有监督方法进行对比,相比于最优数据,误差性指标降低了10% 20%,准确性指标提升了2%左右,同时,得到的稠密深度估计图具有清晰的边缘轮廓以及对反射区域更优的鲁棒性。结论本文提出的基于局部平面参数预测的深度估计方法,充分利用卷积特征信息,避免了训练过程中陷入局部极小值,同时对网络添加几何约束,使测试指标及视觉效果更加优秀。关键词:无监督学习;单目深度估计;注意力机制;局部平面参数估计;局部可微性94|154|3更新时间:2024-05-08

摘要:目的无监督单目图像深度估计是3维重建领域的一个重要方向,在视觉导航和障碍物检测等领域具有广泛的应用价值。针对目前主流方法存在的局部可微性问题,提出了一种基于局部平面参数预测的方法。方法将深度估计问题转化为局部平面参数估计问题,使用局部平面参数预测模块代替多尺度估计中上采样及生成深度图的过程。在每个尺度的深度图预测中根据局部平面参数恢复至标准尺度,然后依据针孔相机模型得到标准尺度深度图,以避免使用双线性插值带来的局部可微性,从而有效规避陷入局部极小值,配合在网络跳层连接中引入的串联注意力机制,提升网络的特征提取能力。结果在KITTI(Karlsruhe Institute of Technology and Toyota Technological Institute at Chicago)自动驾驶数据集上进行了对比实验以及消融实验,与现存无监督方法和部分有监督方法进行对比,相比于最优数据,误差性指标降低了10% 20%,准确性指标提升了2%左右,同时,得到的稠密深度估计图具有清晰的边缘轮廓以及对反射区域更优的鲁棒性。结论本文提出的基于局部平面参数预测的深度估计方法,充分利用卷积特征信息,避免了训练过程中陷入局部极小值,同时对网络添加几何约束,使测试指标及视觉效果更加优秀。关键词:无监督学习;单目深度估计;注意力机制;局部平面参数估计;局部可微性94|154|3更新时间:2024-05-08 -

摘要:目的在无人驾驶系统技术中,控制车辆转向以跟踪特定路径是实现驾驶的关键技术之一,大量基于传统控制的方法可以准确跟踪路径,然而如何在跟踪过程中实现类人的转向行为仍是当前跟踪技术面临的挑战性问题之一。现有传统转向模型并没有参考人类驾驶行为,难以实现过程模拟。此外,现有大多数基于神经网络的转向控制模型仅仅以视频帧作为输入,鲁棒性和可解释性不足。基于此,本文提出了一个融合神经网络与传统控制器的转向模型:深度纯追随模型(deep pure pursuit,deep PP)。方法在deep PP中,首先利用卷积神经网络(convolutional neural network,CNN)提取驾驶环境的视觉特征,同时使用传统的纯追随(pure pursuit,PP)控制器融合车辆运动模型以及自身位置计算跟踪给定的全局规划路径所需的转向控制量。然后,通过拼接PP的转向结果向量和视觉特征向量得到融合特征向量,并构建融合特征向量与人类转向行为之间的映射模型,最终实现预测无人驾驶汽车转向角度。结果实验将在CARLA(Center for Advanced Research on Language Acquisition)仿真数据集和真实场景数据集上进行,并与Udacity挑战赛的CNN模型和传统控制器进行对比。实验结果显示,在仿真数据集的14个复杂天气条件下,deep PP比CNN模型和传统转向控制器更贴近无人驾驶仪的转向指令。在使用均方根误差(root mean square error,RMSE)作为衡量指标时,deep PP相比于CNN模型提升了50.28%,相比于传统控制器提升了35.39%。最后,真实场景实验验证了提出的模型在真实场景上的实用性。结论本文提出的拟人化转向模型,综合了摄像头视觉信息、位置信息和车辆运动模型信息,使得无人驾驶汽车的转向行为更贴近人类驾驶行为,并在各种复杂驾驶条件下保持了高鲁棒性。关键词:无人驾驶;端到端;转向模型;路径跟踪;深度学习;纯追随172|830|1更新时间:2024-05-08

摘要:目的在无人驾驶系统技术中,控制车辆转向以跟踪特定路径是实现驾驶的关键技术之一,大量基于传统控制的方法可以准确跟踪路径,然而如何在跟踪过程中实现类人的转向行为仍是当前跟踪技术面临的挑战性问题之一。现有传统转向模型并没有参考人类驾驶行为,难以实现过程模拟。此外,现有大多数基于神经网络的转向控制模型仅仅以视频帧作为输入,鲁棒性和可解释性不足。基于此,本文提出了一个融合神经网络与传统控制器的转向模型:深度纯追随模型(deep pure pursuit,deep PP)。方法在deep PP中,首先利用卷积神经网络(convolutional neural network,CNN)提取驾驶环境的视觉特征,同时使用传统的纯追随(pure pursuit,PP)控制器融合车辆运动模型以及自身位置计算跟踪给定的全局规划路径所需的转向控制量。然后,通过拼接PP的转向结果向量和视觉特征向量得到融合特征向量,并构建融合特征向量与人类转向行为之间的映射模型,最终实现预测无人驾驶汽车转向角度。结果实验将在CARLA(Center for Advanced Research on Language Acquisition)仿真数据集和真实场景数据集上进行,并与Udacity挑战赛的CNN模型和传统控制器进行对比。实验结果显示,在仿真数据集的14个复杂天气条件下,deep PP比CNN模型和传统转向控制器更贴近无人驾驶仪的转向指令。在使用均方根误差(root mean square error,RMSE)作为衡量指标时,deep PP相比于CNN模型提升了50.28%,相比于传统控制器提升了35.39%。最后,真实场景实验验证了提出的模型在真实场景上的实用性。结论本文提出的拟人化转向模型,综合了摄像头视觉信息、位置信息和车辆运动模型信息,使得无人驾驶汽车的转向行为更贴近人类驾驶行为,并在各种复杂驾驶条件下保持了高鲁棒性。关键词:无人驾驶;端到端;转向模型;路径跟踪;深度学习;纯追随172|830|1更新时间:2024-05-08 -

摘要:目的目前大多数深度图像修复方法可分为两类:色彩图像引导的方法和单个深度图像修复方法。色彩图像引导的方法利用色彩图像真值,或其上一帧、下一帧提供的信息来修复深度图像。若缺少相应信息,这类方法是无效的。单个深度图像修复方法可以修复数据缺失较少的深度图像。但是,无法修复带有孔洞(数据缺失较大)的深度图像。为解决以上问题,本文将生成对抗网络(generative adversarial network,GAN)应用于深度图像修复领域,提出了一种基于GAN的单个深度图像修复方法,即Edge-guided GAN。方法首先,通过Canny算法获得待修复深度图像的边界图像,并将此两个单通道图像(待修复深度图像和边界图像)合并成一个2通道数据;其次,设计Edge-guided GAN高性能的生成器、判别器和损失函数,将此2通道数据作为生成器的输入,训练生成器,以生成器生成的深度图像(假值)和深度图像真值为判别器的输入,训练判别器;最终得到深度图像修复模型,完成深度图像修复。结果在Apollo scape数据集上与其他4种常用的GAN、不带边界信息的Edge-guided GAN进行实验分析。在输入尺寸为256×256像素,掩膜尺寸为32×32像素情况下,Edge-guided GAN的峰值信噪比(peak signal-to-noise ratio,PSN)比性能第2的模型提高了15.76%;在掩膜尺寸为64×64像素情况下,Edge-guided GAN的PSNR比性能第2的模型提高了18.64%。结论Edge-guided GAN以待修复深度图像的边界信息为其修复的约束条件,有效地提取了待修复深度图像特征,大幅度地提高了深度图像修复的精度。关键词:生成对抗网络;深度图像修复方法;Edge-guided GAN;边界信息;Apollo scape数据集50|65|3更新时间:2024-05-08

摘要:目的目前大多数深度图像修复方法可分为两类:色彩图像引导的方法和单个深度图像修复方法。色彩图像引导的方法利用色彩图像真值,或其上一帧、下一帧提供的信息来修复深度图像。若缺少相应信息,这类方法是无效的。单个深度图像修复方法可以修复数据缺失较少的深度图像。但是,无法修复带有孔洞(数据缺失较大)的深度图像。为解决以上问题,本文将生成对抗网络(generative adversarial network,GAN)应用于深度图像修复领域,提出了一种基于GAN的单个深度图像修复方法,即Edge-guided GAN。方法首先,通过Canny算法获得待修复深度图像的边界图像,并将此两个单通道图像(待修复深度图像和边界图像)合并成一个2通道数据;其次,设计Edge-guided GAN高性能的生成器、判别器和损失函数,将此2通道数据作为生成器的输入,训练生成器,以生成器生成的深度图像(假值)和深度图像真值为判别器的输入,训练判别器;最终得到深度图像修复模型,完成深度图像修复。结果在Apollo scape数据集上与其他4种常用的GAN、不带边界信息的Edge-guided GAN进行实验分析。在输入尺寸为256×256像素,掩膜尺寸为32×32像素情况下,Edge-guided GAN的峰值信噪比(peak signal-to-noise ratio,PSN)比性能第2的模型提高了15.76%;在掩膜尺寸为64×64像素情况下,Edge-guided GAN的PSNR比性能第2的模型提高了18.64%。结论Edge-guided GAN以待修复深度图像的边界信息为其修复的约束条件,有效地提取了待修复深度图像特征,大幅度地提高了深度图像修复的精度。关键词:生成对抗网络;深度图像修复方法;Edge-guided GAN;边界信息;Apollo scape数据集50|65|3更新时间:2024-05-08 -

摘要:目的深度学习在自动驾驶环境感知中的应用,将极大提升感知系统的精度和可靠性,但是现有的深度学习神经网络模型因其计算量和存储资源的需求难以部署在计算资源有限的自动驾驶嵌入式平台上。因此为解决应用深度神经网络所需的庞大计算量与嵌入式平台有限的计算能力之间的矛盾,提出了一种基于权重的概率分布的贪婪网络剪枝方法,旨在减少网络模型中的冗余连接,提高模型的计算效率。方法引入权重的概率分布,在训练过程中记录权重参数中较小值出现的概率。在剪枝阶段,依据训练过程中统计的权重概率分布进行增量剪枝和网络修复,改善了目前仅以权重大小为依据的剪枝策略。结果经实验验证,在Cifar10数据集上,在各个剪枝率下本文方法相比动态网络剪枝策略的准确率更高。在ImageNet数据集上,此方法在较小精度损失的情况下,有效地将AlexNet、VGG(visual geometry group)16的参数数量分别压缩了5.9倍和11.4倍,且所需的训练迭代次数相对于动态网络剪枝策略更少。另外对于残差类型网络ResNet34和ResNet50也可以进行有效的压缩,其中对于ResNet50网络,在精度损失增加较小的情况下,相比目前最优的方法HRank实现了更大的压缩率(2.1倍)。结论基于概率分布的贪婪剪枝策略解决了深度神经网络剪枝的不确定性问题,进一步提高了模型压缩后网络的稳定性,在实现压缩网络模型参数数量的同时保证了模型的准确率。关键词:深度学习;神经网络;模型压缩;概率分布;网络剪枝129|122|2更新时间:2024-05-08

摘要:目的深度学习在自动驾驶环境感知中的应用,将极大提升感知系统的精度和可靠性,但是现有的深度学习神经网络模型因其计算量和存储资源的需求难以部署在计算资源有限的自动驾驶嵌入式平台上。因此为解决应用深度神经网络所需的庞大计算量与嵌入式平台有限的计算能力之间的矛盾,提出了一种基于权重的概率分布的贪婪网络剪枝方法,旨在减少网络模型中的冗余连接,提高模型的计算效率。方法引入权重的概率分布,在训练过程中记录权重参数中较小值出现的概率。在剪枝阶段,依据训练过程中统计的权重概率分布进行增量剪枝和网络修复,改善了目前仅以权重大小为依据的剪枝策略。结果经实验验证,在Cifar10数据集上,在各个剪枝率下本文方法相比动态网络剪枝策略的准确率更高。在ImageNet数据集上,此方法在较小精度损失的情况下,有效地将AlexNet、VGG(visual geometry group)16的参数数量分别压缩了5.9倍和11.4倍,且所需的训练迭代次数相对于动态网络剪枝策略更少。另外对于残差类型网络ResNet34和ResNet50也可以进行有效的压缩,其中对于ResNet50网络,在精度损失增加较小的情况下,相比目前最优的方法HRank实现了更大的压缩率(2.1倍)。结论基于概率分布的贪婪剪枝策略解决了深度神经网络剪枝的不确定性问题,进一步提高了模型压缩后网络的稳定性,在实现压缩网络模型参数数量的同时保证了模型的准确率。关键词:深度学习;神经网络;模型压缩;概率分布;网络剪枝129|122|2更新时间:2024-05-08

自动驾驶场景感知与仿真

-

摘要:目的相机外参标定是ADAS(advanced driver-assistance systems)等应用领域的关键环节。传统的相机外参标定方法通常依赖特定场景和特定标志物,无法实时实地进行动态标定。部分结合SLAM(simultaneous localization and mapping)或VIO(visual inertia odometry)的外参标定方法依赖于点特征匹配,且精度往往不高。针对ADAS应用,本文提出了一种相机地图匹配的外参自校正方法。方法首先通过深度学习对图像中的车道线进行检测提取,数据筛选及后处理完成后,作为优化问题的输入;其次通过最近邻域解决车道线点关联,并在像平面内定义重投影误差;最后,通过梯度下降方法迭代求解最优的相机外参矩阵,使得像平面内检测车道线与地图车道线真值重投影匹配误差最小。结果在开放道路上的测试车辆显示,本文方法经过多次迭代后收敛至正确的外参,其旋转角精度小于0.2°,平移精度小于0.2 m,对比基于消失点或VIO的标定方法(精度为2.2°及0.3 m),本文方法精度具备明显优势。同时,在相机外参动态改变时,所提出方法可迅速收敛至相机新外参。结论本文方法不依赖于特定场景,支持实时迭代优化进行外参优化,有效提高了相机外参精确度,精度满足ADAS需求。关键词:外参标定;地图匹配;车道线;梯度下降;在线标定172|332|1更新时间:2024-05-08

摘要:目的相机外参标定是ADAS(advanced driver-assistance systems)等应用领域的关键环节。传统的相机外参标定方法通常依赖特定场景和特定标志物,无法实时实地进行动态标定。部分结合SLAM(simultaneous localization and mapping)或VIO(visual inertia odometry)的外参标定方法依赖于点特征匹配,且精度往往不高。针对ADAS应用,本文提出了一种相机地图匹配的外参自校正方法。方法首先通过深度学习对图像中的车道线进行检测提取,数据筛选及后处理完成后,作为优化问题的输入;其次通过最近邻域解决车道线点关联,并在像平面内定义重投影误差;最后,通过梯度下降方法迭代求解最优的相机外参矩阵,使得像平面内检测车道线与地图车道线真值重投影匹配误差最小。结果在开放道路上的测试车辆显示,本文方法经过多次迭代后收敛至正确的外参,其旋转角精度小于0.2°,平移精度小于0.2 m,对比基于消失点或VIO的标定方法(精度为2.2°及0.3 m),本文方法精度具备明显优势。同时,在相机外参动态改变时,所提出方法可迅速收敛至相机新外参。结论本文方法不依赖于特定场景,支持实时迭代优化进行外参优化,有效提高了相机外参精确度,精度满足ADAS需求。关键词:外参标定;地图匹配;车道线;梯度下降;在线标定172|332|1更新时间:2024-05-08 -

摘要:目的激光雷达实时定位与建图(simultaneous localization and mapping,SLAM)是智能机器人领域的重要组成部分,通过对周边环境的3维建模,可以实现无人驾驶车辆的自主定位和精准导航。针对目前单个车辆激光雷达建图周期长、算力需求大的现状,提出了基于边缘计算的多车协同建图方法,能够有效地负载均衡,在保证单个车辆精准定位的同时,增加多个车辆之间的地图重用性。方法构建基于阈值的卸载函数,论证边缘计算下的多车卸载决策属于势博弈问题,设计实现基于边缘计算的势博弈卸载算法,在模型具有纳什均衡的基础上实现任务调度,引入

摘要:目的激光雷达实时定位与建图(simultaneous localization and mapping,SLAM)是智能机器人领域的重要组成部分,通过对周边环境的3维建模,可以实现无人驾驶车辆的自主定位和精准导航。针对目前单个车辆激光雷达建图周期长、算力需求大的现状,提出了基于边缘计算的多车协同建图方法,能够有效地负载均衡,在保证单个车辆精准定位的同时,增加多个车辆之间的地图重用性。方法构建基于阈值的卸载函数,论证边缘计算下的多车卸载决策属于势博弈问题,设计实现基于边缘计算的势博弈卸载算法,在模型具有纳什均衡的基础上实现任务调度,引入$\alpha $ 关键词:边缘计算;激光雷达实时定位与构图(SLAM);任务卸载;多车协同;无人驾驶200|176|3更新时间:2024-05-08

高精地图构建与SLAM

0