最新刊期

2020 年 第 25 卷 第 10 期

编者按

序言

-

摘要:深度学习能自动从大样本数据中学习获得优良的特征表达,有效提升各种机器学习任务的性能,已广泛应用于信号处理、计算机视觉和自然语言处理等诸多领域。基于深度学习的医学影像智能计算是目前智慧医疗领域的研究热点,其中深度学习方法已经应用于医学影像处理、分析的全流程。由于医学影像内在的特殊性、复杂性,特别是考虑到医学影像领域普遍存在的小样本问题,相关学习任务和应用场景对深度学习方法提出了新要求。本文以临床常用的X射线、超声、计算机断层扫描和磁共振等4种影像为例,对深度学习在医学影像中的应用现状进行综述,特别面向图像重建、病灶检测、图像分割、图像配准和计算机辅助诊断这5大任务的主要深度学习方法的进展进行介绍,并对发展趋势进行展望。关键词:深度学习;医学影像;图像重建;病灶检测;图像分割;图像配准;计算机辅助诊断1473|588|37更新时间:2024-05-07

摘要:深度学习能自动从大样本数据中学习获得优良的特征表达,有效提升各种机器学习任务的性能,已广泛应用于信号处理、计算机视觉和自然语言处理等诸多领域。基于深度学习的医学影像智能计算是目前智慧医疗领域的研究热点,其中深度学习方法已经应用于医学影像处理、分析的全流程。由于医学影像内在的特殊性、复杂性,特别是考虑到医学影像领域普遍存在的小样本问题,相关学习任务和应用场景对深度学习方法提出了新要求。本文以临床常用的X射线、超声、计算机断层扫描和磁共振等4种影像为例,对深度学习在医学影像中的应用现状进行综述,特别面向图像重建、病灶检测、图像分割、图像配准和计算机辅助诊断这5大任务的主要深度学习方法的进展进行介绍,并对发展趋势进行展望。关键词:深度学习;医学影像;图像重建;病灶检测;图像分割;图像配准;计算机辅助诊断1473|588|37更新时间:2024-05-07 -

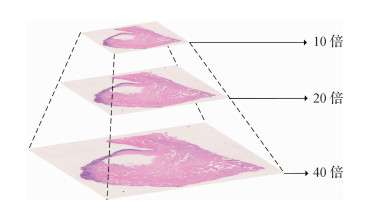

摘要:组织病理学是临床上肿瘤诊断的金标准,直接关系到治疗的开展与预后的评估。来自临床的需求为组织病理诊断提出了质量与效率两个方面的挑战。组织病理诊断涉及大量繁重的病理切片判读任务,高度依赖医生的经验,但病理医生的培养周期长,人才储备缺口巨大,病理科室普遍超负荷工作。近年来出现的基于深度学习的组织病理辅助诊断方法可以帮助医生提高诊断工作的精度与速度,缓解病理诊断资源不足的问题,引起了研究人员的广泛关注。本文初步综述深度学习方法在组织病理学中的相关研究工作。介绍了组织病理诊断的医学背景,整理了组织病理学领域的主要数据集,重点介绍倍受关注的乳腺癌、淋巴结转移癌、结肠癌的病理数据及其分析任务。本文归纳了数据的存储与处理、模型的设计与优化以及小样本与弱标注学习这3项需要解决的技术问题。围绕这些问题,本文介绍了包括数据存储、数据预处理、分类模型、分割模型、迁移学习和多示例学习等相关研究工作。最后总结了面向组织病理学诊断的深度学习方法研究现状,并指出当下研究工作可能的改进方向。关键词:组织病理学;深度学习;卷积神经网络;迁移学习;多示例学习205|277|9更新时间:2024-05-07

摘要:组织病理学是临床上肿瘤诊断的金标准,直接关系到治疗的开展与预后的评估。来自临床的需求为组织病理诊断提出了质量与效率两个方面的挑战。组织病理诊断涉及大量繁重的病理切片判读任务,高度依赖医生的经验,但病理医生的培养周期长,人才储备缺口巨大,病理科室普遍超负荷工作。近年来出现的基于深度学习的组织病理辅助诊断方法可以帮助医生提高诊断工作的精度与速度,缓解病理诊断资源不足的问题,引起了研究人员的广泛关注。本文初步综述深度学习方法在组织病理学中的相关研究工作。介绍了组织病理诊断的医学背景,整理了组织病理学领域的主要数据集,重点介绍倍受关注的乳腺癌、淋巴结转移癌、结肠癌的病理数据及其分析任务。本文归纳了数据的存储与处理、模型的设计与优化以及小样本与弱标注学习这3项需要解决的技术问题。围绕这些问题,本文介绍了包括数据存储、数据预处理、分类模型、分割模型、迁移学习和多示例学习等相关研究工作。最后总结了面向组织病理学诊断的深度学习方法研究现状,并指出当下研究工作可能的改进方向。关键词:组织病理学;深度学习;卷积神经网络;迁移学习;多示例学习205|277|9更新时间:2024-05-07 -

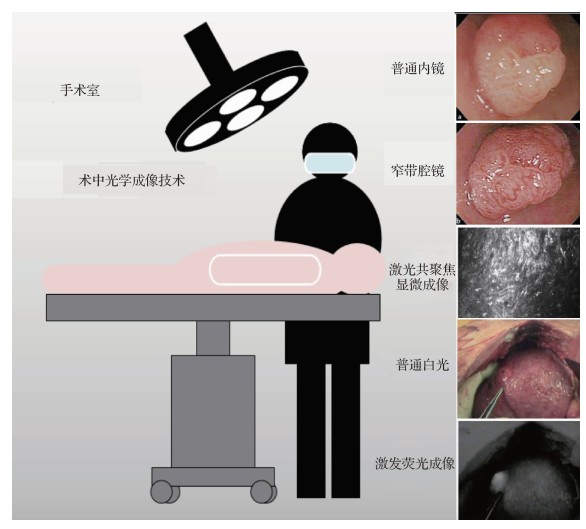

摘要:术中光学成像技术的兴起为临床手术提供了更加便捷和直观的观察手段。传统的术中光学成像方法包括开放式光学成像和术中腔镜、内镜成像等,这些方法保障了临床手术的顺利进行,同时也促进了微创手术的发展。随后发展起来的术中光学成像技术还有窄带腔镜成像、术中激光共聚焦显微成像和近红外激发荧光成像等。术中光学成像技术可以辅助医生精准定位肿瘤、快速区分良恶性组织和检测微小病灶等,在诸多临床应用领域表现出了较好的应用效果。但术中光学成像技术也存在成像质量受限、缺乏有力的成像分析工具,以及只能成像表浅组织的问题。机器学习的加入,有望突破瓶颈,进一步推动术中光学成像技术的发展。本文针对术中光学成像技术,对机器学习在这一领域的应用研究展开调研,具体包括:机器学习对术中光学成像质量的优化、辅助术中光学成像的智能分析,以及辅助基于术中光学影像的3维建模等内容。本文对机器学习在术中光学成像领域的应用进行总结和分析,特别叙述了深度学习方法在该领域的应用前景,为后续的研究提供更宽泛的思路。关键词:术中光学成像技术;机器学习;成像优化;成像智能分析;3维建模29|22|0更新时间:2024-05-07

摘要:术中光学成像技术的兴起为临床手术提供了更加便捷和直观的观察手段。传统的术中光学成像方法包括开放式光学成像和术中腔镜、内镜成像等,这些方法保障了临床手术的顺利进行,同时也促进了微创手术的发展。随后发展起来的术中光学成像技术还有窄带腔镜成像、术中激光共聚焦显微成像和近红外激发荧光成像等。术中光学成像技术可以辅助医生精准定位肿瘤、快速区分良恶性组织和检测微小病灶等,在诸多临床应用领域表现出了较好的应用效果。但术中光学成像技术也存在成像质量受限、缺乏有力的成像分析工具,以及只能成像表浅组织的问题。机器学习的加入,有望突破瓶颈,进一步推动术中光学成像技术的发展。本文针对术中光学成像技术,对机器学习在这一领域的应用研究展开调研,具体包括:机器学习对术中光学成像质量的优化、辅助术中光学成像的智能分析,以及辅助基于术中光学影像的3维建模等内容。本文对机器学习在术中光学成像领域的应用进行总结和分析,特别叙述了深度学习方法在该领域的应用前景,为后续的研究提供更宽泛的思路。关键词:术中光学成像技术;机器学习;成像优化;成像智能分析;3维建模29|22|0更新时间:2024-05-07

综述

-

摘要:医学影像的诊断是许多临床决策的基础,而医学影像的智能分析是医疗人工智能的重要组成部分。与此同时,随着越来越多3D空间传感器的兴起和普及,3D计算机视觉正变得越发重要。本文关注医学影像分析和3D计算机的交叉领域,即医学3D计算机视觉或医学3D视觉。本文将医学3D计算机视觉系统划分为任务、数据和表征3个层面,并结合最新文献呈现这3个层面的研究进展。在任务层面,介绍医学3D计算机视觉中的分类、分割、检测、配准和成像重建,以及这些任务在临床诊断和医学影像分析中的作用和特点。在数据层面,简要介绍了医学3D数据中最重要的数据模态:包括计算机断层成像(computed tomography,CT)、磁共振成像(magnetic resonance imaging,MRI)、正电子放射断层成像(positron emission tomography,PET)等,以及一些新兴研究提出的其他数据格式。在此基础上,整理了医学3D计算机视觉中重要的研究数据集,并标注其数据模态和主要视觉任务。在表征层面,介绍并讨论了2D网络、3D网络和混合网络在医学3D数据的表征学习上的优缺点。此外,针对医学影像中普遍存在的小数据问题,重点讨论了医学3D数据表征学习中的预训练问题。最后,总结了目前医学3D计算机视觉的研究现状,并指出目前尚待解决的研究挑战、问题和方向。关键词:医学影像分析;3D计算机视觉;深度学习;卷积神经网络(CNN);预训练158|180|2更新时间:2024-05-07

摘要:医学影像的诊断是许多临床决策的基础,而医学影像的智能分析是医疗人工智能的重要组成部分。与此同时,随着越来越多3D空间传感器的兴起和普及,3D计算机视觉正变得越发重要。本文关注医学影像分析和3D计算机的交叉领域,即医学3D计算机视觉或医学3D视觉。本文将医学3D计算机视觉系统划分为任务、数据和表征3个层面,并结合最新文献呈现这3个层面的研究进展。在任务层面,介绍医学3D计算机视觉中的分类、分割、检测、配准和成像重建,以及这些任务在临床诊断和医学影像分析中的作用和特点。在数据层面,简要介绍了医学3D数据中最重要的数据模态:包括计算机断层成像(computed tomography,CT)、磁共振成像(magnetic resonance imaging,MRI)、正电子放射断层成像(positron emission tomography,PET)等,以及一些新兴研究提出的其他数据格式。在此基础上,整理了医学3D计算机视觉中重要的研究数据集,并标注其数据模态和主要视觉任务。在表征层面,介绍并讨论了2D网络、3D网络和混合网络在医学3D数据的表征学习上的优缺点。此外,针对医学影像中普遍存在的小数据问题,重点讨论了医学3D数据表征学习中的预训练问题。最后,总结了目前医学3D计算机视觉的研究现状,并指出目前尚待解决的研究挑战、问题和方向。关键词:医学影像分析;3D计算机视觉;深度学习;卷积神经网络(CNN);预训练158|180|2更新时间:2024-05-07 -

摘要:点云作为一种重要的3维数据,能够直观地模拟生物器官、组织等的3维结构,基于医学点云数据的分类、分割、配准、目标检测等任务可以辅助医生进行更为准确的诊断和治疗,在临床医学以及个性化医疗器械辅助设计与3D打印有着重要的应用价值。随着深度学习的发展,越来越多的点云算法逐步由传统算法扩展到深度学习算法中。本文对点云算法在医学领域的研究及其应用进行综述,旨在总结目前用于医学领域的点云方法,包括医学点云的特点、获取途径以及数据转换方法;医学点云分割中的传统算法和深度学习算法;以及医学点云的配准任务定义、意义,以及基于有/无特征的配准方法。总结了医学点云在临床应用中仍存在的限制和挑战:1)医学图像重建的人体器官点云分布稀疏且包含噪音、误差;2)医学点云数据集标注困难、制作成本高,可用于训练深度学习模型的公开数据集非常稀少;3)前沿的点云处理算法大都基于自然场景点云数据集训练,这些算法在医学点云处理中的鲁棒性和泛化能力还有待验证。随着医学点云数据集质量和数量的提升,医学点云处理算法的研究将会吸引更多的研究者。关键词:点云;医学应用;深度学习;分割;配准213|80|8更新时间:2024-05-07

摘要:点云作为一种重要的3维数据,能够直观地模拟生物器官、组织等的3维结构,基于医学点云数据的分类、分割、配准、目标检测等任务可以辅助医生进行更为准确的诊断和治疗,在临床医学以及个性化医疗器械辅助设计与3D打印有着重要的应用价值。随着深度学习的发展,越来越多的点云算法逐步由传统算法扩展到深度学习算法中。本文对点云算法在医学领域的研究及其应用进行综述,旨在总结目前用于医学领域的点云方法,包括医学点云的特点、获取途径以及数据转换方法;医学点云分割中的传统算法和深度学习算法;以及医学点云的配准任务定义、意义,以及基于有/无特征的配准方法。总结了医学点云在临床应用中仍存在的限制和挑战:1)医学图像重建的人体器官点云分布稀疏且包含噪音、误差;2)医学点云数据集标注困难、制作成本高,可用于训练深度学习模型的公开数据集非常稀少;3)前沿的点云处理算法大都基于自然场景点云数据集训练,这些算法在医学点云处理中的鲁棒性和泛化能力还有待验证。随着医学点云数据集质量和数量的提升,医学点云处理算法的研究将会吸引更多的研究者。关键词:点云;医学应用;深度学习;分割;配准213|80|8更新时间:2024-05-07 -

摘要:肝脏肿瘤的精确分割是肝脏疾病诊断、手术计划和术后评估的重要步骤。计算机断层成像(computed tomography,CT)能够为肝脏肿瘤的诊断和治疗提供更为全面的信息,分担了医生繁重的阅片工作,更好地提高诊断的准确性。但是由于肝脏肿瘤的类型多样复杂,使得分割成为计算机辅助诊断的重难点问题。肝脏肿瘤CT图像的深度学习分割方法较传统的分割方法取得了明显的性能提升,并获得快速的发展。通过综述肝脏肿瘤图像分割领域的相关文献,本文介绍了肝脏肿瘤分割的常用数据库,总结了肝脏肿瘤CT图像的深度学习分割方法:全卷积网络(fully convolutional network,FCN)、U-Net网络和生成对抗网络(generative adversarial network,GAN)方法,重点给出了各类方法的基本思想、网络架构形式、改进方案以及优缺点等,并对这些方法在典型数据集上的性能表现进行了比较。最后,对肝脏肿瘤深度学习分割方法的未来研究趋势进行了展望。关键词:计算机断层成像(CT);肝脏肿瘤;深度学习;医学图像分割;全卷积网络(FCN);U-Net;生成对抗网络(GAN)235|78|9更新时间:2024-05-07

摘要:肝脏肿瘤的精确分割是肝脏疾病诊断、手术计划和术后评估的重要步骤。计算机断层成像(computed tomography,CT)能够为肝脏肿瘤的诊断和治疗提供更为全面的信息,分担了医生繁重的阅片工作,更好地提高诊断的准确性。但是由于肝脏肿瘤的类型多样复杂,使得分割成为计算机辅助诊断的重难点问题。肝脏肿瘤CT图像的深度学习分割方法较传统的分割方法取得了明显的性能提升,并获得快速的发展。通过综述肝脏肿瘤图像分割领域的相关文献,本文介绍了肝脏肿瘤分割的常用数据库,总结了肝脏肿瘤CT图像的深度学习分割方法:全卷积网络(fully convolutional network,FCN)、U-Net网络和生成对抗网络(generative adversarial network,GAN)方法,重点给出了各类方法的基本思想、网络架构形式、改进方案以及优缺点等,并对这些方法在典型数据集上的性能表现进行了比较。最后,对肝脏肿瘤深度学习分割方法的未来研究趋势进行了展望。关键词:计算机断层成像(CT);肝脏肿瘤;深度学习;医学图像分割;全卷积网络(FCN);U-Net;生成对抗网络(GAN)235|78|9更新时间:2024-05-07 - 摘要:精神分裂症是一种大脑存在结构和功能异常的严重精神疾病,目前尚无十分有效的诊疗手段。许多研究者尝试采用基于磁共振影像的机器学习方法辅助诊断精神分裂症。深度学习由于其强大的特征表示能力,在医学影像等领域得到了广泛的应用,表现出比传统机器学习方法更优异的性能。目前已有论文对深度学习在医学影像领域内的应用进行了详细的总结和分析,却很少有论文对其在具体某一疾病(例如精神分裂症)诊断中的应用进行系统的梳理和总结。因此,本文主要关注深度学习在基于磁共振影像的精神分裂症诊断中的应用。首先介绍了基于磁共振影像的精神分裂症诊断中常用的几种深度学习模型;其次按照数据的不同模态将相关研究划分为:基于结构磁共振成像的方法、基于功能磁共振成像的方法以及基于多模态数据的方法,并对各类方法的具体应用进行了总结;最后针对目前的研究现状,进一步分析和总结出样本量偏小、样本类别不均衡、模型可解释性低、多模态分析中缺失模态数据以及缺少有效融合策略等,是目前该领域研究中存在的主要问题。多中心及纵向数据分析以及针对不同症状亚型的个体化精准诊断模型的构建,是未来该领域研究发展的趋势。本文系统地总结了深度学习在基于磁共振影像的精神分裂症诊断中的应用,分析了该领域面临的问题和下一步的研究方向,对该领域的研究具有一定的参考和指导意义。关键词:深度学习;精神分裂症;磁共振影像;诊断;分类68|92|0更新时间:2024-05-07

-

摘要:2020年3月,世界卫生组织(World Health Organization,WHO)宣布新型冠状病毒肺炎(corona virus disease 2019,COVID-19)为世界大流行病,疫情的爆发给世界各地医疗系统带来巨大压力。现有的COVID-19诊断标准是核酸检测阳性,然而核酸检测假阴性率高达17%~25.5%,为避免漏诊,需要采用基于影像学的AI诊断方法筛查大量疑似病例,扼制疾病传播。本综述将回顾疫情爆发数月以来,基于医学影像的新冠肺炎AI辅助诊断的研究成果。首先介绍CT(computed tomography)和X光片的优缺点,以及COVID-19的放射学特征,然后对数据准备、图像分割和分类识别等AI诊断的关键步骤分别进行阐述,最后介绍COVID-19的跟踪和预后(预先对疾病后续发展过程及结果的判断和估计)。本文还整理了部分公开的COVID-19相关数据集,并对数据标注不足的问题提供了弱监督学习和迁移学习等解决方案。实验验证,AI系统诊断COVID-19的敏感性达到97.4%,特异性达到92.2%,优于放射科医生的诊断结果。其中表现尤为突出的是基于语义分割网络检测COVID-19感染区域,由此可以定量分析感染率。AI系统可以辅助医生诊断和治疗COVID-19,提高放射科医生阅读X光片和CT的效率。关键词:人工智能;新型冠状病毒肺炎(COVID-19);图像分割;计算机辅助诊断;感染区域分割191|214|3更新时间:2024-05-07

摘要:2020年3月,世界卫生组织(World Health Organization,WHO)宣布新型冠状病毒肺炎(corona virus disease 2019,COVID-19)为世界大流行病,疫情的爆发给世界各地医疗系统带来巨大压力。现有的COVID-19诊断标准是核酸检测阳性,然而核酸检测假阴性率高达17%~25.5%,为避免漏诊,需要采用基于影像学的AI诊断方法筛查大量疑似病例,扼制疾病传播。本综述将回顾疫情爆发数月以来,基于医学影像的新冠肺炎AI辅助诊断的研究成果。首先介绍CT(computed tomography)和X光片的优缺点,以及COVID-19的放射学特征,然后对数据准备、图像分割和分类识别等AI诊断的关键步骤分别进行阐述,最后介绍COVID-19的跟踪和预后(预先对疾病后续发展过程及结果的判断和估计)。本文还整理了部分公开的COVID-19相关数据集,并对数据标注不足的问题提供了弱监督学习和迁移学习等解决方案。实验验证,AI系统诊断COVID-19的敏感性达到97.4%,特异性达到92.2%,优于放射科医生的诊断结果。其中表现尤为突出的是基于语义分割网络检测COVID-19感染区域,由此可以定量分析感染率。AI系统可以辅助医生诊断和治疗COVID-19,提高放射科医生阅读X光片和CT的效率。关键词:人工智能;新型冠状病毒肺炎(COVID-19);图像分割;计算机辅助诊断;感染区域分割191|214|3更新时间:2024-05-07 -

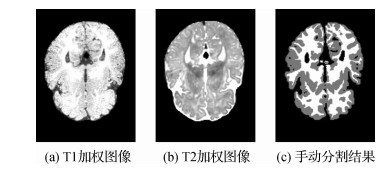

摘要:磁共振(magnetic resonance,MR)成像作为一种安全非侵入式的成像技术,可以提供高分辨率且具有不同对比度的大脑图像,被越来越多地应用于婴儿大脑研究中。将婴儿脑MR图像准确地分割为灰质、白质和脑脊液,是研究早期大脑发育模式不可或缺的基础处理环节。由于在等强度阶段(6~9月龄)婴儿脑MR图像中,灰质和白质信号强度基本一致,组织对比度极低,导致此阶段的脑组织分割非常具有挑战性。基于深度学习的等强度婴儿脑MR图像分割方法,由于其卓越的性能受到研究人员的广泛关注,但目前尚未有文献对该领域的方法进行系统总结和分析。因此本文对目前基于深度学习的等强度婴儿脑MR图像分割方法进行了系统总结,从基本思想、网络架构、性能及优缺点4个方面进行了介绍。并针对其中的典型算法在iSeg-2017数据集上的分割结果进行了对比分析,最后对等强度婴儿脑MR图像分割中存在的问题及未来研究方向进行展望。本文通过对目前基于深度学习的等强度婴儿脑MR图像分割方法进行总结,可以看出深度学习方法已经在等强度期婴儿脑分割中展现出巨大优势,相比传统方法在分割精度和效率上均有较大提升,将进一步促进人类人脑早期发育研究。关键词:磁共振成像;等强度期;婴儿脑分割;深度学习;卷积神经网络101|135|4更新时间:2024-05-07

摘要:磁共振(magnetic resonance,MR)成像作为一种安全非侵入式的成像技术,可以提供高分辨率且具有不同对比度的大脑图像,被越来越多地应用于婴儿大脑研究中。将婴儿脑MR图像准确地分割为灰质、白质和脑脊液,是研究早期大脑发育模式不可或缺的基础处理环节。由于在等强度阶段(6~9月龄)婴儿脑MR图像中,灰质和白质信号强度基本一致,组织对比度极低,导致此阶段的脑组织分割非常具有挑战性。基于深度学习的等强度婴儿脑MR图像分割方法,由于其卓越的性能受到研究人员的广泛关注,但目前尚未有文献对该领域的方法进行系统总结和分析。因此本文对目前基于深度学习的等强度婴儿脑MR图像分割方法进行了系统总结,从基本思想、网络架构、性能及优缺点4个方面进行了介绍。并针对其中的典型算法在iSeg-2017数据集上的分割结果进行了对比分析,最后对等强度婴儿脑MR图像分割中存在的问题及未来研究方向进行展望。本文通过对目前基于深度学习的等强度婴儿脑MR图像分割方法进行总结,可以看出深度学习方法已经在等强度期婴儿脑分割中展现出巨大优势,相比传统方法在分割精度和效率上均有较大提升,将进一步促进人类人脑早期发育研究。关键词:磁共振成像;等强度期;婴儿脑分割;深度学习;卷积神经网络101|135|4更新时间:2024-05-07 -

摘要:残差神经网络(residual neural network,ResNet)及其优化是深度学习研究的热点之一,在医学图像领域应用广泛,在肿瘤、心脑血管和神经系统疾病等重大疾病的临床诊断、分期、转移、治疗决策和靶区勾画方面取得良好效果。本文对残差神经网络的学习优化进行了总结:阐述了残差神经网络学习算法优化,从激活函数、损失函数、参数优化算法、学习衰减率、归一化和正则化技术等6方面进行总结,其中激活函数的改进方法主要有Sigmoid、tanh、ReLU、PReLU(parameteric ReLU)、随机化ReLU(randomized leaky ReLU,RReLU)、ELU(exponential linear units)、Softplus函数、NoisySoftplus函数以及Maxout共9种;损失函数主要有交叉熵损失、均方损失、欧氏距离损失、对比损失、合页损失、Softmax-Loss、L-Softmax Loss、A-Softmax Loss、L2 Softmax Loss、Cosine Loss、Center Loss和焦点损失共12种;学习率衰减总结了8种,即分段常数衰减、多项式衰减、指数衰减、反时限衰减、自然指数衰减、余弦衰减、线性余弦衰减和噪声线性余弦衰减;归一化算法有批量归一化和提出批量重归一化算法;正则化方法主要有增加输入数据、数据增强、早停法、L1正则化、L2正则化、Dropout和Dropout Connect共7种。综述了残差网络模型在医学图像疾病诊断中的应用研究,梳理了残差神经网络在肺部肿瘤、皮肤疾病、乳腺癌、大脑疾病、糖尿病和血液病等6种疾病诊断中的应用研究;对深度学习在医学图像未来发展进行了总结和展望。关键词:深度学习;残差神经网络;优化算法;医学图像;疾病诊断151|247|2更新时间:2024-05-07

摘要:残差神经网络(residual neural network,ResNet)及其优化是深度学习研究的热点之一,在医学图像领域应用广泛,在肿瘤、心脑血管和神经系统疾病等重大疾病的临床诊断、分期、转移、治疗决策和靶区勾画方面取得良好效果。本文对残差神经网络的学习优化进行了总结:阐述了残差神经网络学习算法优化,从激活函数、损失函数、参数优化算法、学习衰减率、归一化和正则化技术等6方面进行总结,其中激活函数的改进方法主要有Sigmoid、tanh、ReLU、PReLU(parameteric ReLU)、随机化ReLU(randomized leaky ReLU,RReLU)、ELU(exponential linear units)、Softplus函数、NoisySoftplus函数以及Maxout共9种;损失函数主要有交叉熵损失、均方损失、欧氏距离损失、对比损失、合页损失、Softmax-Loss、L-Softmax Loss、A-Softmax Loss、L2 Softmax Loss、Cosine Loss、Center Loss和焦点损失共12种;学习率衰减总结了8种,即分段常数衰减、多项式衰减、指数衰减、反时限衰减、自然指数衰减、余弦衰减、线性余弦衰减和噪声线性余弦衰减;归一化算法有批量归一化和提出批量重归一化算法;正则化方法主要有增加输入数据、数据增强、早停法、L1正则化、L2正则化、Dropout和Dropout Connect共7种。综述了残差网络模型在医学图像疾病诊断中的应用研究,梳理了残差神经网络在肺部肿瘤、皮肤疾病、乳腺癌、大脑疾病、糖尿病和血液病等6种疾病诊断中的应用研究;对深度学习在医学图像未来发展进行了总结和展望。关键词:深度学习;残差神经网络;优化算法;医学图像;疾病诊断151|247|2更新时间:2024-05-07 - 摘要:本文综述了体素内不相干运动扩散加权成像(intravoxel incoherent motion diffusion-weighted imaging,IVIM-DWI)及纹理分析技术在术前鉴别宫颈癌组织学亚型及淋巴结转移的临床应用进展。MRI(magnetic resonance imaging)是宫颈癌临床术前最常用的影像学诊断和分期方法。宫颈癌的组织学类型及有无淋巴结转移与患者的生存及预后紧密相关。IVIM-DWI为MRI新型功能成像技术,其D值反映组织内单纯水分子的布朗运动信息、间接反映恶性肿瘤组织细胞密集度;其D*值和f值能提供肿瘤组织内血流灌注的信息。影像组学的纹理分析技术(texture analysis,TA)通过提取肿瘤组织的纹理特征进行客观、定量分析,能检测人眼不能识别的肿瘤组织的微观改变,揭示更多肿瘤组织的灰度分布与定量数据特征,为临床术前预测宫颈癌不同组织学类型及转移淋巴结提供了可能。关键词:宫颈癌;体素内不相干运动扩散加权成像(IVIM-DWI);纹理分析;淋巴结;转移47|79|1更新时间:2024-05-07

- 摘要:随着成像技术的成熟,临床医生及实验人员能获得同时带有时间和空间信息的4D(3D+时间)数据,用于纵向研究疾病变化情况。由于缺乏合适的处理算法,导致明显的信息丢失。为解决这一问题,一些研究发挥人工智能在海量数据处理上的优势进行纵向医学图像分析,研究目标随时间的动态变化。本文对4D时空纵向分析在生物学运动目标追踪、医学影像分割、肿瘤生长预测、血管动力学和神经科学等应用进行综述,重点探讨了人工智能技术与传统分析方法在各应用场景的优劣,并从联合多模态异构数据进行关联分析及联邦学习辅助算法部署两个角度进行前瞻性的探索和可行性分析,突破2D影像处理瓶颈,推动4D设备广泛应用,并为未来时空纵向分析在生物医学领域中的方法学研究及应用场景探索提供思路。关键词:人工智能;医学影像处理;纵向分析;4D影像;时空数据152|166|0更新时间:2024-05-07

前沿进展

-

摘要:目的精准的危及器官(organs at risk,OARs)勾画是肿瘤放射治疗过程中的关键步骤。依赖人工的勾画方式不仅耗费时力,且勾画精度容易受图像质量及医生主观经验等因素的影响。本文提出了一种2D级联卷积神经网络(convolutional neural network,CNN)模型,用于放疗危及器官的自动分割。方法模型主要包含分类器和分割网络两部分。分类器以VGG(visual geometry group)16为骨干结构,通过减少卷积层以及加入全局池化极大地降低了参数量和计算复杂度;分割网络则是以U-Net为基础,用双线性插值代替反卷积对特征图进行上采样,并引入Dropout层来缓解过拟合问题。在预测阶段,先利用分类器从输入图像中筛选出包含指定器官的切片,然后使用分割网络对选定切片进行分割,最后使用移除小连通域等方法对分割结果进一步优化。结果本文所用数据集共包含89例宫颈癌患者的腹盆腔CT(computed tomography)图像,并以中国科学技术大学附属第一医院多位放射医师提供的手工勾画结果作为评估的金标准。在实验部分,本文提出的分类器在6种危及器官(左右股骨、左右股骨头、膀胱和直肠)上的平均分类精度、查准率、召回率和F1-Score分别为98.36%、96.64%、94.1%和95.34%。基于上述分类性能,本文分割方法在测试集上的平均Dice系数为92.94%。结论与已有的CNN分割模型相比,本文方法获得了最佳的分割性能,先分类再分割的策略能够有效地避免标注稀疏问题并减少假阳性分割结果。此外,本文方法与专业放射医师在分割结果上具有良好的一致性,有助于在临床中实现更准确、快速的危及器官分割。关键词:危及器官分割;卷积神经网络;级联模型;放射治疗;宫颈癌84|198|0更新时间:2024-05-07

摘要:目的精准的危及器官(organs at risk,OARs)勾画是肿瘤放射治疗过程中的关键步骤。依赖人工的勾画方式不仅耗费时力,且勾画精度容易受图像质量及医生主观经验等因素的影响。本文提出了一种2D级联卷积神经网络(convolutional neural network,CNN)模型,用于放疗危及器官的自动分割。方法模型主要包含分类器和分割网络两部分。分类器以VGG(visual geometry group)16为骨干结构,通过减少卷积层以及加入全局池化极大地降低了参数量和计算复杂度;分割网络则是以U-Net为基础,用双线性插值代替反卷积对特征图进行上采样,并引入Dropout层来缓解过拟合问题。在预测阶段,先利用分类器从输入图像中筛选出包含指定器官的切片,然后使用分割网络对选定切片进行分割,最后使用移除小连通域等方法对分割结果进一步优化。结果本文所用数据集共包含89例宫颈癌患者的腹盆腔CT(computed tomography)图像,并以中国科学技术大学附属第一医院多位放射医师提供的手工勾画结果作为评估的金标准。在实验部分,本文提出的分类器在6种危及器官(左右股骨、左右股骨头、膀胱和直肠)上的平均分类精度、查准率、召回率和F1-Score分别为98.36%、96.64%、94.1%和95.34%。基于上述分类性能,本文分割方法在测试集上的平均Dice系数为92.94%。结论与已有的CNN分割模型相比,本文方法获得了最佳的分割性能,先分类再分割的策略能够有效地避免标注稀疏问题并减少假阳性分割结果。此外,本文方法与专业放射医师在分割结果上具有良好的一致性,有助于在临床中实现更准确、快速的危及器官分割。关键词:危及器官分割;卷积神经网络;级联模型;放射治疗;宫颈癌84|198|0更新时间:2024-05-07 -

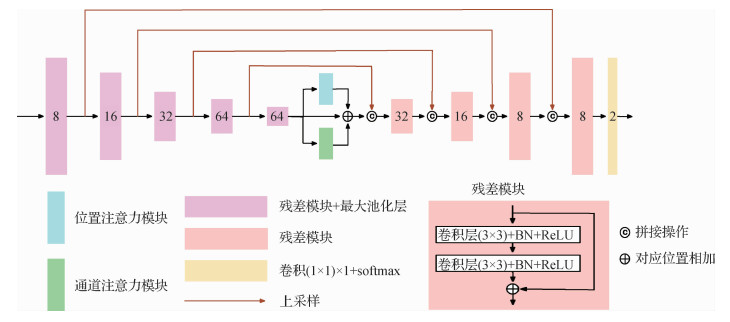

摘要:目的精确的肺肿瘤分割对肺癌诊断、手术规划以及放疗具有重要意义。计算机断层扫描(computed tomography,CT)是肺癌诊疗中最重要的辅助手段,但阅片是一项依靠医生主观经验、劳动密集型的工作,容易造成诊断结果的不稳定,实现快速、稳定和准确的肺肿瘤自动分割方法是当前研究的热点。随着深度学习的发展,使用卷积神经网络进行肺肿瘤的自动分割成为了主流。本文针对3D U-Net准确度不足,容易出现假阳性的问题,设计并实现了3维卷积神经网络DAU-Net(dual attention U-Net)。方法首先对数据进行预处理,调整CT图像切片内的像素间距,设置窗宽、窗位,并通过裁剪去除CT图像中的冗余信息。DAU-Net以3D U-Net为基础结构,将每两个相邻的卷积层替换为残差结构,并在收缩路径和扩张路径中间加入并联在一起的位置注意力模块和通道注意力模块。预测时,采用连通域分析对网络输出的二值图像进行后处理,通过判断每个像素与周围26个像素的连通关系获取所有的连通域,并清除最大连通域外的其他区域,进一步提升分割精度。结果实验数据来自上海胸科医院,总共1 010例肺癌患者,每例数据只包含一个病灶,专业的放射科医师提供了金标准,实验采用十折交叉验证。结果表明,本文提出的肺肿瘤分割算法与3D U-Net相比,Dice系数和哈斯多夫距离分别提升了2.5%和9.7%,假阳性率减少了13.6%。结论本文算法能够有效提升肺肿瘤的分割精度,有助于实现肺癌的快速、稳定和准确分割。关键词:U-Net;计算机断层扫描(CT);肺部肿瘤;分割;注意力机制144|78|8更新时间:2024-05-07

摘要:目的精确的肺肿瘤分割对肺癌诊断、手术规划以及放疗具有重要意义。计算机断层扫描(computed tomography,CT)是肺癌诊疗中最重要的辅助手段,但阅片是一项依靠医生主观经验、劳动密集型的工作,容易造成诊断结果的不稳定,实现快速、稳定和准确的肺肿瘤自动分割方法是当前研究的热点。随着深度学习的发展,使用卷积神经网络进行肺肿瘤的自动分割成为了主流。本文针对3D U-Net准确度不足,容易出现假阳性的问题,设计并实现了3维卷积神经网络DAU-Net(dual attention U-Net)。方法首先对数据进行预处理,调整CT图像切片内的像素间距,设置窗宽、窗位,并通过裁剪去除CT图像中的冗余信息。DAU-Net以3D U-Net为基础结构,将每两个相邻的卷积层替换为残差结构,并在收缩路径和扩张路径中间加入并联在一起的位置注意力模块和通道注意力模块。预测时,采用连通域分析对网络输出的二值图像进行后处理,通过判断每个像素与周围26个像素的连通关系获取所有的连通域,并清除最大连通域外的其他区域,进一步提升分割精度。结果实验数据来自上海胸科医院,总共1 010例肺癌患者,每例数据只包含一个病灶,专业的放射科医师提供了金标准,实验采用十折交叉验证。结果表明,本文提出的肺肿瘤分割算法与3D U-Net相比,Dice系数和哈斯多夫距离分别提升了2.5%和9.7%,假阳性率减少了13.6%。结论本文算法能够有效提升肺肿瘤的分割精度,有助于实现肺癌的快速、稳定和准确分割。关键词:U-Net;计算机断层扫描(CT);肺部肿瘤;分割;注意力机制144|78|8更新时间:2024-05-07 -

摘要:目的从医学影像中进行肝脏与肿瘤分割是计算机辅助诊断和治疗的重要前提。常见的胸部和腹部扫描成像效果中,图像对比度偏低,边界模糊,需要医生丰富的临床解剖学知识才能准确地分割,所以精确的自动分割是一个极大的挑战。本文结合深度学习与医学影像组学,提出一种肝脏肿瘤CT(computed tomography)分割方法。方法首先建立一个级联的2D图像端到端分割模型对肝脏和肿瘤同时进行分割,分割模型采用U-Net深度网络框架,在编码器与解码器内部模块以及编码器与解码器层次之间进行密集连接,这种多样化的特征融合可以获取更准确的全局位置特征和更丰富的局部细节纹理特征;同时融入子像素卷积与注意力机制,有利于分割出更加微小的肿瘤区域;接着生成两个用于后处理的学习模型,一个基于影像组学的分类模型用于假阳性肿瘤的去除;另一个基于3D体素块的分类模型用于分割边缘的细化。结果实验数据来自某医院影像科300个肝癌病例CT,每个序列中的肝脏与肿瘤都是由10年以上的医学专家进行分割标注。对数据进行5倍交叉验证,敏感度(sensitivity)、命中率(positive predicted value)和戴斯系数(Dice coefficient)在验证结果中的平均值分别达到0.87±0.03、0.91±0.03和0.86±0.05,相比于性能第2的模型分别提高了0.03、0.02和0.04。结论肝脏肿瘤CT的精确分割可以形成有价值的术前预判、术中监测和术后评价,有助于制定完善的手术治疗方案,提高肝脏肿瘤手术的成功率,且该方法不局限于肝脏肿瘤的分割,同样也适用于其他医学影像组织器官与肿瘤的分割。关键词:深度学习;影像组学;全卷积网络;注意力模型;密集连接107|251|6更新时间:2024-05-07

摘要:目的从医学影像中进行肝脏与肿瘤分割是计算机辅助诊断和治疗的重要前提。常见的胸部和腹部扫描成像效果中,图像对比度偏低,边界模糊,需要医生丰富的临床解剖学知识才能准确地分割,所以精确的自动分割是一个极大的挑战。本文结合深度学习与医学影像组学,提出一种肝脏肿瘤CT(computed tomography)分割方法。方法首先建立一个级联的2D图像端到端分割模型对肝脏和肿瘤同时进行分割,分割模型采用U-Net深度网络框架,在编码器与解码器内部模块以及编码器与解码器层次之间进行密集连接,这种多样化的特征融合可以获取更准确的全局位置特征和更丰富的局部细节纹理特征;同时融入子像素卷积与注意力机制,有利于分割出更加微小的肿瘤区域;接着生成两个用于后处理的学习模型,一个基于影像组学的分类模型用于假阳性肿瘤的去除;另一个基于3D体素块的分类模型用于分割边缘的细化。结果实验数据来自某医院影像科300个肝癌病例CT,每个序列中的肝脏与肿瘤都是由10年以上的医学专家进行分割标注。对数据进行5倍交叉验证,敏感度(sensitivity)、命中率(positive predicted value)和戴斯系数(Dice coefficient)在验证结果中的平均值分别达到0.87±0.03、0.91±0.03和0.86±0.05,相比于性能第2的模型分别提高了0.03、0.02和0.04。结论肝脏肿瘤CT的精确分割可以形成有价值的术前预判、术中监测和术后评价,有助于制定完善的手术治疗方案,提高肝脏肿瘤手术的成功率,且该方法不局限于肝脏肿瘤的分割,同样也适用于其他医学影像组织器官与肿瘤的分割。关键词:深度学习;影像组学;全卷积网络;注意力模型;密集连接107|251|6更新时间:2024-05-07 -

摘要:目的新冠肺炎(COVID-19)已经成为全球大流行疾病,在全球范围数百万人确诊。基于计算机断层扫描(computed tomography,CT)数据的影像学分析是临床诊断的重要手段。为了实现快速高效高精度地检测,提出了一种超级计算支撑的新冠肺炎CT影像综合分析辅助系统构建方法。方法系统整个处理流程依次包括输入处理模块、预处理模块、影像学分析子系统和人工智能(artifiaial intelligence,AI)分析子系统4部分。其中影像学分析子系统通过分析肺实变、磨玻璃影和铺路石等影像学典型特征检测是否有肺炎和典型新冠肺炎特征,给出肺炎影像分析结论;AI分析子系统通过构建深度学习模型来区分普通病毒肺炎与新冠肺炎,增加肺炎的筛查甄别能力。结果系统发布以来,持续稳定地为国内外超过三十家医院与一百多家科研机构提供了新冠肺炎辅助诊断服务和科研支撑,为抗击疫情提供重要支撑。结论本文提出的超级计算支撑的新冠肺炎CT影像综合分析辅助系统构建方法,取得了应用效果,是一种有效实现快速部署服务、对突发疫情提供高效支撑的服务方式。关键词:新冠肺炎(COVID-19);CT影像;辅助诊断;人工智能;超级计算76|156|2更新时间:2024-05-07

摘要:目的新冠肺炎(COVID-19)已经成为全球大流行疾病,在全球范围数百万人确诊。基于计算机断层扫描(computed tomography,CT)数据的影像学分析是临床诊断的重要手段。为了实现快速高效高精度地检测,提出了一种超级计算支撑的新冠肺炎CT影像综合分析辅助系统构建方法。方法系统整个处理流程依次包括输入处理模块、预处理模块、影像学分析子系统和人工智能(artifiaial intelligence,AI)分析子系统4部分。其中影像学分析子系统通过分析肺实变、磨玻璃影和铺路石等影像学典型特征检测是否有肺炎和典型新冠肺炎特征,给出肺炎影像分析结论;AI分析子系统通过构建深度学习模型来区分普通病毒肺炎与新冠肺炎,增加肺炎的筛查甄别能力。结果系统发布以来,持续稳定地为国内外超过三十家医院与一百多家科研机构提供了新冠肺炎辅助诊断服务和科研支撑,为抗击疫情提供重要支撑。结论本文提出的超级计算支撑的新冠肺炎CT影像综合分析辅助系统构建方法,取得了应用效果,是一种有效实现快速部署服务、对突发疫情提供高效支撑的服务方式。关键词:新冠肺炎(COVID-19);CT影像;辅助诊断;人工智能;超级计算76|156|2更新时间:2024-05-07 -

摘要:目的放射治疗是鼻咽癌的主要治疗方式之一,精准的肿瘤靶区分割是提升肿瘤放疗控制率和减小放疗毒性的关键因素,但常用的手工勾画时间长且勾画者之间存在差异。本文探究Deeplabv3+卷积神经网络模型用于鼻咽癌原发肿瘤放疗靶区(primary tumor gross target volume,GTVp)自动分割的可行性。方法利用Deeplabv3+网络搭建端到端的自动分割框架,以150例已进行调强放射治疗的鼻咽癌患者CT(computed tomography)影像和GTVp轮廓为研究对象,随机选取其中15例作为测试集。以戴斯相似系数(Dice similarity coefficient,DSC)、杰卡德系数(Jaccard index,JI)、平均表面距离(average surface distance,ASD)和豪斯多夫距离(Hausdorff distance,HD)为评估标准,详细比较Deeplabv3+网络模型、U-Net网络模型的自动分割结果与临床医生手工勾画的差异。结果研究发现测试集患者的平均DSC值为0.76±0.11,平均JI值为0.63±0.13,平均ASD值为(3.4±2.0)mm,平均HD值为(10.9±8.6)mm。相比U-Net模型,Deeplabv3+网络模型的平均DSC值和JI值分别提升了3%~4%,平均ASD值减小了0.4 mm,HD值无统计学差异。结论研究表明,Deeplabv3+网络模型相比U-Net模型采用了新型编码—解码网络和带孔空间金字塔网络结构,提升了分割精度,有望提高GTVp的勾画效率和一致性,但在临床实践中需仔细审核自动分割结果。关键词:自动分割;放射治疗;卷积神经网络;原发肿瘤放疗靶区;鼻咽癌31|27|0更新时间:2024-05-07

摘要:目的放射治疗是鼻咽癌的主要治疗方式之一,精准的肿瘤靶区分割是提升肿瘤放疗控制率和减小放疗毒性的关键因素,但常用的手工勾画时间长且勾画者之间存在差异。本文探究Deeplabv3+卷积神经网络模型用于鼻咽癌原发肿瘤放疗靶区(primary tumor gross target volume,GTVp)自动分割的可行性。方法利用Deeplabv3+网络搭建端到端的自动分割框架,以150例已进行调强放射治疗的鼻咽癌患者CT(computed tomography)影像和GTVp轮廓为研究对象,随机选取其中15例作为测试集。以戴斯相似系数(Dice similarity coefficient,DSC)、杰卡德系数(Jaccard index,JI)、平均表面距离(average surface distance,ASD)和豪斯多夫距离(Hausdorff distance,HD)为评估标准,详细比较Deeplabv3+网络模型、U-Net网络模型的自动分割结果与临床医生手工勾画的差异。结果研究发现测试集患者的平均DSC值为0.76±0.11,平均JI值为0.63±0.13,平均ASD值为(3.4±2.0)mm,平均HD值为(10.9±8.6)mm。相比U-Net模型,Deeplabv3+网络模型的平均DSC值和JI值分别提升了3%~4%,平均ASD值减小了0.4 mm,HD值无统计学差异。结论研究表明,Deeplabv3+网络模型相比U-Net模型采用了新型编码—解码网络和带孔空间金字塔网络结构,提升了分割精度,有望提高GTVp的勾画效率和一致性,但在临床实践中需仔细审核自动分割结果。关键词:自动分割;放射治疗;卷积神经网络;原发肿瘤放疗靶区;鼻咽癌31|27|0更新时间:2024-05-07

计算机断层扫描图像

-

摘要:目的脑肿瘤是一种严重威胁人类健康的疾病。利用计算机辅助诊断进行脑肿瘤分割对于患者的预后和治疗具有重要的临床意义。3D卷积神经网络因具有空间特征提取充分、分割效果好等优点,广泛应用于脑肿瘤分割领域。但由于其存在显存占用量巨大、对硬件资源要求较高等问题,通常需要在网络结构中做出折衷,以牺牲精度或训练速度的方式来适应给定的内存预算。基于以上问题,提出一种轻量级分割算法。方法使用组卷积来代替常规卷积以显著降低显存占用,并通过多纤单元与通道混合单元增强各组间信息交流。为充分利用多显卡协同计算的优势,使用跨卡同步批量归一化以缓解3D卷积神经网络因批量值过小所导致的训练效果差等问题。最后提出一种加权混合损失函数,提高分割准确性的同时加快模型收敛速度。结果使用脑肿瘤公开数据集BraTS2018进行测试,本文算法在肿瘤整体区、肿瘤核心区和肿瘤增强区的平均Dice值分别可达90.67%、85.06%和80.41%,参数量和计算量分别为3.2 M和20.51 G,与当前脑肿瘤分割最优算法相比,其精度分别仅相差0.01%、0.96%和1.32%,但在参数量和计算量方面分别降低至对比算法的1/12和1/73。结论本文算法通过加权混合损失函数来提高稀疏类分类错误对模型的惩罚,有效平衡不同分割难度类别的训练强度,本文算法可在保持较高精度的同时显著降低计算消耗,为临床医师进行脑肿瘤分割提供有力参考。关键词:核磁共振成像;脑肿瘤分割;深度学习;组卷积;加权混合损失函数51|74|2更新时间:2024-05-07

摘要:目的脑肿瘤是一种严重威胁人类健康的疾病。利用计算机辅助诊断进行脑肿瘤分割对于患者的预后和治疗具有重要的临床意义。3D卷积神经网络因具有空间特征提取充分、分割效果好等优点,广泛应用于脑肿瘤分割领域。但由于其存在显存占用量巨大、对硬件资源要求较高等问题,通常需要在网络结构中做出折衷,以牺牲精度或训练速度的方式来适应给定的内存预算。基于以上问题,提出一种轻量级分割算法。方法使用组卷积来代替常规卷积以显著降低显存占用,并通过多纤单元与通道混合单元增强各组间信息交流。为充分利用多显卡协同计算的优势,使用跨卡同步批量归一化以缓解3D卷积神经网络因批量值过小所导致的训练效果差等问题。最后提出一种加权混合损失函数,提高分割准确性的同时加快模型收敛速度。结果使用脑肿瘤公开数据集BraTS2018进行测试,本文算法在肿瘤整体区、肿瘤核心区和肿瘤增强区的平均Dice值分别可达90.67%、85.06%和80.41%,参数量和计算量分别为3.2 M和20.51 G,与当前脑肿瘤分割最优算法相比,其精度分别仅相差0.01%、0.96%和1.32%,但在参数量和计算量方面分别降低至对比算法的1/12和1/73。结论本文算法通过加权混合损失函数来提高稀疏类分类错误对模型的惩罚,有效平衡不同分割难度类别的训练强度,本文算法可在保持较高精度的同时显著降低计算消耗,为临床医师进行脑肿瘤分割提供有力参考。关键词:核磁共振成像;脑肿瘤分割;深度学习;组卷积;加权混合损失函数51|74|2更新时间:2024-05-07 -

摘要:目的去除颅骨是脑部磁共振图像处理和分析中的重要环节。由于脑部组织结构复杂以及采集设备噪声的影响导致现有方法不能准确分割出脑部区域,为此提出一种深度迭代融合的卷积神经网络模型实现颅骨的准确去除。方法本文DIFNet(deep iteration fusion net)模型的主体结构由编码器和解码器组成,中间的跳跃连接方式由多个上采样迭代融合构成。其中编码器由残差卷积组成,以便浅层语义信息更容易流入深层网络,避免出现梯度消失的现象。解码器网络由双路上采样模块构成,通过具有不同感受野的反卷积操作,将输出的特征图相加后作为模块输出,有效还原更多细节上的特征。引入带有L2正则的Dice损失函数训练网络模型,同时采用内部数据增强方法,有效提高模型的鲁棒性和泛化能力。结果为了验证本文模型的分割性能,分别利用两组数据集与传统分割算法和主流的深度学习分割模型进行对比。在训练数据集同源的NFBS(neurofeedback skull-stripped)测试数据集上,本文方法获得了最高的平均Dice值和灵敏度,分别为99.12%和99.22%。将在NFBS数据集上训练好的模型直接应用于LPBA40(loni probabilistic brain atlas 40)数据集,本文模型的Dice值可达98.16%。结论本文提出的DIFNet模型可以快速、准确地去除颅骨,相比于主流的颅骨分割模型,精度有较高提升,并且模型具有较好的鲁棒性和泛化能力。关键词:卷积神经网络(CNN);颅骨分割;脑部磁共振图像;深度迭代融合;数据增强71|189|0更新时间:2024-05-07

摘要:目的去除颅骨是脑部磁共振图像处理和分析中的重要环节。由于脑部组织结构复杂以及采集设备噪声的影响导致现有方法不能准确分割出脑部区域,为此提出一种深度迭代融合的卷积神经网络模型实现颅骨的准确去除。方法本文DIFNet(deep iteration fusion net)模型的主体结构由编码器和解码器组成,中间的跳跃连接方式由多个上采样迭代融合构成。其中编码器由残差卷积组成,以便浅层语义信息更容易流入深层网络,避免出现梯度消失的现象。解码器网络由双路上采样模块构成,通过具有不同感受野的反卷积操作,将输出的特征图相加后作为模块输出,有效还原更多细节上的特征。引入带有L2正则的Dice损失函数训练网络模型,同时采用内部数据增强方法,有效提高模型的鲁棒性和泛化能力。结果为了验证本文模型的分割性能,分别利用两组数据集与传统分割算法和主流的深度学习分割模型进行对比。在训练数据集同源的NFBS(neurofeedback skull-stripped)测试数据集上,本文方法获得了最高的平均Dice值和灵敏度,分别为99.12%和99.22%。将在NFBS数据集上训练好的模型直接应用于LPBA40(loni probabilistic brain atlas 40)数据集,本文模型的Dice值可达98.16%。结论本文提出的DIFNet模型可以快速、准确地去除颅骨,相比于主流的颅骨分割模型,精度有较高提升,并且模型具有较好的鲁棒性和泛化能力。关键词:卷积神经网络(CNN);颅骨分割;脑部磁共振图像;深度迭代融合;数据增强71|189|0更新时间:2024-05-07 -

摘要:目的现有的医学图像配准算法在处理较大非刚性形变的医学图像时,存在配准精度低和泛化能力不足的问题。针对该问题,提出结合密集残差块和生成对抗网络(generative adversarial network,GAN)的图像配准方法,用于多模态医学图像的非刚性配准。方法将密集残差块引入到生成器,提取待配准图像对的更多高层特征,从而提高配准精度;在GAN中采用最小二乘损失代替逻辑回归构造的交叉熵损失,由于最小二乘损失的收敛条件更严格,同时能缓解梯度消失和过拟合,从而提高配准模型的稳定性;在判别器网络中引入相对平均GAN(relative average GAN,RaGAN),即在标准判别器的基础上增加一项梯度惩罚因子,降低判别器的判别误差,从而相对减少配准模型的配准误差,有助于稳定配准精度。结果在DRIVE(digital retinal images for vessel extraction)数据集上进行训练和验证,在Sunybrook Cardiac数据集和Brain MRI数据集上进行泛化性能测试,并与几种主流医学图像非刚性配准算法进行对比实验,表明,本文配准模型在精度和泛化能力上均有一定程度的提升,相比其他方法,视网膜图像、心脏图像和脑部图像的配准Dice值分别提升了3.3%、3.0%、1.5%。结论提出的配准方法能够获取更多高层特征信息,从而提升配准精度;同时基于最小二乘法构建损失函数并对判别器进行加强,能够使得配准模型在训练阶段快速收敛,提高了配准模型的稳定性和泛化能力,适合存在较大非刚性形变的医学图像的配准。关键词:医学图像;非刚性配准;生成对抗网络(GAN);密集残差块;最小二乘损失;相对平均GAN(RaGAN)33|31|0更新时间:2024-05-07

摘要:目的现有的医学图像配准算法在处理较大非刚性形变的医学图像时,存在配准精度低和泛化能力不足的问题。针对该问题,提出结合密集残差块和生成对抗网络(generative adversarial network,GAN)的图像配准方法,用于多模态医学图像的非刚性配准。方法将密集残差块引入到生成器,提取待配准图像对的更多高层特征,从而提高配准精度;在GAN中采用最小二乘损失代替逻辑回归构造的交叉熵损失,由于最小二乘损失的收敛条件更严格,同时能缓解梯度消失和过拟合,从而提高配准模型的稳定性;在判别器网络中引入相对平均GAN(relative average GAN,RaGAN),即在标准判别器的基础上增加一项梯度惩罚因子,降低判别器的判别误差,从而相对减少配准模型的配准误差,有助于稳定配准精度。结果在DRIVE(digital retinal images for vessel extraction)数据集上进行训练和验证,在Sunybrook Cardiac数据集和Brain MRI数据集上进行泛化性能测试,并与几种主流医学图像非刚性配准算法进行对比实验,表明,本文配准模型在精度和泛化能力上均有一定程度的提升,相比其他方法,视网膜图像、心脏图像和脑部图像的配准Dice值分别提升了3.3%、3.0%、1.5%。结论提出的配准方法能够获取更多高层特征信息,从而提升配准精度;同时基于最小二乘法构建损失函数并对判别器进行加强,能够使得配准模型在训练阶段快速收敛,提高了配准模型的稳定性和泛化能力,适合存在较大非刚性形变的医学图像的配准。关键词:医学图像;非刚性配准;生成对抗网络(GAN);密集残差块;最小二乘损失;相对平均GAN(RaGAN)33|31|0更新时间:2024-05-07

磁共振图像

-

摘要:目的超声检查是诊断甲状腺疾病的主要影像学方法之一,但由于超声图像中斑点强度具有随机性、组织器官复杂等问题,导致甲状腺在不同数据源间的形态、大小和纹理差异性较大,容易导致观察者视觉疲劳。针对甲状腺超声成像存在斑点强度随机性以及周边组织复杂性的问题,为了更准确地描述出器官与病理性病变的解剖边界,提出一种基于频域增强和局部注意力机制的甲状腺超声分割网络。方法针对原始数据采用高低通滤波器获取高低频段的图像信息,整合高频段细节特征与低频段边缘特征,增强图像前背景的对比度,降低图像间的差异性。根据卷积网络中网络深度所提取特征信息量的不同,采用局部注意力机制对高低维特征信息进行自适应激活,增强低维特征的细节信息,弱化对非目标区域的关注,增强高维特征的全局信息,弱化冗余信息对网络的干扰,增强前背景分类以及对非显著性目标检测的能力。采用金字塔级联空洞卷积获取不同感受野的特征信息,解决数据源间图像差异较大的问题。结果实验结果表明,本文方法在11~16 MHz时采集的16个手绘甲状腺超声公开数据集中,通过10折交叉验证显示准确率为0.989,召回率为0.849,精准率为0.940,Dice系数为0.812,效果优于当前其他医学图像分割网络。通过消融实验,证明本文的几个模块对超声图像分割确实具有一定的提升效果。结论本文所提分割网络,结合深度学习模型及传统图像处理模型的优点,能较好地处理超声图像随机斑点并且提升非显著性组织分割效果。关键词:图像分割;频域分析;注意力机制;空洞卷积;超声影像66|176|3更新时间:2024-05-07

摘要:目的超声检查是诊断甲状腺疾病的主要影像学方法之一,但由于超声图像中斑点强度具有随机性、组织器官复杂等问题,导致甲状腺在不同数据源间的形态、大小和纹理差异性较大,容易导致观察者视觉疲劳。针对甲状腺超声成像存在斑点强度随机性以及周边组织复杂性的问题,为了更准确地描述出器官与病理性病变的解剖边界,提出一种基于频域增强和局部注意力机制的甲状腺超声分割网络。方法针对原始数据采用高低通滤波器获取高低频段的图像信息,整合高频段细节特征与低频段边缘特征,增强图像前背景的对比度,降低图像间的差异性。根据卷积网络中网络深度所提取特征信息量的不同,采用局部注意力机制对高低维特征信息进行自适应激活,增强低维特征的细节信息,弱化对非目标区域的关注,增强高维特征的全局信息,弱化冗余信息对网络的干扰,增强前背景分类以及对非显著性目标检测的能力。采用金字塔级联空洞卷积获取不同感受野的特征信息,解决数据源间图像差异较大的问题。结果实验结果表明,本文方法在11~16 MHz时采集的16个手绘甲状腺超声公开数据集中,通过10折交叉验证显示准确率为0.989,召回率为0.849,精准率为0.940,Dice系数为0.812,效果优于当前其他医学图像分割网络。通过消融实验,证明本文的几个模块对超声图像分割确实具有一定的提升效果。结论本文所提分割网络,结合深度学习模型及传统图像处理模型的优点,能较好地处理超声图像随机斑点并且提升非显著性组织分割效果。关键词:图像分割;频域分析;注意力机制;空洞卷积;超声影像66|176|3更新时间:2024-05-07 -

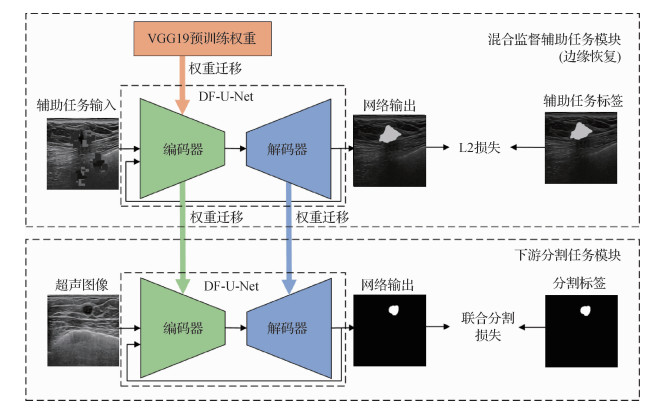

摘要:目的基于超声图像的乳腺病灶分割是实现乳腺癌计算机辅助诊断和定量分析的基本预处理步骤。由于乳腺超声图像病灶边缘通常较为模糊,而且缺乏大量已标注的分割图像,增加了基于深度学习的乳腺超声图像分割难度。本文提出一种混合监督双通道反馈U-Net(hybrid supervised dual-channel feedback U-Net,HSDF-U-Net)算法,提升乳腺超声图像分割的准确性。方法HSDF-U-Net通过融合自监督学习和有监督分割实现混合监督学习,并且进一步通过设计双通道反馈U-Net网络提升图像分割准确性。为了改善标记数据有限的问题,首先在自监督学习框架基础上结合标注分割图像中的标签信息,设计一种边缘恢复的辅助任务,以实现对病灶边缘表征能力更强的预训练模型,然后迁移至下游图像分割任务。为了提升模型在辅助边缘恢复任务和下游分割任务的表现,将循环机制引入经典的U-Net网络,通过将反馈的输出结果重新送入另一个通道,构成双通道编码器,然后解码输出更精确的分割结果。结果在两个公开的乳腺超声图像分割数据集上评估HSDF-U-Net算法性能。HSDF-U-Net对Dataset B数据集中的图像进行分割获得敏感度为0.848 0、Dice为0.826 1、平均对称表面距离为5.81的结果,在Dataset BUSI(breast ultrasound images)数据集上获得敏感度为0.803 9、Dice为0.803 1、平均对称表面距离为6.44的结果。与多种典型的U-Net分割算法相比,上述结果均有提升。结论本文所提HSDF-U-Net算法提升了乳腺超声图像中的病灶分割的精度,具备潜在的应用价值。关键词:乳腺超声图像分割;深度学习;自监督学习;混合监督学习;双通道反馈U-Net42|66|3更新时间:2024-05-07

摘要:目的基于超声图像的乳腺病灶分割是实现乳腺癌计算机辅助诊断和定量分析的基本预处理步骤。由于乳腺超声图像病灶边缘通常较为模糊,而且缺乏大量已标注的分割图像,增加了基于深度学习的乳腺超声图像分割难度。本文提出一种混合监督双通道反馈U-Net(hybrid supervised dual-channel feedback U-Net,HSDF-U-Net)算法,提升乳腺超声图像分割的准确性。方法HSDF-U-Net通过融合自监督学习和有监督分割实现混合监督学习,并且进一步通过设计双通道反馈U-Net网络提升图像分割准确性。为了改善标记数据有限的问题,首先在自监督学习框架基础上结合标注分割图像中的标签信息,设计一种边缘恢复的辅助任务,以实现对病灶边缘表征能力更强的预训练模型,然后迁移至下游图像分割任务。为了提升模型在辅助边缘恢复任务和下游分割任务的表现,将循环机制引入经典的U-Net网络,通过将反馈的输出结果重新送入另一个通道,构成双通道编码器,然后解码输出更精确的分割结果。结果在两个公开的乳腺超声图像分割数据集上评估HSDF-U-Net算法性能。HSDF-U-Net对Dataset B数据集中的图像进行分割获得敏感度为0.848 0、Dice为0.826 1、平均对称表面距离为5.81的结果,在Dataset BUSI(breast ultrasound images)数据集上获得敏感度为0.803 9、Dice为0.803 1、平均对称表面距离为6.44的结果。与多种典型的U-Net分割算法相比,上述结果均有提升。结论本文所提HSDF-U-Net算法提升了乳腺超声图像中的病灶分割的精度,具备潜在的应用价值。关键词:乳腺超声图像分割;深度学习;自监督学习;混合监督学习;双通道反馈U-Net42|66|3更新时间:2024-05-07 -

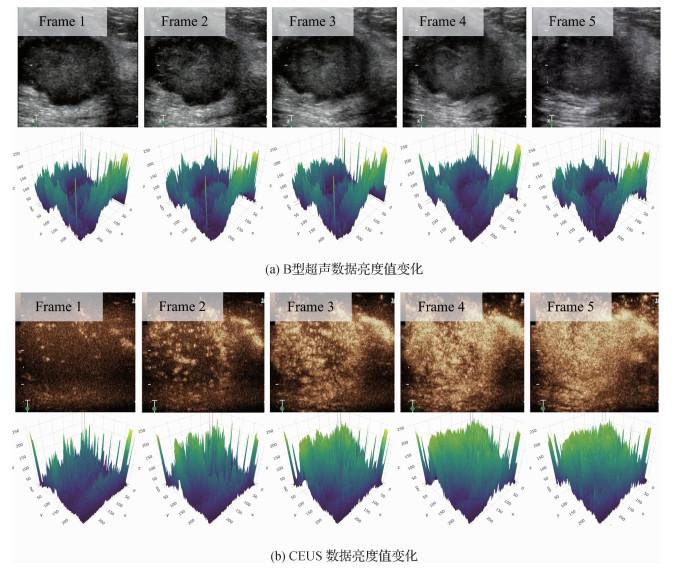

摘要:目的通过深度学习对乳腺癌早期的正确诊断能大幅提高患者生存率。现阶段大部分研究者仅采用B型超声图像作为实验数据,但是B型超声自身的局限性导致分类效果难以提升。针对该问题,提出了一种综合利用B型超声和超声造影视频来提高分类精度的网络模型。方法针对B型超声图像及造影视频双模态数据的特性设计了一个双分支模型架构。针对传统提取视频特征中仅使用单标签的不足,制定了病理多标签预训练。并设计了一种新的双线性协同机制,能更好地融合B型超声和超声造影的特征,提取其中的病理信息并抑制无关噪声。结果为了验证提出方法的有效性,本文设计了3个实验,前两个实验分别对B型超声和超声造影进行预训练。在造影分支,使用根据医学领域设计的病理多标签进行预训练。最后,采用前两个实验的预训练模型进行第3个实验,相比单独使用B型超声图像精度提升6.5%,比单用超声造影视频精度提高7.9%。同时,在使用双模态数据里,本文方法取得了最高精度,相比排名第2的成绩提高了2.7%。结论本文提出的协同约束网络,能对不同模态的数据进行不同处理,以提取出其中的病理特征。一方面,多模态数据确实能从不同角度展示同一个病灶区,为分类模型提供更多的病理特征,进而提高模型的分类精度。另一方面,合适的融合方式也至关重要,能最大程度地利用特征并抑制噪声。关键词:超声造影;双分支网络;双线性融合;协同注意力;乳腺癌分类23|22|1更新时间:2024-05-07

摘要:目的通过深度学习对乳腺癌早期的正确诊断能大幅提高患者生存率。现阶段大部分研究者仅采用B型超声图像作为实验数据,但是B型超声自身的局限性导致分类效果难以提升。针对该问题,提出了一种综合利用B型超声和超声造影视频来提高分类精度的网络模型。方法针对B型超声图像及造影视频双模态数据的特性设计了一个双分支模型架构。针对传统提取视频特征中仅使用单标签的不足,制定了病理多标签预训练。并设计了一种新的双线性协同机制,能更好地融合B型超声和超声造影的特征,提取其中的病理信息并抑制无关噪声。结果为了验证提出方法的有效性,本文设计了3个实验,前两个实验分别对B型超声和超声造影进行预训练。在造影分支,使用根据医学领域设计的病理多标签进行预训练。最后,采用前两个实验的预训练模型进行第3个实验,相比单独使用B型超声图像精度提升6.5%,比单用超声造影视频精度提高7.9%。同时,在使用双模态数据里,本文方法取得了最高精度,相比排名第2的成绩提高了2.7%。结论本文提出的协同约束网络,能对不同模态的数据进行不同处理,以提取出其中的病理特征。一方面,多模态数据确实能从不同角度展示同一个病灶区,为分类模型提供更多的病理特征,进而提高模型的分类精度。另一方面,合适的融合方式也至关重要,能最大程度地利用特征并抑制噪声。关键词:超声造影;双分支网络;双线性融合;协同注意力;乳腺癌分类23|22|1更新时间:2024-05-07 -

摘要:目的深度学习在各种语义分割任务中取得了优异的性能,但需要大量带有准确标注的训练样本。乳腺超声由于其成像特点,导致图像对比度和分辨率低、斑点噪声较高、组织间边界模糊等,这些问题导致精确标注十分困难。超声分割数据集中存在较多非准确的标注,这些数据即标注噪声。若训练集中包含一定量的噪声,将会极大地影响网络的分割准确度。为了解决该问题,提出了一种针对超声图像的动态噪声指数及分割算法,实现在乳腺超声数据包含噪声的情况下肿瘤区域的准确分割。方法针对超声图像的噪声特点提出动态噪声指数(dynamic noise index,DNI);在网络训练过程中实时更新DNI,并在每次迭代结束后计算整个训练集的DNI分布,进而实现对噪声数据的可检测;提出一个改进的损失函数以增强网络噪声检测性能,同时结合DNI降低噪声对训练反向传播的影响。最后本文将动态噪声指数和改进的损失函数联合形成一个噪声容忍框架,该框架可以应用于其他分割网络。结果本文将噪声容忍框架和多种分割网络进行结合,并在两个数据集上进行实验。公开数据集的实验结果显示,增加噪声容忍框架的网络相比于原网络各指标提高了8%~12%。本文构建了一个包含1 805幅图像的乳腺超声肿瘤分割数据集,结合噪声容忍框架之后的网络各指标也取得了4%~7%的提升。结论本文提出的动态噪声指数及分割算法针对不同噪声比例的训练数据集,对噪声均能有效地抑制,并取得稳定的分割性能。关键词:乳腺超声图像;乳腺肿瘤分割;噪声注释;深度学习;损失函数35|19|0更新时间:2024-05-07

摘要:目的深度学习在各种语义分割任务中取得了优异的性能,但需要大量带有准确标注的训练样本。乳腺超声由于其成像特点,导致图像对比度和分辨率低、斑点噪声较高、组织间边界模糊等,这些问题导致精确标注十分困难。超声分割数据集中存在较多非准确的标注,这些数据即标注噪声。若训练集中包含一定量的噪声,将会极大地影响网络的分割准确度。为了解决该问题,提出了一种针对超声图像的动态噪声指数及分割算法,实现在乳腺超声数据包含噪声的情况下肿瘤区域的准确分割。方法针对超声图像的噪声特点提出动态噪声指数(dynamic noise index,DNI);在网络训练过程中实时更新DNI,并在每次迭代结束后计算整个训练集的DNI分布,进而实现对噪声数据的可检测;提出一个改进的损失函数以增强网络噪声检测性能,同时结合DNI降低噪声对训练反向传播的影响。最后本文将动态噪声指数和改进的损失函数联合形成一个噪声容忍框架,该框架可以应用于其他分割网络。结果本文将噪声容忍框架和多种分割网络进行结合,并在两个数据集上进行实验。公开数据集的实验结果显示,增加噪声容忍框架的网络相比于原网络各指标提高了8%~12%。本文构建了一个包含1 805幅图像的乳腺超声肿瘤分割数据集,结合噪声容忍框架之后的网络各指标也取得了4%~7%的提升。结论本文提出的动态噪声指数及分割算法针对不同噪声比例的训练数据集,对噪声均能有效地抑制,并取得稳定的分割性能。关键词:乳腺超声图像;乳腺肿瘤分割;噪声注释;深度学习;损失函数35|19|0更新时间:2024-05-07

超声图像

-

摘要:目的X射线光片是用于诊断多种胸部疾病常用且经济的方法。然而,不同疾病的位置及病灶区域大小在X光片上差异较大且纹理表现存在多样性,是胸部疾病分类任务面临的主要挑战。此外,样本数据类别不平衡进一步增加了任务的困难。针对以上挑战以及目前算法识别精度有待提升的问题,本文采用深度学习方法提出一种基于密集挤压激励网络的多标签胸部疾病分类算法。方法将挤压激励模块同样以密集连接的方式加入密集连接网络中作为特征通道高度注意模块,以增强对于网络正确判断疾病有用信息的传递同时抑制无用信息的传递;使用非对称卷积块增强网络的特征提取能力;采用焦点损失函数,增加难识别疾病的损失权重而减小易识别疾病的损失权重,以增强网络对难识别样本的学习。结果在ChestX-ray14数据集上的实验结果表明,本文算法对14种胸部疾病的分类精度较目前3种经典及先进算法有所提升,平均AUC(area under ROC curve)值达到0.802。另外本文将算法模型在诊断时依据的病灶区域进行可视化,其结果进一步证明了模型的有效性。结论本文提出的基于密集挤压激励网络的多标签分类算法,在胸部疾病识别上的平均AUC值较高,适用于胸部X光片的疾病分类。关键词:胸部X光片;多标签分类;密集连接网络;疾病诊断;医学图像处理111|144|11更新时间:2024-05-07

摘要:目的X射线光片是用于诊断多种胸部疾病常用且经济的方法。然而,不同疾病的位置及病灶区域大小在X光片上差异较大且纹理表现存在多样性,是胸部疾病分类任务面临的主要挑战。此外,样本数据类别不平衡进一步增加了任务的困难。针对以上挑战以及目前算法识别精度有待提升的问题,本文采用深度学习方法提出一种基于密集挤压激励网络的多标签胸部疾病分类算法。方法将挤压激励模块同样以密集连接的方式加入密集连接网络中作为特征通道高度注意模块,以增强对于网络正确判断疾病有用信息的传递同时抑制无用信息的传递;使用非对称卷积块增强网络的特征提取能力;采用焦点损失函数,增加难识别疾病的损失权重而减小易识别疾病的损失权重,以增强网络对难识别样本的学习。结果在ChestX-ray14数据集上的实验结果表明,本文算法对14种胸部疾病的分类精度较目前3种经典及先进算法有所提升,平均AUC(area under ROC curve)值达到0.802。另外本文将算法模型在诊断时依据的病灶区域进行可视化,其结果进一步证明了模型的有效性。结论本文提出的基于密集挤压激励网络的多标签分类算法,在胸部疾病识别上的平均AUC值较高,适用于胸部X光片的疾病分类。关键词:胸部X光片;多标签分类;密集连接网络;疾病诊断;医学图像处理111|144|11更新时间:2024-05-07 -

摘要:目的针对口腔修复体设计中采用标准牙数据库进行再设计时未考虑缺失牙多样性以及个性化程度不足的问题,提出基于高分辨生成式对抗网络(high resolution generative adversarial network,HRGAN)的缺失牙冠个性化设计方法。方法首先,利用图像熵的多方向正交投影方法计算牙体的深度距离值,并构建出咬合面、舌侧面和颊侧面的具有像素值增强的高分辨率深度图像数据集;其次,通过构建的HRGAN模型合成具有高分辨率的缺失牙深度图像,并采用像素—距离的映射关系得到缺失牙齿的3维点云数据;最后,采用点云配准技术和网格重建方法完成3组点云的拼接及3维牙冠形态重建。结果实验采用500副牙冠模型进行训练和测试,通过设置不同损失条件的实验,与不同方法进行比较分析设计牙冠与目标牙冠的偏差。与计算机辅助设计(computer aided design,CAD)方法和基于生成模型的设计方法对比得出,本文构建的HRGAN模型生成的牙冠形态的标准偏差相比前两者分别降低了21.2%和7%,均方根值(root mean square,RMS)分别下降了43.8%和9.8%,并且牙冠咬合面形态与专家设计牙冠形态最为接近。结论本文提出的基于高分辨率生成网络的牙体设计方法能够有效地完成缺失牙体的形态设计,设计的牙冠具有天然牙解剖形态特征。关键词:全冠修复;生成式对抗网络(GAN);图像合成;点云配准;牙齿形态设计69|77|2更新时间:2024-05-07

摘要:目的针对口腔修复体设计中采用标准牙数据库进行再设计时未考虑缺失牙多样性以及个性化程度不足的问题,提出基于高分辨生成式对抗网络(high resolution generative adversarial network,HRGAN)的缺失牙冠个性化设计方法。方法首先,利用图像熵的多方向正交投影方法计算牙体的深度距离值,并构建出咬合面、舌侧面和颊侧面的具有像素值增强的高分辨率深度图像数据集;其次,通过构建的HRGAN模型合成具有高分辨率的缺失牙深度图像,并采用像素—距离的映射关系得到缺失牙齿的3维点云数据;最后,采用点云配准技术和网格重建方法完成3组点云的拼接及3维牙冠形态重建。结果实验采用500副牙冠模型进行训练和测试,通过设置不同损失条件的实验,与不同方法进行比较分析设计牙冠与目标牙冠的偏差。与计算机辅助设计(computer aided design,CAD)方法和基于生成模型的设计方法对比得出,本文构建的HRGAN模型生成的牙冠形态的标准偏差相比前两者分别降低了21.2%和7%,均方根值(root mean square,RMS)分别下降了43.8%和9.8%,并且牙冠咬合面形态与专家设计牙冠形态最为接近。结论本文提出的基于高分辨率生成网络的牙体设计方法能够有效地完成缺失牙体的形态设计,设计的牙冠具有天然牙解剖形态特征。关键词:全冠修复;生成式对抗网络(GAN);图像合成;点云配准;牙齿形态设计69|77|2更新时间:2024-05-07 -

摘要:目的眼底图像中的动静脉分类是许多系统性疾病风险评估的基础步骤。基于传统机器学习的方法操作复杂,且往往依赖于血管提取的结果,不能实现端到端的动静脉分类,而深度语义分割技术的发展使得端到端的动静脉分类成为可能。本文结合深度学习强大的特征提取能力,以提升动静脉分类精度为目的,提出了一种基于语义融合的动静脉分割模型SFU-Net(semantic fusion based U-Net)。方法针对动静脉分类任务的特殊性,本文采用多标签学习的策略来处理该问题,以降低优化难度。针对动静脉特征的高度相似性,本文以DenseNet-121作为SFU-Net的特征提取器,并提出了语义融合模块以增强特征的判别能力。语义融合模块包含特征融合和通道注意力机制两个操作:1)融合不同尺度的语义特征从而得到更具有判别能力的特征;2)自动筛选出对目标任务更加重要的特征,从而提升性能。针对眼底图像中血管与背景像素之间分布不均衡的问题,本文以focal loss作为目标函数,在解决类别不均衡问题的同时重点优化困难样本。结果实验结果表明,本文方法的动静脉分类的性能优于现有绝大多数方法。本文方法在DRIVE(digital retinal images for vessel extraction)数据集上的灵敏性(sensitivity)与目前最优方法相比仅有0.61%的差距,特异性(specificity)、准确率(accuracy)和平衡准确率(balanced-accuracy)与目前最优方法相比分别提高了4.25%,2.68%和1.82%;在WIDE数据集上的准确率与目前最优方法相比提升了6.18%。结论语义融合模块能够有效利用多尺度特征并自动做出特征选择,从而提升性能。本文提出的SFU-Net在动静脉分类任务中表现优异,性能超越了现有绝大多数方法。关键词:眼底图像;动静脉分类;深度学习;语义分割;特征融合50|84|2更新时间:2024-05-07

摘要:目的眼底图像中的动静脉分类是许多系统性疾病风险评估的基础步骤。基于传统机器学习的方法操作复杂,且往往依赖于血管提取的结果,不能实现端到端的动静脉分类,而深度语义分割技术的发展使得端到端的动静脉分类成为可能。本文结合深度学习强大的特征提取能力,以提升动静脉分类精度为目的,提出了一种基于语义融合的动静脉分割模型SFU-Net(semantic fusion based U-Net)。方法针对动静脉分类任务的特殊性,本文采用多标签学习的策略来处理该问题,以降低优化难度。针对动静脉特征的高度相似性,本文以DenseNet-121作为SFU-Net的特征提取器,并提出了语义融合模块以增强特征的判别能力。语义融合模块包含特征融合和通道注意力机制两个操作:1)融合不同尺度的语义特征从而得到更具有判别能力的特征;2)自动筛选出对目标任务更加重要的特征,从而提升性能。针对眼底图像中血管与背景像素之间分布不均衡的问题,本文以focal loss作为目标函数,在解决类别不均衡问题的同时重点优化困难样本。结果实验结果表明,本文方法的动静脉分类的性能优于现有绝大多数方法。本文方法在DRIVE(digital retinal images for vessel extraction)数据集上的灵敏性(sensitivity)与目前最优方法相比仅有0.61%的差距,特异性(specificity)、准确率(accuracy)和平衡准确率(balanced-accuracy)与目前最优方法相比分别提高了4.25%,2.68%和1.82%;在WIDE数据集上的准确率与目前最优方法相比提升了6.18%。结论语义融合模块能够有效利用多尺度特征并自动做出特征选择,从而提升性能。本文提出的SFU-Net在动静脉分类任务中表现优异,性能超越了现有绝大多数方法。关键词:眼底图像;动静脉分类;深度学习;语义分割;特征融合50|84|2更新时间:2024-05-07 -

摘要:目的染色体是遗传信息的重要载体,健康的人体细胞中包含46条染色体,包括22对常染色体和1对性染色体。染色体核型化分析是产前诊断和遗产疾病诊断的重要且常用方法。染色体核型化分析是指从分裂中期的细胞显微镜图像中,分割出染色体并根据染色体的条带进行分组排列的过程。染色体核型化分析通常由细胞学家手工完成,但是这个过程非常费时、繁琐且容易出错。由于染色体的非刚性特质,多条染色体之间存在重叠及交叉现象,致使染色体实例分割非常困难。染色体分割是染色体核型化分析过程中最重要且最困难的一步,因此本文旨在解决重叠、交叉染色体实例分割问题。方法本文基于路径增强网络(PANet)模型,提出AS-PANet(amount segmentation PANet)模型用于解决重叠染色体实例分割问题。在路径增强网络的基础上引入染色体计数领域知识预测作为模型的一个预测分支,并改进了路径增强网络的模型结构和损失函数,使图像分类、目标检测、实例分割和染色体计数4个子任务共享卷积特征,进行联合训练。在临床染色体图像数据上进行标注并构建训练集和测试集,同时提出有效的数据增广方法用以扩充染色体标注训练数据集,提升模型的训练效果。结果在临床染色体数据集中开展实证研究实验。实验结果表明,本文方法在临床染色体数据集中,平均分割精度mAP(mean average precision)为90.63%。该结果比PANet提升了1.18%,比基线模型Mask R-CNN提升了2.85%。分割准确率为85%,相比PANet提升了2%,相比Mask R-CNN(region with convolutional neural network)提升3.75%。结论本文染色体实例分割方法能够更有效地解决临床染色体分割问题,相比现有的方法,分割效果更好。关键词:AS-PANet;路径增强网络;染色体分割;实例分割;染色体核型分析92|112|9更新时间:2024-05-07

摘要:目的染色体是遗传信息的重要载体,健康的人体细胞中包含46条染色体,包括22对常染色体和1对性染色体。染色体核型化分析是产前诊断和遗产疾病诊断的重要且常用方法。染色体核型化分析是指从分裂中期的细胞显微镜图像中,分割出染色体并根据染色体的条带进行分组排列的过程。染色体核型化分析通常由细胞学家手工完成,但是这个过程非常费时、繁琐且容易出错。由于染色体的非刚性特质,多条染色体之间存在重叠及交叉现象,致使染色体实例分割非常困难。染色体分割是染色体核型化分析过程中最重要且最困难的一步,因此本文旨在解决重叠、交叉染色体实例分割问题。方法本文基于路径增强网络(PANet)模型,提出AS-PANet(amount segmentation PANet)模型用于解决重叠染色体实例分割问题。在路径增强网络的基础上引入染色体计数领域知识预测作为模型的一个预测分支,并改进了路径增强网络的模型结构和损失函数,使图像分类、目标检测、实例分割和染色体计数4个子任务共享卷积特征,进行联合训练。在临床染色体图像数据上进行标注并构建训练集和测试集,同时提出有效的数据增广方法用以扩充染色体标注训练数据集,提升模型的训练效果。结果在临床染色体数据集中开展实证研究实验。实验结果表明,本文方法在临床染色体数据集中,平均分割精度mAP(mean average precision)为90.63%。该结果比PANet提升了1.18%,比基线模型Mask R-CNN提升了2.85%。分割准确率为85%,相比PANet提升了2%,相比Mask R-CNN(region with convolutional neural network)提升3.75%。结论本文染色体实例分割方法能够更有效地解决临床染色体分割问题,相比现有的方法,分割效果更好。关键词:AS-PANet;路径增强网络;染色体分割;实例分割;染色体核型分析92|112|9更新时间:2024-05-07 -

摘要:目的可穿戴设备能够长时间实时监测人体心脏状况,其在心电信号监测领域应用广泛。但目前仍没有公开的来自可穿戴设备的心电数据集,大部分心电信号分析算法都是针对医院设备所采集的心电数据。因此,本文使用IREALCARE 2.0柔性远程心电贴作为心电信号监测和采集设备制作了可穿戴设备的心电数据集。针对可穿戴心电数据干扰多、数据量大等特点,本文提出了一种针对可穿戴设备获得的心电信号进行自动分类的深层卷积神经网络,称之为时空卷积神经网络(time-spatial convolutional neural networks,TSCNN)。方法将原始的长时间心电信号分割为单个的心搏并与滤波后不同频段的心搏数据组合成十通道的数据输入到TSCNN中。TSCNN对每个心搏使用时间卷积和空间滤波来提取丰富的特征。采用小卷积核级联卷积的方式提高分类性能,并降低网络的参数量和计算量。结果在本文制作的心电数据集上进行了测试,并与其他4种心电分类算法:CNN(convolutional neural networks)、RNN(recurrent neural networks)、1-DCNN(1-dimensional convolution neural networks)和DCN(dense convolutional networks)进行了比较。实验结果显示,本文方法的分类准确率达到91.16%,优于其他4种方法。结论本文方法面向可穿戴心电数据,获得了较好的分类性能,可以有效监控穿戴者是否出现了心电异常情况。关键词:可穿戴设备;可穿戴心电数据集;心脏监测;卷积神经网络;空间滤波36|39|1更新时间:2024-05-07

摘要:目的可穿戴设备能够长时间实时监测人体心脏状况,其在心电信号监测领域应用广泛。但目前仍没有公开的来自可穿戴设备的心电数据集,大部分心电信号分析算法都是针对医院设备所采集的心电数据。因此,本文使用IREALCARE 2.0柔性远程心电贴作为心电信号监测和采集设备制作了可穿戴设备的心电数据集。针对可穿戴心电数据干扰多、数据量大等特点,本文提出了一种针对可穿戴设备获得的心电信号进行自动分类的深层卷积神经网络,称之为时空卷积神经网络(time-spatial convolutional neural networks,TSCNN)。方法将原始的长时间心电信号分割为单个的心搏并与滤波后不同频段的心搏数据组合成十通道的数据输入到TSCNN中。TSCNN对每个心搏使用时间卷积和空间滤波来提取丰富的特征。采用小卷积核级联卷积的方式提高分类性能,并降低网络的参数量和计算量。结果在本文制作的心电数据集上进行了测试,并与其他4种心电分类算法:CNN(convolutional neural networks)、RNN(recurrent neural networks)、1-DCNN(1-dimensional convolution neural networks)和DCN(dense convolutional networks)进行了比较。实验结果显示,本文方法的分类准确率达到91.16%,优于其他4种方法。结论本文方法面向可穿戴心电数据,获得了较好的分类性能,可以有效监控穿戴者是否出现了心电异常情况。关键词:可穿戴设备;可穿戴心电数据集;心脏监测;卷积神经网络;空间滤波36|39|1更新时间:2024-05-07

研究应用

0