最新刊期

2018 年 第 23 卷 第 10 期

-

摘要:目的生成式对抗网络(GAN)的出现为计算机视觉应用提供了新的技术和手段,它以独特零和博弈与对抗训练的思想生成高质量的样本,具有比传统机器学习算法更强大的特征学习和特征表达能力。目前在机器视觉领域尤其是样本生成领域取得了显著的成功,是当前研究的热点方向之一。方法以生成式对抗网络的不同模型及其在计算机视觉领域的应用为研究对象,在广泛调研文献特别是GAN的最新发展成果基础上,结合不同模型的对比试验,对每种方法的基本思想、方法特点及使用场景进行分析,并对GAN的优势与劣势进行总结,阐述了GAN研究的现状、在计算机视觉上的应用范围,归纳生成式对抗网络在高质量图像生成、风格迁移与图像翻译、文本与图像的相互生成和图像的还原与修复等多个计算机视觉领域的研究现状和发展趋势,并对每种应用的理论改进之处、优点、局限性及使用场景进行了总结,对未来可能的发展方向进行展望。结果GAN的不同模型在生成样本质量与性能上各有优劣。当前的GAN模型在图像的处理上取得较大的成就,能生成以假乱真的样本,但是也存在网络不收敛、模型易崩溃、过于自由不可控的问题。结论GAN作为一种新的生成模型具有很高的研究价值与应用价值,但目前存在一些理论上的桎梏亟待突破,在应用方面生成高质量的样本、逼真的场景是值得研究的方向。关键词:生成式对抗网络;计算机视觉;图像生成;图像风格迁移;图像修复14|18|26更新时间:2024-05-07

摘要:目的生成式对抗网络(GAN)的出现为计算机视觉应用提供了新的技术和手段,它以独特零和博弈与对抗训练的思想生成高质量的样本,具有比传统机器学习算法更强大的特征学习和特征表达能力。目前在机器视觉领域尤其是样本生成领域取得了显著的成功,是当前研究的热点方向之一。方法以生成式对抗网络的不同模型及其在计算机视觉领域的应用为研究对象,在广泛调研文献特别是GAN的最新发展成果基础上,结合不同模型的对比试验,对每种方法的基本思想、方法特点及使用场景进行分析,并对GAN的优势与劣势进行总结,阐述了GAN研究的现状、在计算机视觉上的应用范围,归纳生成式对抗网络在高质量图像生成、风格迁移与图像翻译、文本与图像的相互生成和图像的还原与修复等多个计算机视觉领域的研究现状和发展趋势,并对每种应用的理论改进之处、优点、局限性及使用场景进行了总结,对未来可能的发展方向进行展望。结果GAN的不同模型在生成样本质量与性能上各有优劣。当前的GAN模型在图像的处理上取得较大的成就,能生成以假乱真的样本,但是也存在网络不收敛、模型易崩溃、过于自由不可控的问题。结论GAN作为一种新的生成模型具有很高的研究价值与应用价值,但目前存在一些理论上的桎梏亟待突破,在应用方面生成高质量的样本、逼真的场景是值得研究的方向。关键词:生成式对抗网络;计算机视觉;图像生成;图像风格迁移;图像修复14|18|26更新时间:2024-05-07 -

摘要:目的高分辨率多层螺旋CT是临床医生研究肺部解剖结构功能、评估生理状态、检测和诊断病变的主要影像学工具。鉴于肺部各解剖结构间特殊的关联关系和图像成像缺陷、组织病变等干扰因素对分割效果的影响,学术界已在经典图像处理方法基础上针对CT图像中的肺部解剖结构分割进行了大量研究。方法通过对相关领域有代表性或前沿性文献的归纳总结,系统性地梳理了现有肺组织、肺气管、肺血管、肺裂纹、肺叶或肺段等解剖结构CT图像分割方法的主要流程、方法理论、关键技术和优缺点,讨论了各解剖结构分割的参考数据获取、实验设计方法和结果评价指标。结果分析了现有研究在结果精度和鲁棒性方面所面临的挑战性问题,以及基于分割结果在定位病变、定量测量、提取其他结构等方面展开的热点应用,特别详述了当前被重点关注的深度学习方法在本领域的工作进展,同时展望了本领域在分割理论方法和后续处理等步骤的发展趋势,并探索了如何在实践中根据分割结果发现新的临床生物标志。结论快速精确地从CT图像中分割肺部各解剖结构可以获取清晰直观的3维可视化结构影像,展开解剖结构内部的定量参数测量或结构之间的关联关系分析能提供客观、有效的肺部组织疾病辅助诊断依据信息,可以大大减轻临床医生的阅片负担、提高工作效率,具有重要的理论研究意义和临床应用价值。关键词:CT图像;肺组织分割;肺气管分割;肺血管分割;肺叶分割22|19|2更新时间:2024-05-07

摘要:目的高分辨率多层螺旋CT是临床医生研究肺部解剖结构功能、评估生理状态、检测和诊断病变的主要影像学工具。鉴于肺部各解剖结构间特殊的关联关系和图像成像缺陷、组织病变等干扰因素对分割效果的影响,学术界已在经典图像处理方法基础上针对CT图像中的肺部解剖结构分割进行了大量研究。方法通过对相关领域有代表性或前沿性文献的归纳总结,系统性地梳理了现有肺组织、肺气管、肺血管、肺裂纹、肺叶或肺段等解剖结构CT图像分割方法的主要流程、方法理论、关键技术和优缺点,讨论了各解剖结构分割的参考数据获取、实验设计方法和结果评价指标。结果分析了现有研究在结果精度和鲁棒性方面所面临的挑战性问题,以及基于分割结果在定位病变、定量测量、提取其他结构等方面展开的热点应用,特别详述了当前被重点关注的深度学习方法在本领域的工作进展,同时展望了本领域在分割理论方法和后续处理等步骤的发展趋势,并探索了如何在实践中根据分割结果发现新的临床生物标志。结论快速精确地从CT图像中分割肺部各解剖结构可以获取清晰直观的3维可视化结构影像,展开解剖结构内部的定量参数测量或结构之间的关联关系分析能提供客观、有效的肺部组织疾病辅助诊断依据信息,可以大大减轻临床医生的阅片负担、提高工作效率,具有重要的理论研究意义和临床应用价值。关键词:CT图像;肺组织分割;肺气管分割;肺血管分割;肺叶分割22|19|2更新时间:2024-05-07

综述

-

摘要:目的隐写分析研究现状表明,与秘密信息的嵌入过程相比,图像内容和统计特性差异对隐写检测特征分布会造成更大的影响,这导致图像隐写分析成为了一个"相同类内特征分布分散、不同类间特征混淆严重"的分类问题。针对此问题,提出了一种更加有效的JPEG图像隐写检测模型。方法通过对隐写检测常用的分类器进行分析,从降低隐写检测特征类内离散度的角度入手,将基于图像内容复杂度的预分类和图像分割相结合,根据图像内容复杂度对图像进行分类、分割,然后分别对每一类子图像提取高维富模型隐写检测特征,构建分类器进行训练和测试,并通过加权融合得到最终的检测结果。结果在实验部分,对具有代表性的隐写检测特征集提取了两类可分性判据,对本文算法的各类别、区域所提取特征的可分性均得到明显提高,证明了模型的有效性。同时在训练、测试图像库匹配和不匹配的情况下,对算法进行了二分类测试,并与其他算法进行了性能比较,本文算法的检测性能均有所提高,性能提升最高接近10%。结论本文算法能够有效提高隐写检测性能,尤其是在训练、测试图像库统计特性不匹配的情况下,本文算法性能提升更加明显,更适合于实际复杂网络下的应用。关键词:隐写分析;图像统计特性;图像分类;图像分割;加权融合23|91|2更新时间:2024-05-07

摘要:目的隐写分析研究现状表明,与秘密信息的嵌入过程相比,图像内容和统计特性差异对隐写检测特征分布会造成更大的影响,这导致图像隐写分析成为了一个"相同类内特征分布分散、不同类间特征混淆严重"的分类问题。针对此问题,提出了一种更加有效的JPEG图像隐写检测模型。方法通过对隐写检测常用的分类器进行分析,从降低隐写检测特征类内离散度的角度入手,将基于图像内容复杂度的预分类和图像分割相结合,根据图像内容复杂度对图像进行分类、分割,然后分别对每一类子图像提取高维富模型隐写检测特征,构建分类器进行训练和测试,并通过加权融合得到最终的检测结果。结果在实验部分,对具有代表性的隐写检测特征集提取了两类可分性判据,对本文算法的各类别、区域所提取特征的可分性均得到明显提高,证明了模型的有效性。同时在训练、测试图像库匹配和不匹配的情况下,对算法进行了二分类测试,并与其他算法进行了性能比较,本文算法的检测性能均有所提高,性能提升最高接近10%。结论本文算法能够有效提高隐写检测性能,尤其是在训练、测试图像库统计特性不匹配的情况下,本文算法性能提升更加明显,更适合于实际复杂网络下的应用。关键词:隐写分析;图像统计特性;图像分类;图像分割;加权融合23|91|2更新时间:2024-05-07 -

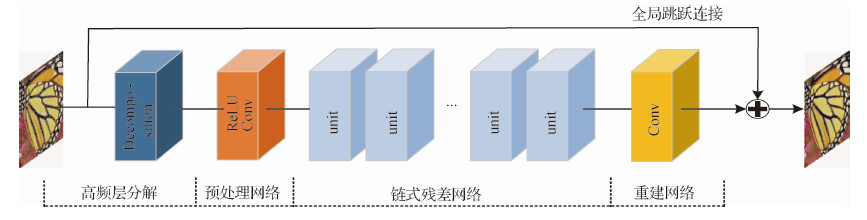

摘要:目的 现存的去噪算法中很多在去除噪声的同时都存在边缘信息过光滑、易产生彩色伪影的问题,为了解决这些缺点,本文提出了一种基于联合感知损失的深度残差去噪网络。方法 首先利用低通滤波器将噪声图片分解成高频层和低频层,然后将包含噪声和边缘信息的高频层输入设计好的残差网络中,通过常规逐像素损失方法学习端到端的残差映射预测出噪声残差图片,再由一个从输入直接通往输出的全局跳跃连接处理得到初始较模糊的去噪结果,最后级联一个预训练好的语义分割网络用来定义感知损失,指导前面的去噪模型学习更多语义特征信息来增强被模糊的边缘细节,得到更清晰真实的去噪结果。结果 本文从定性和定量两个方面进行对比实验。以峰值信噪比(PSNR)作为量化指标来评价算法性能,结果表明所提出的网络在同其他对比方法一样使用逐像素损失训练时能产生最好的指标结果,在Set5、Set14和BSD100测试集25噪声级别时的结果分别为30.51 dB、30.60 dB和29.38 dB。在视觉定性分析上,本文提出的感知损失模型明显取得了更清晰的去噪结果,相比其他方法产生的模糊区域该方法保留了更多的边缘信息和纹理细节。此外还进行了盲去噪测试实验,对一张含有不同噪声级别的图片进行去噪处理,结果表明本文训练好的算法模型可以一次性处理多种未知级别的噪声并产生满意的去噪输出而且没有多余伪影。结论 基于边缘增强的感知损失残差网络的图像去噪算法在去除噪声的同时可以保留更多容易被模糊的边缘细节,改善去噪结果过平滑的问题,提高图像视觉效果。关键词:图像去噪;残差网络;感知损失;分层模式29|11|12更新时间:2024-05-07

摘要:目的 现存的去噪算法中很多在去除噪声的同时都存在边缘信息过光滑、易产生彩色伪影的问题,为了解决这些缺点,本文提出了一种基于联合感知损失的深度残差去噪网络。方法 首先利用低通滤波器将噪声图片分解成高频层和低频层,然后将包含噪声和边缘信息的高频层输入设计好的残差网络中,通过常规逐像素损失方法学习端到端的残差映射预测出噪声残差图片,再由一个从输入直接通往输出的全局跳跃连接处理得到初始较模糊的去噪结果,最后级联一个预训练好的语义分割网络用来定义感知损失,指导前面的去噪模型学习更多语义特征信息来增强被模糊的边缘细节,得到更清晰真实的去噪结果。结果 本文从定性和定量两个方面进行对比实验。以峰值信噪比(PSNR)作为量化指标来评价算法性能,结果表明所提出的网络在同其他对比方法一样使用逐像素损失训练时能产生最好的指标结果,在Set5、Set14和BSD100测试集25噪声级别时的结果分别为30.51 dB、30.60 dB和29.38 dB。在视觉定性分析上,本文提出的感知损失模型明显取得了更清晰的去噪结果,相比其他方法产生的模糊区域该方法保留了更多的边缘信息和纹理细节。此外还进行了盲去噪测试实验,对一张含有不同噪声级别的图片进行去噪处理,结果表明本文训练好的算法模型可以一次性处理多种未知级别的噪声并产生满意的去噪输出而且没有多余伪影。结论 基于边缘增强的感知损失残差网络的图像去噪算法在去除噪声的同时可以保留更多容易被模糊的边缘细节,改善去噪结果过平滑的问题,提高图像视觉效果。关键词:图像去噪;残差网络;感知损失;分层模式29|11|12更新时间:2024-05-07 -

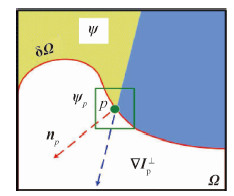

摘要:目的 针对传统基于样本块的图像修复算法中仅利用图像的梯度信息和颜色信息来修复破损区域时,容易产生错误填充块的问题,本文在Criminisi算法的基础上,利用结构张量特性,提出了一种改进的基于结构张量的彩色图像修复算法。方法 首先利用结构张量的特征值定义新的数据项,以确保图像的结构信息能够更加准确地传播;然后利用该数据项构成新的优先权函数,使得图像的填充顺序更加精准;最后利用结构张量的平均相干性来自适应选择样本块大小,以克服结构不连续和错误延伸的缺点;同时在匹配准则中,利用结构张量特征值来增加约束条件,以减少错误匹配率。结果 实验结果表明,改进算法的修复效果较理想,在主观视觉上有明显的提升,其修复结果的峰值信噪比(PSNR)和结构相似度(SSIM)都有所提高;与传统Criminisi算法相比,其峰值信噪比提高了1~3 dB。结论 本文算法利用结构张量的特性实现了对不同结构特征的彩色破损图像的修复,对复杂的线性结构和纹理区域都有较理想的修复,有效地保持了图像边缘结构的平滑性,而且对大物体的移除和文字去除也有较好的修复效果。关键词:彩色图像修复;结构张量;自适应样本块大小;匹配准则;平均相干性13|5|4更新时间:2024-05-07

摘要:目的 针对传统基于样本块的图像修复算法中仅利用图像的梯度信息和颜色信息来修复破损区域时,容易产生错误填充块的问题,本文在Criminisi算法的基础上,利用结构张量特性,提出了一种改进的基于结构张量的彩色图像修复算法。方法 首先利用结构张量的特征值定义新的数据项,以确保图像的结构信息能够更加准确地传播;然后利用该数据项构成新的优先权函数,使得图像的填充顺序更加精准;最后利用结构张量的平均相干性来自适应选择样本块大小,以克服结构不连续和错误延伸的缺点;同时在匹配准则中,利用结构张量特征值来增加约束条件,以减少错误匹配率。结果 实验结果表明,改进算法的修复效果较理想,在主观视觉上有明显的提升,其修复结果的峰值信噪比(PSNR)和结构相似度(SSIM)都有所提高;与传统Criminisi算法相比,其峰值信噪比提高了1~3 dB。结论 本文算法利用结构张量的特性实现了对不同结构特征的彩色破损图像的修复,对复杂的线性结构和纹理区域都有较理想的修复,有效地保持了图像边缘结构的平滑性,而且对大物体的移除和文字去除也有较好的修复效果。关键词:彩色图像修复;结构张量;自适应样本块大小;匹配准则;平均相干性13|5|4更新时间:2024-05-07 -

摘要:目的 深度图像作为一种普遍的3维场景信息表达方式在立体视觉领域有着广泛的应用。Kinect深度相机能够实时获取场景的深度图像,但由于内部硬件的限制和外界因素的干扰,获取的深度图像存在分辨率低、边缘不准确的问题,无法满足实际应用的需要。为此提出了一种基于彩色图像边缘引导的Kinect深度图像超分辨率重建算法。方法 首先对深度图像进行初始化上采样,并提取初始化深度图像的边缘;进一步利用高分辨率彩色图像和深度图像的相似性,采用基于结构化学习的边缘检测方法提取深度图的正确边缘;最后找出初始化深度图的错误边缘和深度图正确边缘之间的不可靠区域,采用边缘对齐的策略对不可靠区域进行插值填充。结果 在NYU2数据集上进行实验,与8种最新的深度图像超分辨率重建算法作比较,用重建之后的深度图像和3维重建的点云效果进行验证。实验结果表明本文算法在提高深度图像的分辨率的同时,能有效修正上采样后深度图像的边缘,使深度边缘与纹理边缘对齐,也能抑制上采样算法带来的边缘模糊现象;3维点云效果显示,本文算法能准确区分场景中的前景和背景,应用于3维重建等应用能取得较其他算法更好的效果。结论 本文算法普遍适用于Kinect深度图像的超分辨率重建问题,该算法结合同场景彩色图像与深度图像的相似性,利用纹理边缘引导深度图像的超分辨率重建,可以得到较好的重建结果。关键词:深度图像;Kinect;超分辨率重建;边缘检测;纹理边缘引导46|6|4更新时间:2024-05-07

摘要:目的 深度图像作为一种普遍的3维场景信息表达方式在立体视觉领域有着广泛的应用。Kinect深度相机能够实时获取场景的深度图像,但由于内部硬件的限制和外界因素的干扰,获取的深度图像存在分辨率低、边缘不准确的问题,无法满足实际应用的需要。为此提出了一种基于彩色图像边缘引导的Kinect深度图像超分辨率重建算法。方法 首先对深度图像进行初始化上采样,并提取初始化深度图像的边缘;进一步利用高分辨率彩色图像和深度图像的相似性,采用基于结构化学习的边缘检测方法提取深度图的正确边缘;最后找出初始化深度图的错误边缘和深度图正确边缘之间的不可靠区域,采用边缘对齐的策略对不可靠区域进行插值填充。结果 在NYU2数据集上进行实验,与8种最新的深度图像超分辨率重建算法作比较,用重建之后的深度图像和3维重建的点云效果进行验证。实验结果表明本文算法在提高深度图像的分辨率的同时,能有效修正上采样后深度图像的边缘,使深度边缘与纹理边缘对齐,也能抑制上采样算法带来的边缘模糊现象;3维点云效果显示,本文算法能准确区分场景中的前景和背景,应用于3维重建等应用能取得较其他算法更好的效果。结论 本文算法普遍适用于Kinect深度图像的超分辨率重建问题,该算法结合同场景彩色图像与深度图像的相似性,利用纹理边缘引导深度图像的超分辨率重建,可以得到较好的重建结果。关键词:深度图像;Kinect;超分辨率重建;边缘检测;纹理边缘引导46|6|4更新时间:2024-05-07 -

摘要:目的 非刚性物体进行匹配时,往往需要对图像中存在的非刚性形变目标进行快速精确的配准,进而实现对图像的后续处理和分析,实现快速而准确的非刚体匹配显得尤为重要。针对传统特征点匹配方法在非刚性物体匹配中准确性差的问题,本文提出了一种基于DAISY算子和有约束Patch-Match的非刚体密集匹配算法。方法 首先对参考图像和待匹配图像生成DAISY特征描述子,其次对两幅图像进行超像素分割,形成相互邻接但没有重叠的超像素块结构,并以其为单元,计算初始位置上对应每一个像素的DAISY特征算子聚合代价。然后,采用Patch-Match算法对整幅图像进行传播和变异,在变异过程中,通过图像预处理和分析得到的先验知识对位置标签的变异窗口进行局部空间约束,使得每个像素的位置标签在该空间范围内随机更新,计算新的聚合代价,保留代价较小的位置标签,重复迭代此过程,直到聚合代价不发生变化或者达到最大迭代次数为止。结果 实验选取了标准数据集、10幅分别由TFDS(the trucking fault dynamic image detection system)线阵列相机和框幅式相机采集的包含非刚体的图像进行匹配,均取得了较好的匹配效果,经验证,本文方法的匹配精度为86%,误匹配点的平均匹配误差为5个像素左右,是传统基于SIFT特征光流匹配方法误差的一半,并且本文采用的DAISY算子在特征提取速度上是Dense SIFT(dense scale invariant feature transform)特征提取算法的2~3倍,大大提升了图像匹配的效率。结论 本文提出了一种非刚体密集匹配算法,针对非刚体变化的不确定性采用密集特征点进行最优化搜索匹配。本文算法对包含小范围非刚性变化的图像匹配上具有较好的适应性,且匹配精度高,视觉效果好,鲁棒性强。关键词:计算机视觉;非刚体匹配;DAISY算子;超像素分割;代价聚合;块匹配11|4|1更新时间:2024-05-07

摘要:目的 非刚性物体进行匹配时,往往需要对图像中存在的非刚性形变目标进行快速精确的配准,进而实现对图像的后续处理和分析,实现快速而准确的非刚体匹配显得尤为重要。针对传统特征点匹配方法在非刚性物体匹配中准确性差的问题,本文提出了一种基于DAISY算子和有约束Patch-Match的非刚体密集匹配算法。方法 首先对参考图像和待匹配图像生成DAISY特征描述子,其次对两幅图像进行超像素分割,形成相互邻接但没有重叠的超像素块结构,并以其为单元,计算初始位置上对应每一个像素的DAISY特征算子聚合代价。然后,采用Patch-Match算法对整幅图像进行传播和变异,在变异过程中,通过图像预处理和分析得到的先验知识对位置标签的变异窗口进行局部空间约束,使得每个像素的位置标签在该空间范围内随机更新,计算新的聚合代价,保留代价较小的位置标签,重复迭代此过程,直到聚合代价不发生变化或者达到最大迭代次数为止。结果 实验选取了标准数据集、10幅分别由TFDS(the trucking fault dynamic image detection system)线阵列相机和框幅式相机采集的包含非刚体的图像进行匹配,均取得了较好的匹配效果,经验证,本文方法的匹配精度为86%,误匹配点的平均匹配误差为5个像素左右,是传统基于SIFT特征光流匹配方法误差的一半,并且本文采用的DAISY算子在特征提取速度上是Dense SIFT(dense scale invariant feature transform)特征提取算法的2~3倍,大大提升了图像匹配的效率。结论 本文提出了一种非刚体密集匹配算法,针对非刚体变化的不确定性采用密集特征点进行最优化搜索匹配。本文算法对包含小范围非刚性变化的图像匹配上具有较好的适应性,且匹配精度高,视觉效果好,鲁棒性强。关键词:计算机视觉;非刚体匹配;DAISY算子;超像素分割;代价聚合;块匹配11|4|1更新时间:2024-05-07

图像处理和编码

-

摘要:目的 针对仿射变换下形状匹配中存在的描述子对形状的描述能力不足,以及描述子计算耗时大的问题,改进基于所有图像点投影的方法,提出一种利用轮廓计算投影面积的仿射形状匹配算法。方法 该算法分为粗匹配和精匹配两个阶段。粗匹配阶段以CSS角点作为备选特征点,首先统计轮廓投影面积分布作为特征点描述子;然后利用动态规划蚁群算法匹配两幅图片公共特征点序列,并将匹配好的特征点序列记为对应的新特征点;最后采用该新特征点划分目标曲线,得到对应的轮廓曲线;这一阶段的目的是对形状的筛选以及寻找一致的轮廓特征点,同时完成轮廓曲线的划分。精匹配阶段,采用小波仿射不变描述子,对粗匹配阶段匹配代价最小的5%的目标进行对应曲线匹配,得到精匹配阶段的匹配代价,从而实现对仿射目标的识别;精匹配弥补了描述子对轮廓细节描述不足的问题。结果 算法的平均检索速度比传统基于形状投影分布描述子提高44.3%,在MPEG-7图像库上的检索效果为98.65%,在MPEG-7仿射图像库上的查准率与查全率综合评价指标比传统的基于形状投影分布描述子高3.1%,比形状上下文高25%。结论 本文算法匹配效果好,效率高,抗噪性强,解决了仿射描述子计算速度慢、描述能力不足的问题,能有效地应用于仿射形状匹配与检索领域。关键词:形状匹配;仿射不变描述子;蚁群算法;小波变换;轮廓19|4|1更新时间:2024-05-07

摘要:目的 针对仿射变换下形状匹配中存在的描述子对形状的描述能力不足,以及描述子计算耗时大的问题,改进基于所有图像点投影的方法,提出一种利用轮廓计算投影面积的仿射形状匹配算法。方法 该算法分为粗匹配和精匹配两个阶段。粗匹配阶段以CSS角点作为备选特征点,首先统计轮廓投影面积分布作为特征点描述子;然后利用动态规划蚁群算法匹配两幅图片公共特征点序列,并将匹配好的特征点序列记为对应的新特征点;最后采用该新特征点划分目标曲线,得到对应的轮廓曲线;这一阶段的目的是对形状的筛选以及寻找一致的轮廓特征点,同时完成轮廓曲线的划分。精匹配阶段,采用小波仿射不变描述子,对粗匹配阶段匹配代价最小的5%的目标进行对应曲线匹配,得到精匹配阶段的匹配代价,从而实现对仿射目标的识别;精匹配弥补了描述子对轮廓细节描述不足的问题。结果 算法的平均检索速度比传统基于形状投影分布描述子提高44.3%,在MPEG-7图像库上的检索效果为98.65%,在MPEG-7仿射图像库上的查准率与查全率综合评价指标比传统的基于形状投影分布描述子高3.1%,比形状上下文高25%。结论 本文算法匹配效果好,效率高,抗噪性强,解决了仿射描述子计算速度慢、描述能力不足的问题,能有效地应用于仿射形状匹配与检索领域。关键词:形状匹配;仿射不变描述子;蚁群算法;小波变换;轮廓19|4|1更新时间:2024-05-07 -

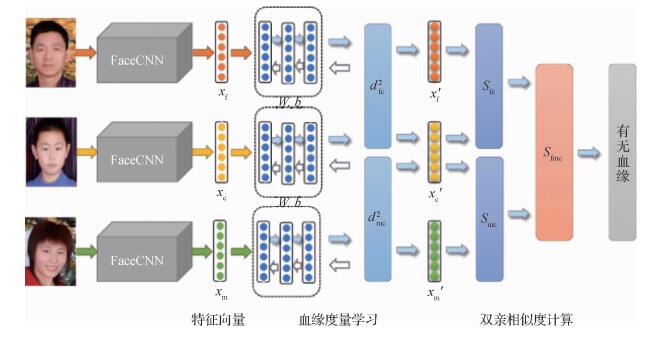

摘要:目的人脸图像分析是计算机视觉和模式识别领域的重要研究方向之一,基于人脸图像的血缘关系识别是对给定的一对或一组人脸图像,判断其是否存在某种血缘关系。人脸血缘关系识别不仅在生物特征识别领域有着重要研究价值,而且在社交媒体挖掘、失散家庭成员寻找等社会生活领域中有重要的应用价值。针对当前大多数算法都是基于传统机器学习方法,提出一种采用深度度量学习进行人脸图像血缘关系研究的新方法。方法目前深度学习算法能很好地理解单张人脸图像,但是多个主体间的关系探究仍然是计算机视觉领域富有挑战性的问题之一。为此,提出一种基于深度度量学习的父母与子女的血缘关系识别方法。首先使用超过5 000 000张人脸图像的样本集训练一个深度卷积神经网络FaceCNN并提取父母与子女的人脸图像深度特征,之后引入判别性度量学习方法,使得具有血缘关系的特征尽可能地靠近,反之则尽可能地远离。然后对特征进行分层非线性变换使其具有更强判别特性。最后根据余弦相似度分别计算父亲、母亲和孩子的相似度并利用相似概率值得到双亲和孩子的综合相似度得分。结果算法在TSKinFace数据集上验证了FaceCNN提取特征与深度度量学习结合进行血缘关系识别的有效性,最终在该数据集上父母与儿子和女儿的血缘关系识别准确率分别达到87.71%和89.18%,同时算法在进行血缘度量学习和双亲相似度计算仅需要3.616 s。结论提出的血缘关系识别方法,充分利用深度学习网络良好的表征和学习能力,不仅耗时少,而且有效地提高了识别准确率。关键词:血缘关系识别;卷积神经网络;深度特征;深度学习;度量学习12|12|0更新时间:2024-05-07

摘要:目的人脸图像分析是计算机视觉和模式识别领域的重要研究方向之一,基于人脸图像的血缘关系识别是对给定的一对或一组人脸图像,判断其是否存在某种血缘关系。人脸血缘关系识别不仅在生物特征识别领域有着重要研究价值,而且在社交媒体挖掘、失散家庭成员寻找等社会生活领域中有重要的应用价值。针对当前大多数算法都是基于传统机器学习方法,提出一种采用深度度量学习进行人脸图像血缘关系研究的新方法。方法目前深度学习算法能很好地理解单张人脸图像,但是多个主体间的关系探究仍然是计算机视觉领域富有挑战性的问题之一。为此,提出一种基于深度度量学习的父母与子女的血缘关系识别方法。首先使用超过5 000 000张人脸图像的样本集训练一个深度卷积神经网络FaceCNN并提取父母与子女的人脸图像深度特征,之后引入判别性度量学习方法,使得具有血缘关系的特征尽可能地靠近,反之则尽可能地远离。然后对特征进行分层非线性变换使其具有更强判别特性。最后根据余弦相似度分别计算父亲、母亲和孩子的相似度并利用相似概率值得到双亲和孩子的综合相似度得分。结果算法在TSKinFace数据集上验证了FaceCNN提取特征与深度度量学习结合进行血缘关系识别的有效性,最终在该数据集上父母与儿子和女儿的血缘关系识别准确率分别达到87.71%和89.18%,同时算法在进行血缘度量学习和双亲相似度计算仅需要3.616 s。结论提出的血缘关系识别方法,充分利用深度学习网络良好的表征和学习能力,不仅耗时少,而且有效地提高了识别准确率。关键词:血缘关系识别;卷积神经网络;深度特征;深度学习;度量学习12|12|0更新时间:2024-05-07

图像理解和计算机视觉

-

摘要:目的圆形标志目前正广泛地应用于各类视觉测量系统, 其圆心定位精度决定了测量系统的测量精度。当相机主光轴与标志表面不平行时, 圆被映射为椭圆, 圆心位置计算产生偏差。光轴与标志表面夹角较大或标志较大等情况下会产生较大的偏心差进而严重影响系统测量精度。为此, 提出一种基于三同心圆圆形标志的投影偏心差补偿算法。方法算法基于三同心圆的圆形标志设计, 根据3组椭圆拟合中心坐标解算偏心差模型进行计算补偿。结果针对圆形标志偏心差问题, 同心圆补偿算法取得良好效果, 有效提升了圆形标志定位精度。仿真结果表明, 在拍摄角度、拍摄距离、圆形标志大小不同的情况下, 偏心差在像素量级, 补偿后偏心差在10-11像素量级。实物实验结果表明, 若设计有直径分别为6 cm, 12 cm, 18 cm的三同心圆标志, 经解算补偿结果较以往两同心圆算法精度提高一倍, 偏心差值减小80%, 测量误差在0.1 mm左右。结论本文提出了一种新的偏心差补偿算法, 利用三同心圆标志增加约束解算偏心差。与以往偏心差补偿算法相比, 此方法精度更高, 且无需预先平差解算相机与目标的距离、拍摄角等参数, 仅需要知道标志圆形半径比例及椭圆中心坐标即可计算补偿, 具有很高的实用性, 可用于改善基于非编码标志点的深度像匹配、基于圆形标志点的全自动相机标定方法、视觉导航定位等应用中。关键词:偏心差;三同心圆;椭圆拟合;像点误差;视觉定位17|5|3更新时间:2024-05-07

摘要:目的圆形标志目前正广泛地应用于各类视觉测量系统, 其圆心定位精度决定了测量系统的测量精度。当相机主光轴与标志表面不平行时, 圆被映射为椭圆, 圆心位置计算产生偏差。光轴与标志表面夹角较大或标志较大等情况下会产生较大的偏心差进而严重影响系统测量精度。为此, 提出一种基于三同心圆圆形标志的投影偏心差补偿算法。方法算法基于三同心圆的圆形标志设计, 根据3组椭圆拟合中心坐标解算偏心差模型进行计算补偿。结果针对圆形标志偏心差问题, 同心圆补偿算法取得良好效果, 有效提升了圆形标志定位精度。仿真结果表明, 在拍摄角度、拍摄距离、圆形标志大小不同的情况下, 偏心差在像素量级, 补偿后偏心差在10-11像素量级。实物实验结果表明, 若设计有直径分别为6 cm, 12 cm, 18 cm的三同心圆标志, 经解算补偿结果较以往两同心圆算法精度提高一倍, 偏心差值减小80%, 测量误差在0.1 mm左右。结论本文提出了一种新的偏心差补偿算法, 利用三同心圆标志增加约束解算偏心差。与以往偏心差补偿算法相比, 此方法精度更高, 且无需预先平差解算相机与目标的距离、拍摄角等参数, 仅需要知道标志圆形半径比例及椭圆中心坐标即可计算补偿, 具有很高的实用性, 可用于改善基于非编码标志点的深度像匹配、基于圆形标志点的全自动相机标定方法、视觉导航定位等应用中。关键词:偏心差;三同心圆;椭圆拟合;像点误差;视觉定位17|5|3更新时间:2024-05-07

计算机图形学

-

摘要:目的MRI正逐步代替CT进行骨头与关节的检查,肩关节MRI中骨结构的精确自动分割对于骨损伤和疾病的度量与诊断至关重要,现有骨头分割算法无法做到不用任何先验知识进行自动分割,且通用性和精准度相对较低,为此提出一种基于图像块和全卷积神经网络(PCNN和FCN)相结合的自动分割算法。方法首先建立4个分割模型,包括3个基于U-Net的骨头分割模型(肱骨分割模型、关节骨分割模型、肱骨头和关节骨作为整体的分割模型)和一个基于块的AlexNet分割模型;然后使用4个分割模型来获取候选的骨头区域,并通过投票的方式准确检测到肱骨和关节骨的位置区域;最后在检测到的骨头区域内进一步使用AlexNet分割模型,从而分割出精确度在像素级别的骨头边缘。结果实验数据来自美国哈佛医学院/麻省总医院骨科的8组病人,每组扫描序列包括100片左右图像,都已经分割标注。5组病人用于训练和进行五倍的交叉验证,3组病人用于测试实际的分割效果,其中Dice Coefficient、Positive Predicted Value(PPV)和Sensitivity平均准确率分别达到0.92±0.02、0.96±0.03和0.94±0.02。结论本文方法针对小样本的病人数据集,仅通过2维医学图像上的深度学习,可以得到非常精确的肩关节分割结果。所提算法已经集成到我们开发的医学图像度量分析平台"3DQI",通过该平台可以展示肩关节骨头3D分割效果,给骨科医生提供临床的诊断指导作用。同时,所提算法框架具有一定的通用性,适应于小样本数据下CT和MRI中特定器官和组织的精确分割。关键词:深度学习;医学图像分割;全卷积网络;核磁共振图像;骨科诊断11|4|5更新时间:2024-05-07

摘要:目的MRI正逐步代替CT进行骨头与关节的检查,肩关节MRI中骨结构的精确自动分割对于骨损伤和疾病的度量与诊断至关重要,现有骨头分割算法无法做到不用任何先验知识进行自动分割,且通用性和精准度相对较低,为此提出一种基于图像块和全卷积神经网络(PCNN和FCN)相结合的自动分割算法。方法首先建立4个分割模型,包括3个基于U-Net的骨头分割模型(肱骨分割模型、关节骨分割模型、肱骨头和关节骨作为整体的分割模型)和一个基于块的AlexNet分割模型;然后使用4个分割模型来获取候选的骨头区域,并通过投票的方式准确检测到肱骨和关节骨的位置区域;最后在检测到的骨头区域内进一步使用AlexNet分割模型,从而分割出精确度在像素级别的骨头边缘。结果实验数据来自美国哈佛医学院/麻省总医院骨科的8组病人,每组扫描序列包括100片左右图像,都已经分割标注。5组病人用于训练和进行五倍的交叉验证,3组病人用于测试实际的分割效果,其中Dice Coefficient、Positive Predicted Value(PPV)和Sensitivity平均准确率分别达到0.92±0.02、0.96±0.03和0.94±0.02。结论本文方法针对小样本的病人数据集,仅通过2维医学图像上的深度学习,可以得到非常精确的肩关节分割结果。所提算法已经集成到我们开发的医学图像度量分析平台"3DQI",通过该平台可以展示肩关节骨头3D分割效果,给骨科医生提供临床的诊断指导作用。同时,所提算法框架具有一定的通用性,适应于小样本数据下CT和MRI中特定器官和组织的精确分割。关键词:深度学习;医学图像分割;全卷积网络;核磁共振图像;骨科诊断11|4|5更新时间:2024-05-07 -

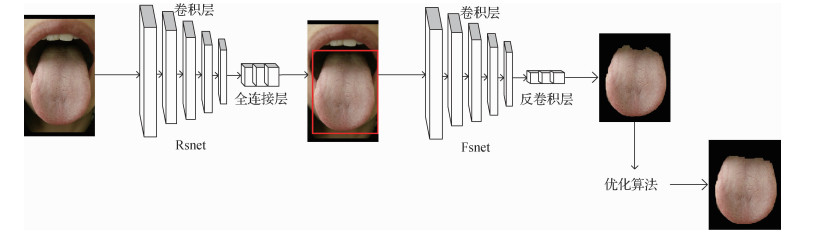

摘要:目的由于舌体与周围组织颜色相似,轮廓模糊,传统的分割方法难以精准分割舌体,为此提出一种基于两阶段卷积神经网络的舌体分割方法。方法首先,在粗分割阶段,将卷积层和全连接层相结合构建网络Rsnet,采用区域建议策略得到舌体候选框,从候选框中进一步确定舌体,从而实现对舌体的定位,去除大量的干扰信息;然后,在精分割阶段,将卷积层与反卷积层相结合构建网络Fsnet,对粗分割舌象中的每一个像素点进行分类进而实现精分割;最后,采用形态学相关算法对精分割后的舌体图像进行后续处理,进一步消除噪点和边缘粗糙点。结果本文构建了包含2 764张舌象的数据集,在该数据集上进行五折交叉实验。实验结果表明,本文算法能够取得较为理想的分割结果且具有较快的处理速度。选取了精确度、召回率及F值作为评价标准,与3种常用的传统分割方法相比,在综合指标F值上分别提高了0.58、0.34、0.12,效率上至少提高6倍,与同样基于深度学习思想的MNC(multi-task network cascades)算法相比,在F值上提高0.17,效率上提高1.9倍。结论将基于深度学习的方法应用到舌体分割中,有利于实现舌象的准确、鲁棒、快速分割。在分割之前,先对舌体进行定位,有助于进一步减少分割中的错分与漏分。实验结果表明,本文算法有效提升了舌体分割的准确性,能够为后续的舌象自动识别和分析奠定坚实的基础。关键词:卷积神经网络;深度学习;舌体分割;两阶段语义分割;形态学12|4|8更新时间:2024-05-07

摘要:目的由于舌体与周围组织颜色相似,轮廓模糊,传统的分割方法难以精准分割舌体,为此提出一种基于两阶段卷积神经网络的舌体分割方法。方法首先,在粗分割阶段,将卷积层和全连接层相结合构建网络Rsnet,采用区域建议策略得到舌体候选框,从候选框中进一步确定舌体,从而实现对舌体的定位,去除大量的干扰信息;然后,在精分割阶段,将卷积层与反卷积层相结合构建网络Fsnet,对粗分割舌象中的每一个像素点进行分类进而实现精分割;最后,采用形态学相关算法对精分割后的舌体图像进行后续处理,进一步消除噪点和边缘粗糙点。结果本文构建了包含2 764张舌象的数据集,在该数据集上进行五折交叉实验。实验结果表明,本文算法能够取得较为理想的分割结果且具有较快的处理速度。选取了精确度、召回率及F值作为评价标准,与3种常用的传统分割方法相比,在综合指标F值上分别提高了0.58、0.34、0.12,效率上至少提高6倍,与同样基于深度学习思想的MNC(multi-task network cascades)算法相比,在F值上提高0.17,效率上提高1.9倍。结论将基于深度学习的方法应用到舌体分割中,有利于实现舌象的准确、鲁棒、快速分割。在分割之前,先对舌体进行定位,有助于进一步减少分割中的错分与漏分。实验结果表明,本文算法有效提升了舌体分割的准确性,能够为后续的舌象自动识别和分析奠定坚实的基础。关键词:卷积神经网络;深度学习;舌体分割;两阶段语义分割;形态学12|4|8更新时间:2024-05-07 -

摘要:目的在甲状腺结节图像中对甲状腺结节进行良恶性分析,对于甲状腺癌的早期诊断有着重要的意义。随着医疗影像学的发展,大部分的早期甲状腺结节可以在超声图像中准确地检测出来,但对于结节的性质仍然缺乏准确的判断。因此,为实现更为准确的早期甲状腺结节良恶性超声图像诊断,避免不必要的针刺或其他病理活检手术、减轻病患生理痛苦和心理压力及其医疗费用,提出一种基于深度网络和浅层纹理特征融合的甲状腺结节良恶性分类新算法。方法本文提出的甲状腺结节分类算法由4步组成。首先对超声图像进行尺度配准、人工标记以及图像复原去除以增强图像质量。然后,对增强的图像进行数据扩展,并作为训练集对预训练过的GoogLeNet卷积神经网络进行迁移学习以提取图像中的深度特征。同时,提取图像的旋转不变性局部二值模式(LBP)特征作为图像的纹理特征。最后,将深度特征与图像的纹理特征相融合并输入至代价敏感随机森林分类器中对图像进行良恶性分类。结果本文方法在标准的甲状腺结节癌变数据集上对甲状腺结节图像取得了正确率99.15%,敏感性99.73%,特异性95.85%以及ROC曲线下面积0.997 0的的好成绩,优于现有的甲状腺结节图像分类方法。结论实验结果表明,图像的深度特征可以描述医疗超声图像中病灶的整体感官特征,而浅层次纹理特征则可以描述超声图像的边缘、灰度分布等特征,将二者统一的融合特征则可以更为全面地描述图像中病灶区域与非病灶区域之间的差异以及不同病灶性质之间的差异。因此,本文方法可以准确地对甲状腺结节进行分类从而避免不必要手术、减轻病患痛苦和压力。关键词:超声图像分类;甲状腺结节;计算机辅助诊断;深度学习;卷积神经网络;迁移学习24|4|11更新时间:2024-05-07

摘要:目的在甲状腺结节图像中对甲状腺结节进行良恶性分析,对于甲状腺癌的早期诊断有着重要的意义。随着医疗影像学的发展,大部分的早期甲状腺结节可以在超声图像中准确地检测出来,但对于结节的性质仍然缺乏准确的判断。因此,为实现更为准确的早期甲状腺结节良恶性超声图像诊断,避免不必要的针刺或其他病理活检手术、减轻病患生理痛苦和心理压力及其医疗费用,提出一种基于深度网络和浅层纹理特征融合的甲状腺结节良恶性分类新算法。方法本文提出的甲状腺结节分类算法由4步组成。首先对超声图像进行尺度配准、人工标记以及图像复原去除以增强图像质量。然后,对增强的图像进行数据扩展,并作为训练集对预训练过的GoogLeNet卷积神经网络进行迁移学习以提取图像中的深度特征。同时,提取图像的旋转不变性局部二值模式(LBP)特征作为图像的纹理特征。最后,将深度特征与图像的纹理特征相融合并输入至代价敏感随机森林分类器中对图像进行良恶性分类。结果本文方法在标准的甲状腺结节癌变数据集上对甲状腺结节图像取得了正确率99.15%,敏感性99.73%,特异性95.85%以及ROC曲线下面积0.997 0的的好成绩,优于现有的甲状腺结节图像分类方法。结论实验结果表明,图像的深度特征可以描述医疗超声图像中病灶的整体感官特征,而浅层次纹理特征则可以描述超声图像的边缘、灰度分布等特征,将二者统一的融合特征则可以更为全面地描述图像中病灶区域与非病灶区域之间的差异以及不同病灶性质之间的差异。因此,本文方法可以准确地对甲状腺结节进行分类从而避免不必要手术、减轻病患痛苦和压力。关键词:超声图像分类;甲状腺结节;计算机辅助诊断;深度学习;卷积神经网络;迁移学习24|4|11更新时间:2024-05-07 -

摘要:目的糖尿病性视网膜病变(DR)是目前比较严重的一种致盲眼病,因此,对糖尿病性视网膜病理图像的自动分类具有重要的临床应用价值。基于人工分类视网膜图像的方法存在判别性特征提取困难、分类性能差、耗时费力且很难得到客观统一的医疗诊断等问题,为此,提出一种基于卷积神经网络和分类器的视网膜病理图像自动分类系统。方法首先,结合现有的视网膜图像的特点,对图像进行去噪、数据扩增、归一化等预处理操作;其次,在AlexNet网络的基础上,在网络的每一个卷积层和全连接层前引入一个批归一化层,得到一个网络层次更复杂的深度卷积神经网络BNnet。BNnet网络用于视网膜图像的特征提取网络,对其训练时采用迁移学习的策略利用ILSVRC2012数据集对BNnet网络进行预训练,再将训练得到的模型迁移到视网膜图像上再学习,提取用于视网膜分类的深度特征;最后,将提取的特征输入一个由全连接层组成的深度分类器将视网膜图像分为正常的视网膜图像、轻微病变的视网膜图像、中度病变的视网膜图像等5类。结果实验结果表明,本文方法的分类准确率可达0.93,优于传统的直接训练方法,且具有较好的鲁棒性和泛化性。结论本文提出的视网膜病理图像分类框架有效地避免了人工特征提取和图像分类的局限性,同时也解决了样本数据不足而导致的过拟合问题。关键词:糖尿病性视网膜图像分类;卷积神经网络;深度学习;迁移学习;深度特征11|4|10更新时间:2024-05-07

摘要:目的糖尿病性视网膜病变(DR)是目前比较严重的一种致盲眼病,因此,对糖尿病性视网膜病理图像的自动分类具有重要的临床应用价值。基于人工分类视网膜图像的方法存在判别性特征提取困难、分类性能差、耗时费力且很难得到客观统一的医疗诊断等问题,为此,提出一种基于卷积神经网络和分类器的视网膜病理图像自动分类系统。方法首先,结合现有的视网膜图像的特点,对图像进行去噪、数据扩增、归一化等预处理操作;其次,在AlexNet网络的基础上,在网络的每一个卷积层和全连接层前引入一个批归一化层,得到一个网络层次更复杂的深度卷积神经网络BNnet。BNnet网络用于视网膜图像的特征提取网络,对其训练时采用迁移学习的策略利用ILSVRC2012数据集对BNnet网络进行预训练,再将训练得到的模型迁移到视网膜图像上再学习,提取用于视网膜分类的深度特征;最后,将提取的特征输入一个由全连接层组成的深度分类器将视网膜图像分为正常的视网膜图像、轻微病变的视网膜图像、中度病变的视网膜图像等5类。结果实验结果表明,本文方法的分类准确率可达0.93,优于传统的直接训练方法,且具有较好的鲁棒性和泛化性。结论本文提出的视网膜病理图像分类框架有效地避免了人工特征提取和图像分类的局限性,同时也解决了样本数据不足而导致的过拟合问题。关键词:糖尿病性视网膜图像分类;卷积神经网络;深度学习;迁移学习;深度特征11|4|10更新时间:2024-05-07

医学图像处理

-

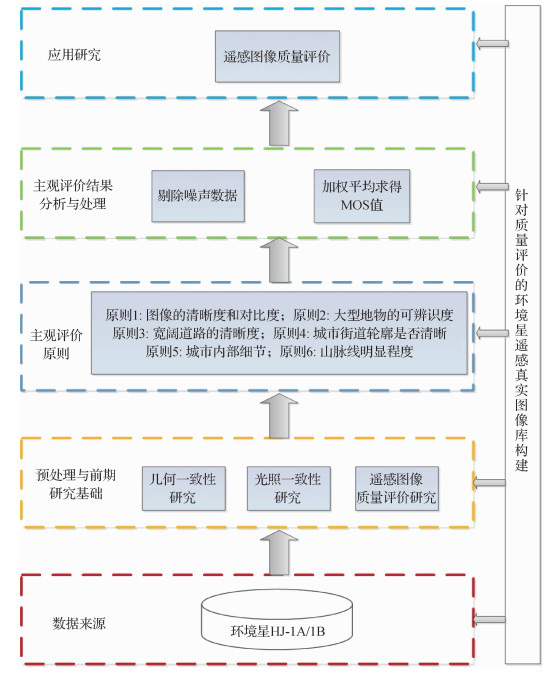

摘要:目的随着遥感信息爆炸时代的来临,海量的遥感图像信息不断地从太空中传来。如何有效地利用这些遥感数据成为学者们新的研究热点。遥感图像质量评价不仅能筛选出有价值的图像以供后续的图像处理,如地物分类、目标识别等,还能对卫星设备的运转情况进行检测,而目前还没有公开的针对质量评价的遥感图像库。为此,构建了一个针对质量评价的环境星HJ-1A/1B真实遥感图像专家评分库。方法遥感图像专家评分库包含70组,每组包含同一地点的5个不同时间点的图像,共350幅真实遥感图像以及每幅图像对应的主观评价质量分数。并通过基于卷积神经网络的图像质量评价算法来验证该遥感图像专家库的可用性。结果将本文算法和4种效果较好的无参考图像质量评价算法在本文数据库上进行性能检测,并对各算法性能与训练测试集规模的关系进行对比实验。实验结果表明,目前针对仿真图像的无参考图像质量评价算法并不适用于该遥感图像库,验证了遥感真实图像与自然仿真图像的巨大差异,而基于卷积神经网络的算法结果则表明该数据库具有质量评价研究价值。结论本文构建的基于环境星遥感真实图像库能够为遥感图像质量评价提供验证平台,并且数据规模可以为深度学习在遥感图像处理领域的应用提供支持。关键词:遥感图像质量评价;遥感图像库;真实图像;环境星;卷积神经网络12|6|0更新时间:2024-05-07

摘要:目的随着遥感信息爆炸时代的来临,海量的遥感图像信息不断地从太空中传来。如何有效地利用这些遥感数据成为学者们新的研究热点。遥感图像质量评价不仅能筛选出有价值的图像以供后续的图像处理,如地物分类、目标识别等,还能对卫星设备的运转情况进行检测,而目前还没有公开的针对质量评价的遥感图像库。为此,构建了一个针对质量评价的环境星HJ-1A/1B真实遥感图像专家评分库。方法遥感图像专家评分库包含70组,每组包含同一地点的5个不同时间点的图像,共350幅真实遥感图像以及每幅图像对应的主观评价质量分数。并通过基于卷积神经网络的图像质量评价算法来验证该遥感图像专家库的可用性。结果将本文算法和4种效果较好的无参考图像质量评价算法在本文数据库上进行性能检测,并对各算法性能与训练测试集规模的关系进行对比实验。实验结果表明,目前针对仿真图像的无参考图像质量评价算法并不适用于该遥感图像库,验证了遥感真实图像与自然仿真图像的巨大差异,而基于卷积神经网络的算法结果则表明该数据库具有质量评价研究价值。结论本文构建的基于环境星遥感真实图像库能够为遥感图像质量评价提供验证平台,并且数据规模可以为深度学习在遥感图像处理领域的应用提供支持。关键词:遥感图像质量评价;遥感图像库;真实图像;环境星;卷积神经网络12|6|0更新时间:2024-05-07

遥感图像处理

0