|

|

|

发布时间: 2022-04-16 |

遥感图像处理 |

|

|

|

收稿日期: 2020-12-18; 修回日期: 2021-03-15; 预印本日期: 2021-03-22

基金项目: 国家重点研发计划资助(2017YFC0821902)

作者简介:

卫春阳,1991年生,男,硕士研究生,主要研究方向为图像匹配与图像定位。E-mail: weicy@aircas.ac.cn

乔彦友,男,研究员,主要研究方向为地理信息系统、软件开发与产业化、空间决策支持系统、数字城市工程建设和森林病虫害。E-mail:qiaoyy@radi.ac.cn *通信作者: 卫春阳 weicy@aircas.ac.cn

中图法分类号: TP751.1

文献标识码: A

文章编号: 1006-8961(2022)04-1251-13

|

摘要

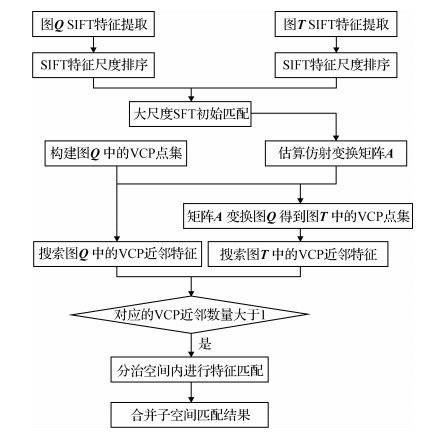

目的 图像匹配是遥感图像镶嵌拼接的重要环节,图像匹配技术通常采用两步法,首先利用高维描述子的最近和次近距离比建立初始匹配,然后通过迭代拟合几何模型消除错误匹配。尽管外点过滤算法大幅提高了时间效率,但其采用传统的两步法,构建初始匹配的方法仍然非常耗时,导致整个遥感图像拼接的速度提升仍然有限。为了提高遥感图像匹配的效率,本文提出了一种基于空间分治思想的快速匹配方法。方法 首先,通过提取图像的大尺度特征生成少量的初始匹配,并基于初始匹配在两幅图像之间构建成对的分治空间中心点;然后,基于范围树搜索分治空间中心点一定范围内的相邻特征点,构造成对分治空间点集;最后,在各个分治空间点集内分别进行遥感图像特征的匹配。结果 通过大量不同图像尺寸和相对旋转的遥感图像的实验表明,与传统的和其他先进方法相比,本文方法在保证较高精度的同时将匹配时间缩短到1/100~1/10。结论 利用初始种子匹配构建分治匹配中心以将图像匹配分解在多个子区间进行的方法有助于提高遥感影像匹配的效率,该算法良好的时间性能对实时遥感应用具有实际价值。

关键词

图像匹配; 遥感影像; 空间分治; 区域树; 空间结构

Abstract

Objective Image matching is crucial to remote sensing. A number of feature matching algorithms have been designed to establish correspondences and filter outliers. The current remote sensing image matching methods have derived from region-based and feature based analyses. Feature-based methods illustrate greater robustness and accuracy in processing complex scenarios like brightness changes, homogeneous textures, and geometric distortions. Feature-based methods are implemented in at two stages as follows: First, robust feature points are extracted and nearest-neighbor distance ratios (NNDRs) is facilitated to clarify putative matches. Next, a geometric model or spatial structure is adopted to filter false matches. An initial putative matching step is time-consuming based on quick mismatches elimination and high inlier ratios. This initial matching step has challenged further for matching speeds improvement. Our new quick matching method decreases matching times significantly in terms of high inlier ratios. Method First, scale-invariant feature transform (SIFT) features are from image extraction and these feature points are sorted out in accordance with their scales to establish initial matches based on top 10 % feature scales derived of NNDR threshold. Top-scale SIFT features is identified to extract the initial matches due to small quantity and high quality. Qualified matches can be obtained based on these features. Next, it samples regularly spaced feature coordinates in the query image. Initial matches based affine model estimation is conducted to transform the sampled points to the target image. The extraction of initial match accuracy is relatively high in terms of top-scale feature points. Thus, accuracy of the affine model estimated from this match is also high. The virtual center point (VCP) is targeted as center of a neighboring feature point set. The VCP is not represented the extracted feature position well as a search center for the neighboring feature points. A set of pairwise neighbors is obtained in terms of an inner rectangular window based feature points search of these pairwise sample points. Finally, feature point matching is performed independently within each pair of windows. Following the set of VCP neighbors derived of the range tree, correspondence is to be established within pairwise windows. As most features are grouped in small windows, feature correspondence can be established rapidly through traditional brute force (BF) matching. Thus, BF matching is utilized to implement feature matching in pairwise windows instead of a k-dimensional tree (kd-tree). The number of points assumed for each window considerably affects the performance of spatial divide and conquer (SDC) algorithm and it determines the number of VCPs and the size of the windows, consequently regulating the average number of feature points per window. This is significant for BF image matching procedures operating within the windows. To analyze the effect of window size on matching time and inlier ratio, a group of images are optioned with resolutions between 795 × 530 and 3 976 × 2 652 pixels. The demonstrations indicate that the window size is inversely proportional to running speed and inlier ratio. Result A multi-sensors based remote sensing data across China is obtained. These analyzed images are mentioned as bellows: 1) the Landsat 8 images of West Sichuan of China; 2) SPOT satellite images of Beijing; 3) GF-3 synthetic aperture radar (SAR) data for the southeast of Wuhan; 4) ZY-3 satellite data for Qingdao area of Shandong province. The images were sized between 816 × 716 and 2 976 × 2 273 pixels, and the maximum relative rotation angle was 30°. These images cover several types of geographical environment, including mountains, cities, coastal plains, forests, and farmland. Extensive experiments on various sizes and orientations of remote sensing images demonstrate that our proposed method is highly accurate and reduces the matching time by 1-2 orders of magnitude compared with traditional and the state-of-the-art methods. Conclusion A top-scale SIFT features based quick image matching method is illustrated and analyzed. Parallel computing can further improve the speed of our algorithm due to the independent matching procedures for separate windows.

Key words

image matching; remote sensing image; spatial divide and conquer; range tree; spatial structure

0 引言

图像配准是图像应用的关键步骤(Wei等,2017; Yang等,2017; Eastman等,2011; Zhao等,2020; Chen等,2015),一般包括局部不变特征点匹配、直线匹配和区域匹配等算法(贾迪等,2019),以及局部不变特征与区域匹配结合等算法(Feng等,2019b; 许斌等,2018)。目前的遥感图像匹配方法主要有基于区域和基于特征的方法及针对山地影像的光流跟踪法(Feng等,2019a)。基于特征的方法由于在亮度变化、重复性纹理和几何失真等复杂场景时依然显示出较高的鲁棒性,成为遥感图像匹配研究的热点,其中SIFT(scale invariant feature transform)(Lowe,2004)是应用最为经典的特征描述子之一,并出现了很多针对耗时和精确性等方面的改进版本(耿娟等,2016; 张庆鹏和曹宇,2019),提出了大量基于特征的图像匹配方法。该类方法有两个主要步骤:1)提取鲁棒特征点并基于最近邻距离比(nearest neighbor distance ratio, NNDR) (Lowe,2004)确定初始匹配; 2)基于几何模型过滤错误匹配。然而,由于重复纹理导致的特征模糊性,使基于NNDR的初始匹配存在大量错误匹配(Raguram等,2008),因此需要额外的错误匹配剔除步骤(Li和Hu,2010; Ma等,2012)。按照错误匹配过滤方式的不同,现有的图像匹配算法可分为3类:基于几何模型的方法、基于局部空间结构的方法和基于图结构的方法。

1) 基于几何模型的匹配算法。该方法先基于NNDR比较局部特征(如SIFT特征的相似度),然后迭代估算几何模型过滤外点,从而实现遥感图像的匹配。初始匹配方法包括暴力(brute force)匹配、近似最近邻(approximate nearest neighbor,ANN)搜索匹配(Agarwal等,2009; Crandall等,2011)和级联哈希(cascade hash,CH)匹配(Strecha等,2012; Cheng等,2014)。初始匹配中一般存在较多的错误匹配,通常使用随机样本一致性算法(random sample consensus,RANSAC)(Fischler和Bolles,1981; Hartley和Zisserman,2000; Raguram等,2008; Moisan等,2012; Chum等,2003)对错误匹配进行过滤,首先迭代选择随机数据样本估计模型,然后基于一定的阈值统计内点数量,以内点数量最多的模型为最终的图像变换模型,以此过滤外点匹配。针对无人机影像进行特征匹配,王晓红等人(2018)提出利用多重约束条件的外点过滤算法,首先检测影像特征点并构建初始匹配,再计算SIFT特征尺度邻域内的特征主方向,最后基于RANSAC估算单应性矩阵实现了更精确的错误匹配过滤。该方法在一般的刚体变换下效果良好,但在重复纹理条件下存在大量错误匹配时,估算出的几何模型不能准确反映图像变换关系,基于该几何模型的错误匹配过滤结果精度会大幅降低(Brown和Lowe,2002)。

2) 基于局部空间关系的匹配算法。为了应对RANSAC的匹配方法在重复的结构场景下性能退化问题,研究人员提出了几种基于局部空间结构一致性的算法。这些算法的基本原理在于:在查询和目标图像之间的转换过程中,匹配特征点的局部空间结构几乎保持不变,基于局部结构一致性原理可以消除图像的错误匹配。Ma等人(2014)提出一种鲁棒向量场一致性(vector field consensus,VFC)方法,通过在两幅图像之间插值一个向量场建立对应关系,采用最大后验估计方法从初始匹配中选择内点匹配。Li(2015)根据地面目标点在目标图像和查询图像之间位置不变性构建特征点几何向量相似性约束,实现了合成孔径雷达图像的正确匹配。Hu等人(2015)将描述符投影到一个单应空间,根据点之间的测地距离判断这些初始匹配的几何一致性和空间连续性,然后基于这种一致性确立正确的图像匹配。Yang等人(2017)通过欧几里德距离和形状建立高斯混合模型度量几何结构相似性,基于能量优化和运动一致性的几何约束更新变换模型以过滤错误匹配。Bian等人(2017)通过计算相邻匹配的数量提出一种基于网格的运动统计(grid-based motion statistics,GMS)方法。

3) 基于图结构的匹配算法。图匹配的核心概念是在两个图节点之间基于一定的规则建立图顶点的对应关系。基于此,研究人员提出了几种相应的图像匹配算法。Izadi和Saeedi(2012)利用图边之间的角度距离将特征与其最近邻连接起来,通过迭代剔除离群值计算相似图达到外点过滤的目的。Zhang等人(2014)利用k近邻的三角形区域定义了仿射不变描述子获得候选外点匹配,结合局部仿射不变描述子和全局信息消除外点匹配。为了在重复图案、遮挡和纹理均匀的情况下获得鲁棒的图像匹配,Yuan等人(2017)提出了一种结合几何约束和辐射约束的边缘加权张量的方法,构建高阶图匹配以实现图像特征的匹配。基于正确匹配局部邻域结构稳定的认识,Ma等人(2018)提出一种基于引导的错误匹配过滤算法(guided locality preserving matching,GLPM),使用较高内点率的初始匹配引导初始匹配中的错误匹配过滤。为了不依赖于高内点率的初始匹配, Ma等人(2019)提出通过搜索每个假设匹配的k近邻构造一个近邻点集。基于局部邻域结构一致性检验消除错误匹配的LPM (locality preserving matching)算法,喜文飞等人(2020)提出利用图论原理构建特征点的能量函数过滤能量较低的特征点,以减少特征匹配的粗差,再结合RANSAC算法进行粗差剔除,获得了更高精度的单应矩阵估算结果。

上述方法大多能在保证较高内点率的前提下快速消除错误,但都有一个共同的问题:都需要一个相对耗时的初始匹配步骤,因此初始匹配步骤制约了基于特征的遥感图像匹配算法速度。为了应对这一问题,本文提出了一种基于空间分治算法思想的快速匹配方法。该方法的核心思路是将图像匹配分解成多个子集的匹配,通过这种分而治之的方法缩短特征匹配搜索范围,从而在缩短图像匹配时间的同时减少错误匹配的概率。本文的贡献在于提出一种构建分治匹配中心和分治匹配区域的方法。实验结果表明,与经典方法和最新方法相比,本文方法在保持较高内点的同时,可以显著减少1~2个数量级的匹配时间。

1 方法

给定查询图像

1.1 基于大尺度SIFT特征的少量初始匹配

由于同一尺度级别的特征更容易正确匹配(Wu,2013),首先提取SIFT特征并根据SIFT尺度大小按升序排序并选择尺度前10 % 的特征(本文称之为大尺度特征),然后对其应用暴力匹配建立初始匹配子集。使用大尺度SIFT特征提取初始匹配,是因为它们数量少、质量高。为了提取尽可能多的正确初始匹配,将NNDR阈值设置为0.6。

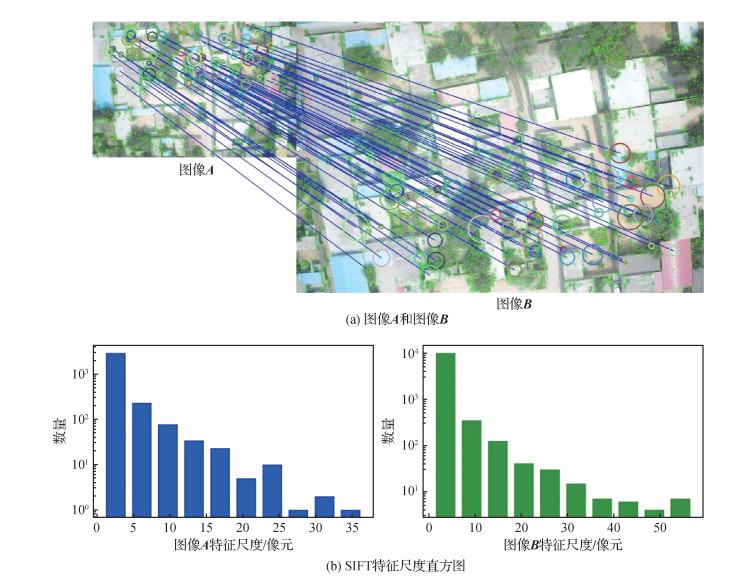

为了分析SIFT特征的尺度分布,本文随机选择两幅图像

1.2 建立分治空间中心点对

构建分治空间中心需要知道每个子集的大致中心位置。为了确定分治空间中心点对,首先查询图中构建虚拟中心点(virtual center point,VCP),称为虚拟中心点是表示该点不一定代表提取特征点的实际位置,而只是作为分治空间的搜索中心。

构建VCP样点的关键是确定采样点间距,从而确定分治空间窗口的大小。采样点越密集、窗口越小,反之亦然。给定一幅具有

| $ W_{\mathrm{num}}=N_{I} /N_{w} $ | (1) |

式中,

因此,基于

| $ L=\min (W, H) /\sqrt{W_{\text {num }}} $ | (2) |

式中,

接下来,将VCP设置变换到目标图像,构建分治空间中心点对。首先,在查询图像中任意选择一个大尺度特征点作为起始点,以

| $ \boldsymbol{V}^{\mathrm{t}}=\boldsymbol{V}^{\mathrm{q}} \boldsymbol{A} $ | (3) |

式中,

由于图像大小不同,并不是所有的采样点都可以转换成目标图像。因此有必要在目标图像之外删除VCP集,得到图像匹配的分治空间中心点对

| $ \boldsymbol{C}(k)= \begin{cases}\left(v_{i}^{\mathrm{q}}, v_{i}^{\mathrm{t}}\right) & v_{i}^{\mathrm{t}} \in \boldsymbol{I}^{\mathrm{t}} \\ \emptyset & \text { 其他 }\end{cases} $ | (4) |

式中,

图 3描述了基于仿射变换获得的

1.3 构建成对分治空间点集

确定分治空间中心点对集后,通过搜索每一对中心点附近的特征点,构建分治空间点集。

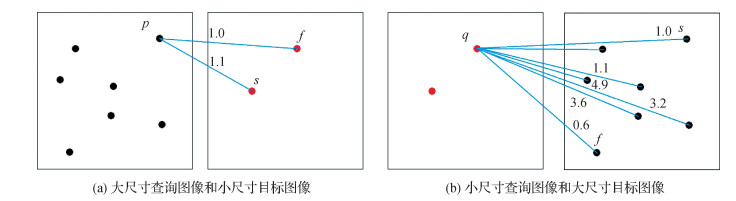

搜索近邻特征点的方法有4种:穷举搜索法、分维数搜索法、k-维树(k-dimensional tree, kd-tree)法和区域树(range-tree)法。由于区域树(de Berg等,2000) 具有较高的搜索效率,时间复杂度为O(log2M+ k),因此本文采用区域树进行分治空间中心点的近邻搜索。具体来说,对于图像中任意一点v(x, y),假设其位于边长为

首先,提取

图 4是两个范围树搜索的示意图。图 4(a)查询图像与目标图像尺寸下相同且无相对旋转; 图 4(b)查询图像与目标图像尺寸不同且存在相对旋转。为了便于查看,只随机选择少量数据进行显示。黄色方框代表搜索范围,方框中心的红点代表VCP。在左侧的查询图像中,VCP均匀分布,间隔距离为

1.4 分治空间内的特征匹配

利用区域树完成分治空间点集构建后,进行分治空间内的特征匹配。kd-tree方法是特征匹配的常用方法,但需要额外的时间建立搜索树,且由于图像特征划分在多个窗口内,而每个窗口内的特征数量较少,此时kd-tree方法优势不明显,直接采用暴力匹配即可实现特征的快速匹配。

与传统暴力匹配方法不同,本文算法对图像顺序有要求,即

1.5 SDC算法的计算复杂度分析

查询图像和目标图像中的特征点数量分别用M和N表示,M<N。构建区域树的时间复杂度和空间复杂度都为

为了便于快速搜索,区域树必须在不同级别保存子树索引,其空间复杂度为O(MlogM+NlogN)。当每个查询窗口中至少有m个特征点时,需要M/m个VCP覆盖整个查询图像。因此,最近邻搜索的时间复杂度约为O((M/m)(log2M+log2N)),存储这些最近邻的空间复杂度为O(M+N)。假设目标窗口中有n个点,每对窗口的计算复杂度为O(mn); 所有窗口的匹配计算的时间复杂度为O(M/m)(mn),以O(nM)表示; 空间复杂度为O(K),其中K是匹配数。

综上所述,空间分治匹配算法的时间复杂度为

2 实验

为验证SDC算法的性能,在不同传感器遥感图像上与现有算法进行对比实验。实验在小米15.6 pro笔记本电脑上进行,软硬件配置为ubuntu16.04操作系统,Intelcorei5-8250U处理器和8 GB运行内存,SDC算法和比较算法均基于C+ +实现。

实验选取我国各地不同类型的卫星遥感数据,包括四川西部的Landsat 8多波段合成图像、北京的SPOT卫星图像、武汉东南部的GF-3合成孔径雷达(synthetic aperture radar,SAR)数据和青岛的ZY-3卫星数据。每种传感器的图像数据选择4对进行实验,图像尺寸在816 × 716~2 976 × 2 273像素之间,最大相对旋转角度为30°。这些图像涵盖了多种类型的地理环境,包括山脉、城市和沿海平原。这些都是高空卫星遥感影像数据,因此地面的起伏在成像上的影响较小。本文首先分析了不同参数设置对性能的影响,然后从内点率和运行时间两方面与其他最新的匹配方法进行比较。

2.1 参数设置

由于每个窗口假设的点数决定了VCP的数量和窗口的大小,因此调节每个窗口的平均特征点数量会极大影响所提算法的性能。为了分析窗口大小对匹配时间和匹配比的影响,首先选取一组分辨率在795×530~3 976×2 652像素之间的图像进行实验。

实验表明,窗口大小与运算速度和内点率成反比。本文定义具有平均特征数的分治空间点集为“假设窗口”,每个“假设窗口”的特征数n对运行耗时和其他参数的影响如表 1所示。可以看出,“假设窗口”中包含的特征数(n)越多,则窗口尺寸越大、窗口对的数目(

表 1

“假设窗口”中特征数对SDC算法性能的影响

Table 1

Effect of numbers of features in the assumed window on SDC performance

| 特征数 | 窗口对 | 平均特征数 | 总匹配数 | 内点匹配数 | 运行时间/s | |

| 查询窗口 | 目标窗口 | |||||

| 5 | 1 119 | 4 | 7 | 564 | 448 | 1.41 |

| 10 | 629 | 7 | 14 | 579 | 425 | 1.67 |

| 15 | 434 | 11 | 21 | 577 | 427 | 2.07 |

| 20 | 331 | 15 | 28 | 582 | 467 | 2.74 |

| 25 | 272 | 18 | 34 | 567 | 399 | 3.14 |

| 30 | 232 | 21 | 41 | 576 | 461 | 3.78 |

| 35 | 194 | 26 | 49 | 561 | 454 | 4.37 |

| 40 | 163 | 28 | 52 | 522 | 387 | 4.72 |

| 45 | 147 | 33 | 64 | 528 | 376 | 5.42 |

| 50 | 141 | 34 | 66 | 541 | 433 | 6.17 |

通过以上对SDC算法的性能分析,可以看出窗口越小,匹配效率越高。实验也表明本文算法在不同地理环境下的遥感影像匹配中表现良好。由于高空卫星图像中,地形起伏对图像的影响可以忽略不计, 因此基于单应变换估算匹配精确性具有较高精度,可作为图像匹配质量的判断依据。具体来说,对于任意落在同一平面的一对匹配特征点

| $ \left[\begin{array}{c} u_{1} \\ v_{1} \\ 1 \end{array}\right]=\left[\begin{array}{lll} h_{1} & h_{2} & h_{3} \\ h_{4} & h_{5} & h_{6} \\ h_{7} & h_{8} & h_{9} \end{array}\right] \cdot\left[\begin{array}{c} u_{2} \\ v_{2} \\ 1 \end{array}\right]=\boldsymbol{H} \cdot\left[\begin{array}{l} u_{2} \\ v_{2} \\ 1 \end{array}\right] $ | (5) |

然后以

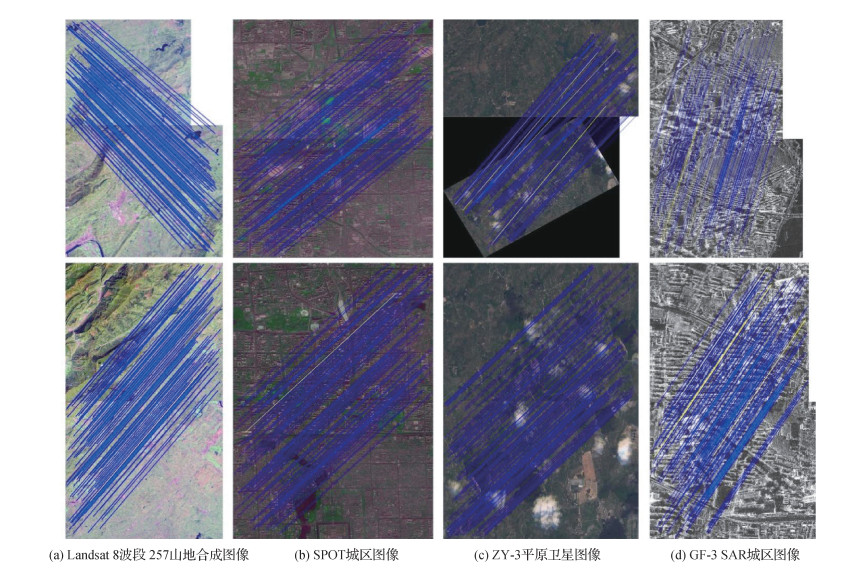

图 6描述了SDC算法在图像匹配中的匹配效果,其中蓝线和黄线分别表示内点匹配和外点匹配,为了便于观察,只随机选择了100对匹配进行展示。可以看出,SDC算法具有较高的匹配精度,在严格的误差阈值(1像元)下,100对随机选择的匹配点中,只有2~3个外点匹配,SDC算法在不同地理区域的图像上都具有较好的匹配结果。其原因在于特征相似度计算在分治空间内进行,降低了误匹配的可能性,在提高匹配精度的同时缩短了匹配时间。

2.2 匹配效率比较

为验证本文提出的SDC算法的匹配效率,选取36幅不同尺寸的遥感图像,与现有最先进的RANSAC(Fischler和Bolles,1981)、VFC(Ma等,2012)、GMS(Bian等,2017)和GLPM(Ma等,2018)算法从内点率和运行耗时两方面进行比较。

2.2.1 初始匹配和内点匹配数量比较

首先对各算法提取的匹配和内点匹配的绝对数量进行比较。通常使用精确度和召回率评估图像匹配性能。因此要计算匹配召回率,就必须确定正确匹配的数量。现有研究中的正确匹配是通过手动选择计算的,而为了验证本文算法在不同图像大小下的性能,选择了20对图像进行实验,从中提取了多达10 000个匹配项,显然手动选择是不可行的。参考Kurz和Himane(2011)方法,本文使用单应矩阵的投影误差确定匹配是否正确。首先选择少量的大尺度SIFT特征进行严格NNDR阈值的初始匹配,由于匹配的数量较少,因而可以直观地检查是否存在不正确的匹配。在没有错误匹配发生的情况下,可以计算出更精确的单应矩阵

表 2显示了通过各种匹配算法获得的总匹配数和内点数。传统的基于RANSAC的匹配方法提取了最多的匹配,BF-RANSAC是基于暴力匹配(BF)的RANSAC,ANN-RANSAC是基于近似最近邻(ANN)匹配的RANSAC,CH-RANSAC是基于级联哈希(CH)匹配的RANSAC,其中最直接的BF-RANSAC匹配方法搜索到最多的匹配。在其他算法中,VFC提取到的匹配几乎与BF-RANSAC相同,略微居于其次的是GMS算法。而GLPM和本文SDC算法提取的匹配数量相对较少,但是内点的比例也很高。有两个原因导致SDC算法获得的匹配较少:1)SDC是一种空间分治算法,匹配点对的数目取决于分治空间的大小。此外,分治空间之间的间隙是不可避免的,因此一些特征被排除在外。2)当影像地面存在起伏时,仿射估计可能不够精确,导致VCP变换不准确,变换后的分治空间会偏离实际应该在的位置,导致部分特征点的匹配发生在不同的分治空间内。虽然SDC算法相对于其他算法丢失了部分匹配,然而在实时遥感匹配中通常不需要匹配所有特征。当匹配点在图像中均匀分布时,可以估计出精确的几何模型,而SDC算法的匹配点分布在分治空间中心的采样时即已决定其均匀性。

表 2

图像的平均初始匹配数量和内点匹配数量

Table 2

Average numbers of putative matches and inliers

| 算法 | 初始匹配数量 | 内点匹配数量 |

| BF-RANSAC | 4 057 | 4 036.15 |

| ANN-RANSAC | 4 045.4 | 4 025 |

| CH-RANSAC | 3 980.25 | 3 962.95 |

| VFC | 4 049.55 | 4 030.2 |

| GMS | 3 974.1 | 3 948.6 |

| GLPM | 2 976.8 | 2 929.15 |

| SDC(本文) | 3 134 | 3 060.2 |

| 注:加粗字体表示各列最优结果。 | ||

2.2.2 内点率和运行时间的比较

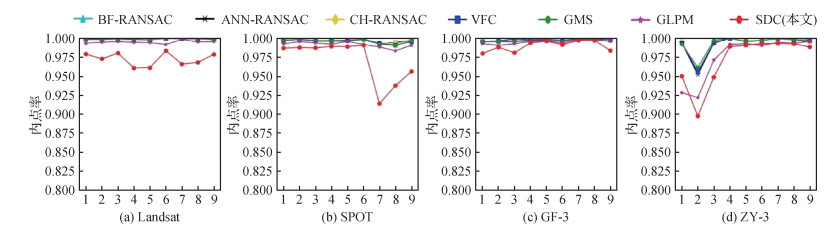

为验证本文算法的匹配效率,对各算法的内点率和运行时间进行比较。各种遥感影像传感器的匹配效率如图 7和图 8所示,每种传感器类型选择9幅图像进行匹配实验,图 7是内点率比较,图 8是运行时间比较。从图 7和图 8可以看出,SDC算法内点率虽然比其他算法略低,但对于各种传感器图像,仍然保持了最低90 % 的较高水平。在运行时间上,VFC、GMS、ANN-RANSAC和CH-RANSAC等最新算法的时间效率相近,CH-RANSAC的速度稍快。但与本文算法相比,这些算法在Landsat和SPOT图像上的耗时约10倍多,在GF-3和ZY-3上的耗时约为2~5倍多; 与经典的BF-RANSAC算法相比,SDC算法的效率提高了100倍左右。可以看出,SDC算法显著提高了遥感图像匹配的效率。

结合4个传感器的36幅图像的内点率和运行时间,可以得出各算法的总体性能。图 9通过箱线图进一步展示了各种算法的综合性能。如图 9(a)所示,基于RANSAC的方法以及基于空间结构的方法VFC和GMS产生了最高的内点率,而SDC算法获得了相对较低的内点率。虽然SDC算法比其他算法的精度稍低,但平均精度仍然在98 % 以上,可以满足大多数实际遥感图像拼接应用的要求。另一方面,SDC算法在运行耗时方面表现出了优异性能,如图 9(b)所示,该算法的平均运行时间比其他算法中最优的缩短到1/100~1/10。这种突出的时间效率对实时遥感图像拼接应用具有实用价值,是SDC算法的主要优势。

3 结论

本文提出了一种基于空间分治的快速遥感图像匹配方法。与传统的和最先进的匹配方法相比,该方法在保证较高内点率的同时将运行耗时缩短到1/100~1/10。本文方法简单直观,利用严格的NNDR提取大尺度特征构造了少量初始匹配; 在查询图像中按一定的间隔构建分治空间中心点。基于初始匹配估计一个仿射模型,将查询图像分治空间中心点转换到目标图像,在两个图像之间构造分治空间中心点对集; 然后,基于区域树搜索每个分治空间中心点的近邻特征点集,构建分治空间点集。在成对分治空间内进行图像匹配。通过多种不同纹理条件的遥感图像的实验表明,与其他方法相比,分治空间匹配方法具有较高的精度和较低的运行时间。其优越的时间性能在遥感拼接镶嵌等应用中具有实际价值。由于各个分治空间的匹配过程相互独立,因此采用并行计算可以进一步提高算法的速度。不足之处是,分治空间匹配的关键是分治空间中心的准确映射,而在低空无人机遥感等场景中,受地形起伏因素的影响,会导致分治空间中心映射不准确,从而导致算法性能下降,这是下一步需要改进的地方。

参考文献

-

Agarwal S, Snavely N, Simon I, Seitz S M and Szeliski R. 2009. Building Rome in a day//Proceedings of the 12th International Conference on Computer Vision (ICCV). Kyoto, Japan: IEEE: 72-79 [DOI: 10.1109/ICCV.2009.5459148]

-

Bian J W, Lin W Y, Matsushita Y, Yeung S K, Nguyen T D and Cheng M M. 2017. GMS: grid-based motion statistics for fast, ultra-robust feature correspondence//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu, USA: IEEE: 2828-2837 [DOI: 10.1109/CVPR.2017.302]

-

Brown M and Lowe D. 2002. Invariant features from interest point groups//Proceedings of the British Machine Vision Conference. [s.l.]: BMVA Press: #23 [DOI: 10.5244/C.16.23]

-

Chen C, Li Y Q, Liu W, Huang J Z. 2015. SIRF: simultaneous satellite image registration and fusion in a unified framework. IEEE Transactions on Image Processing, 24(11): 4213-4224 [DOI:10.1109/TIP.2015.2456415]

-

Cheng J, Leng C, Wu J X, Cui H N and Lu H Q. 2014. Fast and accurate image matching with cascade hashing for 3D reconstruction//Proceedings of 2014 IEEE Conference on Computer Vision and Pattern Recognition. Columbus, USA: IEEE: 1-8 [DOI: 10.1109/CVPR.2014.8]

-

Chum O, Matas J and Kittler J. 2003. Locally optimized RANSAC//The 25th Joint Pattern Recognition Symposium. Magdeburg, Germany: Springer: 236-243 [DOI: 10.1007/978-3-540-45243-0_31]

-

Crandall D, Owens A, Snavely N and Huttenlocher D. 2011. Discrete-continuous optimization for large-scale structure from motion//Proceedings of the CVPR 2011. Colorado Springs, USA: IEEE: #5995626 [DOI: 10.1109/CVPR.2011.5995626]

-

de Berg M, van Kreveld M, Overmars M and Schwarzkopf O C. 2000. Orthogonal range searching//de Berg M, van Kreveld M, Overmars M and Schwarzkopf O C, eds. Computational Geometry. Berlin, Heidelberg: Springer: 95-120 [DOI: 10.1007/978-3-662-04245-8_5]

-

Eastman R D, Netanyahu N S and Moigne J L. 2011. Survey of image registration methods//Le Moigne J, Netanyahu N S and Eastman R D, eds. Image Registration for Remote Sensing. Cambridge: Cambridge University Press

-

Feng R, Li X and Shen H. 2019a. Mountainous remote sensing images registration based on improved optical flow estimation//Proceedings of the ISPRS Annals of the Photogrammetry, Remote Sensing and Spatial Information Sciences. Enschede, the Netherlands: ISPRS: 479-484 [DOI: 10.5194/isprs-annals-IV-2-W5-479-2019]

-

Feng R T, Du Q Y, Li X H, Shen H F. 2019b. Robust registration for remote sensing images by combining and localizing feature-and area-based methods. ISPRS Journal of Photogrammetry and Remote Sensing, 151: 15-26 [DOI:10.1016/j.isprsjprs.2019.03.002]

-

Fischler M A, Bolles R C. 1981. Random sample consensus: a paradigm for model fitting with applications to image analysis and automated cartography. Communications of the ACM, 24(6): 381-395 [DOI:10.1145/358669.358692]

-

Geng J, He C L, Liu X X. 2016. Image matching based on CSIFT feature. Remote Sensing for Land and Resources, 28(1): 93-100 (耿娟, 何成龙, 刘宪鑫. 2016. 基于CSIFT特性的无人机影像匹配. 国土资源遥感, 28(1): 93-100) [DOI:10.6046/gtzyyg.2016.01.14]

-

Hartley R, Zisserman A. 2000. Multiple View Geometry in Computer Vision. Cambridge: Cambridge University Press

-

Hu Y T, Lin Y Y, Chen H Y, Hsu K J, Chen B Y. 2015. Matching images with multiple descriptors: an unsupervised approach for locally adaptive descriptor selection. IEEE Transactions on Image Processing, 24(12): 5995-6010 [DOI:10.1109/TIP.2015.2496305]

-

Izadi M, Saeedi P. 2012. Robust weighted graph transformation matching for rigid and nonrigid image registration. IEEE Transactions on Image Processing, 21(10): 4369-4382 [DOI:10.1109/TIP.2012.2208980]

-

Jia D, Zhu N D, Yang N H, Wu S, Li Y X, Zhao M Y. 2019. Image matching methods. Journal of Image and Graphics, 24(5): 677-699 (贾迪, 朱宁丹, 杨宁华, 吴思, 李玉秀, 赵明远. 2019. 图像匹配方法研究综述. 中国图象图形学报, 24(5): 677-699) [DOI:10.11834/jig.180501]

-

Kurz D and Himane S B. 2011. Inertial sensor-aligned visual feature descriptors//Proceedings of the CVPR 2011. Colorado Springs, USA: IEEE: 161-166 [DOI: 10.1109/CVPR.2011.5995339]

-

Li D P. 2015. A novel method for multi-angle SAR image matching. Chinese Journal of Aeronautics, 28(1): 240-249 [DOI:10.1016/j.cja.2014.12.019]

-

Li X R, Hu Z Y. 2010. Rejecting mismatches by correspondence function. International Journal of Computer Vision, 89(1): 1-17 [DOI:10.1007/s11263-010-0318-x]

-

Lowe D G. 2004. Distinctive image features from scale-invariant keypoints. International Journal of Computer Vision, 60(2): 91-110 [DOI:10.1023/b:visi.0000029664.99615.94]

-

Ma J Y, Jiang J J, Zhou H B, Zhao J, Guo X J. 2018. Guided locality preserving feature matching for remote sensing image registration. IEEE Transactions on Geoscience and Remote Sensing, 56(8): 4435-4447 [DOI:10.1109/TGRS.2018.2820040]

-

Ma J Y, Zhao J, Jiang J J, Zhou H B, Guo X J. 2019. Locality preserving matching. International Journal of Computer Vision, 127(5): 512-531 [DOI:10.1007/s11263-018-1117-z]

-

Ma J Y, Zhao J, Tian J W, Yuille A L, Tu Z W. 2014. Robust point matching via vector field consensus. IEEE Transactions on Image Processing, 23(4): 1706-1721 [DOI:10.1109/TIP.2014.2307478]

-

Ma J Y, Zhao J, Zhou Y and Tian J W. 2012. Mismatch removal via coherent spatial mapping//Proceedings of the 19th IEEE International Conference on Image Processing. Orlando, USA: IEEE: 1-4 [DOI: 10.1109/ICIP.2012.6466780]

-

Moisan L, Moulon P, Monasse P. 2012. Automatic homographic registration of a pair of images, with a contrario elimination of outliers. Image Processing on Line, 2: 56-73 [DOI:10.5201/ipol.2012.mmm-oh]

-

Raguram R, Frahm J M and Pollefeys M. 2008. A comparative analysis of RANSAC techniques leading to adaptive real-time random sample consensus//Proceedings of the 10th European Conference on Computer Vision. Marseille, France: Springer: 500-513 [DOI: 10.1007/978-3-540-88688-4_37]

-

Strecha C, Bronstein A, Bronstein M, Fua P. 2012. LDAHash: improved matching with smaller descriptors. IEEE Transactions on Pattern Analysis and Machine Intelligence, 34(1): 66-78 [DOI:10.1109/TPAMI.2011.103]

-

Wang X H, Deng S X, He Z W, Cao L X, Yan X G. 2018. Study of UAV image matching based on SURF algorithm and homography matrix. Bulletin of Surveying and Mapping, (7): 38-42 (王晓红, 邓仕雄, 何志伟, 曹留霞, 闫星光. 2018. 结合SURF算法和单应性矩阵的无人机影像匹配. 测绘通报, (7): 38-42) [DOI:10.13474/j.cnki.11-2246.2018.0206]

-

Wei Z Q, Han Y F, Li M Y, Yang K, Yang Y, Luo Y, Ong S H. 2017. A small UAV based multi-temporal image registration for dynamic agricultural terrace monitoring. Remote Sensing, 9(9): #904 [DOI:10.3390/rs9090904]

-

Wu C C. 2013. Towards linear-time incremental structure from motion//Proceedings of 2013 International Conference on 3D Vision — 3DV 2013. Seattle, USA: IEEE: 127-134 [DOI: 10.1109/3DV.2013.25]

-

Xi W F, Shi Z T, Li G Z. 2020. UAV image matching feature point coarse error elimination based on image theory algorithm. Bulletin of Surveying and Mapping, (4): 6-10 (喜文飞, 史正涛, 李国柱. 2020. 图论算法的无人机影像匹配特征点粗差剔除. 测绘通报, (4): 6-10) [DOI:10.13474/j.cnki.11-2246.2020.0103]

-

Xu B, Lei B, Sun T, Lu X J. 2018. A multi-feature matching algorithm for visible light and SAR images registration. Remote Sensing Information, 33(3): 85-90 (许斌, 雷斌, 孙韬, 卢晓军. 2018. 一种多特征匹配的可见光与SAR图像配准算法. 遥感信息, 33(3): 85-90) [DOI:10.3969/j.issn.1000-3177.2018.03.013]

-

Yang K, Pan A N, Yang Y, Zhang S, Ong S H, Tang H L. 2017. Remote sensing image registration using multiple image features. Remote Sensing, 9(6): #581 [DOI:10.3390/rs9060581]

-

Yuan X X, Chen S Y, Yuan W, Cai Y. 2017. Poor textural image tie point matching via graph theory. ISPRS Journal of Photogrammetry and Remote Sensing, 129: 21-31 [DOI:10.1016/j.isprsjprs.2017.04.015]

-

Zhang K, Li X Z, Zhang J X. 2014. A robust point-matching algorithm for remote sensing image registration. IEEE Geoscience and Remote Sensing Letters, 11(2): 469-473 [DOI:10.1109/LGRS.2013.2267771]

-

Zhang Q P, Cao Y. 2019. Image matching algorithm based on exposure and color information. Laser and Optoelectronics Progress, 56(19): #191004 (张庆鹏, 曹宇. 2019. 一种融合光照和彩色信息的图像匹配算法. 激光与光电子学进展, 56(19): #191004) [DOI:10.3788/LOP56.191004]

-

Zhao X, Li H, Wang P, Jing L H. 2020. An image registration method for multisource high-resolution remote sensing images for earthquake disaster assessment. Sensors, 20(8): 2286 [DOI:10.3390/s20082286]